作者:趙世振

本文整理自 2025 雲棲大會,阿里雲智能集團產品架構師 趙世振 的主題演講《Serverless AI 原生應用架構》

在 AI 大模型浪潮席捲全球的今天,企業紛紛加速擁抱 AI,推動智能客服、內容生成、流程自動化等場景快速落地。然而,許多企業在實踐中卻遭遇了“三高困境”——成本高、複雜度高、風險高。

一位互聯網公司 CTO 曾坦言:“智能客服流量暴增,模型服務很容易被打掛,緊急手動擴容後,GPU 閒置率高達 90%,月底賬單翻倍,還有數據泄漏風險。”

這並非個例——大量企業仍在用“傳統架構”承載“新型 AI 業務”,要讓 AI 業務簡單、穩定、安全落地,我們必須從基礎設施到業務接入層,進行一場 AI 原生的架構重塑。

架構變革的底層邏輯

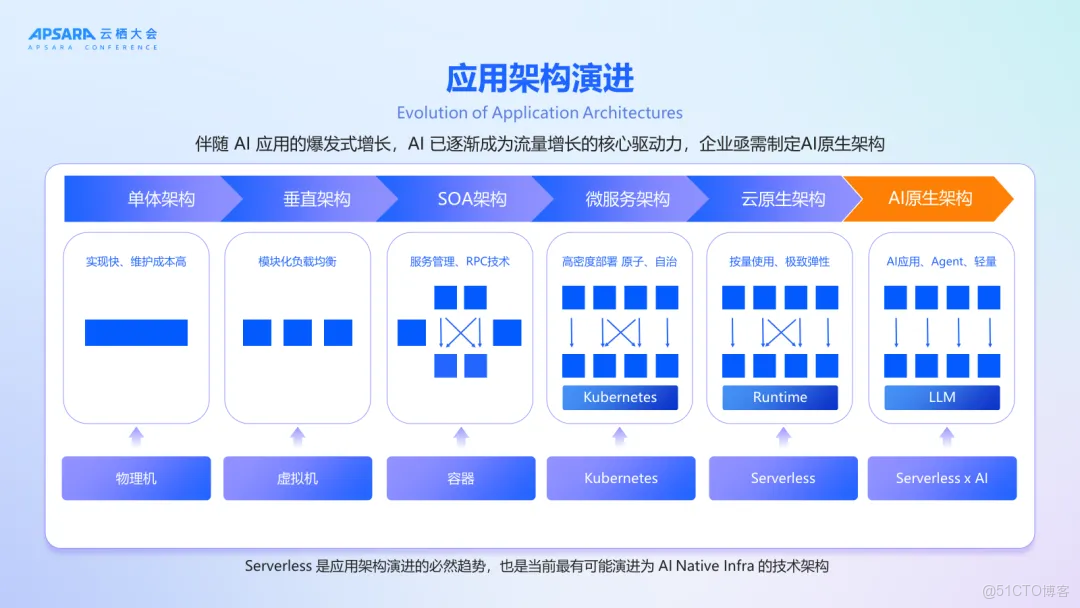

過去十餘年間,應用架構持續演進:從單體架構到垂直拆分,歷經 SOA、微服務,走向雲原生,直至今日的 AI 原生架構。這一進程的本質,是業務邏輯不斷解耦、分佈化與智能化的過程,旨在實現更快速的業務響應、更靈活的協同能力。

與此同時,底層基礎設施也同步進化——從物理機、虛擬機到容器、Kubernetes,再到 Serverless,如今邁向 Serverless AI 的新階段。其核心在於對資源與能力的極致抽象,實現按需彈性、自動伸縮,讓計算如同水電一般隨取隨用、高效便捷。

兩條演進主線共同揭示了一個清晰的趨勢:未來的技術重心將愈發聚焦於業務邏輯本身的創新與實現,而基礎設施則趨於全面抽象化、自動化和智能化。開發者無需再過多關注底層運維細節,而是可以專注於創造更高價值的業務場景。這不僅是技術的躍遷,更是生產力的一次深刻變革。

AI 原生應用架構的三大核心需求

通過與 300 餘家企業的深度交流,AI 原生應用架構的核心需求可歸納為高模型算力、高可用性及嚴格安全管控三大維度:

1. 算力需求

- 成本優化: GPU 算力成本是 CPU 的數倍,且供應波動大。需提供靈活的卡型選擇(如 N 分之一卡)、按需付費模式及預留閒置資源策略,以平衡成本與性能。

- 穩定性保障: 通過多可用區部署與動態資源調度,確保模型調用的持續性與資源利用率最大化。

2. 高可用性需求

- 全鏈路容災: 支持多可用區部署,避免單點故障;

- 限流與 fallback 機制: 突發流量時自動限流,模型服務異常時無縫切換至備用模型,保障業務連續性。

3. 安全管控需求

- 輸入輸出合規性: 模型輸入輸出均設內容安全防護,過濾違規內容、敏感信息等;

- 消費者鑑權: 不同團隊或不同用户請求帶有不同的鑑權憑證,權限最小化;

- 全鏈路監控: 實現從網關到算力的全鏈路可觀測體系;

總結來説,AI 原生應用架構需要的是:簡單易用的開發體驗、生產級的性能、穩定性和安全保障。

Serverless AI 原生架構的全棧能力支撐

為滿足上述需求,Serverless AI 原生應用架構應運而生。在該架構中,模型可通過 Serverless GPU(即函數計算 FC)進行部署,與 Agent 相關的 Sandbox、MCP Server、E2B 等服務也可託管於 FC。AI 網關作為模型與 MCP 服務的代理層,提供限流、鑑權、可觀測性與安全護欄等功能。AI Agent 的開發支持低代碼、零代碼及高代碼方式,可部署於 FC 或 SAE。Agent 前端通過網關進行代理,全鏈路配備 AI 應用觀測能力,實現端到端可觀測。

該架構具備以下特點:

特徵一:全棧 Serverless,極致簡化運維

整個架構中,函數計算 FC、SAE(Serverless應用引擎)、MSE Nacos、RocketMQ、AI 網關等關鍵組件均為 Serverless 形態或具備 Serverless 特性。無需管理底層服務器,自動擴縮容真正做到“一鍵部署、開箱即用”。

特徵二:全鏈路高可用,保障業務連續性

架構中的每一個產品節點均支持多可用區部署,具備跨區域容災能力。特別是函數計算 FC 提供的 Serverless GPU 實例,已實現三可用區冗餘部署,並配備實例級健康檢查與自動恢復機制,極大提升了模型服務的穩定性。

此外,AI 網關內置 Fallback 機制,在主模型不可用時可自動切換至備用模型,確保關鍵業務不中斷。

特徵三:雙層安全保障,構築可信 AI 防線

安全貫穿整個調用鏈路:

- 運行時安全:FC 和 SAE 採用實例隔離機制,防止租户間干擾;

- 調用層安全:AI 網關提供消費者鑑權、API Key 管理、內容審核等功能,有效防範未授權訪問與惡意攻擊。

特徵四:簡單易用,加速 AI 創新落地

所有產品都是雲上託管,一鍵部署啓動,常見模型與 MCP 服務已封裝為模板,可在 FunctionAI 平台一鍵部署,不管你是零代碼用户、低代碼開發者,還是資深工程師,都能找到適合你的入口。

Serverless AI 架構的核心組件

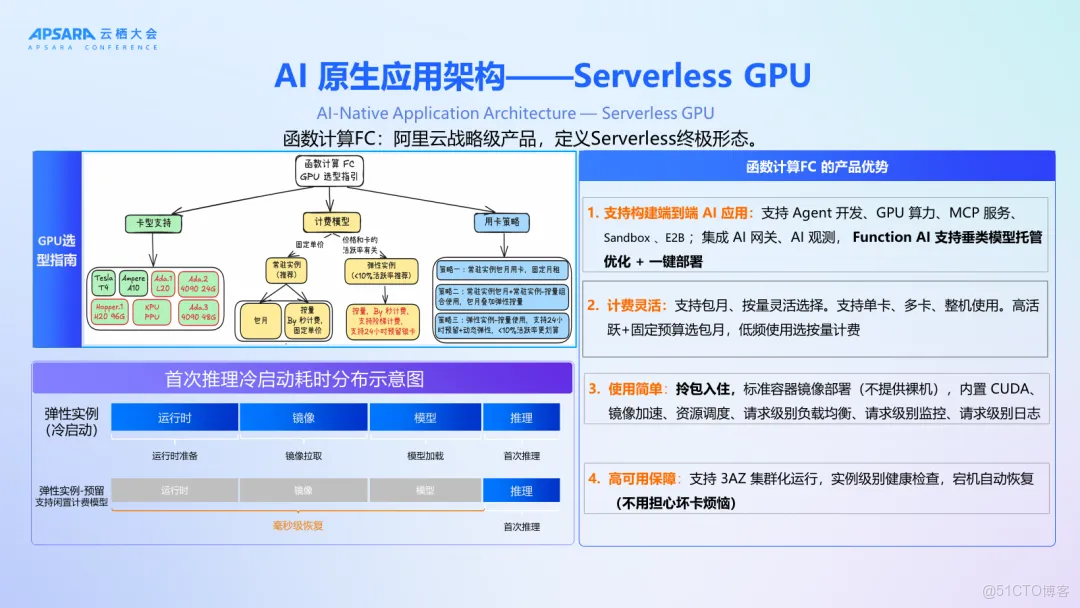

函數計算 FC:定義 Serverless 終極形態

定位為彈性經濟的全託管 Serverless 計算服務,專用於部署大模型與 MCP 工具:

- 經濟降本:支持卡切分(1/N GPU)、階梯定價、常駐實例等策略,整體 GPU 利用率超 50%,成本更低。

- 極致彈性:GPU 實例啓動快(毫秒級/秒級) ,通過請求感知調度顯著降低 RT 抖動, 支持定時/水位伸縮、延遲釋放、會話親和。

- 開發框架集成:內置 MCP Server、Sandbox 等服務運行時,支持模型微調鏡像一鍵部署;

- 運維能力:提供鏡像加速、資源調度、請求級監控日誌,實現零運維體驗。

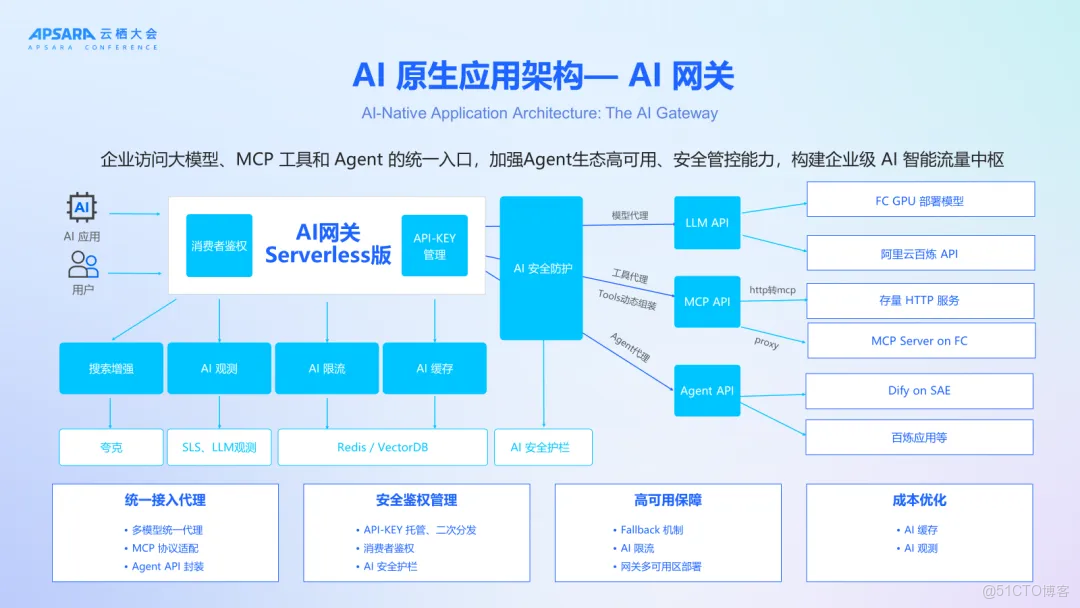

AI 網關:企業級 AI 流量中樞

作為模型、MCP、Agent 的統一接入入口,承擔安全、治理與調度職責:

- 統一代理:支持多模型路由、MCP 協議適配、Agent API 封裝,簡化調用複雜度;

- 安全鑑權:集中管理 API-KEY,支持二次分發與消費者身份驗證,設置 AI 安全護欄防範惡意輸入與輸出;

- 高可用保障:多可用區部署 + fallback 機制,異常時自動切換備用模型,支持精細化限流,保障核心業務穩定性;

- 成本優化:內置 AI 緩存減少算力資源消耗,結合觀測能力實現 Token 級成本監控;

- 靈活擴展:支持動態組裝 MCP 新工具鏈,快速接入外部 AI 服務。

總結展望

Serverless AI 原生架構不僅是技術演進,更是企業智能化轉型的關鍵基礎設施。它讓開發者聚焦業務邏輯,讓企業告別“基建焦慮”,讓 AI 真正“飛入尋常百姓家”。

正如本次演講尾聲所説:“讓架構為業務賦能,讓 AI 為世界創造更多可能。 ”

阿里雲將持續投入 Serverless 與 AI 原生架構研發,攜手更多行業夥伴,共同構建開放、智能、安全的新一代 AI 應用生態。