本文價值提示:

💡 面向人羣:擁有 Java/Scala/Spark 背景,正在向 AI Agent/RAG 架構轉型的後端或大數據工程師。 🎯 核心收穫:

- 思維重構:如何用 Spark 的“惰性求值”思維理解 Python 生成器。

- 架構解耦:如何用 Spring AOP 的“切面”思維掌握 Python 裝飾器。

- 實戰落地:手把手構建一個自動重試+流式輸出的高可用 LLM 接口。

在大數據時代,Python 往往被我們視為“膠水語言”——寫寫 Airflow 調度腳本,或者用 PySpark 做個簡單的 ETL。那時候,我們的重型武器是 Java 和 Scala,追求的是高吞吐和強類型約束。

但在 AI 2.0 時代,Python 翻身做主人,成為了核心業務邏輯的承載者。

當你開始構建 AI Agent 或 RAG(檢索增強生成)應用時,你會發現:LLM 的 API 極其不穩定,且響應速度慢得驚人。 如果你還用寫腳本的方式寫架構,系統分分鐘崩潰。

今天,我們將深入 Python 的生成器 (Generators) 和 裝飾器 (Decorators) ,帶你從“腳本小子”進化為“AI 架構師”。

01 🌊 生成器 (Generators):數據的“惰性”流動

🤔 大數據思維映射

還記得 Spark RDD 或 Flink DataStream 嗎? 它們的核心特性是 Lazy Evaluation(惰性求值)。當你定義一個 map 操作時,數據並沒有真正計算;只有當觸發 Action 時,數據才像水流一樣流過管道。

Python 的生成器(Generator),就是單機版的 Flink 流。

🚫 傳統列表的痛點

在處理 LLM 響應時,傳統的做法是等待 AI 生成完所有 1000 個字,再一次性返回給用户。 這就像 Spark 裏的 collect() 算子,把所有數據拉回 Driver 端,結果就是:

- 用户體驗極差:看着空白屏幕乾等 10 秒。

- 內存爆炸:如果併發高,內存瞬間被撐爆。

✅ 生成器的魔法:yield

生成器使用 yield 關鍵字。它不像 return 那樣交出結果就結束函數,而是交出一個值,然後“暫停”在原地,保留現場,等待下一次召喚。

這正是 ChatGPT 實現“打字機效果”的核心技術!

💻 代碼實戰:模擬 LLM 流式吐字

在 AI 工程中,我們通常使用 異步生成器 (async generator),因為網絡 I/O 是最大的瓶頸。

import asyncio

import time

from typing import AsyncGenerator

# 模擬一個耗時的 LLM 推理過程

async def mock_llm_stream(query: str) -> AsyncGenerator[str, None]:

"""

模擬 LLM Token 生成。

這就像 Flink 的 Source Function,源源不斷產生數據。

"""

print(f"🤖 AI 收到問題: {query}")

response_text = "Python 的生成器機制非常適合處理 LLM 的流式傳輸..."

for token in response_text:

# 模擬網絡延遲 (非阻塞)

# ⚠️ 注意:千萬別用 time.sleep(),那會卡死整個 Event Loop!

await asyncio.sleep(0.1)

# 【關鍵點】yield 將數據"推"給下游,並暫停在此處

yield token

# 消費端 (Sink)

async def main():

print("--- 開始接收流 ---")

# 【關鍵點】必須使用 async for 來遍歷異步生成器

async for token in mock_llm_stream("什麼是生成器?"):

# end='' 模擬打字機效果,不換行

print(token, end='', flush=True)

print("\n--- 結束 ---")

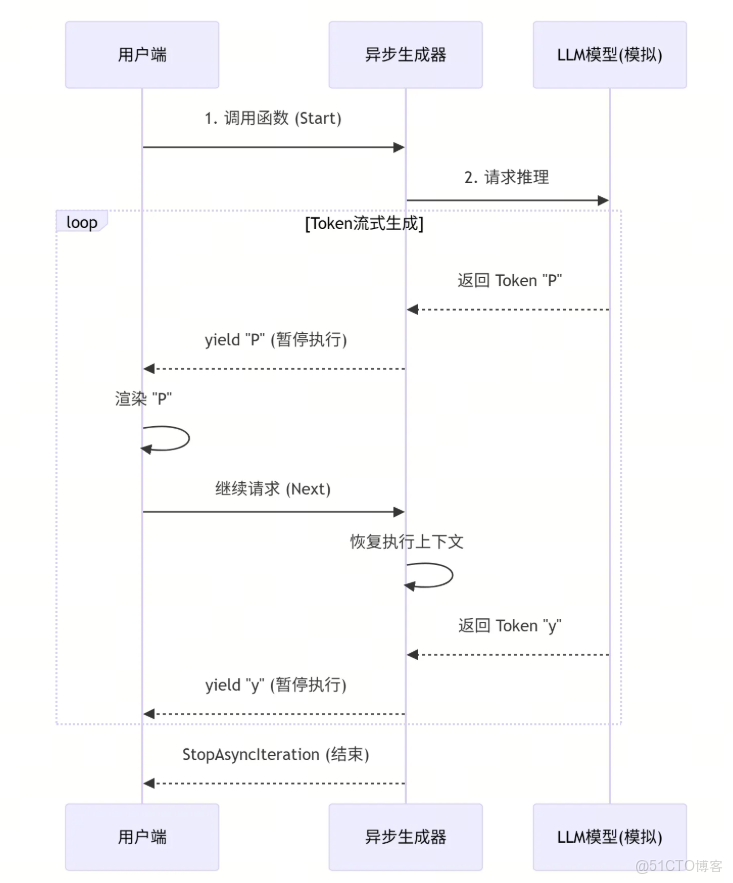

📊 流程圖解

看看數據是如何像水流一樣被 yield 出來的:

02 🛡️ 裝飾器 (Decorators):Python 版的 AOP

🤔 大數據思維映射

在 Java Spring 開發中,你一定用過 @Transactional 處理事務,或者 @Retryable 處理重試。這就是 **AOP(面向切面編程)**。

你不需要修改業務代碼,只需要加一個註解,就能把“鑑權、日誌、重試、熔斷”這些非業務邏輯“織入”到代碼中。

Python 的裝飾器,就是更靈活、更動態的 AOP。

🛠️ 為什麼 AI 架構必用裝飾器?

LLM 的 API 是出了名的“嬌氣”:

- Rate Limit: 動不動就報 429 Too Many Requests。

- Timeout: 經常 504 Gateway Timeout。

- 不穩定: 偶爾返回亂碼或空值。

如果我們把重試邏輯寫在業務代碼裏,代碼會變成一團亂麻。我們需要一個**“指數退避重試”**的切面。

💻 代碼實戰:打造“高可用護甲”

import asyncio

import functools

import logging

from typing import Callable, Any, AsyncGenerator

# 配置日誌:顯示時間戳以便觀察重試間隔

logging.basicConfig(

level=logging.INFO,

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

logger = logging.getLogger("RetrySystem")

def retry_with_backoff(max_retries: int = 3, initial_delay: float = 1.0):

"""

裝飾器工廠:用於接收配置參數,閉包保存重試配置。

"""

def decorator(func: Callable[..., AsyncGenerator]):

# 使用 functools.wraps 保留原函數的名稱、文檔等元數據

@functools.wraps(func)

async def wrapper(*args, **kwargs):

"""

代理生成器 (Proxy Generator)。

它攔截調用,並在內部管理對原始生成器的迭代和重試。

注意:因為函數體內包含 yield,wrapper 本身也會返回一個 AsyncGenerator。

"""

delay = initial_delay

# --- 重試循環 ---

for attempt in range(max_retries):

try:

# 1. 獲取生成器實例

# 調用原函數 func(*args),此時原函數內部代碼並未執行!

# 它僅僅返回一個"未啓動"的生成器對象 (Generator Object)。

gen = func(*args, **kwargs)

# 2. 驅動生成器執行 (關鍵步驟)

# 使用 async for 遍歷生成器,這會觸發 func 內部代碼開始運行。

# 如果 func 內部拋出異常(如連接失敗),會在這裏被觸發,從而被外層 try 捕獲。

async for item in gen:

# 3. 數據透傳

# 將底層生成器產生的數據,原封不動地 yield 給最外層的調用者。

yield item

# 4. 成功退出

# 如果上面的循環完整走完且沒有報錯,説明流式傳輸成功完成。

# 直接 return 結束 wrapper 生成器,不再進行後續重試。

return

except Exception as e:

# --- 異常捕獲與處理 ---

logger.warning(f"⚠️ [第 {attempt + 1} 次失敗] 捕獲異常: {e}")

# 檢查是否還有重試機會

if attempt < max_retries - 1:

# 計算指數退避時間 (1s, 2s, 4s...)

sleep_time = delay * (2 ** attempt)

logger.info(f"⏳ 等待 {sleep_time} 秒後重新創建生成器...")

# 掛起當前任務,等待冷卻

await asyncio.sleep(sleep_time)

# 循環繼續 -> 下一次迭代會再次調用 func()

# 這相當於創建了一個全新的生成器實例,實現了"從頭重試"。

else:

# 重試次數耗盡,記錄錯誤並向上拋出,通知調用方徹底失敗

logger.error("❌ 重試次數耗盡,操作失敗。")

raise e

return wrapper

return decorator

03 🏗️ 綜合實戰:構建高可用 LLM 網關

現在,我們將 Stream(流式) 和 Decorator(切面) 結合起來,解決一個真實的工程痛點: “如何優雅地調用一個經常掛掉的 LLM 接口,並流式返回給用户?”

場景模擬

- 不穩定: 模擬 70% 概率連接失敗。

- 流式: 連接成功後,逐字吐出。

- 無感重試: 用户不知道底層重試了,只看到最終結果。

🚀 完整架構代碼

import random

# --- 業務層 ---

class UnstableLLMProvider:

# 應用裝飾器:

# 當調用 create_completion_stream 時,實際上調用的是 wrapper

@retry_with_backoff(max_retries=4, initial_delay=0.5)

async def create_completion_stream(self, prompt: str):

"""

模擬不穩定的 LLM 流式接口。

"""

# 模擬 API 網關隨機抖動 (70% 概率失敗)

# 注意:這個異常只有在 wrapper 進行 async for 遍歷時才會被觸發

if random.random() < 0.7:

raise ConnectionError("模擬 API 網關超時 (504 Gateway Timeout)")

print(f"✅ [底層提供商] 連接成功!開始流式傳輸關於 '{prompt}' 的內容...")

# 模擬生成內容

content = "Python 異步生成器重試機制演示..."

for char in content:

# 模擬 Token 生成延遲

await asyncio.sleep(0.1)

# 逐個字符產出

yield char

# --- 調用層 ---

async def run_business_logic():

client = UnstableLLMProvider()

try:

print("🚀 [業務層] 發起請求...")

# 1. 獲取代理生成器

# 這裏調用的是 wrapper,它立即返回一個 AsyncGenerator,不會阻塞

stream = client.create_completion_stream("RAG 架構設計")

# 2. 消費數據

# 這裏的 async for 會驅動 wrapper 運行 -> wrapper 驅動 UnstableLLMProvider 運行

# 整個鏈路像齒輪一樣咬合轉動

async for token in stream:

print(token, end='', flush=True)

print("\n✅ [業務層] 接收完成")

except Exception as e:

# 如果重試耗盡,異常最終會拋到這裏

print(f"\n💀 [業務層] 服務最終不可用: {e}")

if __name__ == "__main__":

# 啓動事件循環

asyncio.run(run_business_logic())

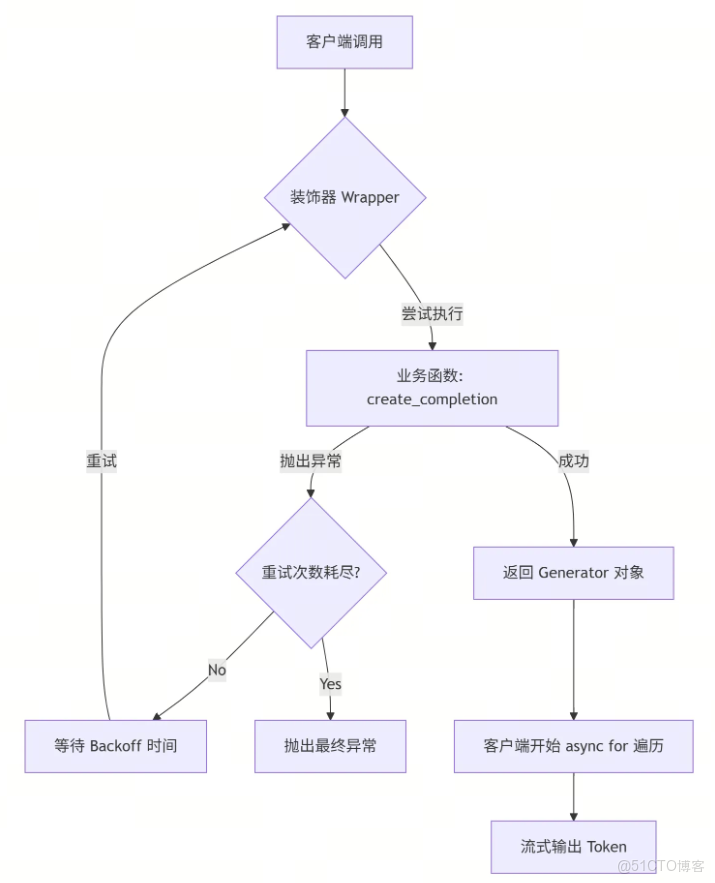

🧩 邏輯流程圖

看看裝飾器是如何攔截並保護你的業務邏輯的:

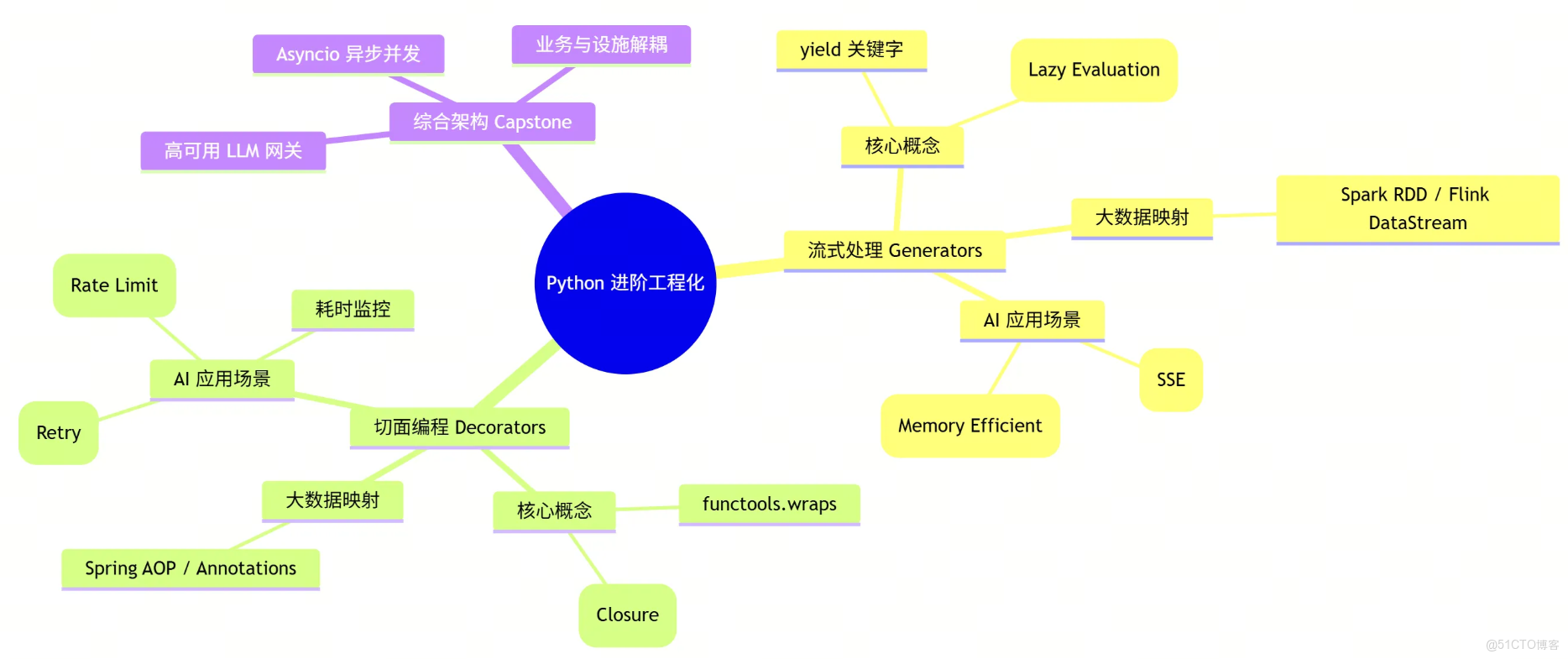

📝 總結與展望

從大數據轉型 AI 架構,語言只是工具,思維才是核心。

- Generators 讓你學會了處理 AI 的“流式數據”,就像處理 Spark 的 RDD。

- Decorators 讓你學會了架構的“解耦”,就像使用 Spring 的 AOP。

當你把這兩個工具結合起來,你就擁有了構建生產級 AI 應用的基石:既能處理高併發的 I/O 等待,又能從容應對不穩定的外部依賴。

🧠 本文核心知識圖譜

下期預告: 搞定了核心邏輯,如何將其封裝成微服務?下一篇我們將深入 FastAPI,探討如何結合 Pydantic 進行強類型接口定義,構建符合 OpenAPI 標準的 AI 微服務。

👉 關注我,帶你用架構師的思維玩轉 AI 工程化!