大家好,我是EpicGames中國的技術美術孫丹璐,今天為大家帶來的分享是Metahuman原理及流程淺析。

現在數字人是個非常火熱的題材,不管是遊戲、影視、直播、工業、廣告等領域都有着大量需求。但是傳統數字人的製作在設備,人力和時間成本上都非常高昂的,每個流程,每一個環節比如掃描角色、綁定,動捕和麪捕進行驅動,也都需要一定的技術門檻才能達到的。所以在市面上的大多數案例中,比如大家看到的AAA遊戲中,基於成本,一般只有有限的主角會採用完整的高精度數字人效果,其他角色的精度都相對低很多。

基於此,我們提供了一套方案叫做MetaHuman Creator,快速和容易地創建獨特高保真的數字人類的工具,你可以直接操縱面部特徵,調整膚色,並且從預設的身體類型、髮型、服飾等範圍中選擇,在metahuman中甚至可以編輯角色的牙齒,在角色製作完成後,你的角色會包含完整的綁定並可以直接在虛幻引擎或者maya中製作動畫。

為了達到零門檻創建數字人,可見即所得的目標,我們提供了基於Epic生態的三個套件進行協同工作,通過MHC快速在線製作數字人,利用Quixel Bridge導出數字人,在虛幻引擎中應用到遊戲或者影視當中。

https://v.qq.com/x/page/s3312...

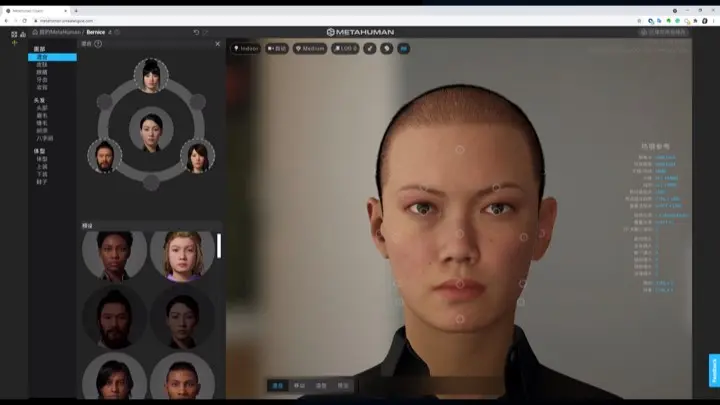

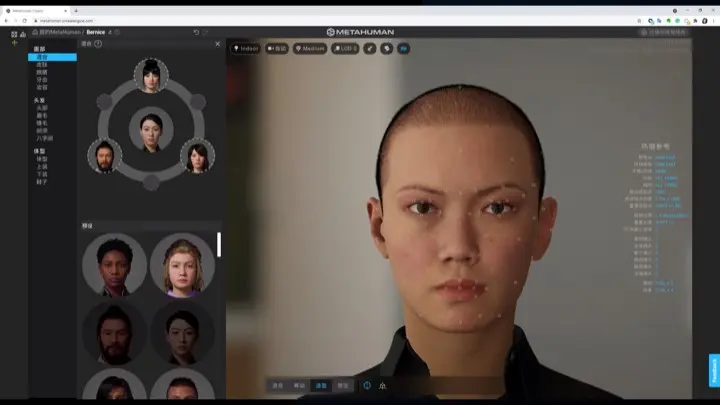

我想先為大家展示下通過MHC進行捏人,MHC依託於網絡,通過Pixel Streaming在網頁端交互使用,在這個視頻演示中,我捏出一個全新的數字角色實際只用了4分鐘,大家可以看到操作也很直觀易懂,上手門檻非常低。在捏臉的部分,面部混合提供三種模式 。

第一種是混合模式,最粗粒度的捏臉,通過左上方的混合圈,添加3~6個角色區進行插值,你每控制一個特徵點進行捏臉,就是採樣這幾個預設角色的特徵點去做插值。

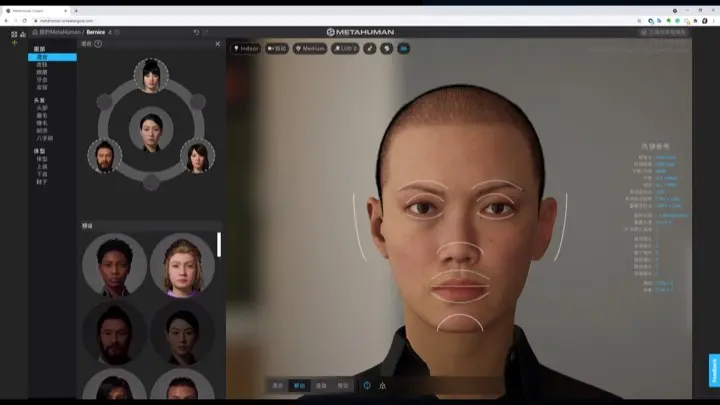

第二種模式是移動模式,按照五官劃分了特徵點,在這個模式下可以快速的修改五官。

第三種模式是雕刻工具,是Creator提供的最細粒度的工具,可以針對最小特徵點,比如鼻尖,來區進行細節調整,Creator中大家需要注意到這裏的雕刻和Zbrush中的雕刻是存在一些不同,MHC中的雕刻, 是通過你期望雕刻的形態,在基因庫中索引一組面部特徵點再進行融合。另外Creator中常見的一個誤區是,移動和雕刻工具,實際上與你左上角預設好的幾個角色是無關的。它移動和雕刻都是在整個基因庫中進行索引,並不依賴於左上角預設好的角色。

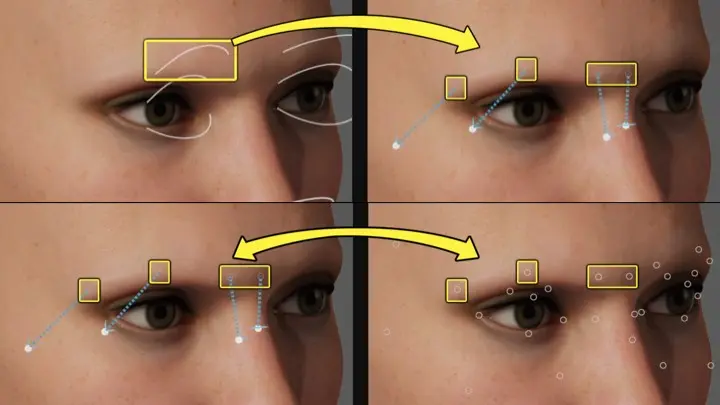

另外,其實移動工具和雕刻工具,是可以一一對應起來的,比如移動模式的眉弓處控件,對應的是雕刻工具下 ,眉心、眉頭、眉峯、眉尾、這四個特徵點。

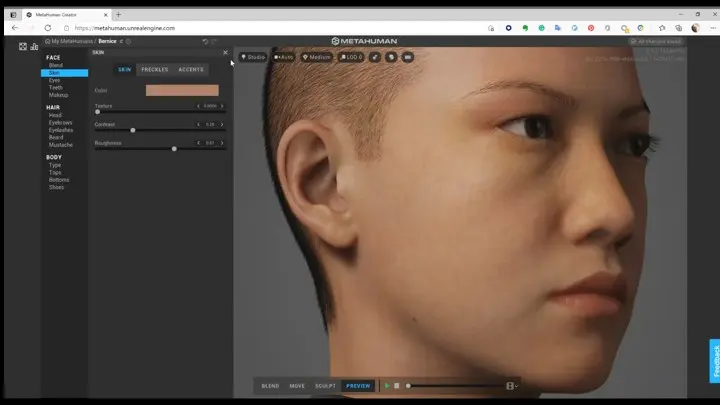

另外在Creator中也可以調整膚色和紋理細節,皮膚的紋理選項不但可以增加臉部表面的細節,也會對面部的形態產生影響,比如皺紋對於面部形態其實是有一個形變的。

Creator中也提供了相對靈活的妝容設置,比如粉底,眼影和眼線,各部位的腮紅、口紅,能夠進一步減少用户對於數字角色進行二次修改的需求和開銷。

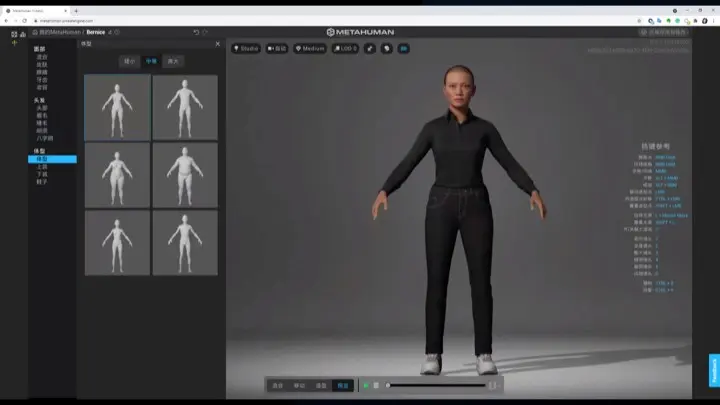

在身體的塑造上,MHC提供了預設好的18種體型進行選擇,頭部目前並不會隨着身體的高度或體型選擇自動的發生改變。所以其實有的時候你選擇體型之後,可能看起來身體和頭的比例有些奇怪,所以我們提供了頭部縮放功能。

頭部的縮放並不是完全等比縮放,而是會更符合人體特徵,你可以看到,你現在縮放頭部的時候,你的脖子並不會隨之無限的增粗,這樣縮放也能較好的處理頭頸和身體的銜接。

我們來看下MHC背後的技術,首先我們會通過4D掃描大量的現實人類面部,通過人工和ML處理數據,提取出每個角色的特徵點信息,存入一個叫做DNA的數據格式中,而DNA用於描述角色的外觀、骨骼綁定,最後我們把這些信息存放到GenePool中,GenePool是我們的一個數據庫,用户每一下捏臉操作,實際上就是在GenePool的數據庫中進行索引,混合,最後基於你捏好的數字角色,也會生成一份獨一無二的DNA數據。

在體型方面,採用了傳統流程製作的體型。主要是目前我們還沒有較為完善的身體數據庫,所以沒有辦法和頭部一樣可以融合不同體型的特徵點來捏體型,另外現在我們也不提供利用縮放進行任意的體型調整的設置,主要原因是整體效果不能達標,比如説局部調整過體型之後,你的身體和脖子的接縫處並不是一個很好處理,另外服飾也是很大的問題,局部放過的身體很難做到布料貼合。

在紋理方面,皮膚的紋理是通過掃描數據中的紋理進行合成來生成製作,以確保達到更真實的效果,掃描的紋理分離成低、中、高頻率的細節紋理,用於在Creator中自定義的混合,而其他地方使用的紋理,則使用更傳統的管道去進行製作。

另外MHC是一個基於雲端的APP,我們把MHC放在了雲端。主要是因為以上數據量,尤其是面部GenePool和紋理數據的數據量非常非常巨大的,而且未來會不停擴充,單就數據量和運算壓力恐怕不太適合放在個人電腦上進行運算,所以我們採用了基於雲端的方案,同時雲端還有個好處,更新迭代很快,很多問題和改善可以直接後台完成,不需要每一位用户都進行頻繁的更新。為了把雲端的MHC輸送到瀏覽器,我們採用了Pixel streaming,Pixel streaming是一個基於虛幻引擎的流送技術,在雲端服務器上運行虛幻引擎應用程序,通過WebRTC將渲染的幀和音頻流送到瀏覽器和移動設備,不知道大家有沒有意識到,使用了pixel streaming意味着,後台跑的也是虛幻引擎,在雲端的虛幻引擎中製作數字人,導出到本地的虛幻引擎裏進行使用,所有參數,模型,毛髮,布料,紋理,材質,LOD參數都可以一一匹配,這是真正的所見即所得。

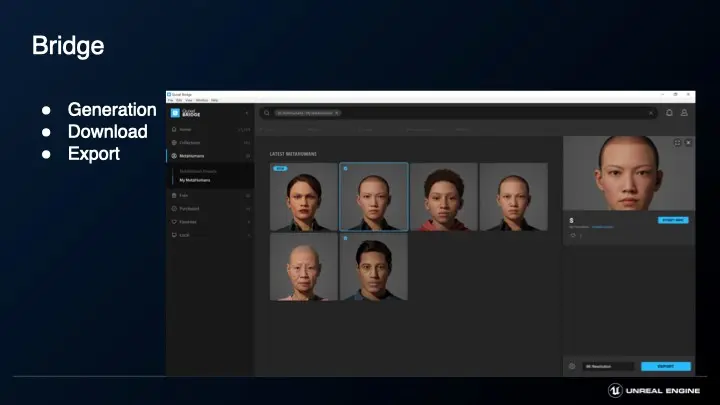

從MHC捏好之後,就可以通過Bridge下載你製作的數字角色了,打開Bridge可以看到Metahuman的分欄,裏面會實時更新你捏的MH,在Bridge需要配置你希望下載的紋理分辨率。在點擊download的時候,會有一個自動步驟是生成,生成是根據捏人時候設置的數據,比如皮膚,以及download設置的參數,基於這些數據生成紋理和LOD,因為後台跑的是虛幻引擎,所以模型以及骨骼的LOD,都是基於規則,使用引擎內LOD減面和骨骼LOD剔除達成的,而對於毛髮的LOD,為了保證效果,是手動生成的插片和模型LOD,MetaHuman的資產生成可能需要一點時間來處理,這主要取決於所選擇的資產是什麼,它們的紋理分辨率以及你現在的網速,還有就是會考慮到你現在的Bridge隊列中有多少資產需要生成,平均來説,如果你下載的是一個有1K紋理的MetaHuman,需要大約20分鐘來生成和下載。

在下載的時候選擇的紋理分辨率,並不是一個絕對分辨率,而是一個指引的分辨率,也就是説如果選擇下載8K的,實際上只有貢獻最大的normal和cavity紋理是8K的,而皮膚albedo是2K的. 這其實和皮膚本身的特性有關,一般SSS皮膚散射的效果接近於低頻的濾波,效果有點類似於blur之後的紋理,所以albedo的高頻細節本身就會被SSS的shading特性抹掉,我們對albedo的貢獻做了效果和效率上的評估,發現8K 4K的albedo相對於2K的效果改善幾乎是肉眼不可區分的,所以在這裏使用了2K的分辨率。而roughness紋理,是使用虛幻中一個自帶流程將法線轉換為粗糙度,通過Bridge導出可以導出到maya和虛幻引擎中,接下來我們來分析在虛幻引擎中的MH。

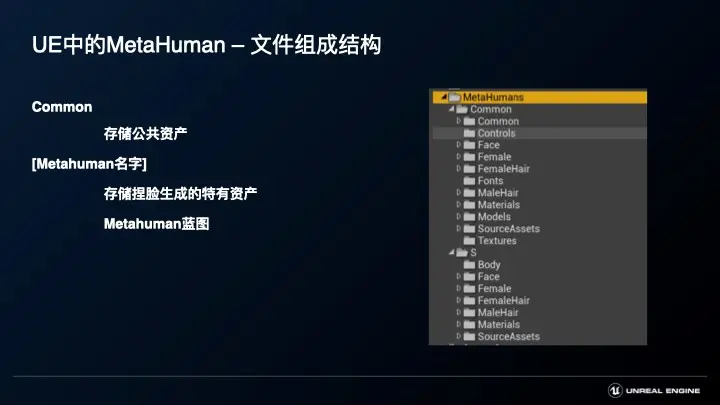

導入引擎後,會有一個專門的Metahuman文件夾,對於所有Metahuman生成的數字角色來説,無論是男性還是女性,有些資產內容都是共通的,我們把這些存儲在MetaHuman/Common文件夾中,而每個人特有的資產則存儲在相應名字的文件夾下。

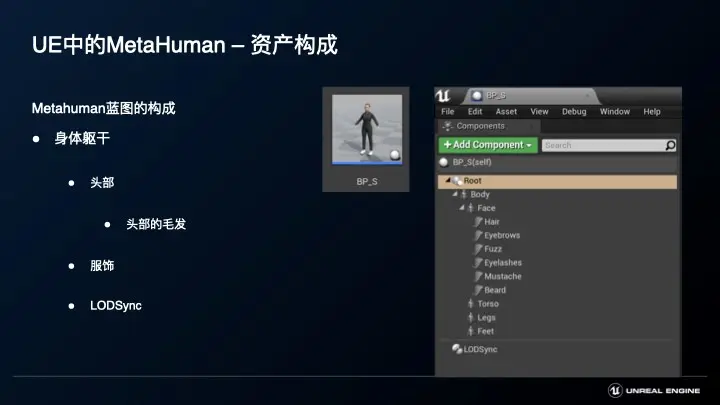

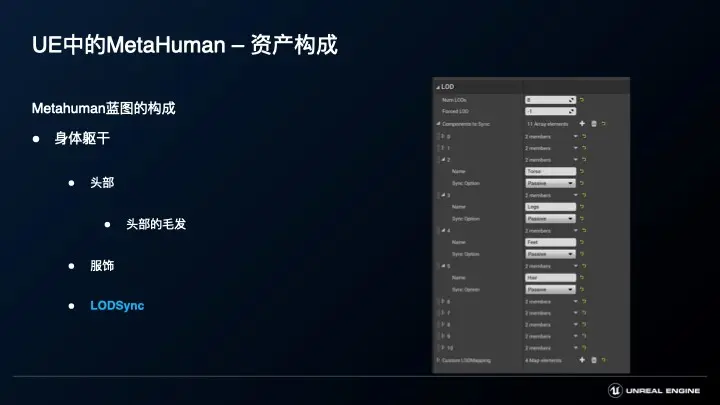

位於Metahuman文件夾下,Metahuman的身體各部件會以一個藍圖組合到一起,包含軀幹,面部,面部各種毛髮,出於性能和效果的平衡,並且為了適配不同的平台,不管軀幹還是毛髮,都有自己的LOD信息。

比如頭部我們設置了8層LOD,我們為每層LOD設置了一定規則,每層LOD都有獨立的,頂點量、blendshape,、關節數、動畫紋理、蒙皮影響等區別,blendshape因為性能開銷比較高,所以從LOD1開始就沒有在使用,而紋理動畫則是因為需要讀入的紋理非常多,所以LOD2開始沒有在用,當然從屏幕上看這些頭部,可能LOD3或者LOD4開始 ,之後的效果會顯得有點粗糙,但是LOD的選擇一定是要綜合考慮到屏佔比來去衡量效果的。

比如我在對應LOD的屏佔比上去截了這三張圖,分別是拉到最近時候的LOD0,中距離看到全身時候會切換到的LOD3,以及遠距離切換到的LOD7。

我在相同距離下,把模型強制按LOD0渲染作為對比,也就是圖上現在新增的LOD3和LOD7旁邊的對應的頭部和全身,可以看到兩者的區別並不是特別大,也就是在這樣的距離下,在這樣的屏佔比下,LOD切換對於畫面的效果並不會影響太大,LOD其實不光是對於性能有提升,對於畫面效果也是會有一定改善的,比如大家常見的畫面失真摩爾紋,引入LOD就可以改善這種情況。

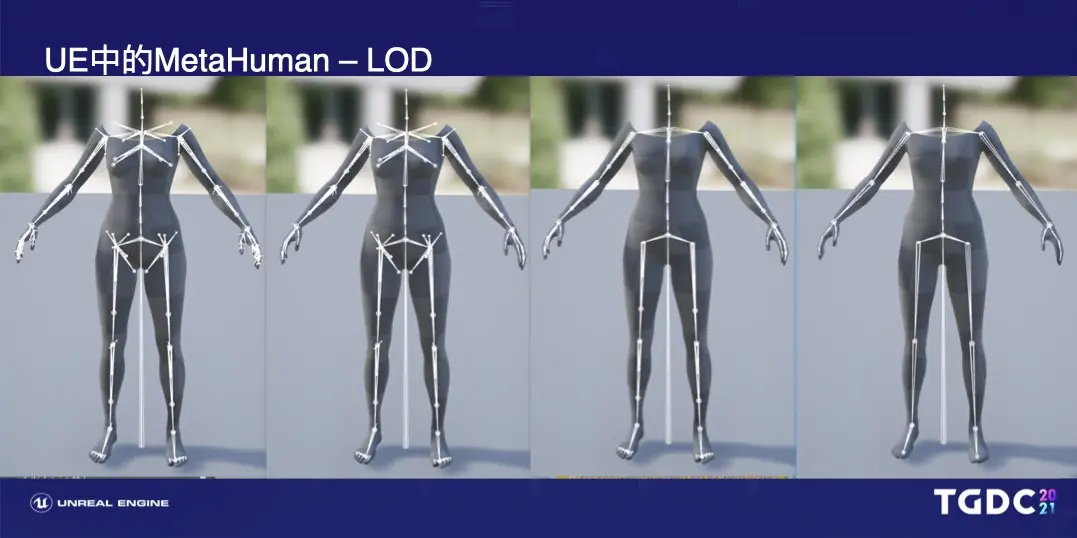

這是身體模型的LOD數據,身體只有4層LOD,以畫面上的褲子為例LOD0是有一萬五千面左右,而LOD4 大概是一千五百面左右。

對於骨骼而言,骨骼模型的LOD可以大量減少skinning的開銷,但是他還需要骨骼的LOD,骨骼的LOD可以很大減少動畫Evaluation中採樣、插值、混合的開銷。那麼身體骨骼LOD0是150根骨骼,LOD4是55根骨骼。

大家其實注意到,每個不同的部分可能LOD層數不一致,比如説剛才的頭部是8層LOD,而身體的LOD只有4層,同時要考慮到,因為身體和頭部的屏佔比不一致,所以計算出來的LOD也會不一致。那就會導致效果上出現一些不匹配的問題,比如身體和頭部的接縫處沒有辦法完全匹配,或者説,我們考慮毛髮的話,屏佔比很小的眉毛groom可能永遠沒有辦法渲染到LOD0,而只有很近處才需要的汗毛groom,卻因為包圍盒是整個面部,所以會在中距離處也會渲染到LOD0,這是一個性能上的浪費。那麼為了解決這個情況,引擎加入了LODSync component,通過配置LODSync component在這裏面配置不同部位的貢獻和計算方式,可以讓不同部位也可以做到共享一套LOD。

因為時間關係,可能沒有辦法分析引擎中metahuman每一個細節,下面我會以相對靜態和動態資產為區分,結合可伸縮性,主要介紹下面幾個主要的部分。

首先是毛髮,毛髮包括:頭髮,眉毛,面部的絨毛,睫毛以及鬍子。

毛髮採用了引擎的Groom毛髮系統,這裏不會細展開groom本身,而是介紹Groom對於Metahuman的一些處理,以及值得注意的地方。

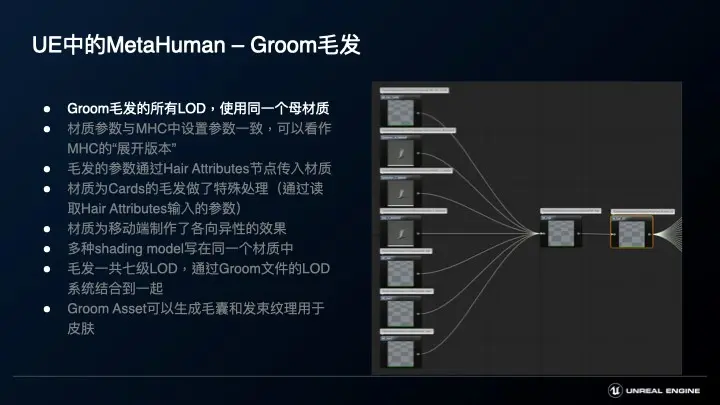

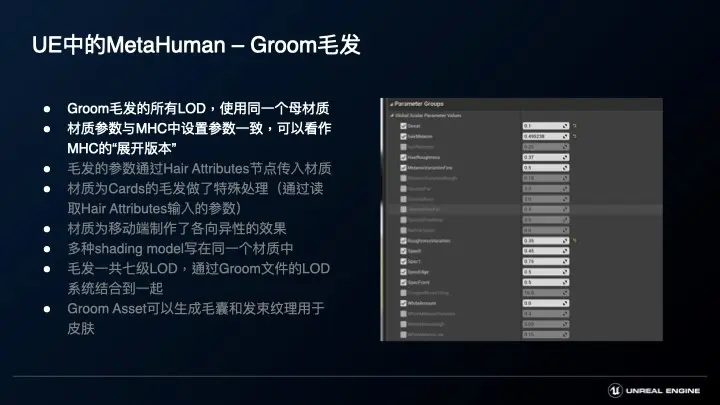

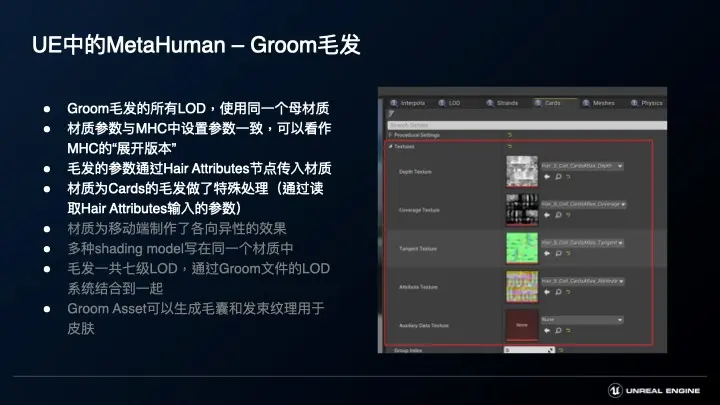

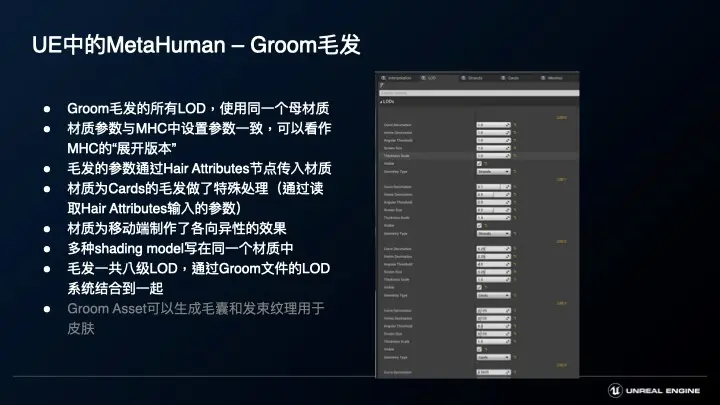

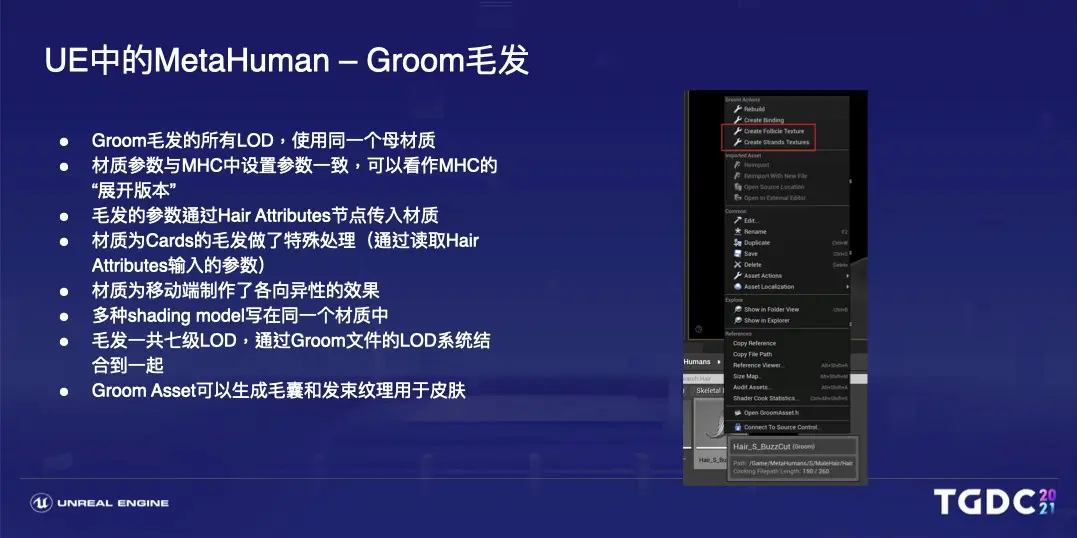

Groom毛髮的所有LOD,不管是插片還是mesh,都使用同一個母材質。

毛髮的材質參數與MHC中的參數是一一對應,可以看作MHC的“展開版本”。比如可以看到材質中,有紅色素,黑色素,如果你在MHC調整頭髮顏色的時候注意過,這些參數就是MHC中的調整參數及數值。

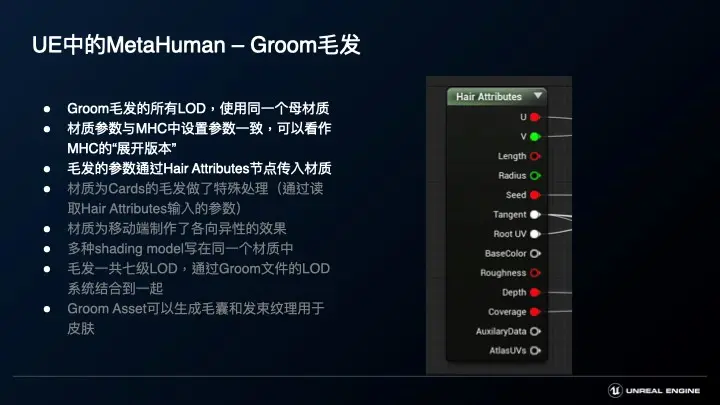

另外Groom毛髮的參數是通過Hair Attributes傳入到毛髮材質中的。

將深度紋理輸入到hair attributes的方式,是在groom asset中,cards分頁下指定對應紋理,比如説深度紋理,一般輸送到插片毛髮中是會用於、pixel、depth、offset,他是改善頭髮與頭皮交叉的效果,另外是Coverage用於毛髮的opacity,裏面比較特殊的是Attribute紋理,Attribute紋理對應的是Root UV和Seed,Seed也就是毛髮的unique ID,一般是用於在材質中加強頭髮的髮絲感。

大家知道,後續我們會為移動端增加多種shading model,但是當前移動端還不支持,所以當前只能fall back到default lit。

毛髮在效果上是有一定特殊性的,他基本上來自於兩個大的功能,一方面來源於毛髮的各向異性特性,另外一個是層層毛髮會具有一定的透射散射,那為了改善移動端的效果,毛髮材質中為移動端單獨增加了各向異性的效果,就是現在截圖中的這一段,至於毛髮透射散射的部分,因為移動端只採用了一級LOD採用插片毛髮,其餘都是Mesh毛髮,在mesh毛髮上比較難以表現毛髮間細膩的透射散射,所以綜合考量,我們並沒有在移動端去處理這塊。

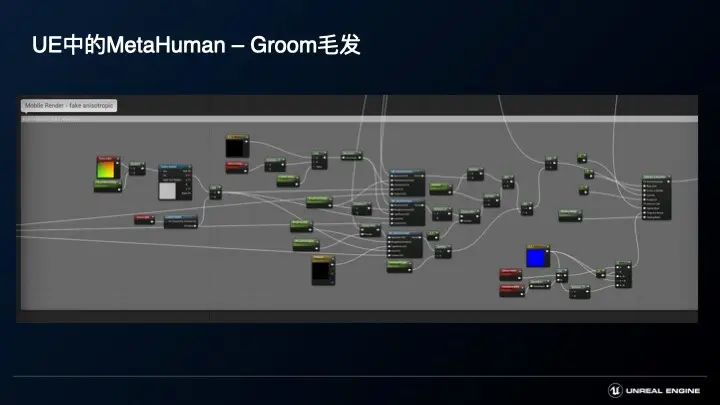

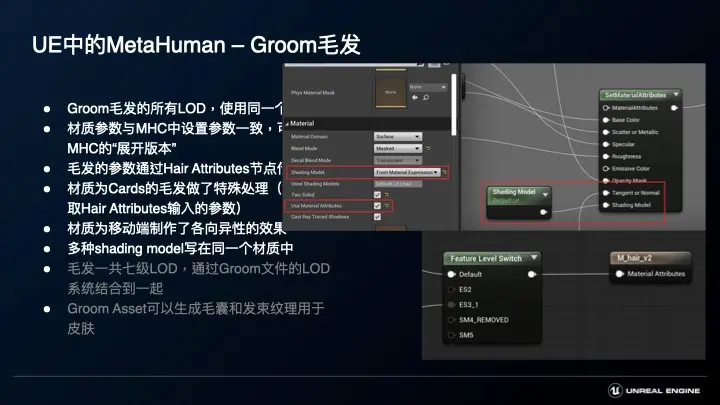

剛才其實是多種shading model,但是都寫在同一個材質中,這其實是源於引擎最近幾個版本提供的新機制,材質系統並不鎖定整個材質的shading model,而是把shading model作為一個參數去進行一個輸入,然後不同的material attribute輸入到不同的feature level下,這樣子就可以做到一個材質實現針對不同平台,按照不同的shading model去進行渲染。

毛髮的多級LOD,Groom, 插片,mesh,這些不同形態的資產是通過Groom文件中的LOD系統結合到一起,通過LOD分頁,可以對這些LOD進行統一管理。

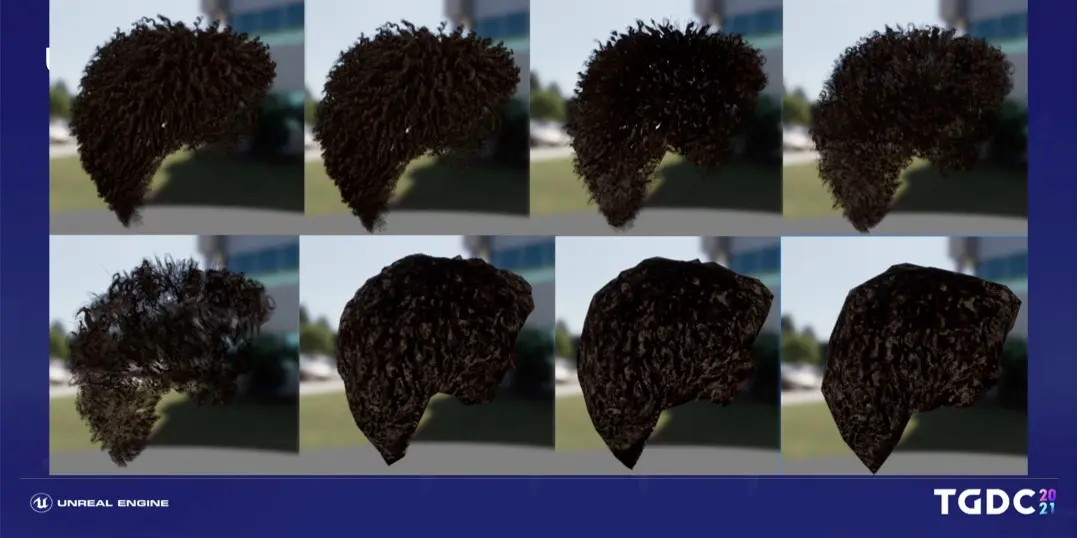

這是MH毛髮的LOD數據,LOD 0–1 使用strand based hair,一般用於高端平台,比如説次世代主機和高端PC,LOD 2–4 基於插片毛髮,LOD 5-7 是基於簡化的mesh毛髮。

這是MH中一個角色的毛髮LOD展示,我們可以看到其實有幾層因為面數比較少,所以會變得稀疏。

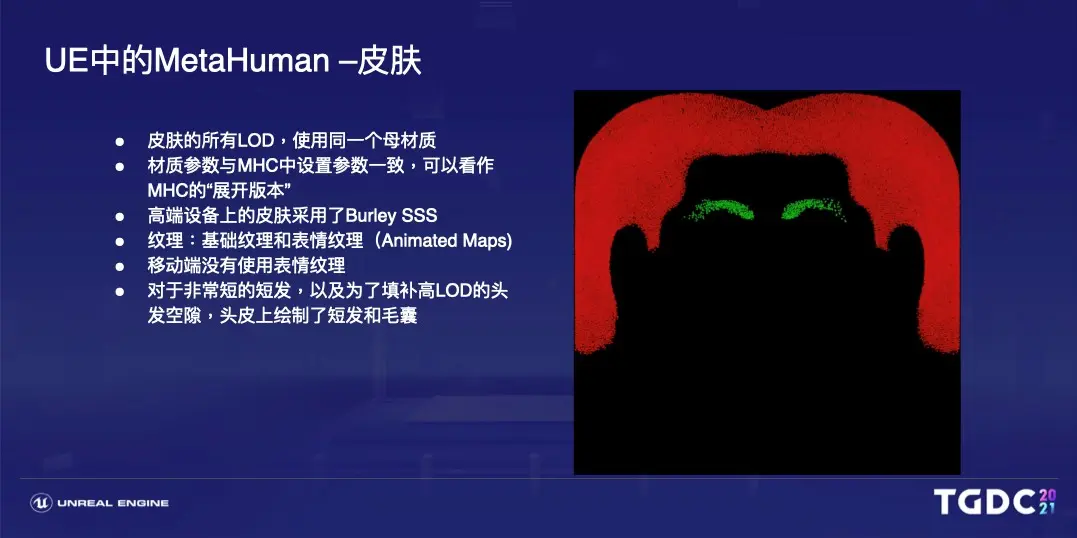

這個解決方案之一是使用遮罩紋理放在頭頂皮膚,引擎也提供了對應工具,就是説右鍵groom asset, 可以生成毛囊紋理,此外,對於非常短的短髮,其實並不適合創建插片或者mesh來做為LOD,這個時候也可以通過groom asset生成髮束紋理,等會講到皮膚,我們也會提到這張髮束紋理。

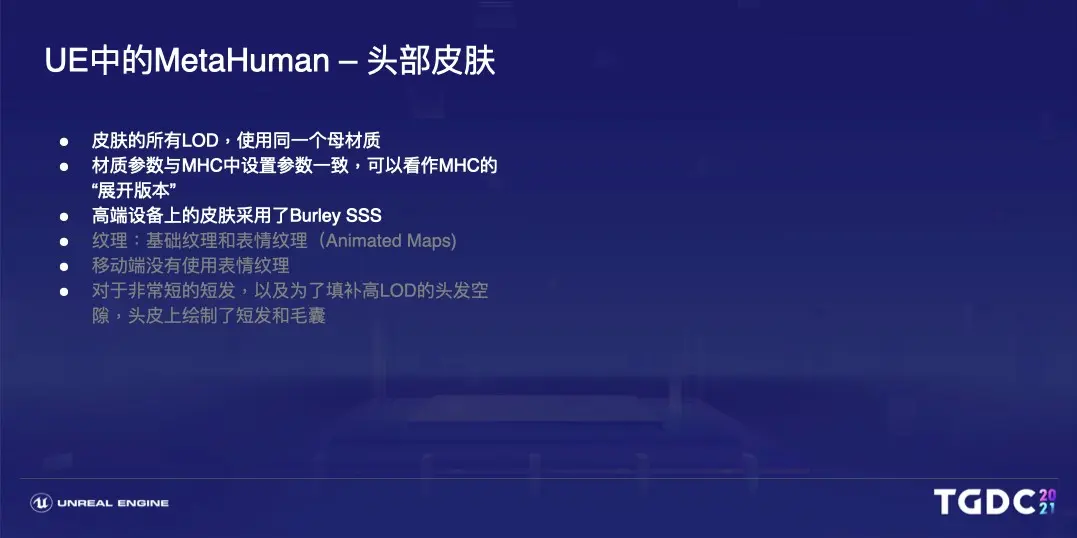

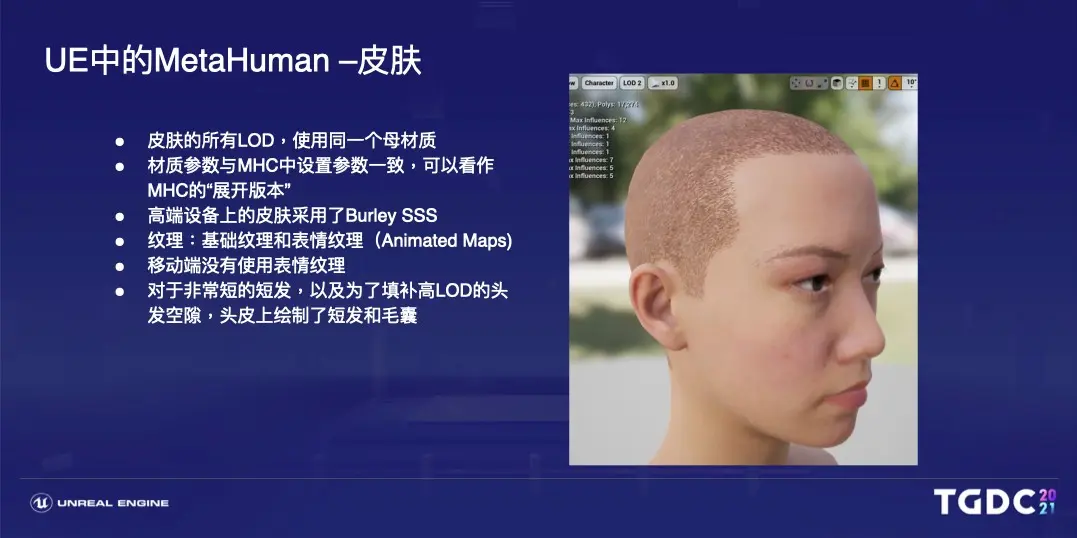

皮膚和頭髮的設計是有一些類似的:比如只有一個材質資產。材質屬性與MHC中是一一對應的,在中高端設備上,皮膚的渲染模式採用了Burley SSS,移動端因為沒有這樣的shading model,所以會自動回退到Default Lit。

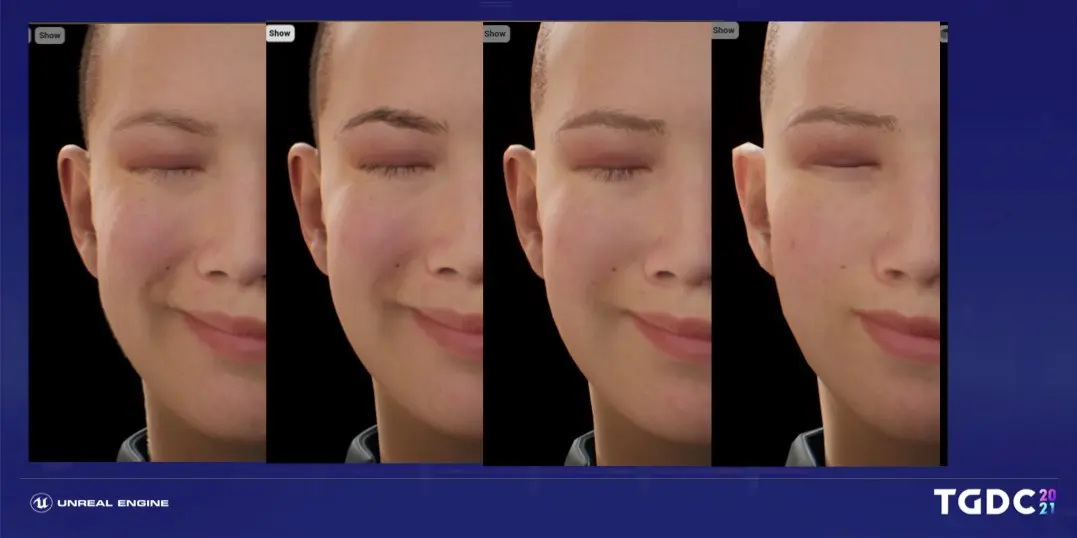

皮膚的紋理方面,特殊點在於有一套表情紋理,是一個基礎姿態和三個表情姿態,通過在做表情時融合表情紋理,它可以提高整體的細節效果。

表情紋理主要用於描述皮膚在表情比較大、皮膚褶皺比較深的時候的形態,比如左圖是基礎姿態,右圖是努力抬眉毛或者額頭,有明顯抬頭紋時的形態。

可以看到,表情紋理會用到大量的紋理數,因此對於帶寬和渲染都會造成一定壓力,移動端是沒有使用表情紋理的。

對於皮膚,除了繪製皮膚本身的效果和妝容信息,有時候還需要繪製毛囊或者髮束,比如説演示的這個角色,頭髮非常短,頭髮是沒有製作插片毛髮或者Mesh毛髮而是把短髮的髮束紋理,繪製到了皮膚的頭皮部位。

頭皮上繪製短髮和毛囊的這張紋理,就是通過剛才提到的Groom asset生成的髮束紋理。

上面介紹的groom毛髮,還有皮膚都是引擎中已有的機制,可能很多用過虛擬引擎開發的同學都已經非常熟悉了,下面着重介紹下表情。

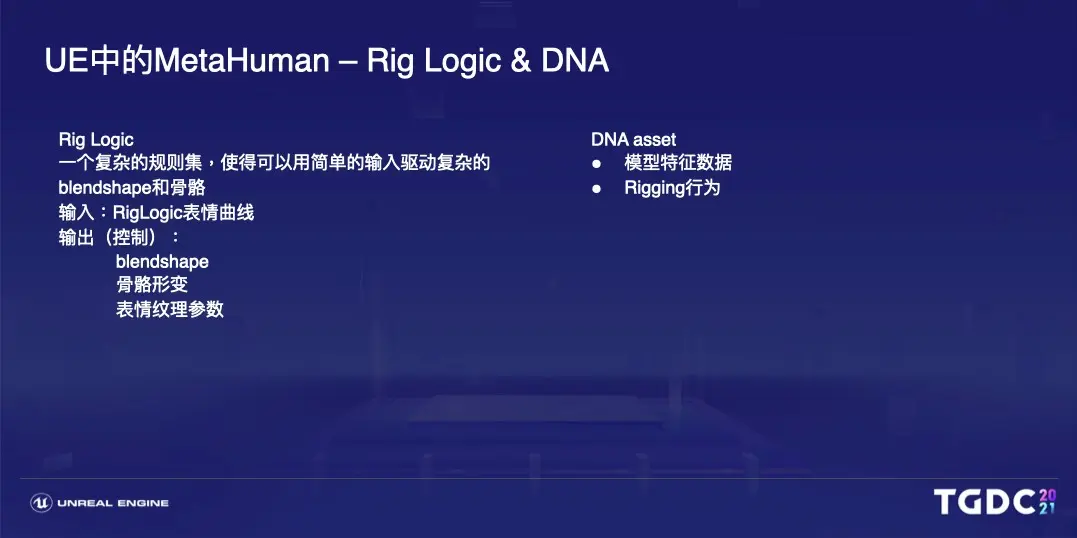

為了實現數字角色真實可信的表情,metahuman採用了骨骼形變,blendshape材質中加入表情紋理的混合方案,表情本身來自於骨骼形變,而blendshape用於補充細微肌肉細節,表情紋理主要用於加強皮膚出現褶皺時候的表現,大家可能還記得,在metahuman面部LOD0有600多根骨骼,同時又要保證不同LOD的表現基本一致,還要控制這三套參數,整體加起來是非常複雜繁瑣的。所以我們採用了來自3Lateral的Rig Logic系統,Rig Logic是一個非常非常複雜的規則集,可以從簡單的輸入來驅動數以千計的Blendshape和骨骼,表情紋理,Rig Logic運作需要一些模型的額外信息,比如説模型的特徵數據,以及模型的rigging行為,提供這個數據的,就是我們在一開始提到的每個模型獨有的DNA文件,DNA文件用於描述角色的外觀和骨骼綁定,基於這些,即使是不同的metahuman面部的骨骼,蒙皮,面數等信息有所差異。也可以通過使用這樣一套的RigLogic,用一套驅動數據驅動所有metahuman的表情,你不需要對每一個角色都去重新的製作。

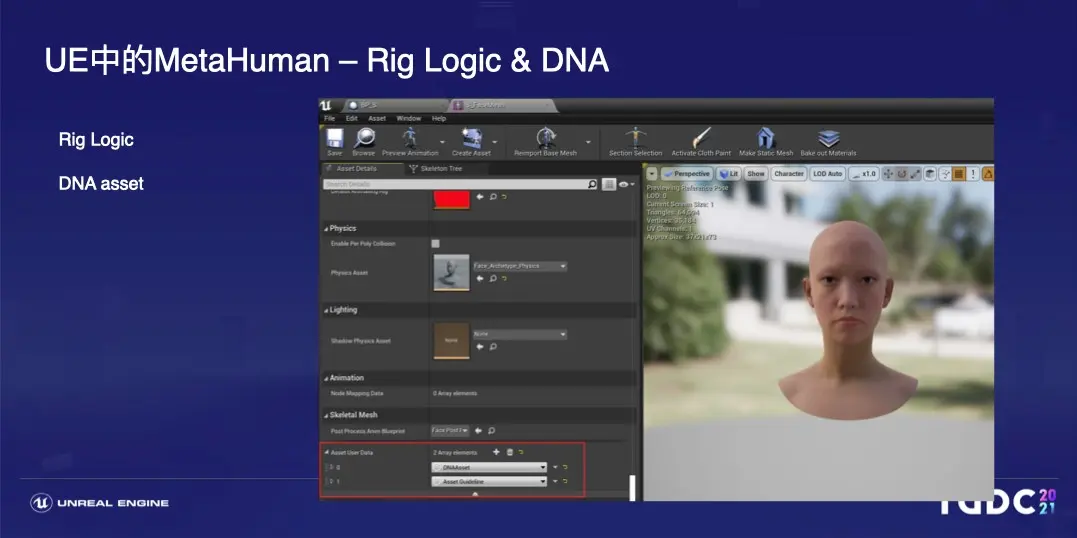

如果你在引擎中打開模型頭部,可以看到details中有指定了一個DNA asset文件,這個文件來源於你在捏臉的時候,根據捏臉的數據生成的,DNA 文件是與捏的MH一一對應的關係。另外如果你把metahuman導出到Maya中,也會看到提示,是否要安裝RigLogic,包括指定這套DNA。

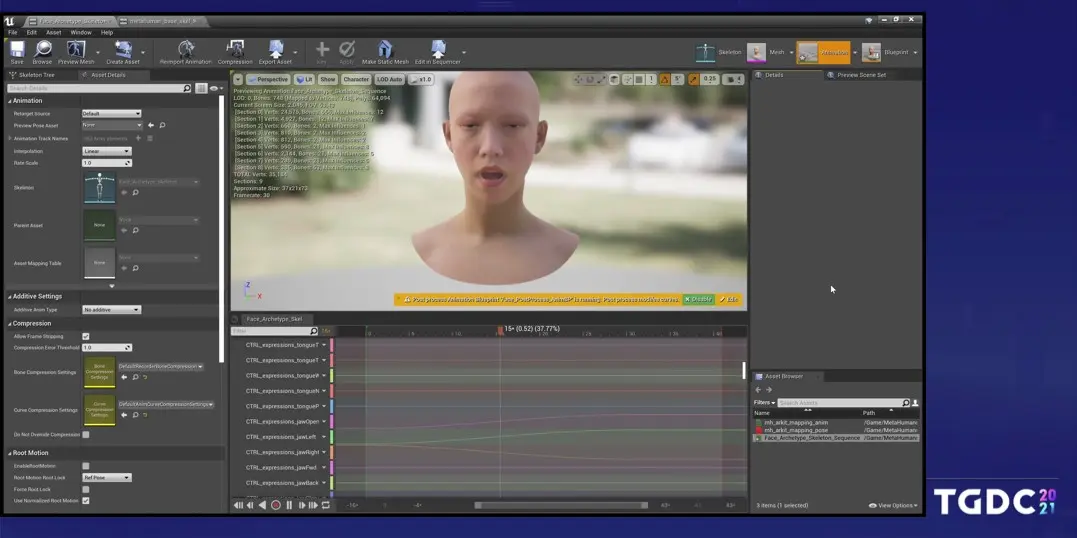

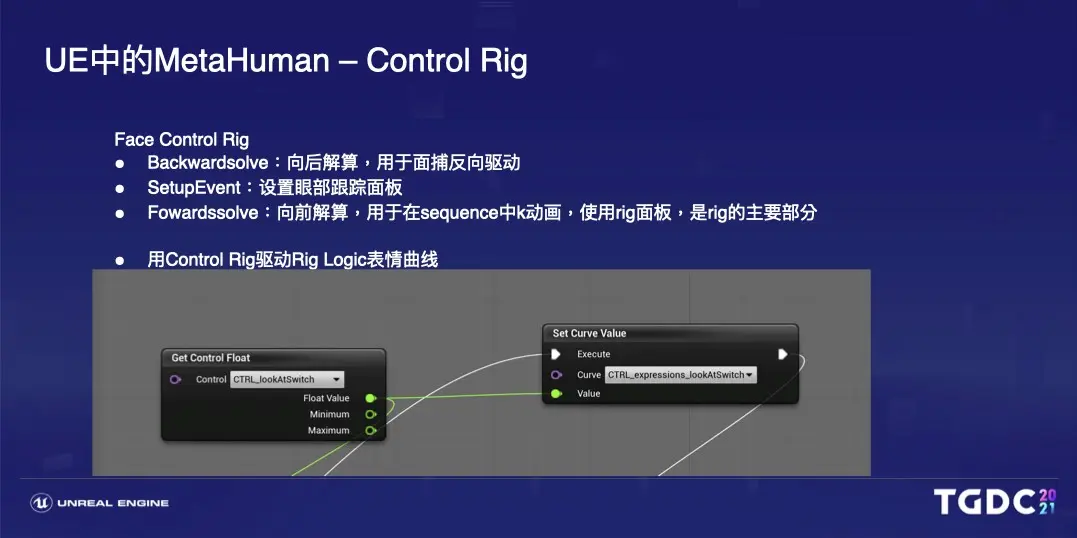

RigLogic驅動表情採用的是RigLogic表情曲線,每個RigLogic表情曲線, 對應一組骨骼和blendshape還有表情紋理。

比如我通過sequence生成這樣一個打哈氣的表情,生成好之後是基於你K的數據,生成了RigLogic表情曲線,而RigLogic表情曲線再進一步驅動骨骼,blendshape,以及你的表情紋理,並且這套曲線可以在動畫中二次調整,你可以看到我剛才改變這條曲線,模型會隨之發送改變,另外Rig logic表情曲線在runtime下也可以做出調整。

剛才提到面部表情是由骨骼、blendshape、面部表情紋理共同構成,對於基礎的面部表情都是基於骨骼的blendshape貢獻細微的肌肉變化。表情紋理貢獻做表情時皮膚的褶皺,對於面部表情的品質,這裏做了個簡單的對比,從左到右分別是LOD0,1,2,4,除了面數和紋理本身精度的降低導致的影響外,表情方面,最左邊是包含所有信息的表情,也就是説骨骼、blendshape、表情紋理這些所有信息的表情,第二張去除了blendshape的貢獻,第三張去除了表情紋理的貢獻。那麼可以看到,對比起來,第二張和第一張的區別不是那麼大,只在眼周有一點點微小的變化,而對於第三張和第二張的對比其實差別是蠻大的,她的魚尾紋都會消失掉,也就是説對最終品質而言,大多時候表情紋理的貢獻是大於blendshape的。第四張是相對於第三張做了進一步的減面,本身的面數只有1400面,同時也沒有表情紋理的改善,在表情的表現上會弱一些。那麼在引擎中製作表情,不管是通過錄制或者是手調,都是通過Control Rig操作RigLogic表情曲線來做到的,我們來看下Metahuman中的Control Rig。

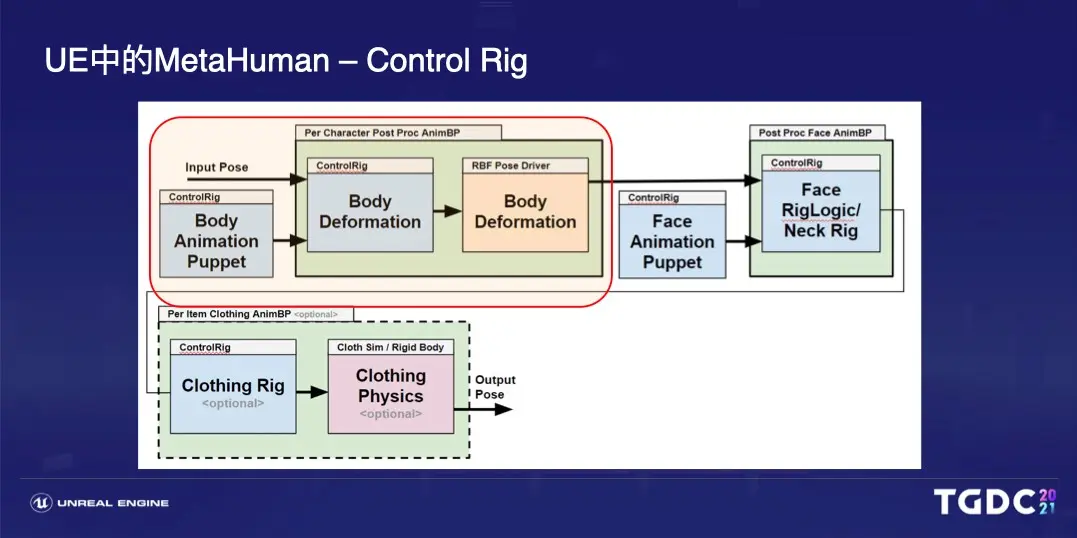

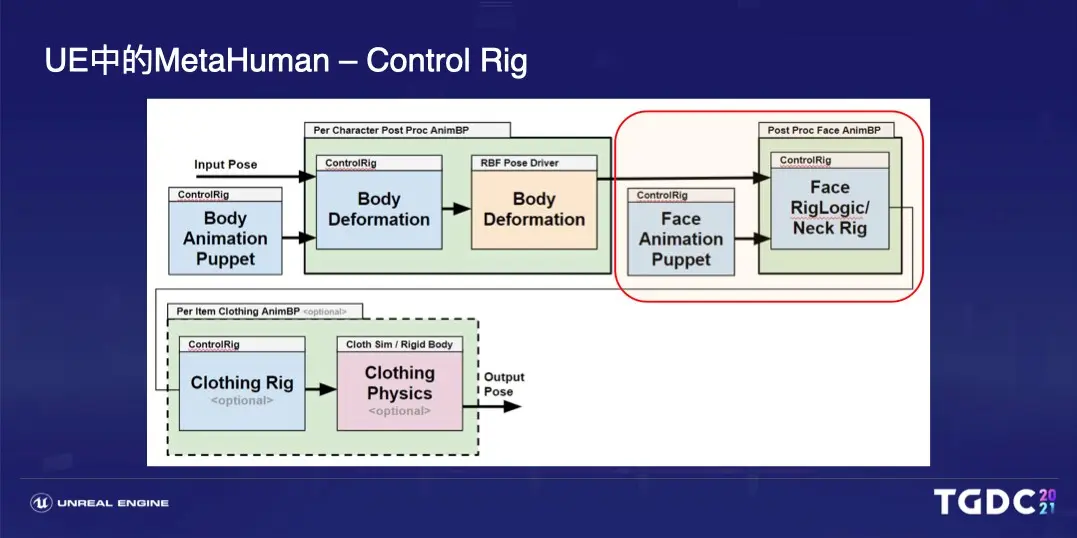

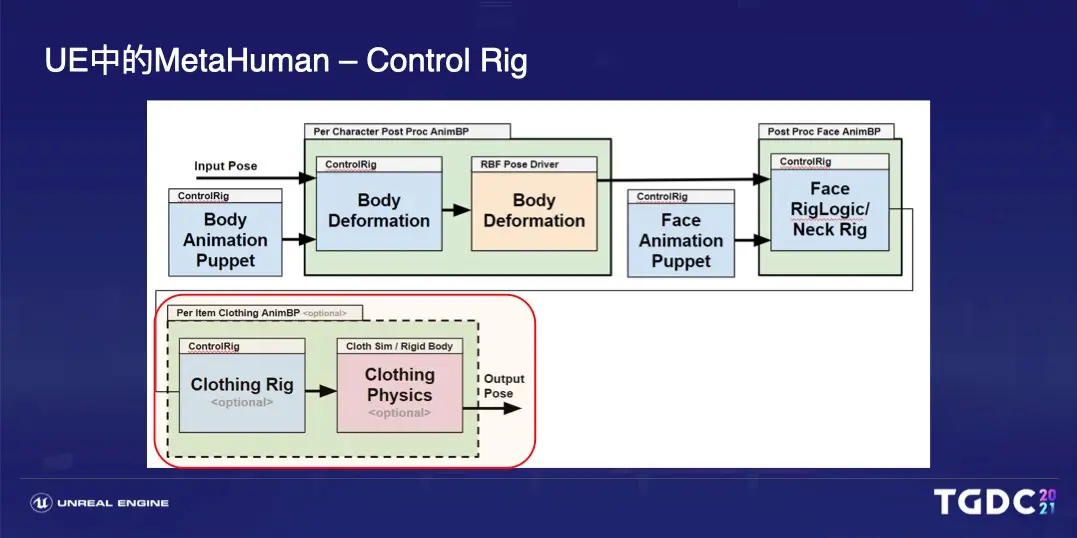

Metahuman中,Control Rig可以認為是分為了3個綁定分層,首先是木偶綁定,也就是MetaHuman的第一個綁定分層,用於動畫師通過Control Rig來創造動畫和表情的。

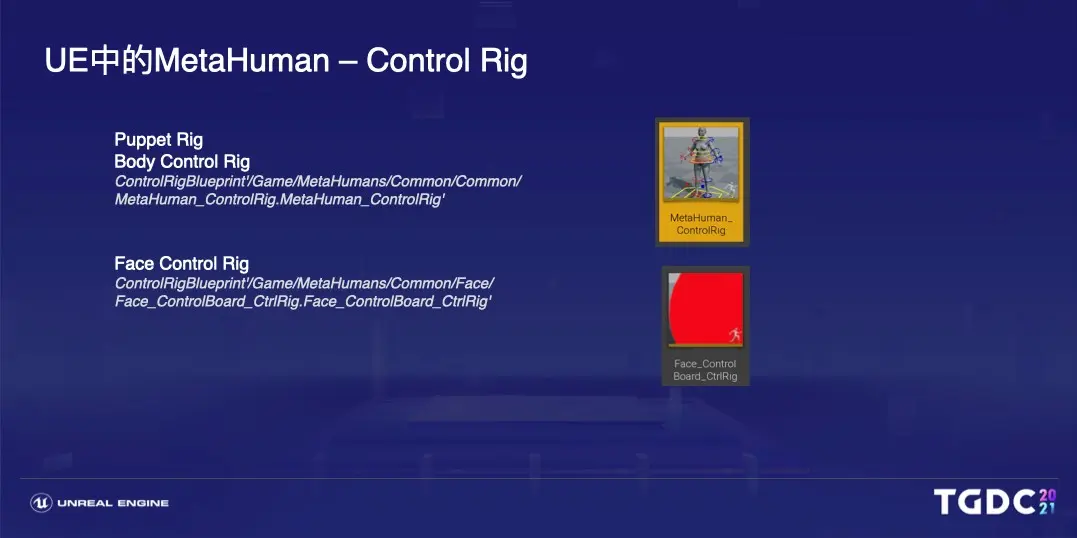

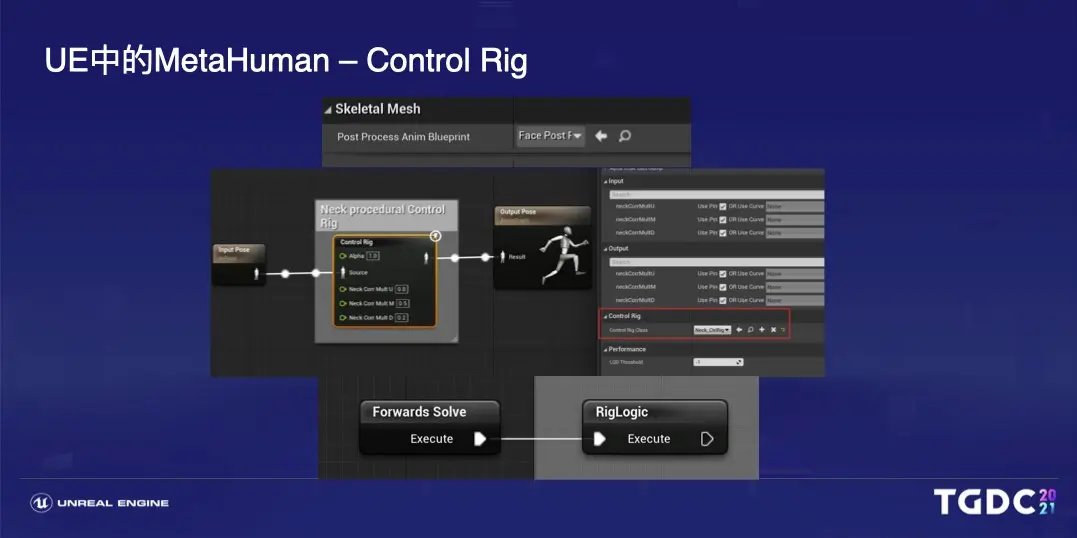

身體和麪部的Control Rig都位於Common文件夾下,打開可以看到完整的ControlRig實現,身體Control Rig是比較常規,是直接驅動骨骼,而面部的Control Rig則是驅動Rig Logic 表情曲線。

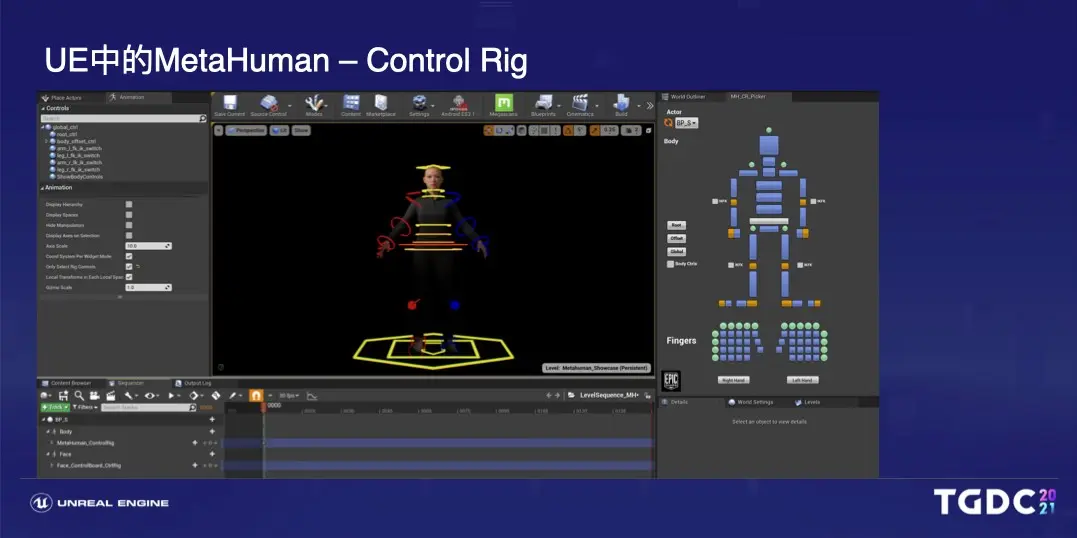

當然對於動畫師而言,不太需要關注Control Rig的實現,實際需要的還是一套好用的K動畫工具,對於動畫師在引擎中K動畫,使用方法也很簡單,就是直接把角色藍圖或者角色拖到sequencer中,因為模型身上有Control Rig信息,就會自動出現身體和麪部的Control Rig界面,對於身體而言,你還可以用Metahuman中預設好的Editor Utility Widget,快速選擇Control Rig以及切換 IK FK。

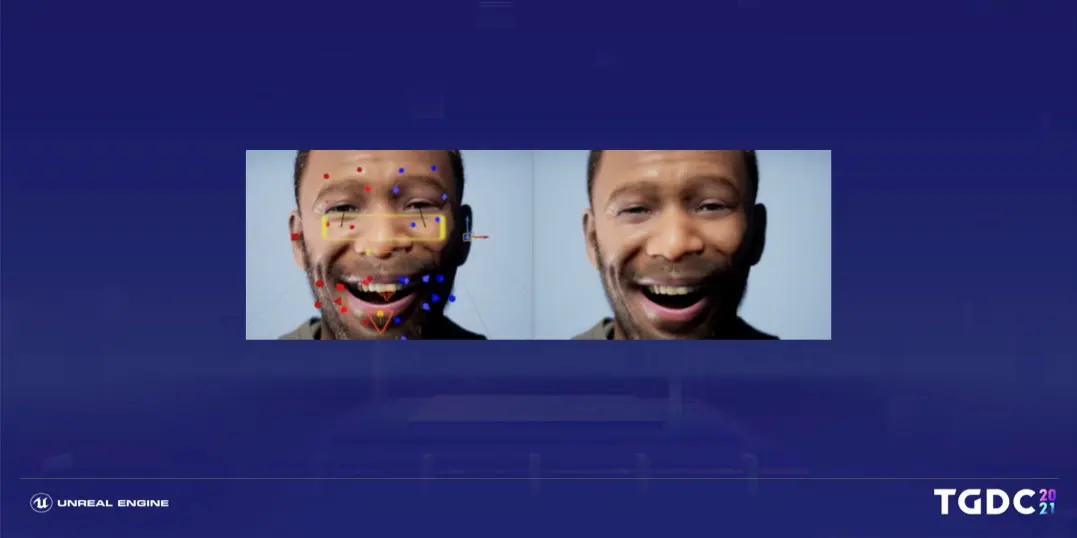

對於面部Control Rig,Face Control Rig中分為三塊,一塊是用於面部捕捉的backwards solve,一塊是forwards solve,也就是用於我們在sequencer中K動畫,另外還又一個比較小的模塊是setup event中添加了一個眼部關注點的模塊,因為剛才介紹了面部表情是非常複雜的,面部的Control Rig是驅動Rig Logic 表情曲線,Rig Logic這套系統會根據模型對應的DNA asset信息,把Rig Logic 表情曲線映射到blendshape和麪部骨骼以及動畫紋理上。

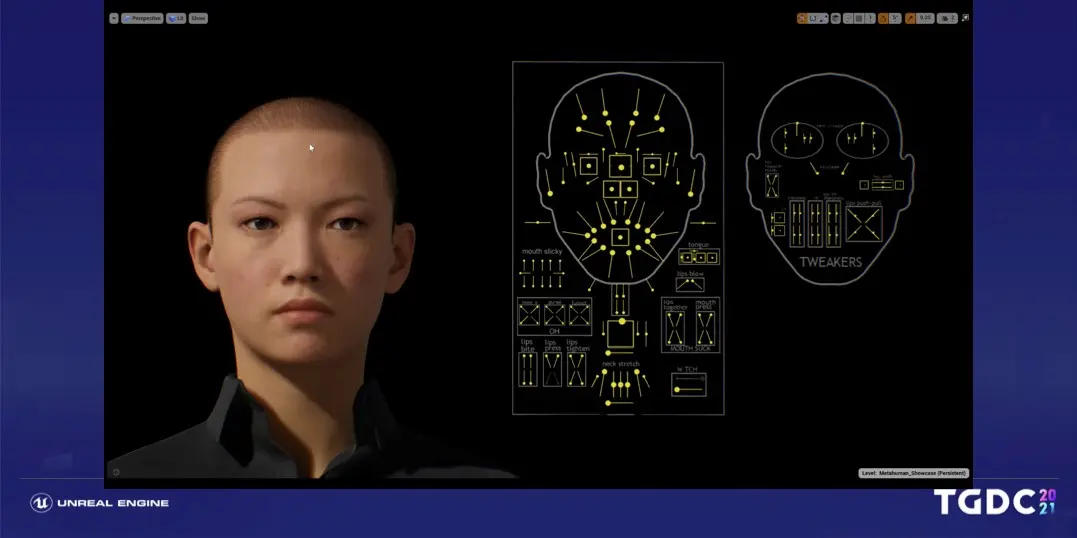

對於面部我們提供了一套預設好的Control Rig面板,這裏做個簡單的操作演示,在這裏每個控制器對應一組肌肉羣,另外面部Control Rig提供了watch的小模塊,你的眼睛會始終盯着這個模塊,在模塊移動時不止眼球會不斷髮生轉變,眼周的肌肉也會做出正確的改變。

另外我們也提供了一套簡易的面部Control Rig,直接依附在面部上,這樣可以更直觀的進行表情製作。

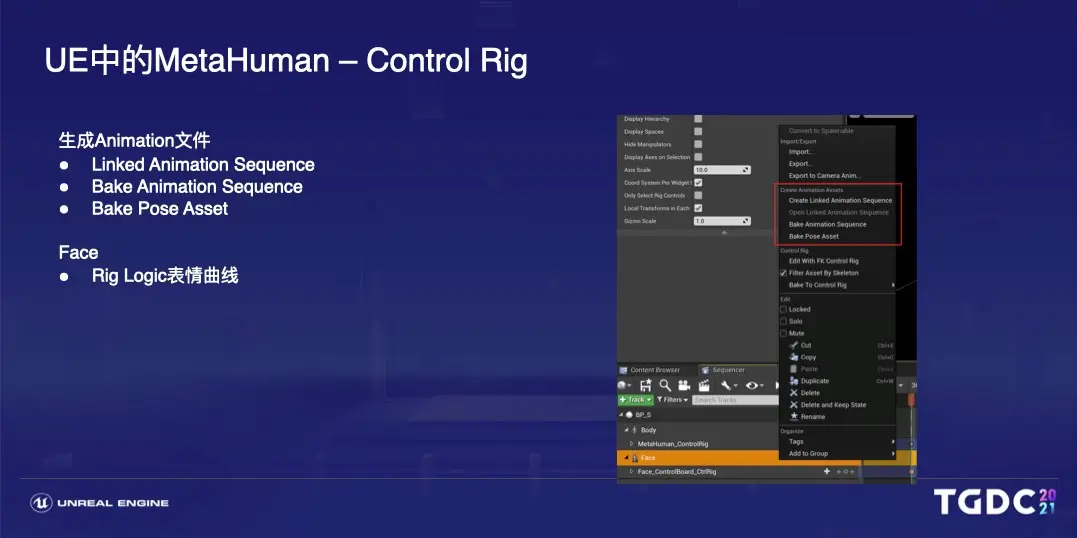

如果你是為了在遊戲中使用,在Sequencer用Control Rig作好動畫後,為了性能考慮,最好把K好的數據以動畫文件生成出來,引擎默認提供了這樣的工具,右鍵模型,可以生成animation文件,身體的animation保存是骨骼的transform信息,而面部的animation, 保存的是rig logic表情曲線。

接下來是Control Rig的第二個綁定分層,變形綁定 :變形綁定用於驅動所有的旋轉和結構關節,模型身上會指定post process animation blueprint,運行一套用於runtime的Control Rig。

以頭部為例,使用了RigLogic在runtime運行,這裏允許各種動畫接口驅動或者運行RigLogic表情曲線,形成最終的面部表情動畫。

最後一個綁定分層是服飾,服飾主要是採用Control Rig來去修正表現,但也不是每一個服飾表現都會用Control Rig,比如説連帽衫的帽線和脖子後方的帽子褶皺,其實是採用了Rigid Body作為物理模擬方案。

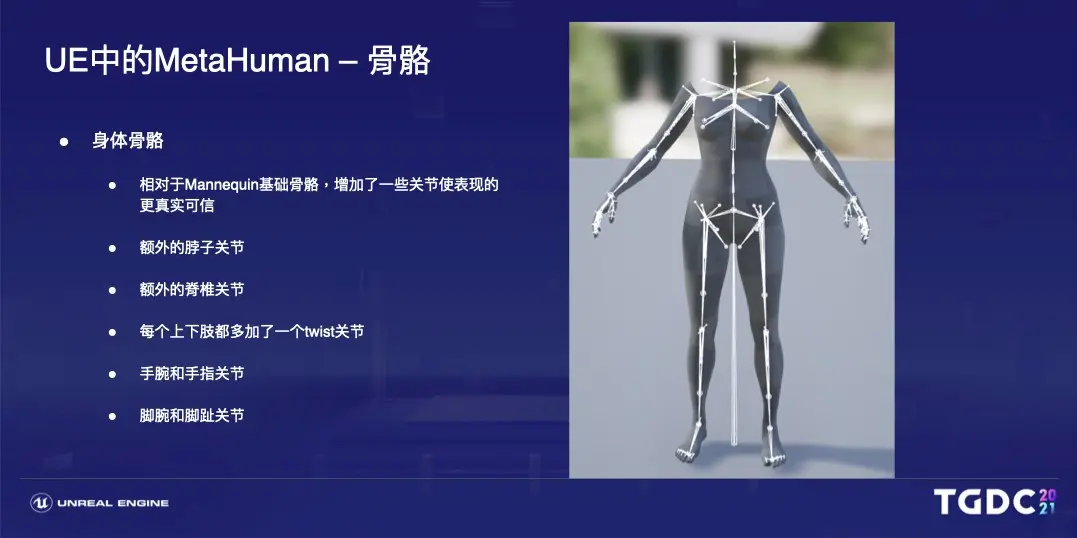

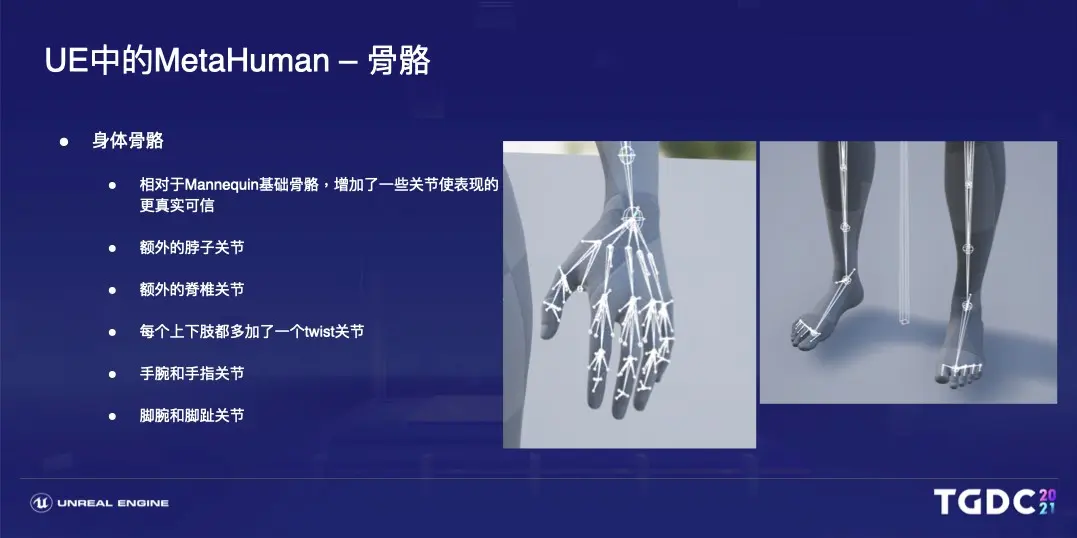

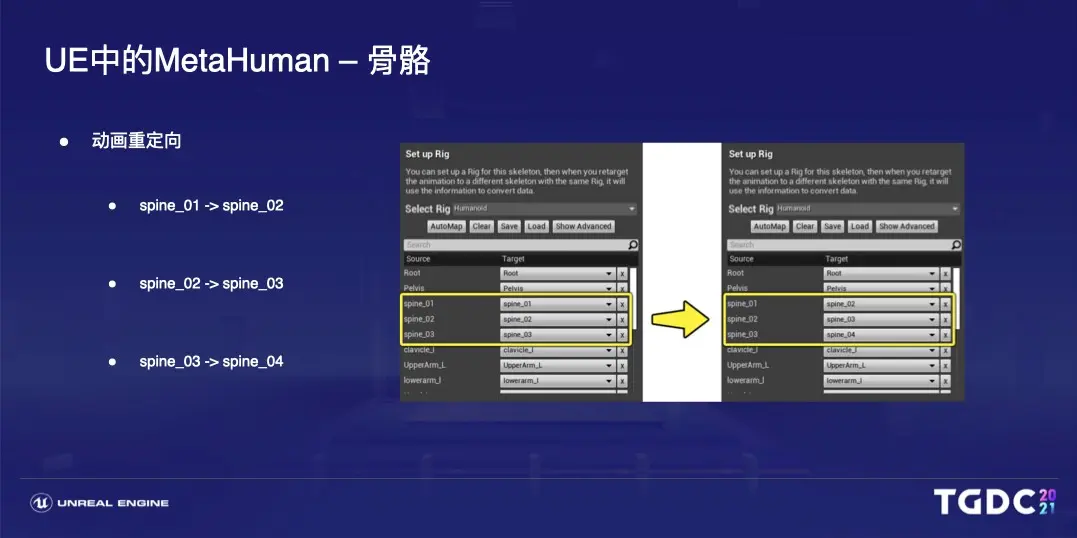

在身體骨骼方面,為了表現更真實可信,相對於之前大家比較熟悉的小白人,MetaHuman的身體骨骼方面增加了一些額外的關節,增加的這些關節大多數是肢體末端的葉子關節或是輔助關節,基本只會影響到表現,但是需要額外注意的是增加了額外的脊椎關節,這樣會導致骨骼層級有所變化,所以如果要複用小白人制作的動畫資產的話,是需要做一個重定向的操作。

對於肢體末端關節,我們對於手指的骨骼進行了一個細化,另外增加了新的腳趾關節。

剛才提到如果你想要讓metahuman複用商場中基於小白人制作的動畫,你需要重定向的操作,重定向的話,你是需要重新制定脊椎骨骼的映射關係,對於其他的新增骨骼部分,因為小白人沒有對應骨骼,就會跳過這節骨骼的計算,所以並不會受到影響。

最後還有兩點補充,表情DCC只能使用maya,而不能使用motion builder和3Dmax,這其實是因為3Lateral自己內部一直使用的maya,也就只有針對maya的RigLogic插件,所以如果需要在DCC中製作表情,因為依賴於rig logic,所以只能使用有rig logic插件的Maya。其次是我們建議把Maya作為動畫製作工具,而不是修改工具,我知道,其實很多用户希望能去二次修改metahuman,我們實際上是不推薦這麼做的,原因在之前也提到過,修改模型可能會讓你模型的DNA文件是沒有辦法做到完全匹配的,從而rig logic驅動的表情依賴於DNA,但是他通過這樣的驅動的話,會出現一些不那麼匹配的情況,所以在有一些表情下邊會看起來有些假,所以我們推薦的流程是隻有Maya作為動畫製作工具。當然我也知道現在社區中已經有很多人做過嘗試,用RigLogic驅動自己的模型,可以看到真人的局部和非真人的效果還是很棒的,這裏挑選了兩個來自中國開發者的分享。

這是來自北理工數字表演與仿真實驗室的嘗試,他們有一套自己的掃描角色庫。

這是David Jiang的分享,他使用的是自己創作的獸人形象。但是這裏依然要強調,其實我們並不推薦這樣的流程,可以給大家分享的是我們其實也在內部感知到客户的這樣的需求,所以我們也在積極的嘗試這件事,不遠的未來會給大家提供一套更靈活的捏臉包括二次修改的一個機制。

謝謝大家,今天我的分享就到這裏。

Q & A

Q:為什麼Metahuman Creator捏不出明星臉的亞裔女性?

孫丹璐:因為Metahuman Creator中的捏臉,取決於數據庫中掃描的人臉數據,目前雖然數據庫中亞裔是佔了四分之一,但是因為疫情原因,整體數據庫的總量並不是特別大,所以有些臉型或者面部特徵並沒有收錄到庫中,那麼這些臉型和麪部特徵就比較難捏出來了,那麼基於此,其實在應用方面,尤其是遊戲行業的應用,我們更建議把Metahuman Creator用於捏大眾臉的NPC上面,目前 我們第一優先級就是擴充數據庫,並且我們會徵集這些數據來源覆蓋各個行業與民族,爭取添加更多類型的數據特徵到這個庫中。

Q:Metahuman Creator為什麼不建立本地庫?

孫丹璐:其實這個問題在剛才的演講中已經簡單提到過了,先是這個數據庫 數據庫中的數據是非常非常龐大的,你在捏臉的時候需要處理的數據量也非常大,那麼 考慮到你的硬盤或者是內存 cpu和gpu的運算壓力,它都是非常大的 對於電腦的配置要求是很高的,我們的期望是讓每個用户都能比較低門檻的去打造數字人,這個低門檻當然也包括了硬件設備,另外就是Metahuman還是一個相對早期的狀態,它的更新迭代是比較快的,直接放在雲端可以避免每個用户去頻繁的進行更新,主要是出於以上這兩個考慮,我們最終把Metahuman Creator放在了雲端。