(<center>Java 大視界 -- Java 大數據在智能教育學習效果評估與教學質量改進實戰</center>)

引言:

嘿,親愛的 Java 和 大數據愛好者們,大家好!我是CSDN(全區域)四榜榜首青雲交!在《大數據新視界》和《 Java 大視界》專欄攜手探索技術前沿的旅程中,我們一同見證了 Java 大數據在多個領域的輝煌成就。

如今,教育領域正面臨着新的挑戰與機遇,傳統的教育模式難以滿足個性化教學和精準評估的需求。Java 大數據能否在教育領域掀起一場變革呢?讓我們一同走進《Java 大視界 --Java 大數據在智能教育學習效果評估與教學質量改進實戰》,探尋其中的答案。

正文:

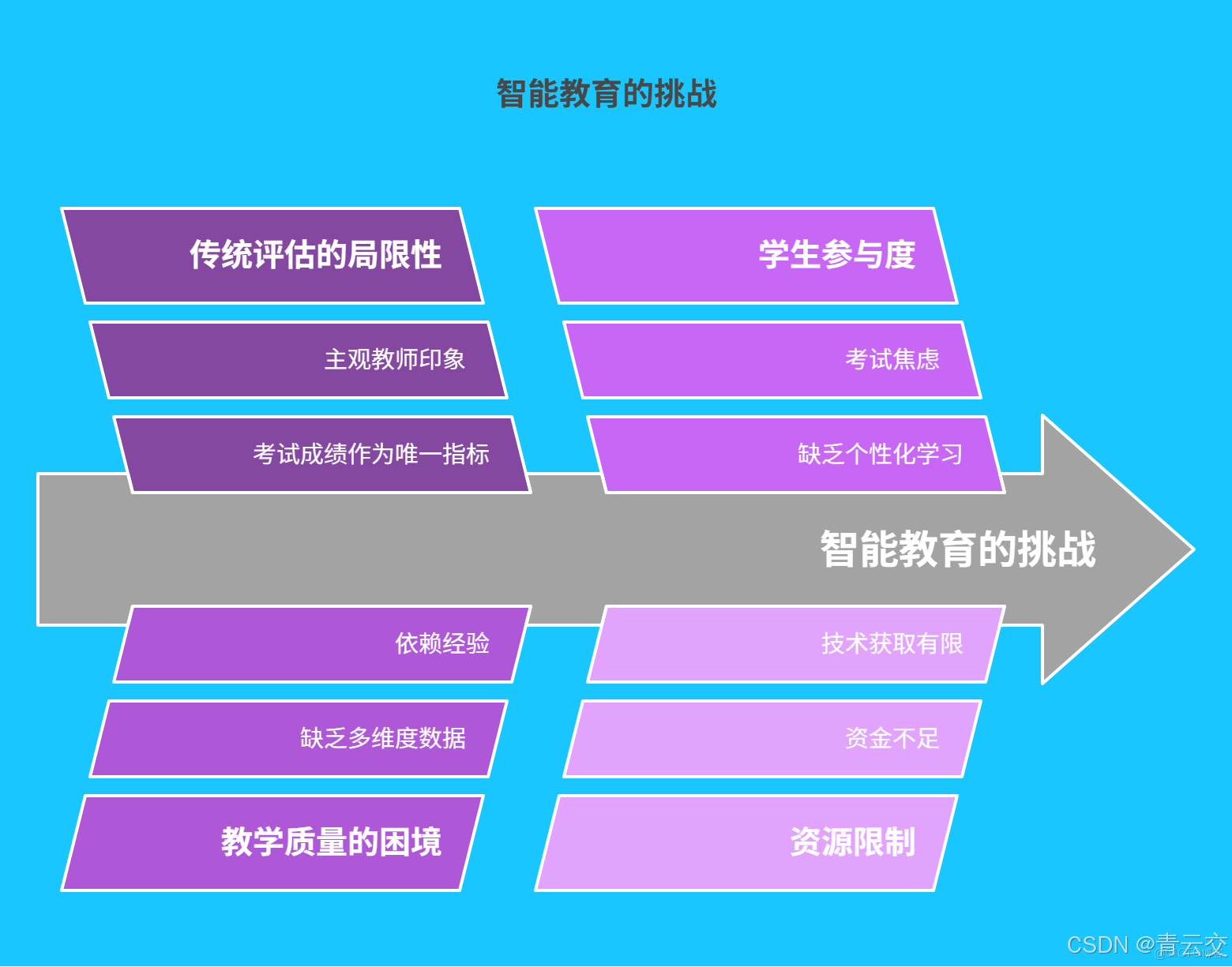

一、智能教育的現狀與挑戰

1.1 傳統教育評估的侷限性

傳統教育評估就像用一把 “通用尺子” 丈量所有學生:考試成績成為衡量學習效果的唯一標尺,教師的主觀印象左右評價走向。某重點中學的數學課堂上,學生小王平時作業完成質量高、解題思路靈活,但因考試緊張成績平平,最終被埋沒在 “中等生” 的標籤下。據權威調研,約 65% 的學生認為考試無法體現真實學習能力,這種粗放式評估不僅錯失挖掘潛力的機會,更可能澆滅學生的學習熱情。

1.2 教學質量提升的困境

教師在提升教學質量時,常陷入 “盲人摸象” 的困境。某小學語文教師發現班級閲讀理解平均分低於年級水平,卻無從知曉:是教學方法不適配?還是學生基礎薄弱?或是練習題型單一?缺乏多維度數據支撐,使得教學改進只能 “憑經驗下藥”,難以精準命中痛點。

二、Java 大數據技術基石

2.1 多源數據採集與整合

Java 憑藉其強大的網絡編程能力與豐富生態,成為教育數據採集的 “超級連接器”。從在線學習平台的點擊流數據,到課堂互動設備的實時反饋,再到校園一卡通的行為軌跡,Java 均可高效採集。以下是通過 HttpClient 從慕課平台獲取學生課程學習記錄的示例代碼,包含網絡異常重試機制:

import java.net.http.HttpClient;

import java.net.http.HttpRequest;

import java.net.http.HttpResponse;

import java.net.URI;

import java.io.IOException;

import java.net.http.HttpRequest.BodyPublishers;

public class LearningDataCollector {

// 慕課平台API地址,需替換為真實地址

private static final String COURSE_RECORD_API = "https://mooc-platform.com/api/course-records?studentId=";

// 最大重試次數

private static final int MAX_RETRIES = 3;

// 重試間隔時間(毫秒)

private static final int RETRY_INTERVAL = 1000;

public static void main(String[] args) {

HttpClient client = HttpClient.newHttpClient();

// 假設學生ID為12345

String studentId = "12345";

for (int i = 0; i < MAX_RETRIES; i++) {

try {

HttpRequest request = HttpRequest.newBuilder()

.uri(URI.create(COURSE_RECORD_API + studentId))

.build();

HttpResponse<String> response = client.send(request, HttpResponse.BodyHandlers.ofString());

System.out.println("第 " + (i + 1) + " 次請求成功,數據:" + response.body());

break;

} catch (IOException | InterruptedException e) {

if (i == MAX_RETRIES - 1) {

System.err.println("重試 " + MAX_RETRIES + " 次失敗:" + e.getMessage());

} else {

try {

System.out.println("請求失敗," + RETRY_INTERVAL + " 毫秒後重試...");

Thread.sleep(RETRY_INTERVAL);

} catch (InterruptedException ex) {

Thread.currentThread().interrupt();

}

}

}

}

}

}

採集後的數據如同 “散裝零件”,需藉助 Hadoop 分佈式文件系統(HDFS)與 Hive 數據倉庫進行整合。Hive 的外部表功能可輕鬆將 CSV、JSON 等格式數據結構化存儲,為後續分析奠定基礎。

2.2 數據處理與分析框架

Apache Spark 與 Flink 組成 Java 大數據的 “黃金搭檔”。Spark 的 MLlib 庫提供豐富算法,可構建複雜的學習效果評估模型。以下是使用邏輯迴歸預測學生考試通過概率的完整代碼,包含數據預處理與模型評估:

import org.apache.spark.ml.classification.LogisticRegression;

import org.apache.spark.ml.feature.VectorAssembler;

import org.apache.spark.ml.evaluation.BinaryClassificationEvaluator;

import org.apache.spark.sql.Dataset;

import org.apache.spark.sql.Row;

import org.apache.spark.sql.SparkSession;

import org.apache.spark.ml.linalg.Vector;

public class LearningPerformancePrediction {

public static void main(String[] args) {

SparkSession spark = SparkSession.builder()

.appName("LearningPerformancePrediction")

.master("local[*]")

.getOrCreate();

// 讀取學生數據,包含學習時長、作業正確率、考試成績等特徵

Dataset<Row> data = spark.read().csv("student_learning_data.csv")

.toDF("study_hours", "homework_accuracy", "previous_score", "pass_exam");

// 特徵工程:將數值特徵合併為向量

VectorAssembler assembler = new VectorAssembler()

.setInputCols(new String[]{"study_hours", "homework_accuracy", "previous_score"})

.setOutputCol("features");

Dataset<Row> assembledData = assembler.transform(data);

// 劃分訓練集與測試集

Dataset<Row>[] splits = assembledData.randomSplit(new double[]{0.7, 0.3});

Dataset<Row> trainingData = splits[0];

Dataset<Row> testData = splits[1];

// 構建邏輯迴歸模型

LogisticRegression lr = new LogisticRegression()

.setLabelCol("pass_exam")

.setFeaturesCol("features");

org.apache.spark.ml.classification.LogisticRegressionModel model = lr.fit(trainingData);

// 模型預測

Dataset<Row> predictions = model.transform(testData);

predictions.select("probability", "prediction", "pass_exam").show();

// 模型評估:計算AUC值

BinaryClassificationEvaluator evaluator = new BinaryClassificationEvaluator()

.setLabelCol("pass_exam")

.setRawPredictionCol("rawPrediction");

double auc = evaluator.evaluate(predictions);

System.out.println("模型AUC值:" + auc);

spark.stop();

}

}

Flink 則專注實時分析,通過 CEP(複雜事件處理)庫捕捉學生學習行為的異常模式。例如,當檢測到學生連續 3 次在作業提交截止前 10 分鐘內完成作業,且正確率低於 50% 時,系統自動推送學習提醒。

三、Java 大數據在智能教育中的創新應用

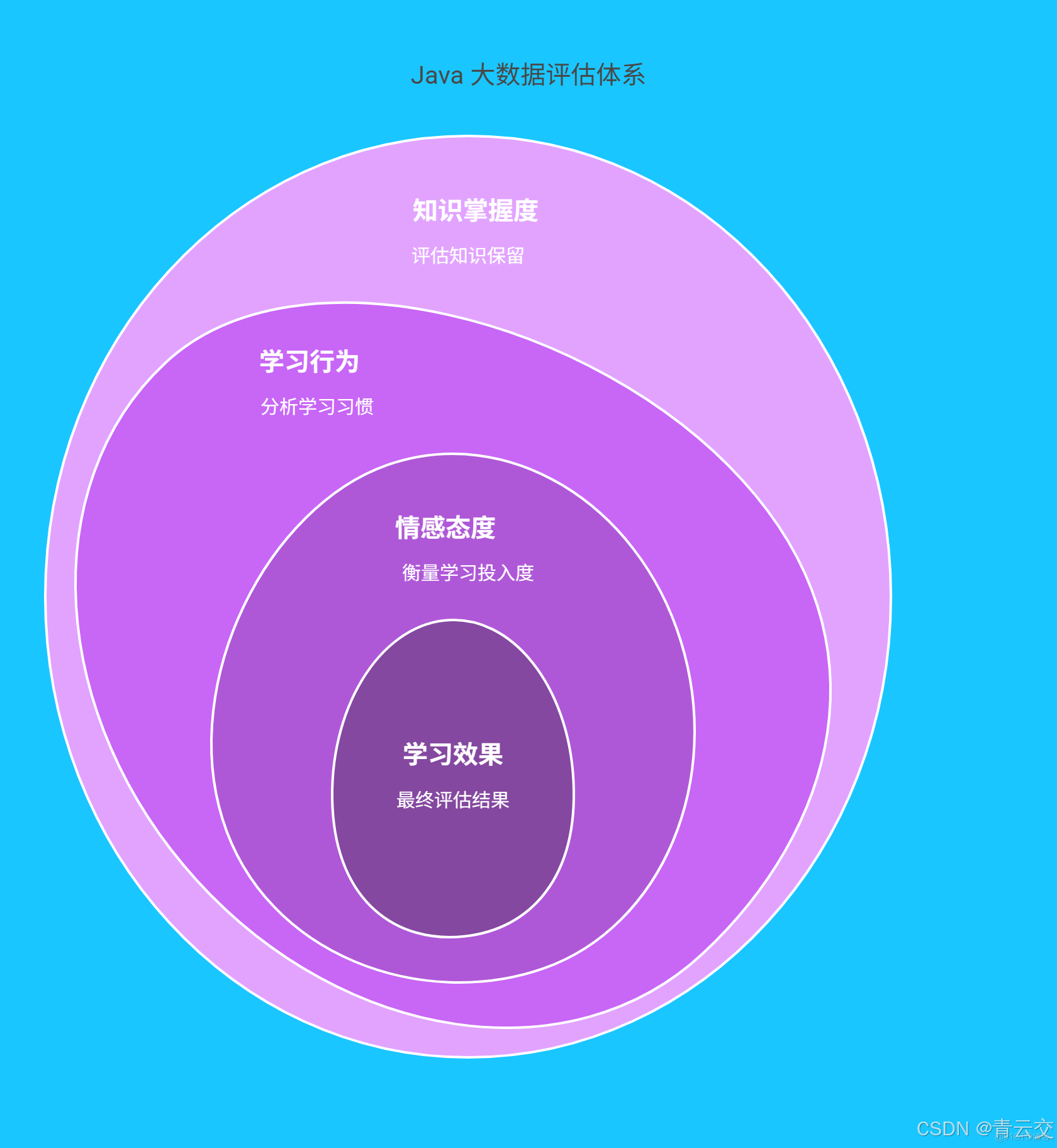

3.1 學習效果精準評估

Java 大數據打破 “唯分數論”,構建 三維評估體系:

- 知識掌握度:通過作業、考試數據量化知識點掌握情況;

- 學習行為:分析在線學習時長、視頻回放次數、筆記記錄量;

- 情感態度:藉助課堂互動頻率、討論區發言積極性評估學習投入度。 某在線教育平台應用該體系後,評估準確率從 72% 提升至 89% ,並能提前發現 20% 的學生存在學習倦怠風險。

3.2 個性化教學方案定製

基於聚類分析為學生 “畫像”,匹配專屬學習路徑。使用 K-Means 算法時,通過交叉驗證尋找最優聚類數,代碼如下:

import org.apache.spark.ml.clustering.KMeans;

import org.apache.spark.ml.evaluation.ClusteringEvaluator;

import org.apache.spark.ml.feature.VectorAssembler;

import org.apache.spark.sql.Dataset;

import org.apache.spark.sql.Row;

import org.apache.spark.sql.SparkSession;

import org.apache.spark.ml.linalg.Vector;

public class StudentClustering {

public static void main(String[] args) {

SparkSession spark = SparkSession.builder()

.appName("StudentClustering")

.master("local[*]")

.getOrCreate();

// 讀取學生數據,包含成績、學習時長、互動頻率等特徵

Dataset<Row> data = spark.read().csv("student_data.csv")

.toDF("score", "study_time", "interaction_frequency");

// 特徵工程

VectorAssembler assembler = new VectorAssembler()

.setInputCols(new String[]{"score", "study_time", "interaction_frequency"})

.setOutputCol("features");

Dataset<Row> assembledData = assembler.transform(data);

// 嘗試不同聚類數(K值)並評估

int[] ks = {2, 3, 4, 5};

ClusteringEvaluator evaluator = new ClusteringEvaluator();

for (int k : ks) {

KMeans kmeans = new KMeans()

.setK(k)

.setSeed(1L);

org.apache.spark.ml.clustering.KMeansModel model = kmeans.fit(assembledData);

Dataset<Row> predictions = model.transform(assembledData);

double silhouette = evaluator.evaluate(predictions);

System.out.println("K = " + k + " 時,輪廓係數:" + silhouette);

}

spark.stop();

}

}

根據聚類結果,系統為 “潛力型” 學生推送拓展挑戰題,為 “薄弱型” 學生定製基礎鞏固課程。某中學實踐後,班級平均分提升 12 分 ,後進生轉化率提高 35% 。

3.3 教學質量智能診斷

通過分析教師的課件使用時長、作業批改速度、課堂互動設計等 12 類數據指標 ,生成教學質量診斷報告。某高校教師使用該系統後,發現自己的課件中理論講解佔比過高,實踐案例不足,隨即調整教學策略,學生課程滿意度從 78% 躍升至 91% 。

3.4 前沿技術創新融合

- 生成式 AI 智能輔導:Java 調用 OpenAI API 實現實時答疑。當學生在平台提問 “如何理解牛頓第二定律”,系統自動生成圖文並茂的解答,並推薦相關實驗視頻:

import okhttp3.*;

import java.io.IOException;

public class ChatGPTIntegration {

// 替換為你的OpenAI API Key

private static final String API_KEY = "sk-csdn_qingyunjiao";

private static final MediaType JSON = MediaType.get("application/json; charset=utf-8");

private static final OkHttpClient client = new OkHttpClient();

public static String sendQuestion(String question) throws IOException {

RequestBody body = RequestBody.create(JSON, "{\"model\": \"gpt-3.5-turbo\", \"messages\": [{\"role\": \"user\", \"content\": \"" + question + "\"}]}");

Request request = new Request.Builder()

.url("https://api.openai.com/v1/chat/completions")

.addHeader("Authorization", "Bearer " + API_KEY)

.post(body)

.build();

try (Response response = client.newCall(request).execute()) {

return response.body().string();

}

}

}

- 聯邦學習保護隱私:多所學校聯合訓練學生行為預測模型時,採用 FATE 框架實現 “數據不動模型動”,確保學生隱私數據不出校。

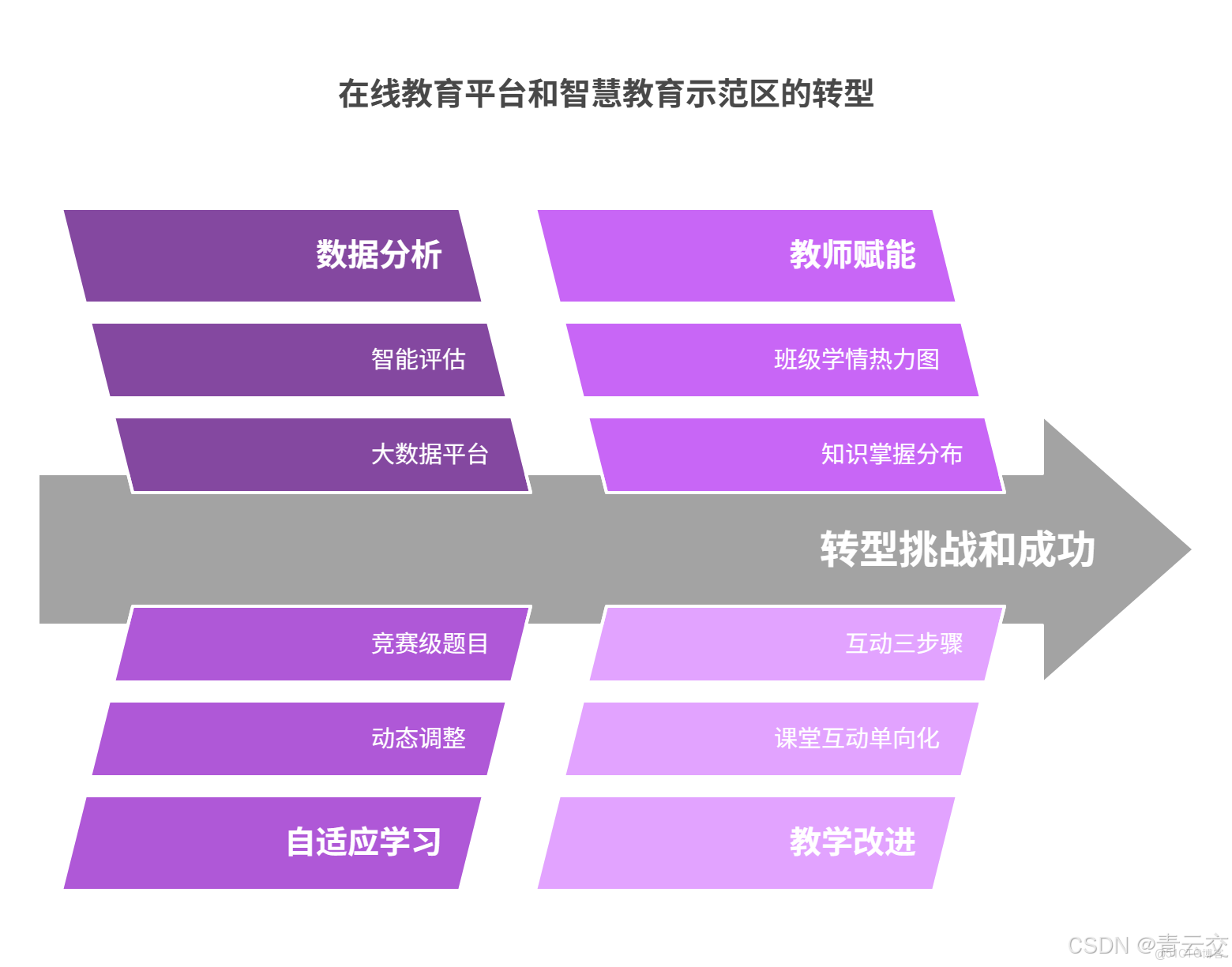

四、標杆案例深度剖析

4.1 案例一:某頭部在線教育平台的智能化轉型

該平台日均產生 50TB 學習數據,通過 Java 大數據平台實現:

- 智能評估:分析學生觀看教學視頻的暫停、快進、回放行為,精準定位知識薄弱點;

- 自適應學習:根據學生答題速度與正確率,動態調整題目難度,如某學生連續答對 3 道難題後,系統自動推送競賽級題目;

- 教師賦能:為教師提供班級學情熱力圖,直觀展示學生知識掌握分佈。轉型後,平台用户留存率提升 22% ,付費轉化率增長 18% 。

4.2 案例二:某市智慧教育示範區建設

全市 32 所中小學部署統一數據平台,採集課堂行為、考試成績、家校溝通等 15 類數據 。通過分析發現:

- 教學痛點:23% 的班級存在 “課堂互動單向化” 問題,教師提問後未給予學生充分思考時間;

- 改進方案:平台推送 “互動三步驟” 教學模板(提問→留白→追問),並提供優秀案例視頻;

- 實施效果:學生課堂參與度提升 40% ,區域中考平均分排名上升 5 位 。

五、技術架構全景呈現

請看如下智能教育技術架構圖:

結束語:

親愛的 Java 和 大數據愛好者,從重塑教育評估體系,到開啓個性化教學新範式,Java 大數據正在教育領域書寫傳奇。

親愛的 Java 和 大數據愛好者,你在智能教育實踐中遇到過哪些數據難題?對生成式 AI 與 Java 大數據的融合有哪些期待?歡迎在評論區分享您的寶貴經驗與見解。

為了讓後續內容更貼合大家的需求,誠邀各位參與投票,Java 大數據的下一站技術巔峯,由你定義!快來投出你的寶貴一票。