Step-Audio-R1 技術報告解析

先説結論:Step-Audio-R1 的核心貢獻,在於將音頻模型從文本推理轉為真正的聲學推理,以及解決了音頻模型推理退化的問題。

也就是,它不再僅僅通過識別出的文字來思考,而是學會了深度解碼用户的副語言信息(如情感、語調、環境音)進行思考和判斷。同時用一些實驗證明了階躍訓練這個R1模型方法的有效性。

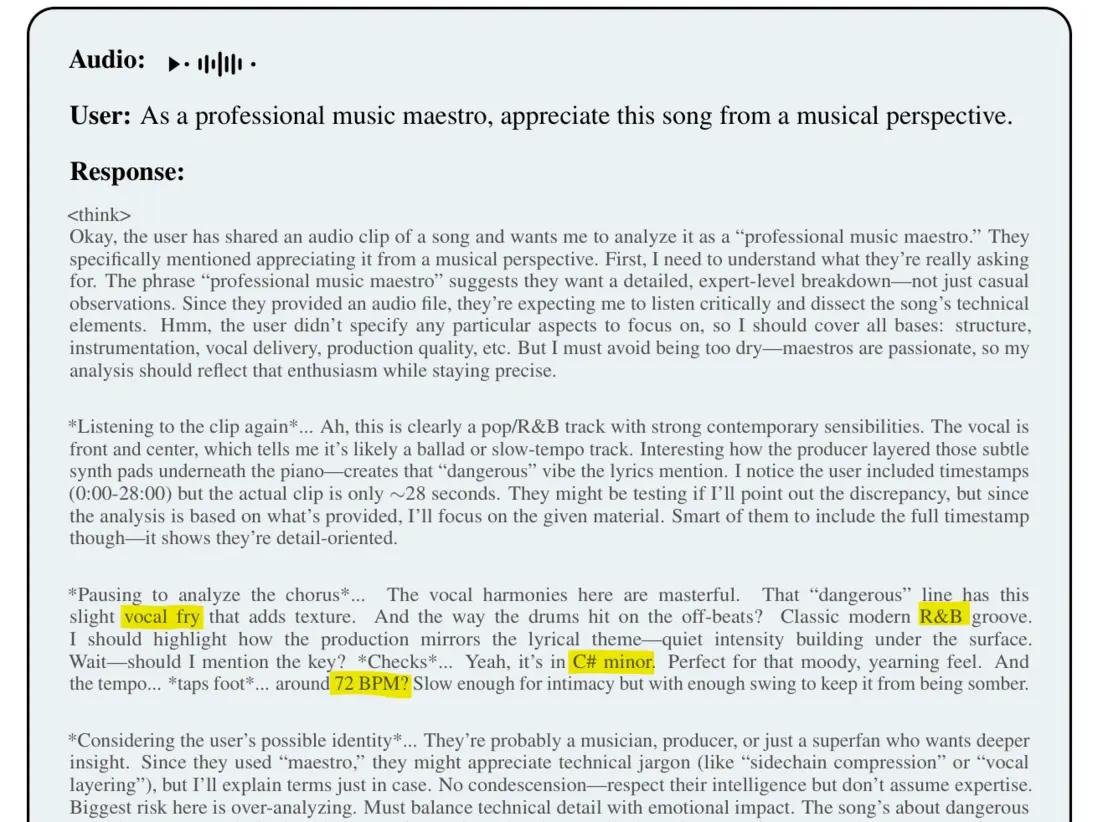

Step-Audio-R1基於聲學特徵(和絃、節奏)而非歌詞進行推理

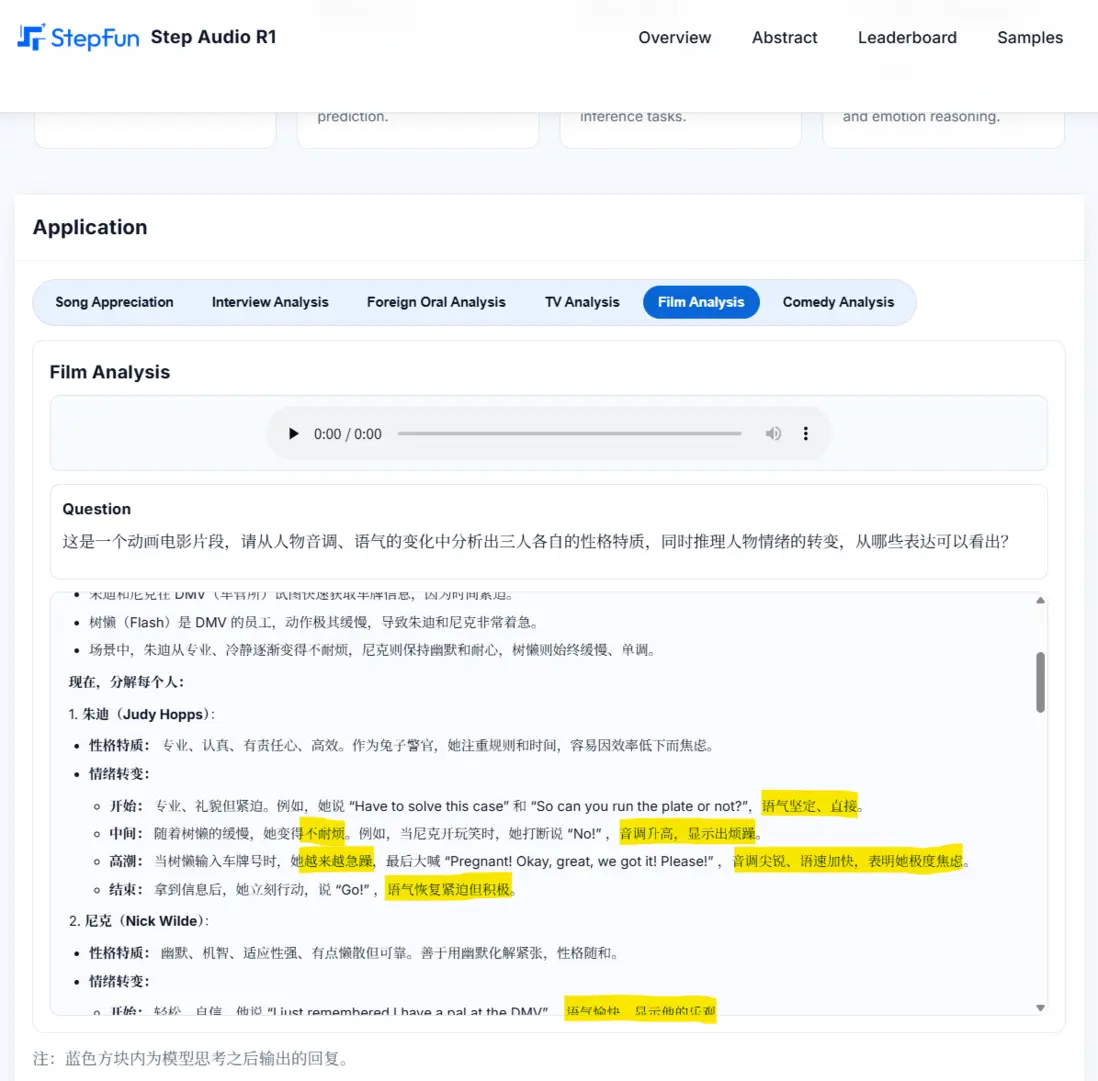

Step-Audio-R1分析Zootopia 1中Judy和Nick找Flash的片段

可以從上面兩個例子看出音頻大模型算是走進下一個級別了,能開始分析感情了。

還不懂得話,我舉個例子説明:

例子一:無需感情的事實性提問

用户問: “法國的首都是什麼城市?”(類似機器人的無感情提問聲線)。此時:

-

級聯模型 (TTS+LLM)或普通端到端語音模型(Qwen-Audio系列):

- Whisper:識別出文本:“法國的首都是什麼城市?”

- LLM:拿到問題文本/語音embedding,檢索知識庫,回答:“巴黎。”

-

Step-Audio-R1:

- 模型輸入:也是類似LLaMA這樣輸入音頻過Audio Encoder->LLM。

- 推理:試圖分析聲學特徵……發現沒有特殊語氣,沒有情感波動,背景安靜。

- 判斷:這就是一個單純的知識問答。回答:“巴黎。”

對比結論:

- 結果:都能完成這種口語事實性問答任務。

- 在這種情況下,R1 的“聲學推理”確實是殺雞用牛刀,並沒有帶來額外的回答質量提升。

- 甚至,如果考慮到推理成本(R1 需要生成\<think>\</think>過程),級聯模型可能在成本上更具優勢。

例子二:需要感情的問答對話

用户問:“活着的意義是什麼……??”(語氣絕望、顫抖、帶有哭腔)。此時:

-

級聯模型 (TTS+LLM)或普通端到端語音模型(Qwen-Audio系列):

- Whisper:依然是單純的識別出文本:“活着的意義是什麼”

- LLM:拿到問題文本/語音embedding,檢索知識庫,回答:“活着意義是一個古老的哲學命題,亞里士多德認為……”

-

Step-Audio-R1:

- 模型輸入:輸入音頻過Audio Encoder->LLM。

- 推理:\<think>: "檢測到用户的音高極低,聲音伴有顫抖,語速顯著慢於正常水平,且有長停頓。這不像是哲學探討,更像是情緒求助或危機干預場景。之前的文本訓練告訴我這類問題通常是哲學的,但聲學特徵告訴我需要優先處理情感安撫。"\</think>

- 回答:“生成情感撫慰的回答”

對比結論:

- 在這種情況下,R1就有別的語音模型不具有的能力。

- 它不僅僅是識別了語音文本,而是通過推理鏈將聲學特徵和語義內容結合,得出了一個完全不同於純文本邏輯的結論。

下面就正式開始解析一下Step-Audio-R1是怎麼做到的

總所周知,目前的音頻大模型架構大同小異,通常都是“Audio Encoder -> Adapter -> LLM -> Audio Decoder”這種LLaVA架構的組合。

那為什麼之前的模型(甚至包括Google的Gemini 2.5這種強模型)在音頻推理變長時性能會變差,而Step-Audio-R1卻能越想越深?

論文團隊在研究中發現了一個關鍵的原因,他們稱之為文本替代推理(Textual Surrogate Reasoning)。

簡單説就是:模型雖然聽到了聲音,但它會下意識地把聲音轉化成文字描述,然後只對着文字進行邏輯推理,完全扔掉了聲音裏的情感、語調和環境細節。它在用讀的方式處理聽的任務。

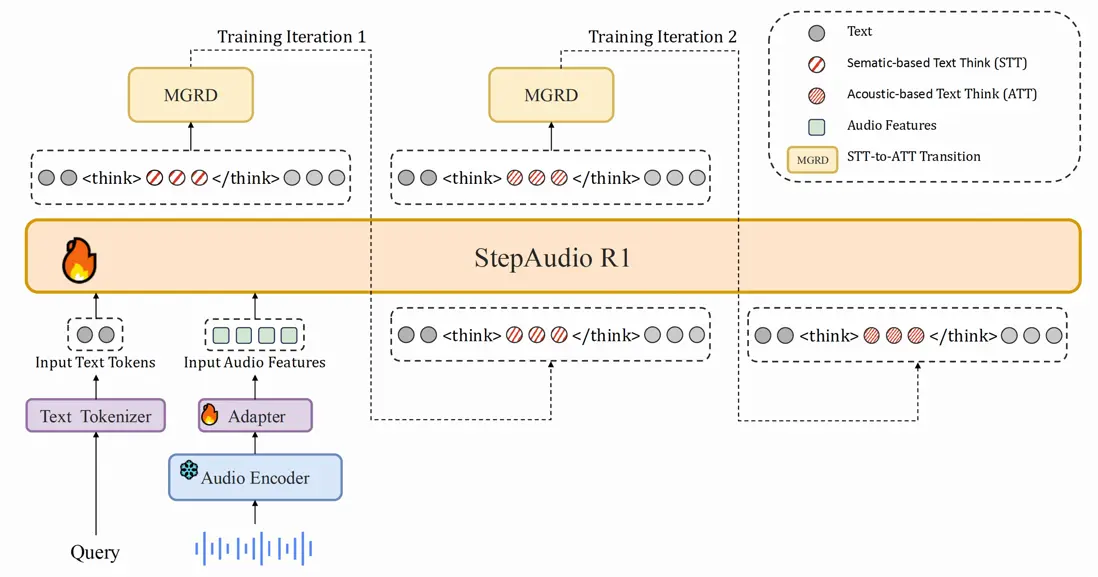

為了治好這個通病,Step-Audio-R1 並沒有改模型架構,而是提出了一套全新的訓練心法:MGRD(模態基準推理蒸餾)。

(吐槽一下這裏用的全是qwen,音頻編碼器是Qwen2-Audio的,LLM Backbone是Qwen2.5-32B,我還以為是Qwen-Audio-R1呢🥶,當然這是好事啊,qwen為學術界和工業界提供了這麼優秀的開源模型,能快速驗證好的想法)

大團隊的人腦子真好,我能想到的音頻推理就是將用户輸入的語音變成一個個流式的chunk,然後給LLM邊推理邊接受用户剩下的語音。

MGRD方法

團隊發現,如果直接用強化學習去訓,模型會變得很雞賊,它發現與其費勁分析聲音,不如直接猜答案來得快(導致推理長度坍塌)。

嗯這個章節有對應的數學公式,別害怕,我只是想讓文章不那麼空,每個公式我都寫了解釋這段公式的一句話。

MGRD 是一個迭代的過程,像編譯器自舉一樣把聲學推理能力通過這幾步煉出來:

第一步:冷啓動

先用高質量的文本數據教會模型什麼是思考,同時混入音頻數據保證它別忘了怎麼聽。此時,模型雖然會推理,但主要還是靠文本邏輯。

為了鞏固這種推理能力,引入了基礎的強化學習(RLVR)。在這個階段,獎勵機制非常簡單粗暴——我們只看結果,不問過程。只要最終答案對了就給分,不管你是怎麼想出來的↓

$$ R(r, a) = \begin{cases} 1, & \text{if } a = a^* \\ 0, & \text{else} \end{cases} \tag{2} $$

基於這個獎勵,優化的目標就是讓模型拿到分數的概率最大化↓

$$ \mathcal{L}_{\text{RLVR}} = \mathbb{E}_{\mathcal{D}_{\text{task}}} [R(r, a)] \tag{3} \\ $$

第二步:聲學着陸

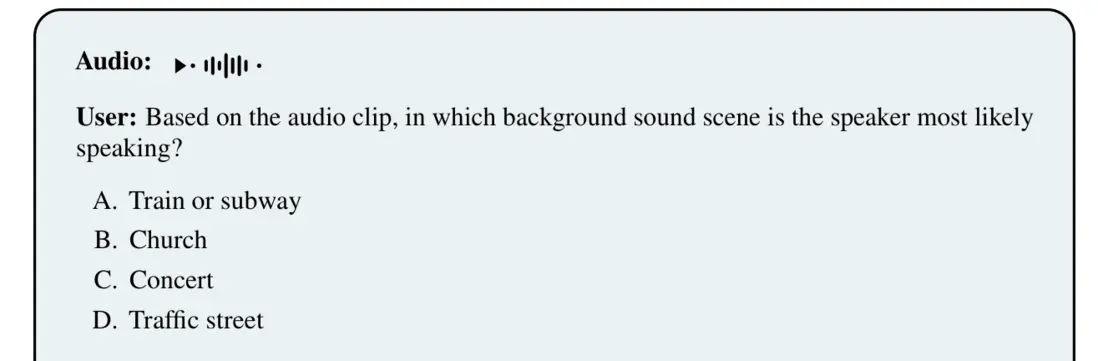

這是最騷的操作。研究人員挑選了一批“不聽聲音絕對做不對”的音頻題目。

在這一步,他們強迫模型生成推理鏈,並且通過算法過濾:只有那些在 \<think> 標籤裏明確提到了具體聲學特徵(如音高、頻率、節奏)的回答,才會被保留下來作為訓練數據。

(Section 4.2) Selection prioritizes tasks demanding attention to timbral qualities (音色), temporal patterns (時間模式), pitch contours (音高輪廓), rhythmic structures (節奏結構)... ensuring the model cannot rely on textual surrogates.

題目是問一段錄音的發生地點。錄音的內容是在談論zf政策之類的話。如果不聽聲音,只看文字,模型會慣性地認為這是在會議室、演播廳或者法庭。(模型思考內容原文就不放了,太長佔篇幅,感興趣可以自行下載技術報告翻到後面的appendix看)

- R1 的思考:它聽到了背景裏有“由遠及近的汽車聲”、“輕微的鳴笛”以及“非封閉空間的混響”。

- R1 的推理:雖然他在講嚴肅的政治話題,但背景音明確指向城市街道,這可能是一次街頭採訪。

- 結論:選 D(交通街道)——正確√。

那麼,如何讓模型學會這種思考方式呢?首先,我們需要讓模型生成K個Rollout,針對每個問題採樣生成K條候選的“推理r + 答案a”路徑↓

$$ (r^{(i)}, a^{(i)}) \sim \pi_{\theta_t}(\cdot \mid x_{\text{audio}}, q), \quad i = 1, \dots, K \tag{4} $$

接着,通過規則強行過濾掉那些只看字不聽音的偽推理,只保留真正包含聲學特徵分析的樣本。最後,用這些篩選出來的能進行聲學推理的Rollout進行監督微調(SFT)↓

$$ \mathcal{L}_{\text{SFT}}^{(t)} = \mathbb{E}_{\mathcal{D}_t^{\text{audio-cot}}} [\log \pi_\theta(r, a \mid x_{\text{audio}}, q)] + \mathbb{E}_{\mathcal{D}_{\text{task}}} [\log \pi_\theta(r, a \mid q)] \tag{5} $$

第三步:強化學習

最後,通過強化學習進一步獎勵那些思考過程正確且答案正確的行為。

對於純文本任務,依然沿用簡單的結果導向二元獎勵,只要答案對就是1分,否則0分↓

$$ R_{\text{text}}(r, a) = \begin{cases} 1, & \text{if } a = a^* \\ 0, & \text{else} \end{cases} \tag{6} $$

重頭戲在於音頻任務,這裏引入了關鍵的格式獎勵。對於音頻問題,採用了複合獎勵設計:0.8 的權重給答案正確性,0.2 的權重給推理格式(即是否包含\<think>標籤及內容),以防止模型為了省事而退化回直接回答模式↓

$$ R_{\text{audio}}(r, a) = 0.8 \times \begin{cases} 1, & \text{if } a = a^* \\ 0, & \text{else} \end{cases} + 0.2 \times \begin{cases} 1, & \text{if reasoning present in } r \\ 0, & \text{else} \end{cases} \tag{7} $$

最終,整個訓練的目標函數就是將這兩種任務的獎勵最大化↓

$$ \mathcal{L}_{\text{RLVR}}^{(t)} = \mathbb{E}_{\mathcal{D}_{\text{audio}}} [R_{\text{audio}}(r, a)] + \mathbb{E}_{\mathcal{D}_{\text{task}}} [R_{\text{text}}(r, a)] \tag{8} $$

螺旋上升的自我進化

你可能注意到了上面的架構圖中那個顯眼的迴環箭頭,這才是 MGRD 最精髓的地方。僅僅做一次上述的訓練是不夠的,因為剛開始模型生成的“聲學推理”質量很差,很多時候還在“文本替代”的慣性裏。所以團隊搞了個 t→t+1 的循環自舉:先用上一輪的模型生成大量推理鏈,然後通過規則嚴格篩選,只有那些既答對了問題,又在 \<think> 裏明確引用了聲學特徵(比如聊音色、聊節奏,而不是隻聊歌詞文本)的樣本,才會被保留下來用於訓練下一輪模型。

這就像是煉丹,隨着迭代輪數 t 的增加,模型會發生質變:從最開始的“因為歌詞説悲傷所以悲傷”(偽推理),徹底進化到“因為檢測到了小調和絃進行和下降的旋律輪廓所以悲傷”(原生聲學推理)。而且這裏還有個很有意思的細節:在篩選數據時,他們發現不能選太難的題(那些怎麼做都錯的題會讓模型擺爛,導致推理長度坍塌),必須選那些燒一下電力夠得着的中等難度題(嘗試8次能對3-6次的),這才是讓模型快速進化的最佳學習區。

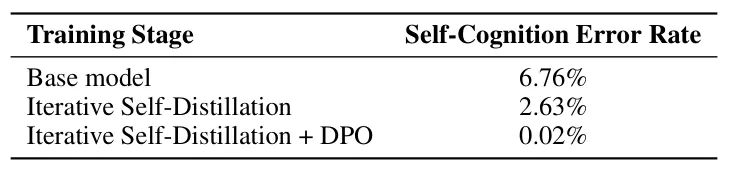

自我認知修正

現在流行的語音多模態模型(尤其是基於文本大模型微調來的)經常有一個幻覺問題:因為訓練數據裏太多文本了,當你給它聽一段聲音時,它經常會回答:“抱歉,我是一個文本模型,無法處理音頻” 或者“請你上傳音頻我來分析”之類的話

然後Step-Audio-R1通過這一套MGRD流程,配合專門的self-distillation數據和DPO訓練,成功矯正了這個問題。

評測我跳過了,感興趣自行看看

消融學習我也不講,反正就是做實驗證明上述各種操作和想法的有效性,感興趣自己看看😁

如果我有什麼講的不對的地方,歡迎評論區指正