公共資源速遞

5 個公共數據集:

- HelpSteer3 人類偏好數據集

- A-WetDri 惡劣天氣駕駛數據集

- NonverbalTTS 非語言音頻生成數據集

- STRIDE-QA-Mini 自動駕駛問答數據集

- MathCaptcha10k 算數驗證碼圖像數據集

5 個公共教程:

- dots.ocr:多語言文檔解析模型

- MiniCPM-V4.0:極致高效的端側大模型

- llama.cpp+Open-WebUI 部署 gpt-oss-20b

- llama.cpp+Open-WebUI 部署 gpt-oss-120b

- vLLM+Open-WebUl 部署 Phi-4-mini-flash-reasoning

訪問官網立即使用:openbayes.com

公共數據集

- HelpSteer3 人類偏好數據集

HelpSteer3 數據集包含 40,476 個偏好樣本,每個樣本包含領域、語言、上下文、2 個回覆、以及 2 個回覆之間的總體偏好評分和最多 3 位標註者的個人偏好評分,其包含了多語言數據(中文、韓文、法語、西班牙文、日本語、德語、俄語、葡萄牙語、意大利語、越南語、荷蘭語)。

- 在線使用:

https://go.openbayes.com/Icu7H

- A-WetDri 惡劣天氣駕駛數據集

A-WetDri 數據集包含了 42,390 個樣本,其中 19,344 個樣本為模擬數據、23,046 個樣本為現實世界數據,數據集涵蓋 4 種環境場景(雨、霧、夜晚、雪、晴朗天氣)、不同的物體類別(汽車、卡車汽車、自行車、摩托車、步行者、交通標誌交通燈)。

- 在線使用:

https://go.openbayes.com/NBBUi

數據集示例

- NonverbalTTS 非語言音頻生成數據集

NonverbalTTS 數據集包含 17 小時的高質量語音數據,數據源自 2,296 名參與者(60% 男性,40% 女性),涵蓋 10 種非語言語音類型(呼吸、笑聲、嘆息、打噴嚏、咳嗽、清嗓子、呻吟、咕噥、打鼾、吸氣)、8 種情緒類別(憤怒、厭惡、恐懼、快樂、中性、悲傷、驚訝、其他)。

- 在線使用:

https://go.openbayes.com/4vFLX

- STRIDE-QA-Mini 自動駕駛問答數據集

STRIDE-QA-Mini 數據集包含 103,220 個問答對及 5,539 張圖像樣本。數據源自東京收集的真實行車記錄儀鏡頭(城市、郊區、高速公路、各種天氣)。

- 在線使用:

https://go.openbayes.com/XbJzl

- MathCaptcha10k 算數驗證碼圖像數據集

MathCaptcha10K 數據集包含 10,000 個帶標籤樣本和 11,766 個未標註文件樣本,分辨率為 200×70 像素。每個帶標籤樣本包含算數驗證碼圖像,圖像中的精確字符及其整數答案。

- 在線使用:

https://go.openbayes.com/Pd2Gk

數據集示例

公共教程

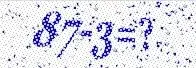

1.dots.ocr:多語言文檔解析模型

dots.ocr 基於 17 億參數的視覺語言模型(VLM),能統一進行佈局檢測和內容識別,保持良好的閲讀順序。模型規模雖小,但性能達到業界領先水平(SOTA),在 OmniDocBench 等基準測試中表現優異,公式識別效果能與 Doubao-1.5 和 gemini2.5-pro 等更大規模模型相媲美,在小語種解析方面優勢顯著。該模型提供了簡潔高效的架構,任務切換僅需更改輸入提示詞,推理速度快,適用多種文檔解析場景。

- 在線運行:

https://go.openbayes.com/V1zz3

項目示例

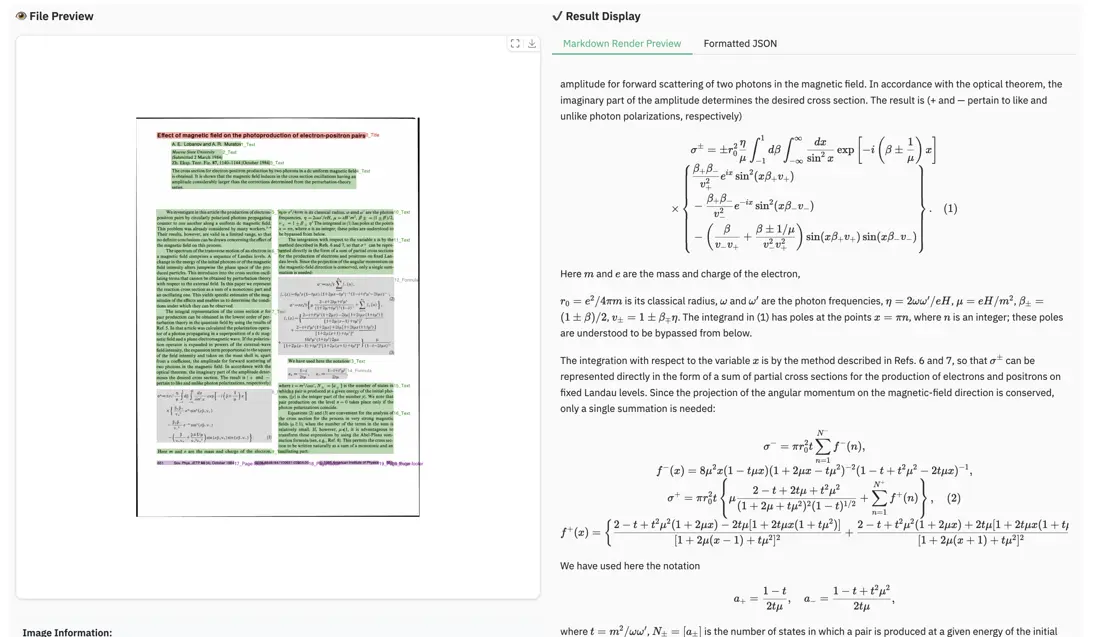

2. MiniCPM-V4.0:極致高效的端側大模型

MiniCPM-V4.0 基於 SigLIP2-400M 和 MiniCPM4-3B 構建,總參數量為 4.1B。它繼承了 MiniCPM-V2.6 強大的單圖、多圖和視頻理解性能,效率大幅提升。面壁智能還同步開源了適用於 iPhone 和 iPad 的 iOS 應用。MiniCPM-V4.0 在 OpenCompass 評測中圖像理解能力超越了 GPT-4.1-mini-20250414、Qwen2.5-VL-3B-Instruct 和 InternVL2.5-8B。

- 在線運行:

https://go.openbayes.com/uxBrY

項目示例

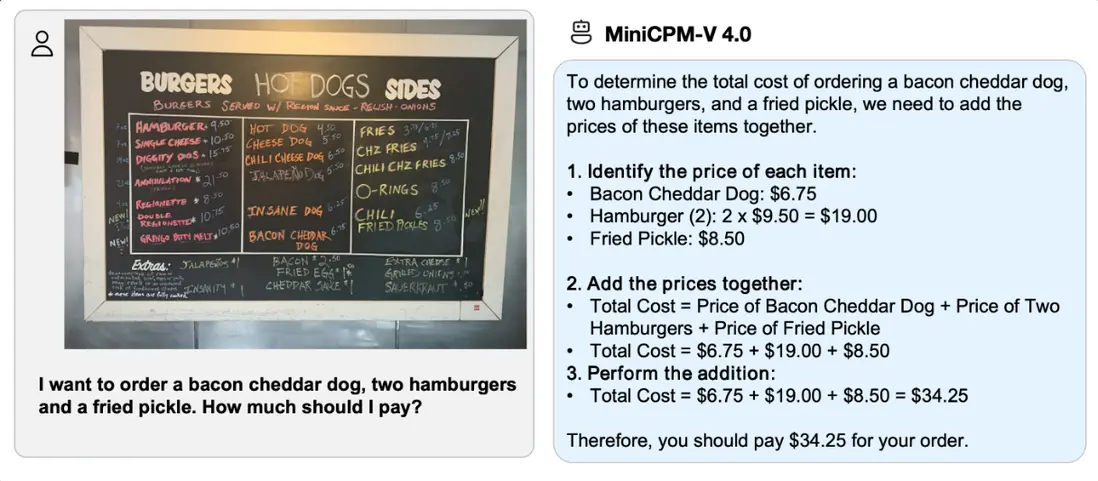

- llama.cpp+Open-WebUI 部署 gpt-oss-20b

gpt-oss-20b 參數約為 21B,運行時僅需 16GB 內存,在常見基準測試裏,其表現與 o3-mini 相當,這種輕量化設計使得它在邊緣設備上也能輕鬆部署,無論是在本地推理,還是在對基礎設施要求嚴苛的快速迭代場景中,都能發揮出色的效能。

- 在線運行:

https://go.openbayes.com/VqXzq

項目示例

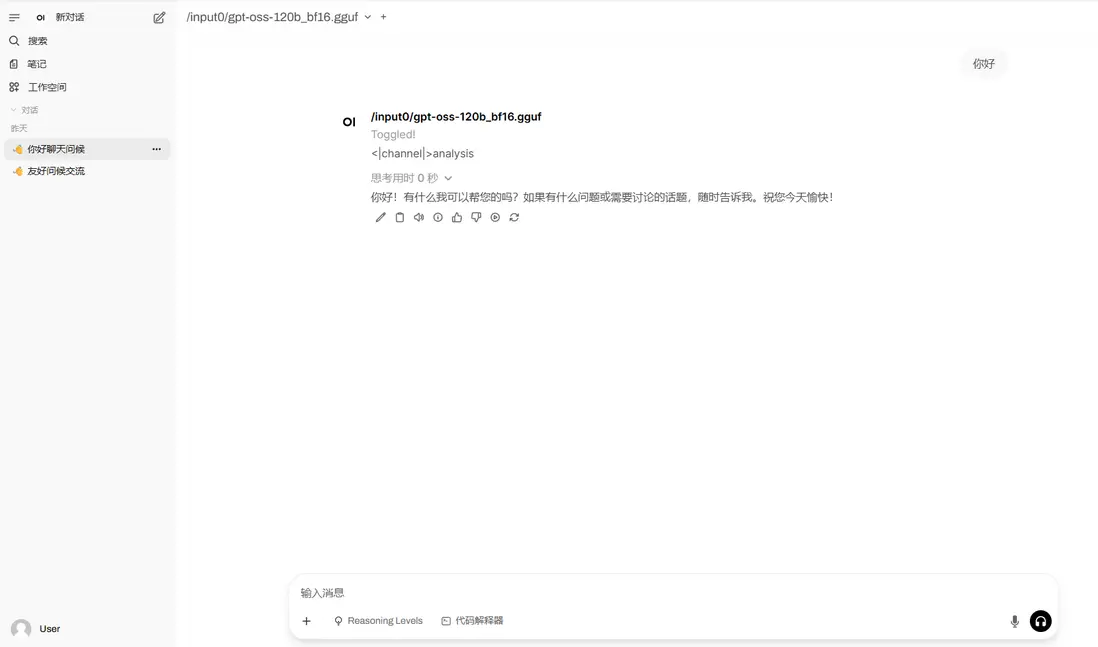

- llama.cpp+Open-WebUI 部署 gpt-oss-120b

gpt-oss-120b 擁有約 117B 參數,在核心推理基準測試中,其推理性能與 OpenAI 自家的 o4-mini 不相上下,且每個 token 僅啓用 51 億參數,便能在單個 80GB GPU 上實現高效運行,這一成果極大地優化了計算資源的利用效率。

- 在線運行:

https://go.openbayes.com/A3lCf

項目示例

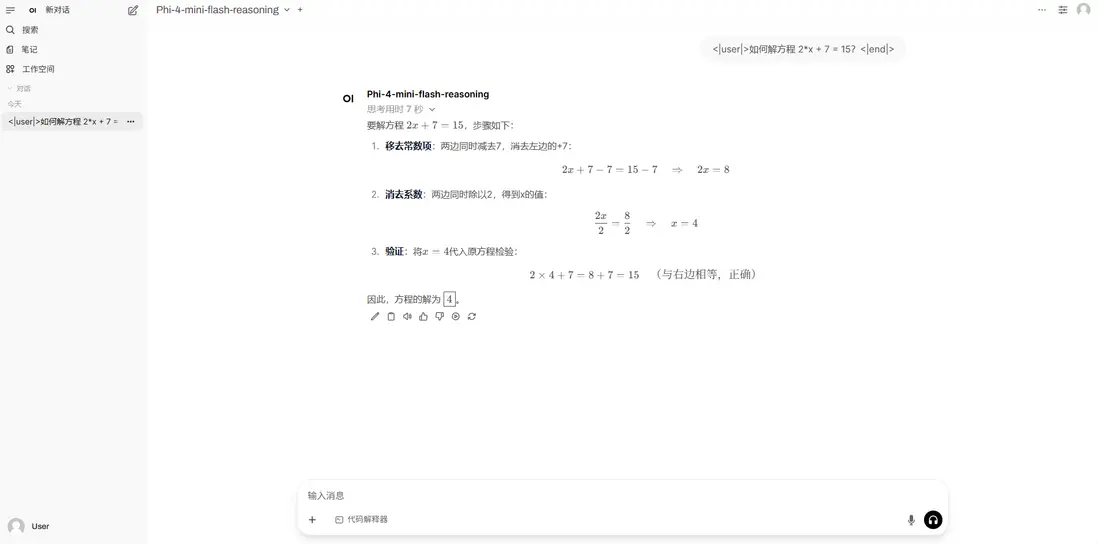

5. vLLM+Open WebUl 部署 Phi-4-mini-flash-reasoning

Phi-4-mini-flash-reasoning 基於合成數據構建,專注於高質量、密集推理數據,並進一步微調以獲得更高級的數學推理能力。該模型屬於 Phi-4 模型系列,支持 64K token 上下文長度,採用解碼器-混合-解碼器架構,結合注意力機制和狀態空間模型(SSM),在推理效率方面表現出色。

- 在線運行:

https://go.openbayes.com/kURAu

項目示例