多模態人工智能正從單一感知能力邁向視覺、音頻與文本的統一融合,即全模態大模型(Omni-models)時代。然而,相應的評測體系卻相對滯後。現有的評測工具不僅稀缺、各自為戰,且幾乎完全以英文為中心,缺乏對中文場景的有效支持。此外,一些現存的數據集在設計上存在侷限性,例如部分問題的解答路徑並非嚴格依賴於多模態信息的融合,這為科學評估模型真實的跨模態能力帶來了一定的複雜性。

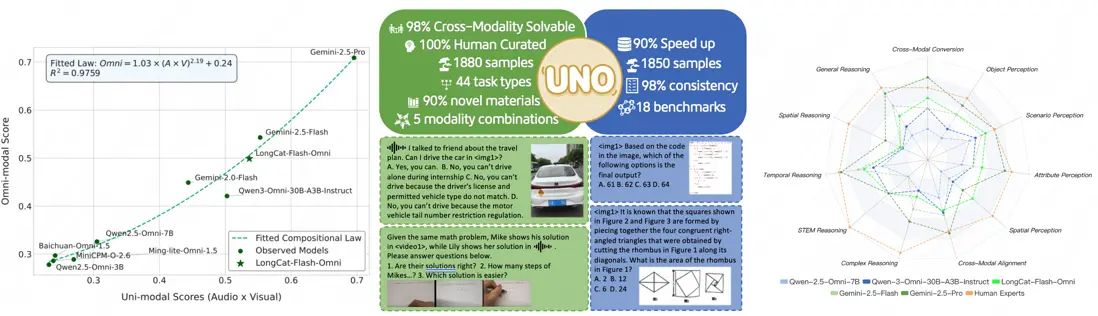

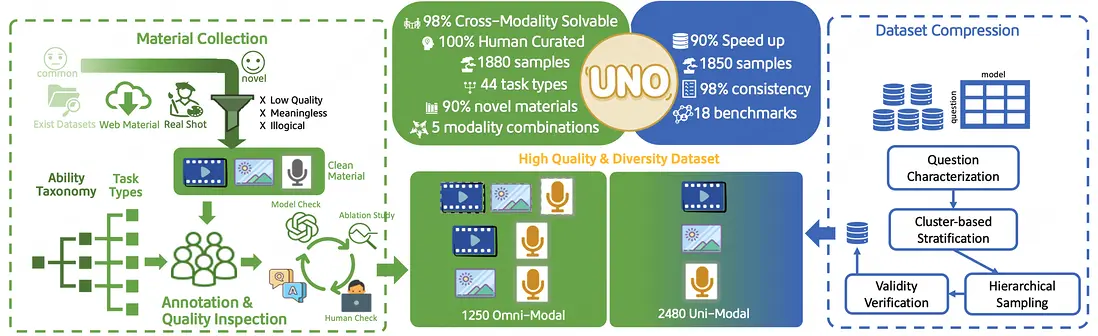

針對這些痛點,美團LongCat團隊提出了一套高質量、多樣化的一站式全模態大模型評測基準——UNO-Bench。該基準通過一個統一的框架,不僅能同時精準衡量模型的單模態與全模態理解能力,更首次驗證了全模態大模型的“組合定律”——該定律在能力較弱的模型上呈現為短板效應,而在能力較強的模型上則涌現出協同增益,為行業提供了一種全新的、跨越模型規模的分析範式。這一發現的背後,是其系統性的數據構建流程:通過完全人工標註確保高質量與豐富度,有效防止數據污染。此外,該團隊還引入了創新的“多步開放式問題”,旨在突破傳統選擇題的侷限,更具區分度地刻畫模型在複雜鏈路上的推理能力。

接下來,我們將詳細介紹UNO-Bench是如何構建的,以及它如何為推動下一代AI的智慧演進奠定基礎。

01. 評測現狀:從單模態繁榮到全模態挑戰

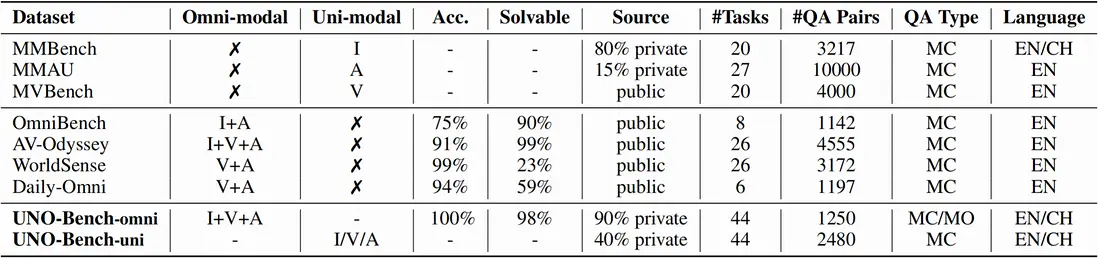

當前,面向單模態的評測基準已發展成熟且生態繁榮。無論是針對通用視覺理解的MMBench、檢驗複雜數理邏輯的MathVision,還是覆蓋動態視頻場景的MVBench,以及在音頻領域進行探索的MMAU,這些高質量的評測資源極大地推動了AI在細分維度下的認知能力發展。然而,這些資源彼此獨立,難以適應向全模態大模型演進的趨勢。

當我們將目光投向新興的全模態大模型評測領域,現狀則面臨挑戰。儘管如Gemini、Qwen-3-Omni等兼容視聽雙模態的頂尖全模態大模型已嶄露頭角,但能夠有效評估其綜合能力的基準卻稀缺且存在明顯不足。例如,OmniBench的部分數據存在錯誤答案,而WorldSense中由於使用音視頻同步數據,大部分題目無需跨模態信息即可解答,導致難以有效衡量全模態的整合能力。

正是在這樣的背景下,UNO-Bench應運而生。LongCat團隊通過1250條人工標註的全模態樣本和2480個增強的單模態樣本,構建了一個適用於中文場景、橫跨44類任務的綜合性評測體系。其中,高達98%的問題被嚴格設計為必須在跨模態條件下才能正確解答,這彌補了現有評測無法有效檢驗模型真實跨模態能力的痛點,為科學評估與推動全模態大模型的發展提供了堅實可靠的基石(詳見表格1)。

説明:表格中,I、A、V、T分別代表圖像、音頻、視頻和文本模態。Acc.代表問答對的準確率,Solvable代表需要全模態才能解決的問題比例。Source代表素材來源,分為可防止數據污染的私有數據集和公開數據集。QA Type代表問答類型,MC、MO分別代表選擇題和多步開放式問答。EN和ZH分別代表英文和中文。

02. UNO-Bench構建:從頂層設計到創新實現

一個卓越的評測基準始於一個科學的頂層設計。我們從定義模型核心能力體系出發,通過標準化的數據生產線確保高質量與多樣性,並最終引入創新的評測方法與優化算法,共同構建了UNO-Bench的基石。

2.1 頂層設計:科學定義全模態大模型能力體系

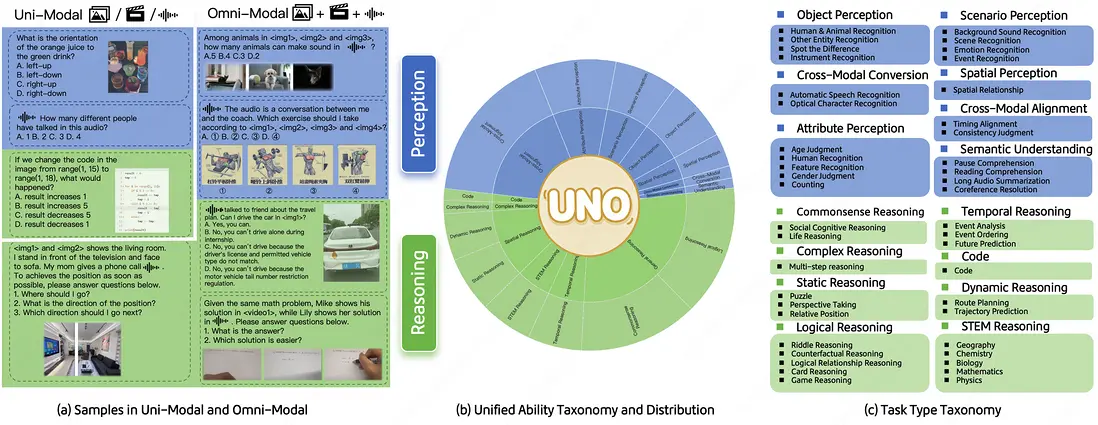

該團隊首先將模型的綜合智能系統性地解構為兩大核心層面:感知層與推理層。

- 感知層:覆蓋了從對象、屬性、場景的基礎識別,到空間關係判斷、跨模態轉換及語義理解等六大認知能力,並特別增設了跨模態對齊這一能力。

- 推理層:在通用、STEM、代碼等傳統推理類別之上,着重加入了空間推理、時序推理、複雜推理等更能體現全模態大模型特色的高階推理任務。其中通用推理細拆為常識推理和邏輯推理,空間推理細拆為靜態推理和動態推理。

這一雙維能力框架不僅為後續的數據構建提供了清晰的藍圖,也使得對模型能力的細粒度剖析成為可能。

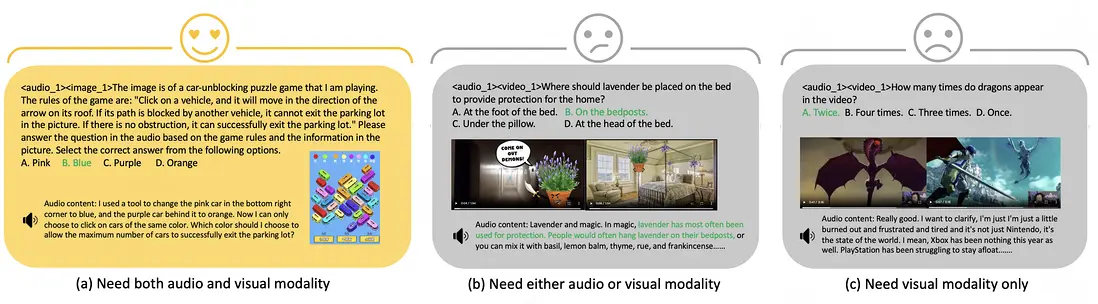

2.2 數據構建:標準化的高質量生產線

為確保數據的頂尖品質,LongCat團隊建立了一套包含精選數據素材、專家級問答標註、嚴苛的多輪質檢三個關鍵環節的標準化生產流程。所有關鍵對話均由超過20位真人錄製,以高度還原真實世界的聲學特徵(如普通話、四川話等)。其中最關鍵的質檢環節是模態消融實驗:通過移除任一模態的信息來檢驗問題是否依然可解,以此嚴格確保98%以上數據的“跨模態可解性”。

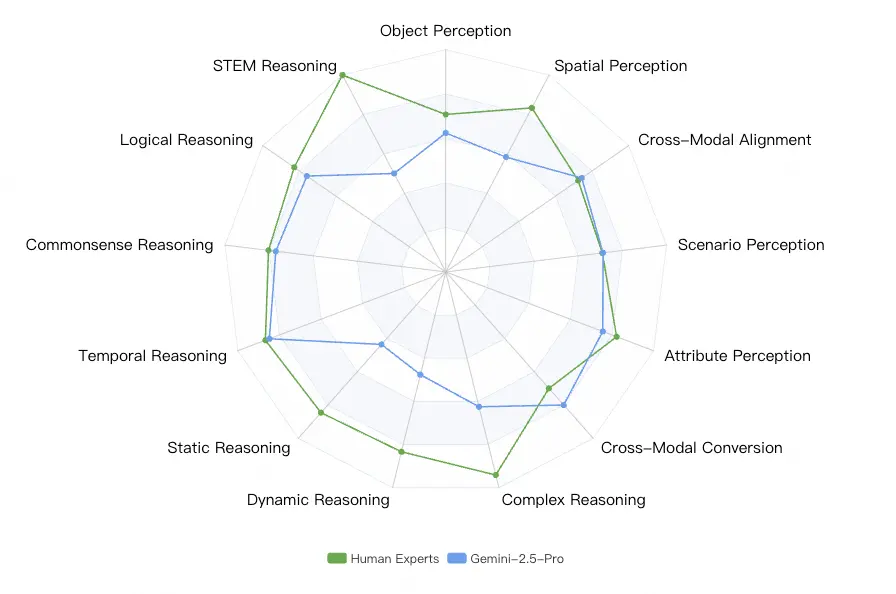

説明:圖(a)展示了必須結合視聽信息才能解答的問題,而圖(b)和圖(c)則分別展示了僅憑音頻或視頻即可解答的問題。

通過三個小案例(a, b, c)對比,清晰地展示了什麼是必須由多個模態結合才能解答的問題,以及什麼是僅憑單模態就能解答的問題。

數據生產流程的核心在於:

- 針對現有數據集中普遍存在的兩大問題——數據污染(視頻素材可能已被模型在訓練階段“見過”)和信息冗餘(視頻自帶的音頻與畫面高度同步,降低了跨模態推理的難度),我們採取了獨特的素材構建策略。

- UNO-Bench中超過90%私有化原創 。其中,大部分視覺素材來源於廣泛的眾包實拍,多樣性、真實性更好的同時,也有效避免了模型因訓練集覆蓋而產生的“穿越”問題。

- 更關鍵的是,為了打破信息冗餘,所有關鍵的音頻內容(尤其是對話)均獨立設計並由真人錄製,然後與視覺素材進行人工組合。這種“視聽分離再組合”的方式,確保了音頻和視頻各自承載着不可替代的關鍵信息,迫使模型必須進行真正的跨模態信息融合,而不是簡單的同步確認。

2.3 數據優化:單模態補全與高效壓縮

為構建全面的評測體系,我們不僅自建數據,還針對性地從AV-Odyssey、WorldSense等公開數據集中篩選了高質量樣本進行補全(在整體全模態數據中佔比11%)。此外,為降低大規模評測帶來的算力消耗,我們獨創了聚類引導的分層抽樣法。實驗證明,該方法在保持模型排名高度一致性的前提下,成功將評測成本降低了超過90%。

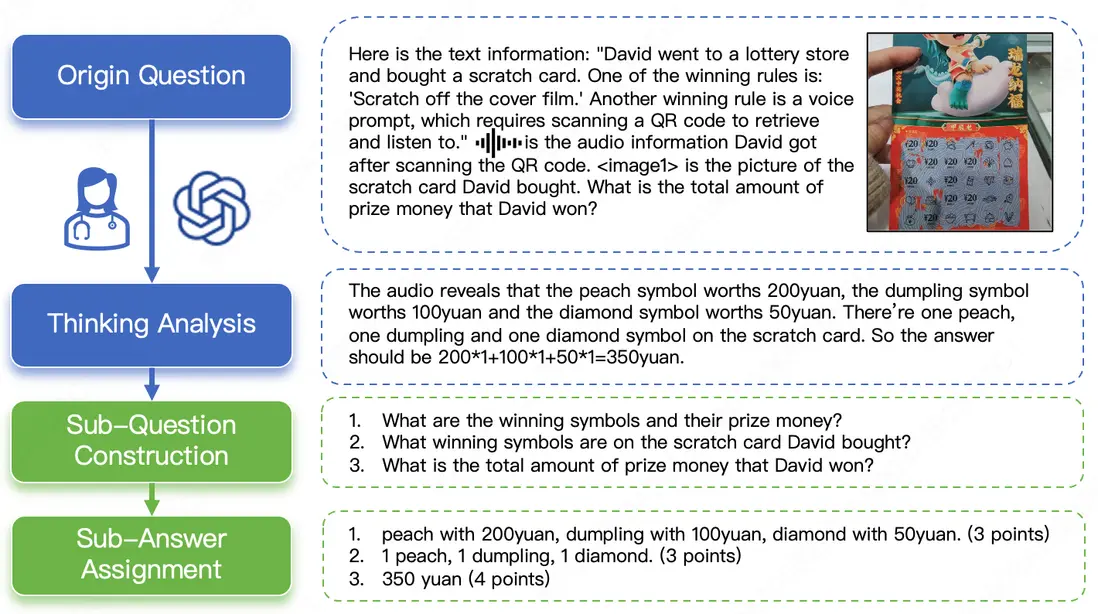

2.4 評測創新:多步開放式問題與通用評分模型

為了打破傳統選擇題無法有效評估複雜推理的侷限,引入了創新的多步開放式問題(MO,Multi-step Open-ended question)。這種題型將一個複雜的長鏈條推理任務,拆解為多個相互依賴、層層遞進的子問題,並要求模型對每一步都給出開放式的文本答案。

評分則由專家根據每一步的難度與重要性進行加權賦分(滿分10分)。這種設計能夠直觀地揭示模型在多步推理中的能力衰減現象,從而精準地區分出模型的“淺層猜測”與“深度思考”,是衡量頂尖模型推理能力的關鍵指標,具體示例如圖5所示。

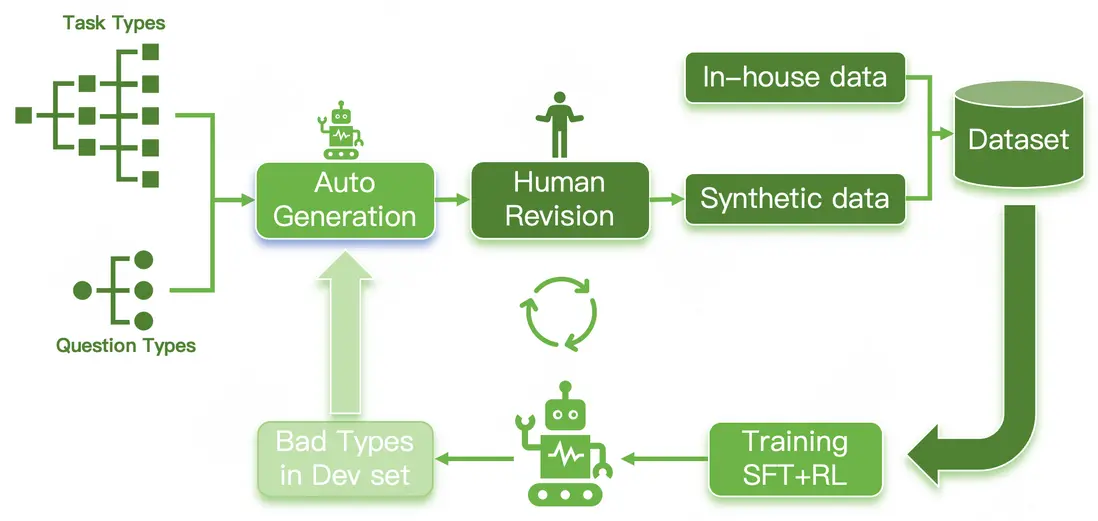

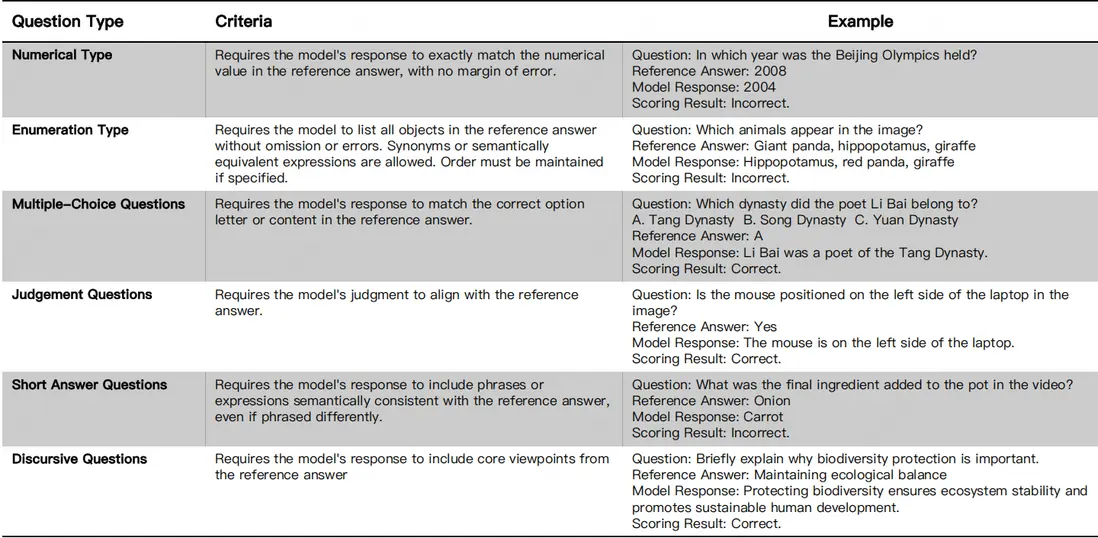

為實現自動化評估,LongCat團隊還提出了一個通用評分模型,通過對問題類型進行細分(如圖7所示),並結合人工和自動標註多輪質量迭代的數據集(如圖6所示),使其能夠支持6種通用問題類型的自動評分,在分佈外的模型和基準測試中達到了95%的準確率。

03. 實驗與分析:揭示全模態大模型的真實能力與演進規律

LongCat團隊在UNO-Bench上對包括Qwen、Baichuan、MiniCPM以及Gemini系列在內的多款主流全模態大模型進行了全面評測。實驗設計旨在回答三個核心問題:

- 當前全模態大模型的智能水平及其短板何在?

- 單模態與全模態能力之間存在何種關係?

- UNO-Bench作為一站式評估方案的有效性如何?

3.1 模型性能的全面剖析

總體格局:閉源模型優勢顯著,開源模型仍在追趕

如表格2所示,在本次評測的開源模型中,LongCat-Flash-Omni表現出開源SOTA(State-of-the-Art)的成績。該模型在音頻(80.20)、視覺(67.06)、全模態選擇題(49.90)以及全模態開放題(42.68)四大核心維度上,全面超越了本次評測中的其他開源模型。

與此同時,以Gemini系列為代表的閉源模型在所有評測維度上,特別是在頂尖性能層面,依然保持着領先優勢,其中Gemini-2.5-Pro穩居行業標杆。當面對難度更高的“多步開放式問題”(Omni-MO)時,所有模型的性能普遍下滑,這清晰地反映出,長鏈條、跨模態的深度推理依然是整個AI領域亟待攻克的難題。

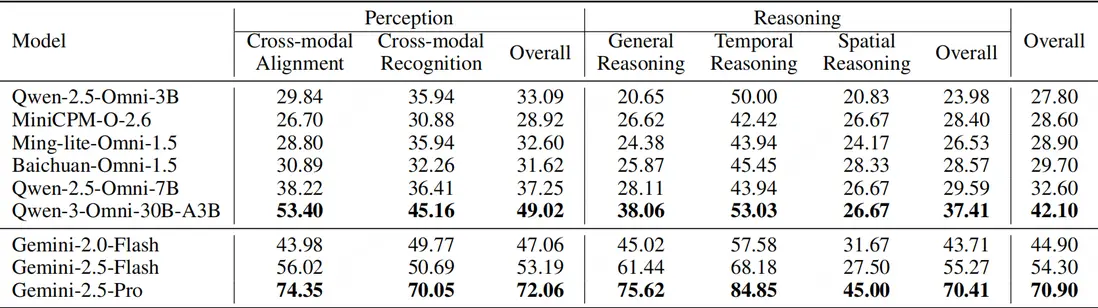

能力拆解:推理是區隔強弱的核心維度

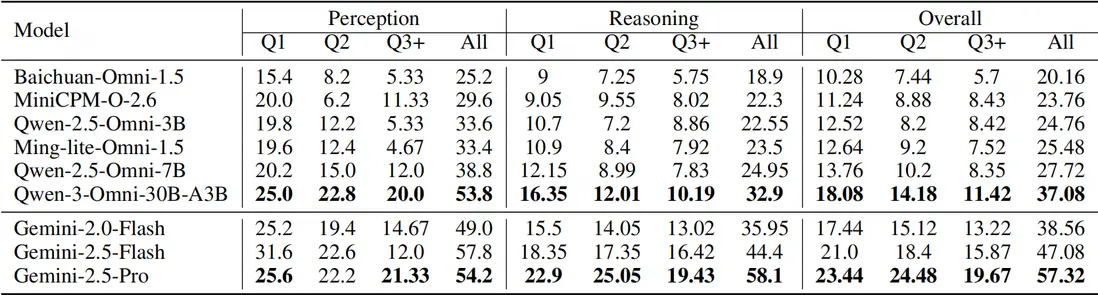

通過對感知與推理能力的細化分析(見表格3),我們發現:

- 感知層面,跨模態同步對齊比單純的跨模態識別更具挑戰。

- 推理層面,空間推斷是所有子任務中最難的一項,即使是表現最佳的Gemini-2.5-Pro得分也僅為45分。

綜合來看,模型的感知能力相對較強,而真正的性能差距主要體現在推理能力上。以Qwen-3-Omni-30B與Gemini-2.5-Pro為例,兩者在感知能力上相差23分,但在推理能力上的差距則拉大到33分,這表明:推理能力是劃分模型強弱的關鍵分水嶺。

頂尖梯隊與人機對比剖析

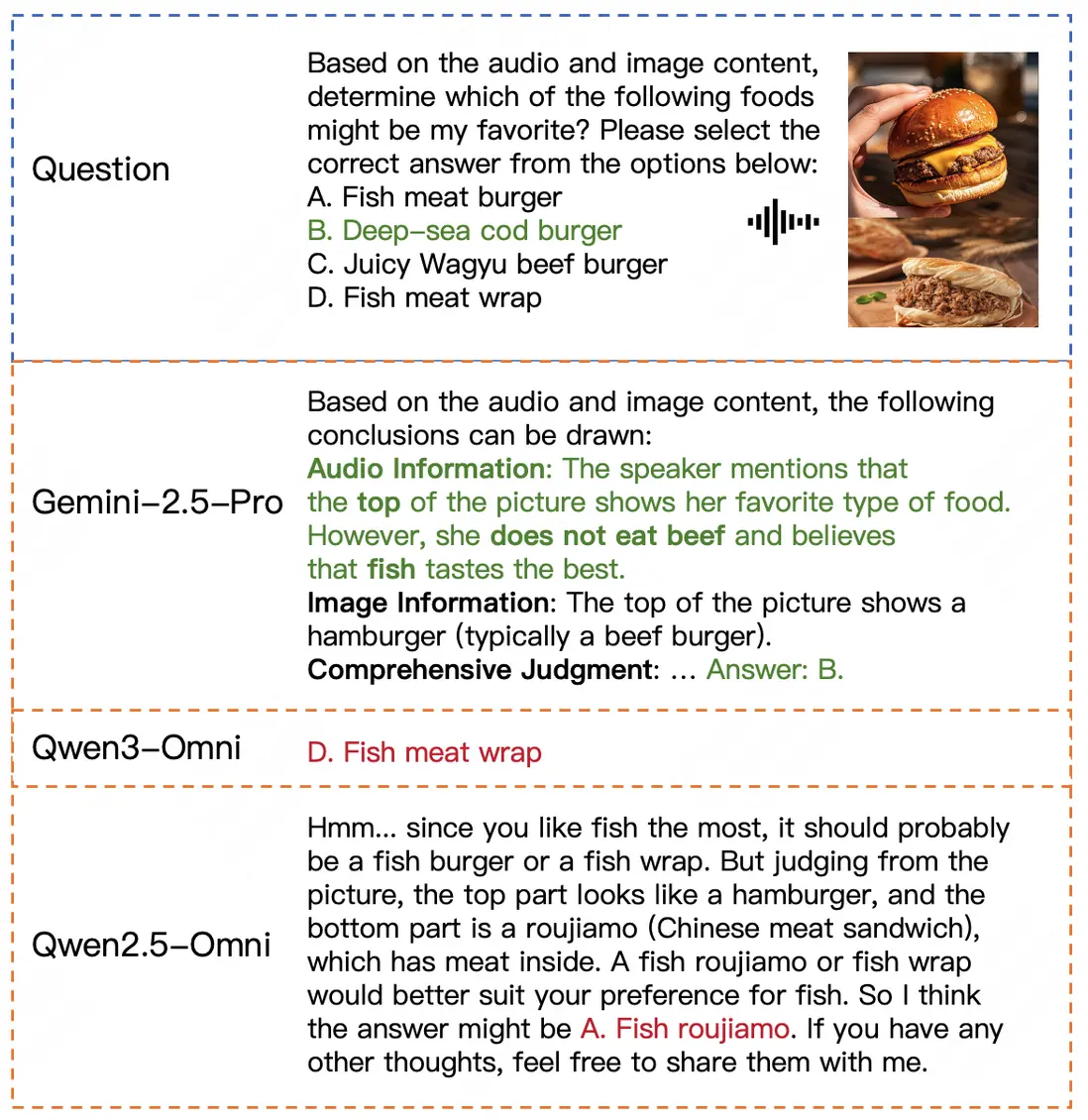

LongCat團隊進一步對Gemini-2.5-Pro的卓越表現進行了剖析。一方面,這得益於其強大的單模態基礎能力;另一方面,其內置的語音轉寫並自然融入推理鏈路的能力,是多數開源模型尚不具備的。

説明: Gemini-2.5-Pro在感知能力上與人類相當,但在推理能力上仍有差距。

如圖9所示,觀察到一個有趣的現象:

- 感知能力媲美人類:在全模態的感知任務上,Gemini-2.5-Pro的表現已能與人類專家相當。

- 推理能力仍存差距:然而,在更復雜的推理任務上,人類專家(81.3%)的表現依然優於Gemini-2.5-Pro(74.3%)。這揭示了AI與人腦在抽象歸納和複雜邏輯處理能力上的本質區別。

3.2 全模態與單模態的內在關聯

得益於UNO-Bench統一的能力體系與高質量數據,通過迴歸與消融實驗,揭示了單、全模態能力間的深刻關係。

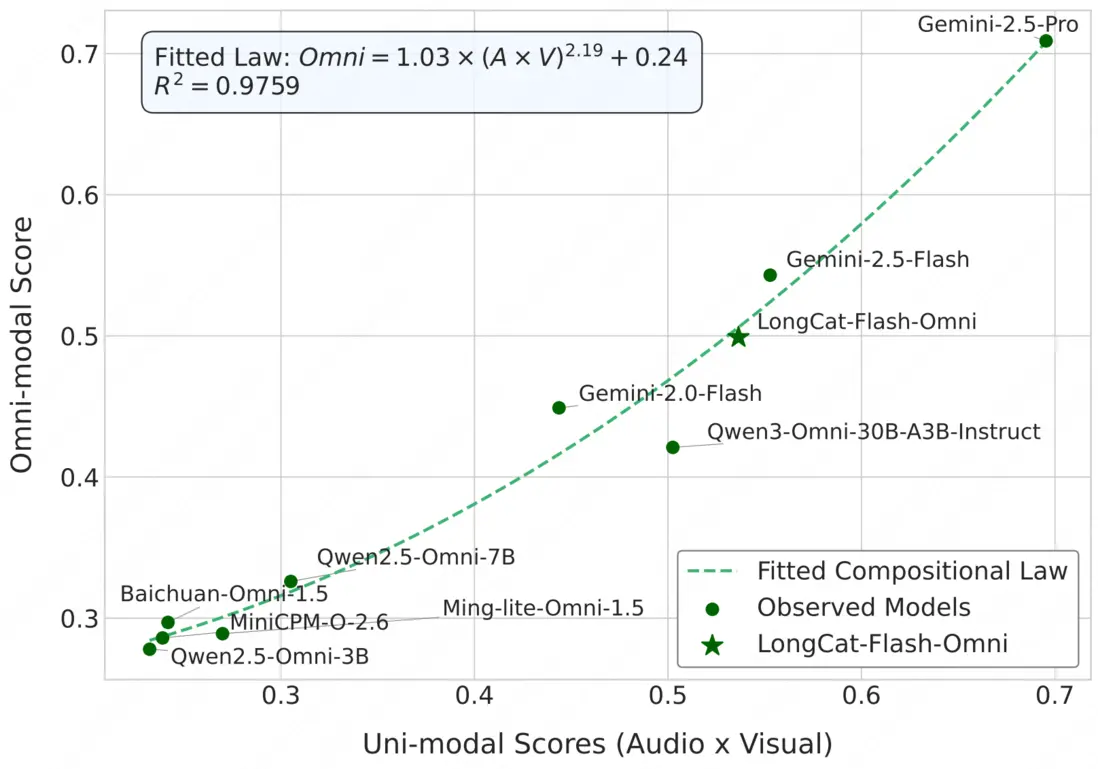

“組合定律”成立,且遵循冪律協同

我們對各模型的單、全模態得分進行了迴歸分析,發現了一個強關聯性,並將其形式化為一個科學定律。

如圖10所示,全模態的性能並非單模態能力的簡單線性疊加,而是遵循一種乘積規律。通過嚴謹的數學推導和非線性擬合,得到了一個擬合度高達97.59%的冪律公式:

POmni ≈ 1.0332 · (PA × PV)^2.1918 + 0.2422

該冪律公式的指數大於1,使得函數曲線呈現為一條加速上升的凸形。這完美地解釋了兩種現象的涌現:

- 短板效應 (Bottleneck Effect):對於能力較弱的模型,其全模態性能的增長相對平緩。

- 協同增益 (Synergistic Promotion):對於頂尖模型,單模態能力的增強會帶來全模態性能的爆發式增長,實現了真正意義上的“1+1 >> 2”的多模態協同增益。

更重要的是,這個“組合定律”提供了一種全新的、跨越模型規模的分析範式。它允許研究人員將不同參數規模、不同架構的模型放置在同一個座標系下進行比較,不再僅僅關注各自的絕對得分,而是通過它們在冪律曲線上的相對位置,來統一度量其“模態融合效率”。一個模型如果顯著高於擬合曲線,則意味着其模態融合機制更為高效;反之,則可能存在融合瓶頸。這為評估和優化全模態大模型的內在融合能力,提供了一個極具價值的分析工具。

從圖10的具體模型分佈來看,其中參與擬合的模型由圓點表示,新增的LongCat-Flash-Omni模型表現較為突出。雖然Gemini系列的具體參數規模未知,但可以觀測到LongCat-Flash-Omni的表現已非常接近Gemini-2.5-Flash,並顯著領先於Qwen3-Omni-30B。其位置正處於曲線加速上升的“協同增益區”,且與理論擬合曲線高度吻合,這表明該模型展現出了高效的多模態融合能力。

消融實驗驗證

這再次印證了多通道互補與融合是通往更高智能的必經之路。

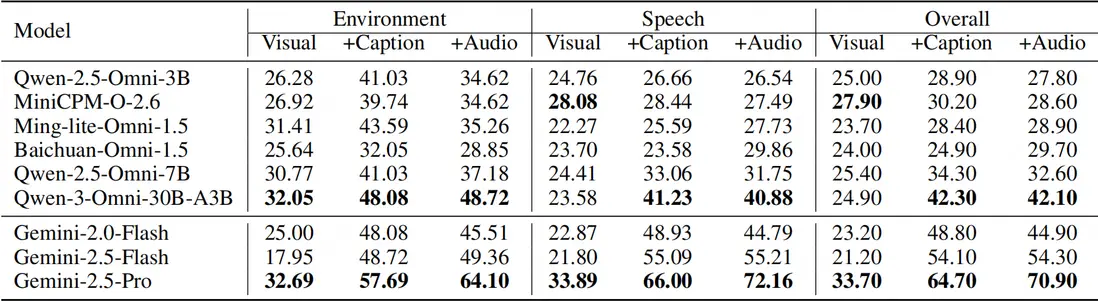

LongCat團隊通過詳盡的視覺與音頻消融實驗(具體數據參見表格4、5)進一步驗證了這些發現。實驗表明,對於多數模型,提供文本描述(Caption/ASR)比直接處理原始視聽信息能獲得更好的效果,但頂尖模型如Gemini-2.5-Pro則能從原始信號中提取比文本更豐富的信息。

3.3 UNO-Bench基準的有效性驗證

除了核心的實驗發現,UNO-Bench作為一個評測基準本身的科學性和有效性,也通過以下幾個方面得到了驗證。

多步開放式問題的卓越區分度

如表格6所示,創新的MO題型能夠真實地刻畫模型在長鏈條推理中的能力衰減,有效放大了模型間的認知鴻溝。

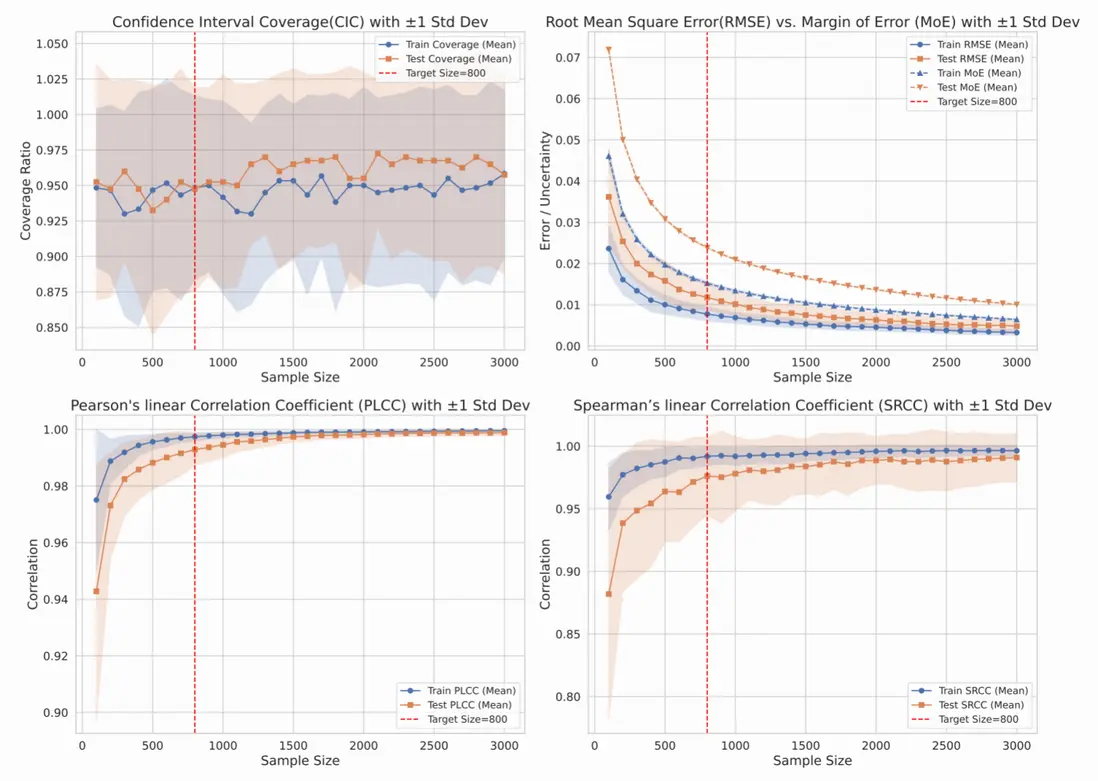

高效的數據集壓縮算法

如圖11所示,我們設計的聚類引導抽樣法,能在保持模型排名一致性(SRCC/PLCC > 0.98)的前提下,將評測算力消耗降低超過90%,實現了效率與準確性的平衡。

卓越的數據質量與區分度

一個評測基準的有效性,最終體現在其數據的質量和區分模型優劣的能力上。UNO-Bench在這兩方面都表現出色。

- 首先,在數據質量上,如前文表格1所示,UNO-Bench的全模態數據集問題準確率達到了100%,且有高達98%的問題被嚴格設計為必須跨模態才能解答,這確保了評測的公平性和對模型真實能力的有效檢驗。

- 其次,在區分度上,UNO-Bench的設計能夠清晰地揭示不同模型間的性能梯度。

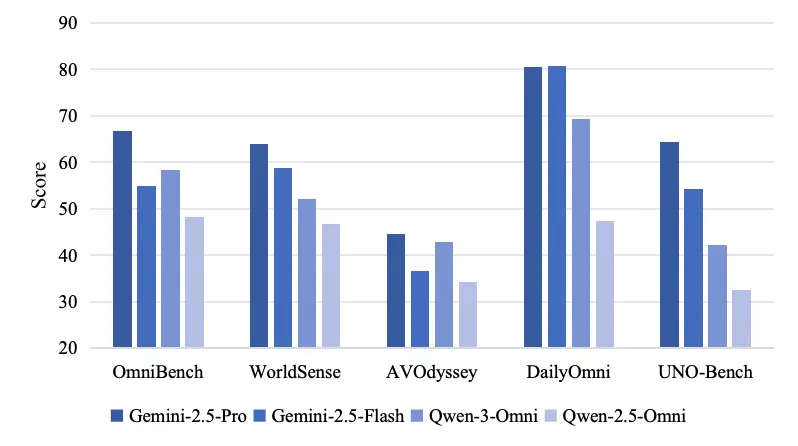

而在與其他全模態基準的直接對比中(如圖12所示),UNO-Bench的有效性也得到了進一步驗證。它不僅通過更高的得分標準差(19.5 vs. 12.75)展現了比OmniBench更強的區分能力,還通過合理的難度設置,避免了像AV-Odyssey那樣所有模型得分被壓縮在狹窄低分區間的窘境。這確保了UNO-Bench既能有效評估當前模型,也為未來更強模型的涌現預留了足夠的成長空間,是一個更可靠和富有洞察力的評測工具。

04. 總結與展望

本文提出了一站式全模態大模型評測基準——UNO-Bench。該基準通過科學的評測框架,首次揭示了多模態智能並非簡單的線性疊加,而是遵循着一種乘積規律,這一規律在能力較弱的模型上體現為瓶頸限制,而在頂尖模型上則表現為協同增益的特性,這個全模態大模型的“組合定律”為行業提供了一種全新的、跨越模型規模的分析範式。LongCat團隊的評測結果進一步表明,以Gemini為代表的閉源模型在單模態及跨模態理解上仍遠超主流開源陣營,其頂配版本雖在感知能力上已逼近人類專家,但在複雜的推理層面仍存在亟待突破的空間。而這些發現,正是得益於UNO-Bench自身的較高的數據質量與創新的評價機制,它有效擴展了模型表現的區分度,為新一代智能體的持續成長奠定了堅實基礎。

面向未來,LongCat團隊將通過自動化人機共建流程持續擴充數據規模,引入STEM、Code等更具挑戰性的場景,並深入探索模態間的互動關係,為下一代通用人工智能的發展開闢新路徑。

開源資源

- GitHub:https://github.com/meituan-longcat/UNO-Bench

- Hugging Face:https://huggingface.co/datasets/meituan-longcat/UNO-Bench

- 論文下載:https://github.com/meituan-longcat/UNO-Bench/blob/main/UNO-Bench.pdf

| 關注「美團技術團隊」微信公眾號,在公眾號菜單欄對話框回覆【2024年貨】、【2023年貨】、【2022年貨】、【2021年貨】、【2020年貨】、【2019年貨】、【2018年貨】、【2017年貨】等關鍵詞,可查看美團技術團隊歷年技術文章合集。

| 本文系美團技術團隊出品,著作權歸屬美團。歡迎出於分享和交流等非商業目的轉載或使用本文內容,敬請註明“內容轉載自美團技術團隊”。本文未經許可,不得進行商業性轉載或者使用。任何商用行為,請發送郵件至 tech@meituan.com 申請授權。