今天,我們正式發佈 LongCat-Flash-Chat,並同步開源。LongCat-Flash 採用創新性混合專家模型(Mixture-of-Experts, MoE)架構,總參數 560 B,激活參數 18.6B~31.3B(平均 27B),實現了計算效率與性能的雙重優化。

根據多項基準測試綜合評估,作為一款非思考型基礎模型,LongCat-Flash-Chat 在僅激活少量參數的前提下,性能比肩當下領先的主流模型,尤其在智能體任務中具備突出優勢。並且,因為面向推理效率的設計和創新,LongCat-Flash-Chat 具有明顯更快的推理速度,更適合於耗時較長的複雜智能體應用。

目前,我們在 Github、Hugging Face 平台同步開源,同時你也可以訪問官網 https://longcat.ai/,與 LongCat-Flash-Chat 開啓對話。

技術亮點

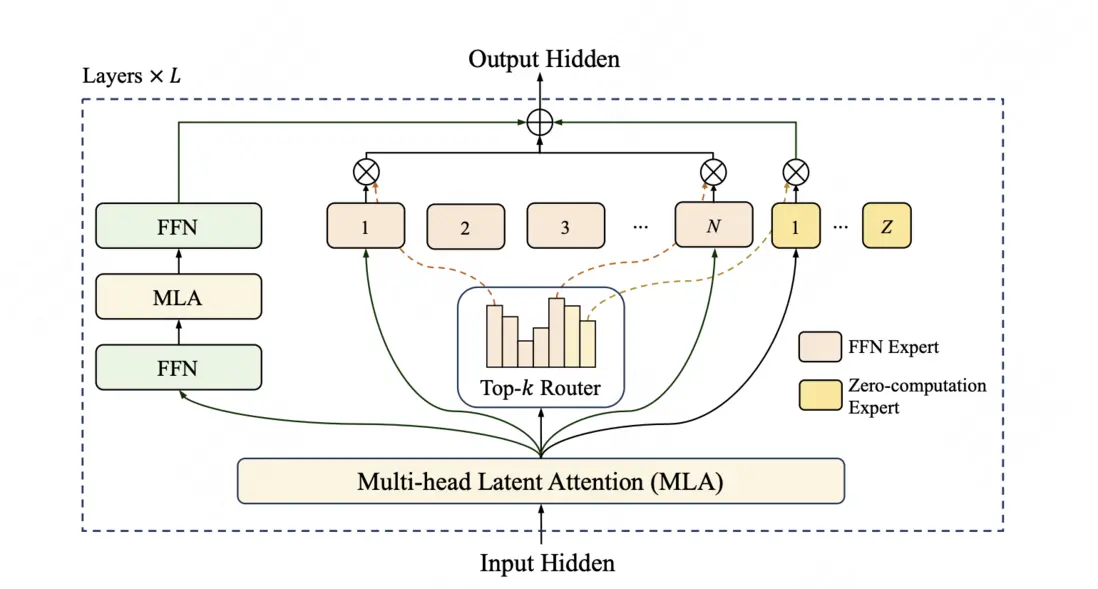

LongCat-Flash 模型在架構層面引入“零計算專家(Zero-Computation Experts)”機制,總參數量 560 B,每個 token 依據上下文需求僅激活 18.6B~31.3 B 參數,實現算力按需分配和高效利用。為控制總算力消耗,訓練過程採用 PID 控制器實時微調專家偏置,將單 Token 平均激活量穩定在約 27 B。

此外,LongCat-Flash 在層間鋪設跨層通道,使 MoE 的通信和計算能很大程度上並行,極大提高了訓練和推理效率。配合定製化的底層優化,LongCat-Flash 在 30 天內完成高效訓練,並在 H800 上實現單用户 100+ tokens/s 的推理速度。LongCat-Flash 還對常用大模型組件和訓練方式進行了改進,使用了超參遷移和模型層疊加的方式進行訓練,並結合了多項策略保證訓練穩定性,使得訓練全程高效且順利。

針對智能體(Agentic)能力,LongCat-Flash 自建了 Agentic 評測集指導數據策略,並在訓練全流程進行了全面的優化,包括使用多智能體方法生成多樣化高質量的軌跡數據等,實現了優異的智能體能力。

通過算法和工程層面的聯合設計,LongCat-Flash 在理論上的成本和速度都大幅領先行業同等規模、甚至規模更小的模型;通過系統優化,LongCat-Flash 在 H800 上達成了 100 tokens/s 的生成速度,在保持極致生成速度的同時,輸出成本低至 5 元/百萬 Token。

性能評估

全面且嚴謹的評估表明,LongCat-Flash 是一款強大且全能的模型,它在多個領域表現出卓越的性能優勢。以下將從不同維度詳細解讀:

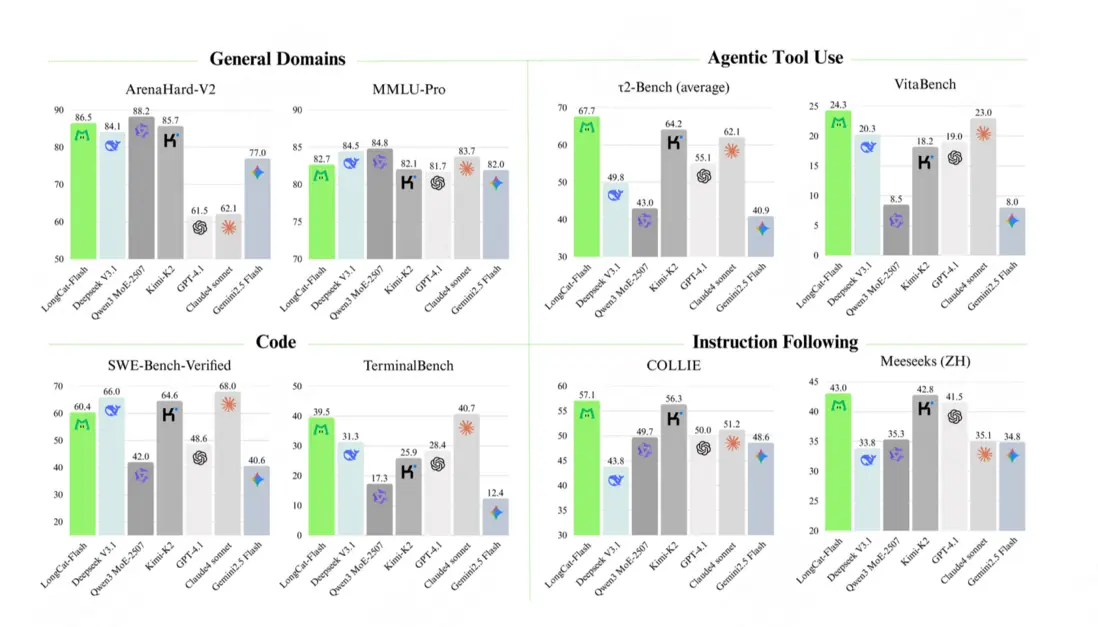

- 在 通用領域知識 方面,LongCat-Flash 表現出強勁且全面的性能:在 ArenaHard-V2 基準測試中取得 86.50 的優異成績,位列所有評估模型中的第二名,充分體現了其在高難度“一對一”對比中的穩健實力。在基礎基準測試中仍保持高競爭力,MMLU(多任務語言理解基準)得分為 89.71,CEval(中文通用能力評估基準)得分為 90.44。這些成績可與目前國內領先的模型比肩,且其參數規模少於 DeepSeek-V3.1、Kimi-K2 等產品,體現出較高的效率。

- 在 智能體(Agentic)工具使用 方面,LongCat-Flash 展現出明顯優勢:即便與參數規模更大的模型相比,其在 τ2-Bench(智能體工具使用基準)中的表現仍超越其他模型;在高複雜度場景下,該模型在 VitaBench(複雜場景智能體基準)中以 24.30 的得分位列第一,彰顯出在複雜場景中的強大處理能力。

- 在 編程 方面,LongCat-Flash 展現出紮實的實力:其在 TerminalBench(終端命令行任務基準)中,以 39.51 的得分位列第二,體現出在實際智能體命令行任務中的出色熟練度;在 SWE-Bench-Verified(軟件工程師能力驗證基準)中得分為 60.4,具備較強競爭力。

- 在 指令遵循 方面,LongCat-Flash 優勢顯著:在 IFEval(指令遵循評估基準)中以 89.65 的得分位列第一,展現出在遵循複雜且細緻指令時的卓越可靠性;此外,在 COLLIE(中文指令遵循基準)和 Meeseeks-zh(中文多場景指令基準)中也斬獲最佳成績,分別為 57.10 和 43.03,凸顯其在中英文兩類不同語言、不同高難度指令集上的出色駕馭能力。

模型部署

我們同步提供了分別基於 SGLang 和 vLLM 的兩種高效部署方案,助您輕鬆部署、快速體驗模型效果。

以下為使用 SGLang 進行單機部署的示例:

python3 -m sglang.launch_server \

--model meituan-longcat/LongCat-Flash-Chat-FP8 \

--trust-remote-code \

--attention-backend flashinfer \

--enable-ep-moe \

--tp 8其他更為詳細的部署指導請參閲 LongCat-Flash-Chat 倉庫:

https://github.com/meituan-longcat/LongCat-Flash-Chat

全面開放,即刻體驗

前往 https://longcat.ai/,立即與 LongCat-Flash-Chat 開啓對話。

開源平台地址:

- Hugging Face:https://huggingface.co/meituan-longcat/LongCat-Flash-Chat

- Github:https://github.com/meituan-longcat/LongCat-Flash-Chat

此次我們的開源倉庫統一採用 MIT License,並允許用户利用模型輸出、通過模型蒸餾等方式訓練其他模型。

| 關注「美團技術團隊」微信公眾號,在公眾號菜單欄對話框回覆【2024年貨】、【2023年貨】、【2022年貨】、【2021年貨】、【2020年貨】、【2019年貨】、【2018年貨】、【2017年貨】等關鍵詞,可查看美團技術團隊歷年技術文章合集。

| 本文系美團技術團隊出品,著作權歸屬美團。歡迎出於分享和交流等非商業目的轉載或使用本文內容,敬請註明“內容轉載自美團技術團隊”。本文未經許可,不得進行商業性轉載或者使用。任何商用行為,請發送郵件至 tech@meituan.com 申請授權。