前言:互聯網的觸角——網絡爬蟲及其重要性

在信息爆炸的時代,互聯網已成為人類知識和數據最龐大的載體。如何高效地從這浩如煙海的信息中提取有價值的內容,成為了現代信息技術領域一個核心挑戰。網絡爬蟲,作為自動化信息採集的利器,扮演着至關重要的角色。它如同互聯網的觸角,不知疲倦地探索、發現和收集網絡信息,為搜索引擎、數據分析、網絡監控等眾多應用場景提供源源不斷的數據支持。網絡爬蟲的應用領域極為廣泛,幾乎滲透到互聯網應用的方方面面:

- 搜索引擎的基石:索引構建。搜索引擎,例如Google、百度等,之所以能夠快速響應用户的搜索請求,精準定位所需信息,背後強大的網絡爬蟲功不可沒。它們持續不斷地抓取網頁,建立索引,為搜索引擎提供最基礎的數據支撐。Googlebot 就是 Google 搜索引擎的代表性爬蟲。

- 數字記憶的守護者:網絡歸檔。為了保存珍貴的網絡信息,供未來研究和查閲,許多機構,如美國國會圖書館、歐盟網絡檔案等,都依賴網絡爬蟲技術進行網絡信息的歸檔工作。這相當於為數字時代建立了一座座巨大的檔案館。

- 數據挖掘的引擎:知識發現。互聯網藴藏着巨大的數據價值,網絡爬蟲可以幫助我們挖掘這些潛在的知識。金融機構使用爬蟲抓取財經新聞、公司報告,分析市場動態;研究機構利用爬蟲收集學術論文、研究數據,推動科學進步。

- 網絡安全的衞士:侵權監控。在數字版權保護日益重要的今天,網絡爬蟲也成為了維護知識產權的有效工具。例如,Digimarc 公司利用爬蟲監測網絡上的盜版內容,保護版權所有者的權益。

- 商業情報的助手:競爭分析。企業可以利用爬蟲抓取競爭對手的網站信息、產品價格、用户評價等,進行市場調研和競爭分析,輔助商業決策。

- 內容聚合的工具:信息整合。新聞聚合應用、比價網站等,也常使用爬蟲技術,從不同的網站抓取信息,整合呈現給用户,提供便捷的信息服務。

構建一個高性能、高可靠、可擴展的網絡爬蟲系統絕非易事。它可能是一個簡單的個人項目,也可能是需要專業團隊長期投入和持續優化的複雜工程。為了深入理解網絡爬蟲的設計,我們接下來將從需求分析、架構設計、關鍵技術等方面展開詳細的探討。

第一步:深入理解需求,劃定設計範圍

如同任何軟件系統設計一樣,首要任務是明確需求,劃定設計範圍。在網絡爬蟲設計中,這一點尤為重要。清晰的需求理解是後續設計工作的基礎。

- 核心目標:搜索引擎索引。這決定了爬蟲設計的核心關注點是網頁的廣泛抓取和索引數據的有效構建。

- 抓取規模:每月 10 億網頁。這是一個龐大的數字,直接決定了系統的可擴展性、性能、存儲容量等方面的設計指標。如此巨大的抓取量,必須採用分佈式架構和高效的數據處理流程。

- 內容類型:僅限 HTML。 簡化了內容處理的複雜度,但仍然需要關注 HTML 頁面的高效下載、解析和信息提取。

- 更新機制:考慮新增和修改網頁。 意味着爬蟲需要具備增量抓取能力,能夠定期檢測網頁變化,及時抓取更新內容,並更新索引。

- 數據存儲:HTML 快照存儲五年。 顯著增加了存儲需求,需要考慮高效的數據壓縮和長期存儲方案。五年快照的存儲,也為後續的數據分析和挖掘提供了可能。

- 重複內容處理:忽略重複網頁。 要求爬蟲具備一定的去重能力,避免重複抓取和存儲相同內容的網頁,節省資源。

除了以上具體的功能性需求,一個優秀網絡爬蟲應具備的關鍵特性,這些特性是評價爬蟲系統優劣的重要標準:

- 可擴展性 (Scalability): 互聯網的規模持續膨脹,網頁數量呈指數級增長。網絡爬蟲必須具備良好的可擴展性,能夠通過增加服務器數量、優化系統架構等方式,應對日益增長的抓取任務。並行化抓取是提升效率的關鍵手段。

- 魯棒性 (Robustness): 互聯網環境極其複雜,充斥着各種異常情況:網絡連接不穩定、服務器響應超時、HTML 格式錯誤、惡意鏈接、爬蟲陷阱等等。 爬蟲系統必須具備強大的魯棒性,能夠優雅地處理各種異常,保證穩定可靠地運行。

- 禮貌性 (Politeness): 網絡爬蟲在互聯網上進行信息採集活動,必須遵守 “Robots 協議” 等行業規範,尊重網站所有者的意願,避免對目標網站造成過大的訪問壓力。過度的請求可能被視為拒絕服務攻擊 (DoS),甚至導致 IP 被封禁。

- 可擴展性 (Extensibility) : 系統設計應具備良好的靈活性和可擴展性,方便未來擴展功能或支持新的內容類型。例如,未來可能需要爬取圖片、PDF 文檔、視頻等不同類型的文件。良好的擴展性可以降低維護成本,延長系統生命週期。

封底估算:初步評估資源需求

在系統設計初期,快速評估所需的資源規模,例如計算能力、存儲容量、網絡帶寬等。雖然估算結果可能不夠精確,但可以幫助我們對系統的量級有一個初步的認識。

基於每月下載 10 億網頁的假設,文檔進行了如下的估算:

- 平均下載速率:每月 10 億網頁,約等於每秒下載 400 個網頁 (10億 / (30天 24小時 3600秒) ≈ 386)。

- 平均網頁大小:假設平均網頁大小為 500KB。

- 每月新增存儲需求:每月 500TB (10億網頁 * 500KB = 500TB)。

- 五年快照存儲總需求:30PB (500TB/月 12個月/年 5年 = 30PB)。

這個簡單的估算結果令人震驚,五年內僅網頁內容就需要 30PB 的存儲空間。 這進一步突顯了構建高效、可擴展的網絡爬蟲系統的必要性。 海量數據存儲和高速數據處理將成為系統設計的核心挑戰。

第二步:構建高層設計藍圖

在充分理解需求和進行初步規模估算之後,着手構建網絡爬蟲的高層設計架構了。

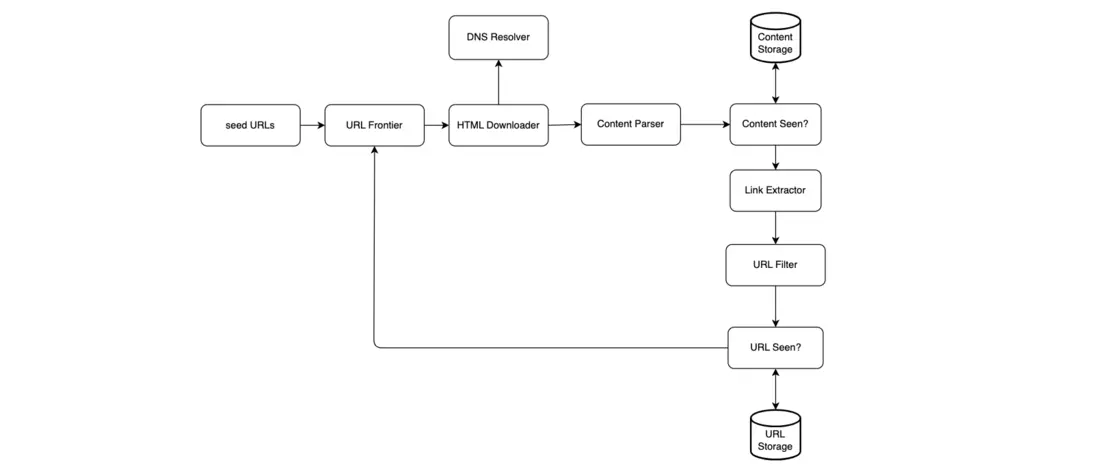

這張架構圖清晰地展示了網絡爬蟲的核心組件以及它們之間的相互作用關係。每個組件都承擔着特定的職責,協同工作,共同完成網頁抓取任務。接下來,我們將逐一深入解析這些核心組件的功能和作用。

核心組件詳解

-

種子 URL (Seed URLs): 爬蟲的起點

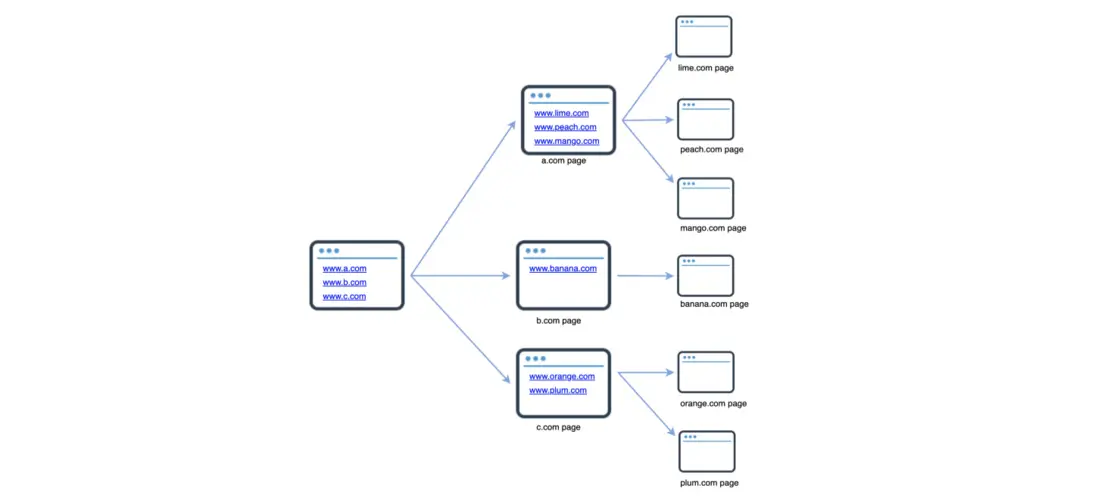

網絡爬蟲的抓取過程始於一組精心挑選的種子 URL。種子 URL 是爬蟲探索互聯網的初始入口,如同探險隊的初始營地。種子 URL 的選擇策略直接影響着爬蟲的抓取效率和覆蓋範圍。

- 定向抓取:如果目標是抓取特定網站的內容,例如某個大學的官方網站,那麼該大學的域名 (例如

www.university.edu) 就是最直接、最有效的種子 URL。 - 全網抓取:如果目標是儘可能全面地抓取互聯網信息,種子 URL 的選擇就更具挑戰性。我們需要儘可能覆蓋互聯網的各個領域。一種常見的策略是將整個 URL 空間劃分成更小的區域,例如按地理位置、主題領域等進行劃分。針對不同國家或地區的熱門網站,或者新聞、科技、體育、健康等不同主題的網站,分別設定種子 URL。

種子 URL 的選擇是一個開放性問題,沒有唯一的“最佳答案”。 最關鍵的是根據實際的抓取目標和需求,選擇最合適的起始 URL 集合。 良好的種子 URL 策略能夠引導爬蟲快速高效地進入目標抓取範圍。

- 定向抓取:如果目標是抓取特定網站的內容,例如某個大學的官方網站,那麼該大學的域名 (例如

-

URL 隊列 (URL Frontier): 待抓取 URL 的管理器

URL 隊列 (URL Frontier),中文也常稱為 待抓取 URL 隊列, 是網絡爬蟲系統中至關重要的核心組件之一。它負責管理所有 待下載 的 URL。 現代爬蟲通常將抓取任務的狀態分為兩個主要部分: 待下載的 URL 和 已下載的 URL。 URL 隊列 (URL Frontier) 主要負責維護和管理前者。

URL 隊列 (URL Frontier) 的設計直接決定了爬蟲的抓取策略和效率。 深度優先搜索 (DFS) 和廣度優先搜索 (BFS) 兩種常見的抓取策略,而 URL 隊列 (URL Frontier) 的實現方式會直接影響抓取策略的選擇和效果。 我們將在後續“深度優先搜索 (DFS) 與關鍵技術”部分深入探討 URL 隊列 (URL Frontier) 的設計細節。

-

HTML 下載器 (HTML Downloader): 網頁內容的獲取者

HTML 下載器 (HTML Downloader) 的職責非常明確而核心,就是從互聯網上下載網頁內容。 它從 URL 隊列 (URL Frontier) 中獲取一批待下載的 URL 列表,然後針對每個 URL,向對應的 Web 服務器發起 HTTP 請求,下載 HTML 頁面。

HTML 下載器 的性能直接影響着整個爬蟲系統的抓取速度。 高效的 HTML 下載器 需要具備以下能力:

- 高併發下載: 支持同時發起多個 HTTP 請求,並行下載網頁,提高整體吞吐量。

- 連接池管理: 有效地管理 HTTP 連接,複用連接,減少連接建立和斷開的開銷。

- 超時控制: 設置合理的請求超時時間,避免因個別網站響應緩慢而阻塞整個爬蟲流程。

- User-Agent 隨機切換: 模擬不同的瀏覽器 User-Agent,避免被網站識別為爬蟲並封禁。

- 代理 IP 支持: 使用代理 IP 池,輪換 IP 地址,避免因 IP 訪問頻率過高而被網站封禁。

-

DNS 解析器 (DNS Resolver): URL 到 IP 地址的翻譯器

在 HTML 下載器 下載網頁之前,需要將人類可讀的 URL (例如

www.example.com) 轉換為計算機網絡中可識別的 IP 地址 (例如192.0.2.1)。 DNS 解析器 (DNS Resolver) 就負責完成這項關鍵的 “翻譯” 工作。 HTML 下載器 會調用 DNS 解析器,查詢 URL 對應的 IP 地址,以便建立網絡連接,最終成功下載網頁內容。DNS 解析的效率也會影響爬蟲的整體性能。 為了優化 DNS 解析效率,可以採用以下策略:

- DNS 緩存: 緩存已解析的 DNS 記錄,下次解析相同域名時,直接從緩存中讀取結果,減少 DNS 查詢次數。

- 異步 DNS 解析: 使用異步 DNS 解析庫,避免因 DNS 解析耗時而阻塞下載線程。

- 使用本地 DNS 服務器: 配置使用本地 DNS 服務器或高速 DNS 服務器,提高 DNS 解析速度。

-

內容解析器 (Content Parser): HTML 頁面的分析器

下載的 HTML 頁面可能包含各種格式錯誤、代碼冗餘或惡意代碼。 內容解析器 (Content Parser) 的作用是對下載的 HTML 頁面進行解析、清洗和驗證, 檢查頁面是否完整、有效,並從中提取出有用的信息,例如:

- 頁面元數據: 標題 (Title)、關鍵詞 (Keywords)、描述 (Description) 等。

- 正文內容: 去除 HTML 標籤、廣告、導航欄等噪音信息,提取出頁面的主要文本內容。

- 鏈接 (URLs): 提取頁面中包含的所有鏈接,為後續的抓取提供新的目標 URL。

內容解析器 通常需要處理各種複雜的 HTML 結構,並具備一定的容錯能力,以應對格式不規範的網頁。 常用的 HTML 解析庫包括:

- BeautifulSoup (Python)

- Jsoup (Java)

- HTMLParser (Python 標準庫)

由於網頁解析可能較為耗時,通常會將其設計為獨立的組件,異步執行,以避免阻塞整個爬蟲流程。

-

內容存儲 (Content Storage): 網頁數據的倉庫

內容存儲 (Content Storage) 系統負責存儲下載和解析後的 HTML 頁面內容。存儲系統的選擇需要根據多種因素綜合考慮,例如:

- 數據量大小: 根據預估的抓取規模,選擇合適的存儲介質和架構。

- 數據類型: HTML 文本數據、索引數據、元數據等,不同類型的數據可能需要不同的存儲方案。

- 訪問頻率: 高頻訪問的數據可以考慮使用高速存儲介質,例如內存緩存、SSD 固態硬盤。

- 數據生命週期: 根據數據保留時間要求,選擇合適的存儲成本方案。

常用的存儲介質和技術包括:

- 磁盤存儲: 成本較低,適合存儲海量網頁數據。 可以使用分佈式文件系統 (HDFS)、對象存儲 (如 Amazon S3, 阿里雲 OSS) 等。

- 內存緩存: 速度極快,適合緩存熱點數據,例如頻繁訪問的網頁、索引數據等。 可以使用 Redis, Memcached 等內存數據庫。

-

數據庫: 適合存儲結構化數據和元數據,提供靈活的查詢和管理功能。 可以使用關係型數據庫 (MySQL, PostgreSQL) 或 NoSQL 數據庫 (MongoDB, Cassandra)。

研究表明,互聯網上存在大量的重複網頁,大約 29% 的網頁內容是重複的。 為了避免重複存儲相同的內容,浪費存儲空間,可以採用內容哈希 (Content Hashing) 技術。 計算網頁內容的哈希值 (例如 MD5, SHA-256),並與已存儲內容的哈希值進行比較。 如果哈希值相同,則認為內容重複,可以丟棄,只保留一份副本。

-

URL 提取器 (URL Extractor): 鏈接的挖掘機

URL 提取器 (URL Extractor) 的核心任務是從已下載的 HTML 頁面中,解析並提取出所有包含的鏈接 (URLs)。 它就像一個鏈接挖掘機,深入 HTML 代碼的海洋,找出所有指向其他網頁的超鏈接, 為爬蟲的下一步抓取提供源源不斷的新目標。

URL 提取器 需要能夠處理各種 HTML 鏈接形式,包括絕對路徑和相對路徑。 對於相對路徑的鏈接,需要根據當前頁面的 Base URL,將其轉換為絕對 URL。 例如,將 `<a href="/wiki/Cong_Wuwei">康有為</a>` 轉換為完整的絕對 URL `https://en.wikipedia.org/wiki/Cong_Wuwei`。

高效的 URL 提取器 需要具備以下能力:

* **快速解析 HTML**: 使用高效的 HTML 解析庫,快速定位和提取鏈接。

* **處理各種鏈接形式**: 能夠處理 HTML 代碼中各種不同的鏈接形式,例如 `<a href="...">`, `<img src="...">`, `<link href="...">`, `<script src="...">` 等。

* **URL 規範化**: 對提取出的 URL 進行規範化處理,例如去除 URL 中的空格、特殊字符,統一 URL 編碼,方便後續處理。

-

URL 過濾器 (URL Filter): 鏈接的守門員

URL 過濾器 (URL Filter) 的作用是對 URL 提取器 提取出的鏈接進行過濾, 排除掉那些爬蟲不需要抓取的 URL, 提高抓取的效率和質量。 URL 過濾器 就像鏈接的守門員,只允許符合條件的 URL 進入後續的處理流程。

URL 過濾器 可以根據多種規則進行過濾,例如:

- 內容類型過濾: 根據 URL 的文件擴展名、MIME 類型等,排除掉不需要抓取的內容類型,例如圖片、視頻、音頻、文檔等。 如果需求只抓取 HTML 頁面,則可以過濾掉所有非 HTML 類型的 URL。

- URL 模式匹配: 使用正則表達式或通配符,匹配 URL 的模式,排除掉符合特定模式的 URL。 例如,可以排除掉包含特定關鍵詞、特定目錄結構的 URL。

- 黑名單過濾: 維護一個黑名單 URL 列表或域名列表,排除掉黑名單中的 URL,例如已知的惡意網站、垃圾網站、爬蟲陷阱網站等。

- Robots 協議過濾: 遵守網站的 Robots 協議 (robots.txt),排除掉 Robots 協議禁止爬蟲訪問的 URL。

- 追蹤鏈接過濾: 過濾掉用於用户行為追蹤的鏈接,例如包含

utm_source,_trackid等參數的 URL。

合理的 URL 過濾規則能夠有效地減少無效抓取, 節省帶寬和計算資源,提高爬蟲的效率和數據質量。

-

URL 已訪問? (URL Seen?): URL 訪問狀態的記錄者

URL 已訪問? (URL Seen?), 常稱為 已訪問 URL 列表 或 URL 去重模塊, 是網絡爬蟲系統中用於 跟蹤 URL 訪問狀態 的關鍵組件。 它的核心作用是記錄哪些 URL 已經被爬蟲訪問過,或者已經存在於 URL 隊列 (URL Frontier) 中, 防止爬蟲重複抓取相同的 URL, 避免陷入無限循環,並減輕服務器壓力。

URL 已訪問? (URL Seen?) 就像一個 URL 訪問歷史記錄本, 爬蟲在準備抓取某個 URL 之前,首先會查詢 “URL 已訪問? (URL Seen?)” 組件,判斷該 URL 是否已經被訪問過了。

URL 已訪問? (URL Seen?) 的高效實現至關重要,因為它需要處理海量的 URL 查詢請求,並儘可能節省內存空間。 常用的實現技術包括:

- 哈希表 (Hash Table): 使用哈希表 (或哈希集合) 存儲已訪問 URL 的哈希值。 哈希表查詢速度快,平均時間複雜度為 O(1)。

- 布隆過濾器 (Bloom Filter): 布隆過濾器是一種空間效率極高的概率型數據結構,用於快速判斷一個元素是否可能在一個集合中。 它可以用極小的內存空間存儲海量的 URL 訪問信息,但存在一定的誤判率 (False Positive), 即可能將未訪問的 URL 誤判為已訪問,但不會出現漏判 (False Negative)。 布隆過濾器非常適合用於海量 URL 去重場景,對內存空間要求非常苛刻的場景。

-

URL 存儲 (URL Storage): 已訪問 URL 的持久化存儲

URL 存儲 (URL Storage) 系統用於持久化存儲 已訪問的 URL 列表。 與 URL 已訪問? (URL Seen?) 組件不同的是, URL 存儲 (URL Storage) 更側重於數據的持久化存儲, 例如將已訪問的 URL 列表寫入數據庫或文件系統, 以便在爬蟲重啓、故障恢復或後續數據分析時使用。

URL 存儲 (URL Storage) 的選擇也需要根據實際需求進行權衡, 例如:

- 數據庫: 關係型數據庫 (MySQL, PostgreSQL) 或 NoSQL 數據庫 (MongoDB) 都可以用來存儲 URL 數據, 提供可靠的持久化存儲和靈活的查詢功能。

- 分佈式文件系統: 對於海量 URL 存儲, 可以使用分佈式文件系統 (HDFS) 存儲 URL 列表文件。

網絡爬蟲工作流程詳解

為了更清晰地理解各個組件是如何協同工作的,讓我們再次回顧網絡爬蟲工作流程,並結合之前對各個組件的介紹,詳細解讀爬蟲的工作流程。

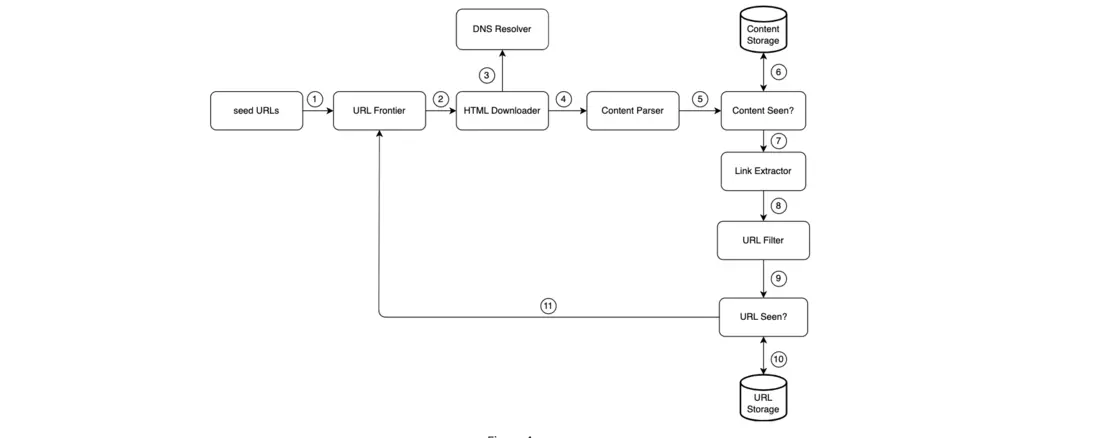

網絡爬蟲的工作流程可以分解為以下 11 個步驟 (如圖 4 所示):

- 步驟 1:添加種子 URL 到 URL 隊列 (URL Frontier)。 爬蟲的抓取任務從這裏開始,將預先設定的種子 URL 添加到 URL 隊列 (URL Frontier) 中,作為初始的抓取目標。

- 步驟 2:HTML 下載器 從 URL 隊列 (URL Frontier) 獲取 URL 列表。 HTML 下載器 定期從 URL 隊列 (URL Frontier) 中獲取一批待下載的 URL,準備開始下載網頁。

- 步驟 3:HTML 下載器 從 DNS 解析器 獲取 URL 的 IP 地址。 對於每一個待下載的 URL, HTML 下載器 首先調用 DNS 解析器, 將 URL 解析成對應的 IP 地址,為建立網絡連接做準備。

- 步驟 4:HTML 下載器 開始下載網頁。 HTML 下載器 根據 DNS 解析得到的 IP 地址,向 Web 服務器發送 HTTP 請求,下載 HTML 頁面。

- 步驟 5:內容解析器 解析 HTML 頁面並進行格式檢查。 內容解析器 接收到下載的 HTML 頁面後, 對頁面進行解析和驗證, 檢查 HTML 格式是否正確, 頁面內容是否完整有效。

-

步驟 6:內容去重檢查 (內容感知組件)。 “內容感知” 組件 (即內容去重模塊) 檢查解析後的 HTML 頁面內容是否已經存在於 內容存儲 (Content Storage) 系統中。

- 如果已存在: 説明該頁面內容之前已經被抓取和存儲過 (可能是不同的 URL 指向了相同的內容)。 為了避免重複存儲, 丟棄該頁面, 結束本次處理流程。

- 如果不存在: 説明這是一個新的頁面內容, 繼續進行後續處理。

- 步驟 7:鏈接提取器 從 HTML 頁面中提取鏈接。 鏈接提取器 負責從解析後的 HTML 頁面中, 提取出所有包含的鏈接 (URL), 為後續的抓取任務發現新的目標。

- 步驟 8:URL 過濾器 對提取的鏈接進行過濾。 URL 過濾器 根據預設的過濾規則, 對提取出的鏈接進行過濾, 排除掉不需要抓取的 URL, 例如圖片鏈接、視頻鏈接、黑名單 URL 等。

- 步驟 9:URL 傳遞給 “URL 已訪問? (URL Seen?)” 組件進行檢查。 將過濾後的 URL 傳遞給 “URL 已訪問? (URL Seen?)” 組件, 進行 URL 是否已訪問的檢查。

-

步驟 10:“URL 已訪問? (URL Seen?)” 組件判斷 URL 是否已被處理。 “URL 已訪問? (URL Seen?)” 組件查詢已訪問 URL 列表, 判斷當前 URL 是否已經被訪問過。

- 如果已處理: 説明該 URL 已經被抓取過了, 無需再次處理, 結束本次流程。

- 如果未處理: 説明這是一個新的、尚未被抓取的 URL, 繼續進行下一步處理。

- 步驟 11:將新的 URL 添加到 URL 隊列 (URL Frontier)。 將 “URL 已訪問? (URL Seen?)” 組件判斷為 “未處理” 的新 URL, 添加回 URL 隊列 (URL Frontier) 中, 等待下一輪的抓取。

通過以上 11 個步驟的循環往復, 網絡爬蟲就像不知疲倦的蜘蛛, 在互聯網上持續不斷地抓取網頁, 並將抓取到的有價值信息存儲起來。 這個工作流程體現了網絡爬蟲的核心思想: 從種子 URL 出發, 沿着鏈接不斷髮現新的 URL, 並不斷抓取和處理網頁內容, 循環往復, 不斷擴張抓取範圍。

第三步:深度優先搜索 (DFS) 與關鍵技術深入

在高層架構設計的基礎上,進一步深入探討了深度優先搜索 (DFS) 和廣度優先搜索 (BFS) 兩種常見的抓取策略。

深度優先搜索 (DFS) vs 廣度優先搜索 (BFS) 策略

網絡爬蟲的抓取過程本質上可以看作是對互聯網這張巨型 “網頁圖” 的遍歷。 網頁是圖中的節點, 網頁之間的超鏈接 (URL) 是圖中的邊。 兩種經典的圖遍歷算法: 深度優先搜索 (DFS) 和 廣度優先搜索 (BFS)。 這兩種算法也成為了網絡爬蟲常用的抓取策略。

-

廣度優先搜索 (BFS): 逐層擴展,全面覆蓋。 BFS 策略 優先抓取距離種子 URL “近” 的網頁, 以種子 URL 為中心, 由近及遠, 一層一層地向外擴展抓取, 就像水波紋一樣, 逐步擴散到整個網絡。 BFS 使用 先進先出 (FIFO) 隊列 來實現, URL 按照請求的先後順序入隊和出隊。

標準的 BFS 策略 在網絡爬蟲應用中, 雖然能夠保證抓取範圍的廣度, 但也存在一些固有的問題和侷限性:

- 爬蟲陷阱 (Crawler Traps): 互聯網上存在一些 “爬蟲陷阱” 網站, 例如, 無限深度或循環鏈接的目錄結構。 如果使用 BFS 策略, 爬蟲可能會被困在這些陷阱網站中, 無限制地抓取同一站點的網頁, 導致抓取效率低下, 浪費大量資源。 例如, 維基百科的網頁, 內部鏈接非常豐富, 如果使用 BFS 策略, 爬蟲可能會長時間專注於抓取維基百科內部的網頁, 而忽略了其他更廣泛的網絡空間, 這就如同陷入了 “維基百科陷阱”。 此外, 過度的請求同一站點, 也可能對目標網站服務器造成過大的壓力, 甚至被網站識別為惡意爬蟲而封禁。

- URL 優先級忽略: 標準的 BFS 策略 對待所有 URL 一視同仁, 不考慮 URL 的優先級和重要性。 但在實際應用中, 不同網頁的價值和質量可能差異巨大。 例如, 一個高質量的新聞門户網站首頁, 顯然比一個個人博客的某個過時頁面更有價值。 如果能夠優先抓取高質量、重要的網頁, 就能在有限的資源下, 最大化爬蟲的價值。

-

深度優先搜索 (DFS): 深入探索,縱向挖掘。 DFS 策略 則優先沿着一條鏈接路徑深入抓取, 儘可能深入地挖掘網頁內容, 直到達到預設的抓取深度限制, 或者遇到死鏈接、無效頁面, 再回溯到上一個節點, 繼續探索其他分支路徑。 DFS 策略 更側重於縱向挖掘, 沿着鏈接不斷深入, 力求儘可能完整地抓取單個網站或某個主題領域的內容。

DFS 策略 通常是網絡爬蟲更好的選擇, 因為互聯網網頁之間的鏈接深度可能非常深, 使用 DFS 策略 更有利於深入挖掘網站內容, 發現隱藏在深層目錄下的網頁。 但 DFS 策略 也存在一定的侷限性, 例如, 如果網站的鏈接結構過於複雜, DFS 策略 可能會陷入過深的抓取路徑, 導致抓取範圍過於狹窄, 錯過其他重要的網頁。

在實際應用中, 可以根據具體的抓取目標和網站特點, 靈活選擇 BFS 或 DFS 策略, 或者將兩者結合使用, 例如, 先使用 BFS 策略 進行廣度優先的初步抓取, 然後再針對特定網站或主題, 使用 DFS 策略 進行深度挖掘。

URL 隊列 (URL Frontier) 的精細化設計: 禮貌性、優先級與新鮮度

為了克服 BFS 策略 的缺陷, 並更好地控制和優化抓取過程, 將深入探討 URL 隊列 (URL Frontier) 的精細化設計, 特別是如何通過 URL 隊列 (URL Frontier) 來實現網絡爬蟲的 禮貌性 (Politeness)、 優先級 (Priority) 和 新鮮度 (Freshness) 等關鍵特性。

-

禮貌性 (Politeness): 避免過度訪問,尊重網站意願

網絡爬蟲在互聯網上進行信息採集活動時, 必須遵守 禮貌性 (Politeness) 原則, 限制對同一網站的訪問頻率, 避免對目標網站服務器造成過大的訪問壓力, 尊重網站所有者的意願。 過度的請求, 特別是在短時間內發起大量請求, 可能會被網站服務器識別為惡意攻擊 (DoS), 導致 IP 被封禁, 甚至引發法律風險。

實現 禮貌性 (Politeness) 的常用方法包括:

- 限制併發連接數: 限制爬蟲程序同時向同一網站發起的併發連接數, 例如, 同一時刻只允許建立 1-2 個連接。

- 添加請求延遲: 在每次下載網頁之後, 暫停一段時間 (例如幾秒鐘), 再進行下一次請求, 降低對網站的訪問頻率。

- 遵守 Robots 協議: 嚴格遵守網站的 Robots 協議 (robots.txt) 的規定, 不抓取 Robots 協議 禁止爬蟲訪問的目錄或頁面。

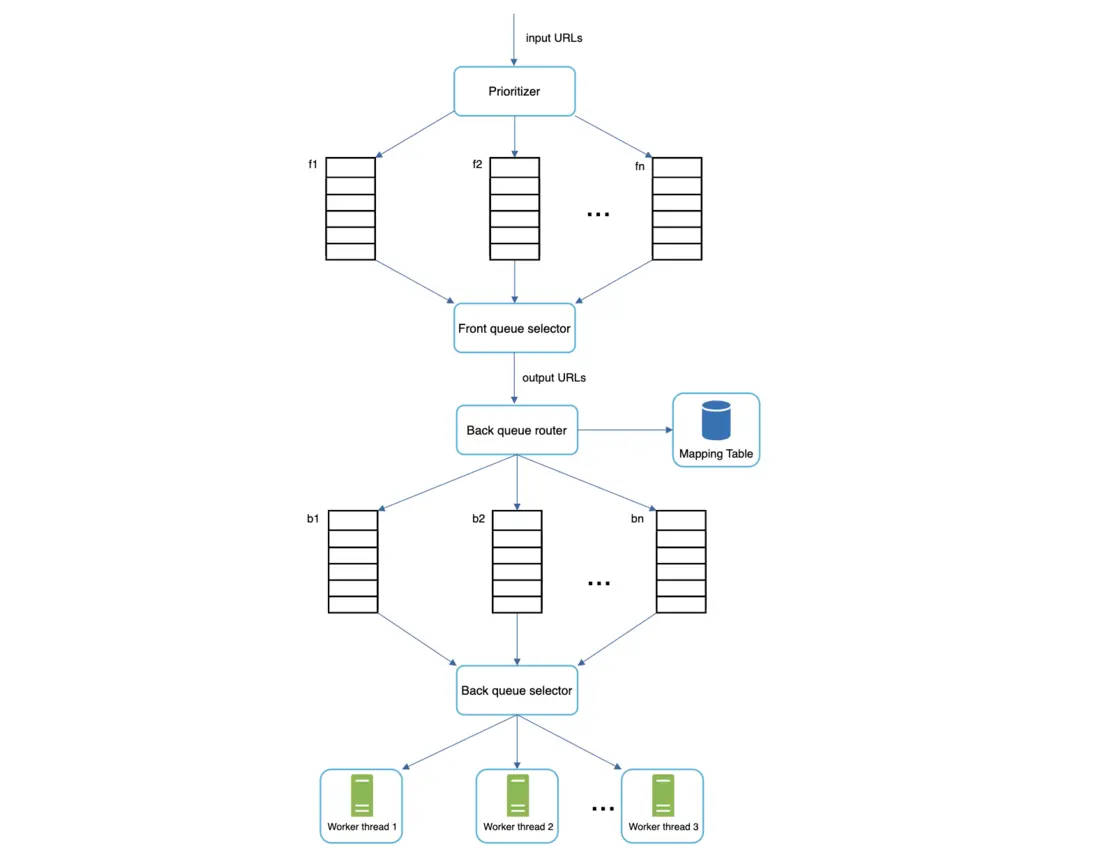

URL 隊列 (URL Frontier) 管理禮貌性的設計方案:

這個設計方案的核心思想是 基於主機名進行隊列劃分和調度, 確保每個工作線程在一段時間內只從同一主機下載網頁, 從而實現禮貌性訪問。 其主要組件包括:

- 隊列路由器 (Queue Router): 負責接收待抓取的 URL, 並根據 URL 的主機名, 將 URL 路由到不同的 FIFO 隊列 (FIFO Queues) 中。 保證每個隊列只包含來自同一主機的 URL。

- 映射表 (Mapping Table): 維護一個 主機名到 FIFO 隊列 的映射關係表, 記錄每個主機名對應的隊列。

- FIFO 隊列 (FIFO Queues b1, b2...bn): 多個 FIFO 隊列, 每個隊列對應一個主機名, 存儲來自該主機的待抓取 URL。

- 隊列選擇器 (Queue Selector): 負責從多個 FIFO 隊列中選擇一個隊列, 供工作線程進行下載。 隊列選擇器 可以採用輪詢 (Round Robin) 或其他調度算法, 確保公平地調度各個主機隊列。

- 工作線程 (Working Threads 1 to N): 多個工作線程, 每個工作線程被分配到一個 FIFO 隊列, 並且 只能從分配給自己的隊列中下載 URL。 工作線程 在下載網頁時, 可以添加適當的延遲, 進一步降低訪問頻率。

通過這種基於 URL 隊列 (URL Frontier) 的禮貌性管理設計, 網絡爬蟲可以有效地控制對同一網站的訪問頻率, 避免過度訪問, 降低被網站封禁的風險, 並更好地遵守互聯網 “遊戲規則”。

-

優先級 (Priority): 優先抓取重要網頁,提升數據價值

互聯網上的網頁質量和價值參差不齊, 並非所有網頁都具有相同的抓取優先級。 在有限的抓取資源下, 優先抓取更重要、更有價值的網頁, 能夠顯著提升爬蟲的整體數據價值和效率。 優先級 (Priority) 機制 就是為了解決這個問題而提出的。

實現 優先級 (Priority) 的關鍵在於 如何評估和量化網頁的重要性。 常用的網頁優先級評估指標包括:

- PageRank 值: Google 提出的 PageRank 算法 是評估網頁重要性的經典指標, PageRank 值越高的網頁, 通常認為越重要。

- 網站流量: 網站的流量越高, 通常意味着網站內容越受歡迎, 也可能包含更多有價值的信息。 可以使用 Alexa 排名、 網站流量統計數據 等指標來評估網站流量。

- 更新頻率: 內容更新頻率高的網站, 例如新聞網站、博客等, 通常包含更多時效性信息, 值得優先抓取。

- 關鍵詞相關性: 根據預設的關鍵詞列表, 評估網頁內容與關鍵詞的相關性。 與關鍵詞相關性越高的網頁, 優先級越高。

- 網站權威性: 政府網站、知名媒體網站、學術機構網站等, 通常被認為具有更高的權威性和可信度, 可以賦予更高的抓取優先級。

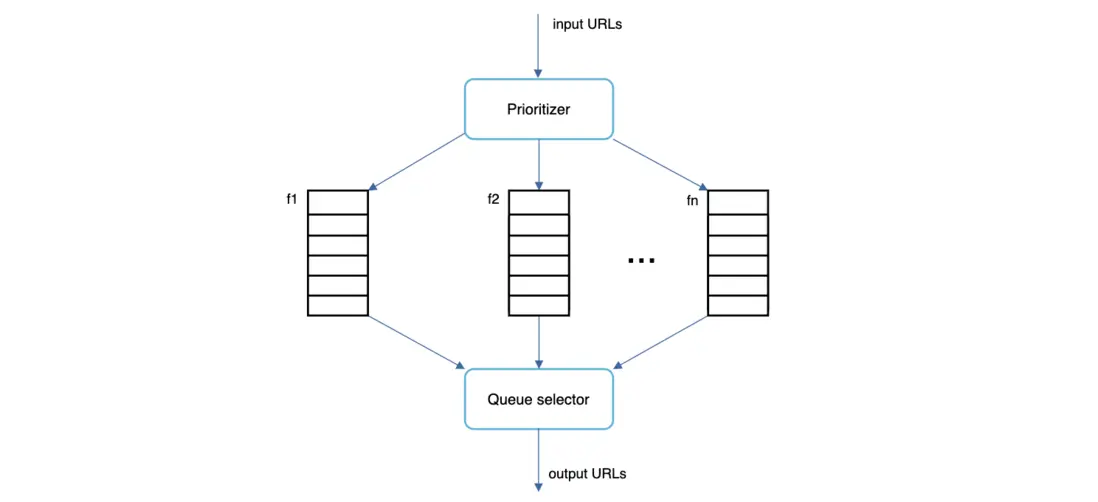

URL 隊列 (URL Frontier) 管理優先級的方案:

這個設計方案的核心思想是 基於優先級對 URL 進行分級管理和調度, 優先調度優先級較高的 URL 進行抓取。 其主要組件包括:

- 優先級 (Priority) 組件: 負責接收 URL 作為輸入, 並根據預設的優先級評估指標, 計算 URL 的優先級分值。

- 優先級隊列 (Queues f1 to fn): 多個優先級隊列, 每個隊列對應一個優先級級別 (例如, 高、中、低)。 根據 URL 的優先級分值, 將其分配到相應的優先級隊列中。 優先級高的隊列, 存儲優先級較高的 URL。

- 隊列選擇器 (Queue Selector): 負責從多個優先級隊列中選擇一個隊列, 供工作線程進行下載。 隊列選擇器 會偏向於選擇優先級更高的隊列, 例如, 可以採用加權輪詢 (Weighted Round Robin) 或優先級調度算法, 確保優先級較高的隊列中的 URL 被優先調度。

通過這種基於 URL 隊列 (URL Frontier) 的優先級管理設計, 網絡爬蟲可以更加智能地進行抓取, 優先抓取更有價值的網頁, 在有限的資源下, 最大化數據採集的價值。

-

URL 隊列 (URL Frontier) 綜合設計: 禮貌性與優先級並重

在實際的網絡爬蟲系統中, 禮貌性 (Politeness) 和 優先級 (Priority) 往往是需要 同時考慮和兼顧 的。 一個優秀的 URL 隊列 (URL Frontier) 設計, 應該能夠同時實現禮貌性訪問和優先級抓取。

URL 隊列 (URL Frontier) 綜合設計方案:

這個綜合設計方案採用了 分層隊列 的架構, 將 URL 隊列 (URL Frontier) 分為 前隊列 (Front Queues) 和 後隊列 (Back Queues) 兩個層次:

- 前隊列 (Front Queues): 優先級管理層。 負責管理 URL 優先級。 URL 首先進入前隊列, 優先級 (Priority) 組件 計算 URL 的優先級, 並根據優先級分值, 將 URL 分配到不同的 優先級隊列 中。 隊列選擇器 (Queue Selector) 根據優先級調度算法, 從前隊列中選擇優先級較高的 URL。

- 後隊列 (Back Queues): 禮貌性管理層。 負責管理 禮貌性訪問。 從前隊列中被選中的 URL, 會被路由到後隊列。 隊列路由器 (Queue Router) 根據 URL 的主機名, 將 URL 分配到不同的 主機隊列 中。 隊列選擇器 (Queue Selector) 根據主機調度算法, 從後隊列中選擇 URL, 供工作線程進行下載。 工作線程 (Working Threads) 最終從後隊列中獲取 URL 進行下載, 並遵守禮貌性原則, 控制訪問頻率。

這種分層隊列的設計, 巧妙地將 優先級調度 和 禮貌性控制 結合在一起, 既能夠保證爬蟲的抓取效率和數據質量, 又能夠確保爬蟲的 “行為文明”, 避免對網站造成不必要的干擾。 是構建高性能、負責任的網絡爬蟲系統的理想選擇。

性能優化策略: 提升抓取效率和系統吞吐量

為了進一步提升網絡爬蟲的性能, 使其能夠應對海量網頁的抓取任務, 有一下系列關鍵的性能優化策略:

-

分佈式爬蟲 (Distributed Crawler): 並行抓取,水平擴展。

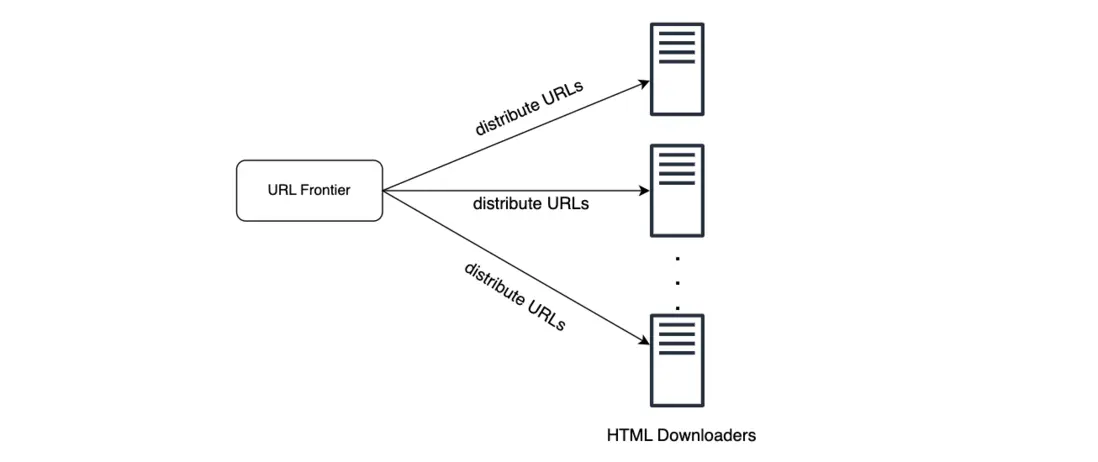

對於大規模的網絡爬蟲系統, 單台服務器的處理能力是遠遠不夠的。 為了充分利用計算資源, 提高抓取效率, 必須採用 分佈式架構, 將爬蟲任務分解並分配到多台服務器上並行執行。 分佈式爬蟲 (Distributed Crawler) 就應運而生。

分佈式爬蟲 通常由多台 爬蟲服務器 (Crawler Servers) 組成, 每台爬蟲服務器 運行着完整的爬蟲組件 (例如 HTML 下載器、URL 隊列、內容解析器等), 共同協作完成抓取任務。 為了實現分佈式抓取, 需要解決以下關鍵問題:

- URL 分片 (URL Sharding): 將海量的 URL 空間劃分為更小的 URL 分片 (URL Shards), 每個爬蟲服務器 負責抓取一部分 URL 分片。 可以使用一致性哈希 (Consistent Hashing) 等算法進行 URL 分片, 保證負載均衡和可擴展性。

- 分佈式 URL 隊列 (Distributed URL Frontier): 需要一個分佈式的 URL 隊列 (URL Frontier), 能夠協調多個爬蟲服務器 的抓取任務, 避免重複抓取和資源競爭。 可以使用分佈式消息隊列 (例如 Kafka, RabbitMQ) 或分佈式數據庫 來實現分佈式 URL 隊列 (URL Frontier)。

- 共享內容存儲 (Shared Content Storage): 多個爬蟲服務器 需要共享同一個 內容存儲 (Content Storage) 系統, 以便存儲抓取到的網頁內容, 並進行內容去重。 可以使用分佈式文件系統 (HDFS) 或對象存儲 來實現共享 內容存儲 (Content Storage)。

- 任務調度與監控 (Task Scheduling and Monitoring): 需要一箇中心化的 任務調度器 (Task Scheduler) 來分配抓取任務, 監控爬蟲服務器的運行狀態, 並進行錯誤處理和故障恢復。 可以使用 ZooKeeper, Kubernetes 等分佈式協調和容器管理工具來實現任務調度和監控。

分佈式爬蟲 能夠充分利用多台服務器的計算能力和網絡帶寬, 實現海量網頁的並行抓取, 顯著提升抓取效率和系統吞吐量。 水平擴展能力也更強, 可以方便地通過增加服務器數量來應對不斷增長的抓取任務。

-

緩存 DNS 解析器 (Cached DNS Resolver): 減少 DNS 查詢,降低延遲。

DNS 解析 (DNS Resolution) 是網絡爬蟲流程中一個潛在的性能瓶頸。 DNS 解析請求可能會耗費一定的時間 (通常在 10ms 到 200ms 之間), 尤其是在 DNS 接口同步的情況下, 爬蟲線程會被阻塞, 直到 DNS 解析完成。 頻繁的 DNS 查詢會顯著降低爬蟲的抓取效率。

為了解決 DNS 解析瓶頸, 可以採用 緩存 DNS 解析器 (Cached DNS Resolver) 技術。 其核心思想是將已解析的 DNS 記錄 緩存 (Cache) 起來, 下次需要解析相同域名時, 直接從緩存中讀取結果, 避免重複進行 DNS 查詢, 從而降低延遲, 提高效率。

緩存 DNS 解析器 (Cached DNS Resolver) 通常使用 內存緩存 來存儲 DNS 記錄, 並設置合理的 緩存失效時間 (Cache TTL)。 當緩存中的 DNS 記錄過期後, 需要重新進行 DNS 解析並更新緩存。 為了進一步提升性能, 可以使用 異步 DNS 解析 (Asynchronous DNS Resolution) 技術, 將 DNS 解析請求 異步化, 避免阻塞爬蟲線程。

-

局部性 (Locality): 就近訪問,縮短網絡傳輸距離。

局部性 (Locality) 原則 是指將分佈式爬蟲系統的各個組件 (例如, 爬蟲服務器、緩存、存儲等) 部署在地理位置上靠近目標網站主機的地區, 儘可能縮短網絡傳輸距離, 降低網絡延遲, 提高下載速度。

例如, 如果要抓取大量的美國網站, 可以將爬蟲服務器部署在美國的數據中心; 如果要抓取大量的歐洲網站, 可以將爬蟲服務器部署在歐洲的數據中心。 局部性 (Locality) 原則 不僅適用於 爬蟲服務器, 也適用於系統的其他組件, 例如 緩存 (Cache)、 存儲 (Storage) 等。 將緩存服務器和存儲服務器也部署在靠近爬蟲服務器的地區, 可以進一步降低數據訪問延遲, 提升系統整體性能。

-

短超時 (Short Timeout): 快速失敗,避免長時間等待。

互聯網上的 Web 服務器 響應速度千差萬別, 有些服務器響應迅速, 而另一些服務器則可能響應緩慢, 甚至根本不響應 (例如服務器宕機、網絡故障等)。 如果爬蟲程序在等待服務器響應時, 長時間阻塞, 將會嚴重降低抓取效率。

為了解決這個問題, 可以採用 短超時 (Short Timeout) 機制。 為 HTTP 請求 設置一個 最大等待時間 (Timeout), 例如幾秒鐘或幾十秒鐘。 如果在預設的超時時間內, 服務器沒有響應, 爬蟲程序就 主動放棄 本次請求, 並嘗試抓取其他頁面, 避免長時間的等待。 短超時 (Short Timeout) 策略 能夠有效地提升爬蟲的魯棒性和效率, 避免被慢速或無響應的服務器 “拖累”。

魯棒性 (Robustness) 增強策略: 保障系統穩定可靠運行

除了性能優化, 魯棒性 (Robustness) 也是構建網絡爬蟲系統至關重要的一環。 一個健壯的網絡爬蟲系統, 必須能夠在各種異常情況下, 保持穩定可靠地運行, 避免因錯誤或異常而崩潰。 設計了一些增強系統魯棒性的關鍵策略:

- 一致性哈希 (Consistent Hashing): 動態伸縮,負載均衡。 一致性哈希 (Consistent Hashing) 算法 用於在 分佈式爬蟲 系統中, 將 URL 分片 (URL Shards) 動態地分配到不同的 下載器 (Downloaders) 服務器上。 與傳統的哈希算法相比, 一致性哈希 (Consistent Hashing) 具有更好的 伸縮性 (Scalability) 和 容錯性 (Fault Tolerance)。 當 下載器 (Downloaders) 服務器數量發生變化 (例如, 新增或移除服務器) 時, 一致性哈希 (Consistent Hashing) 能夠儘量減少 URL 分片 (URL Shards) 的遷移量, 避免大規模的數據遷移, 降低系統負載, 保證系統的平穩運行。 一致性哈希 (Consistent Hashing) 算法 也有助於實現 負載均衡 (Load Balancing), 將 URL 抓取任務 均勻地分配到各個 下載器 (Downloaders) 服務器上, 避免個別服務器負載過高。

- 狀態和數據持久化 (State and Data Persistence): 為了保證爬蟲系統的 可靠性 (Reliability) 和 可恢復性 (Recoverability), 需要將爬蟲的 狀態信息 (State Information) 和 抓取數據 (Crawling Data) 定期 持久化 (Persistence) 存儲到可靠的存儲系統中 (例如, 數據庫、分佈式文件系統)。 狀態信息 包括爬蟲的運行進度、 URL 隊列 (URL Frontier) 的當前狀態、 已訪問 URL 列表等。 抓取數據 包括已下載的網頁內容、 提取出的鏈接等。 當系統發生故障 (例如, 服務器宕機、程序崩潰等) 時, 可以從持久化存儲中 加載 (Load) 保存的狀態和數據, 快速重啓 (Restart) 爬蟲程序, 從中斷點繼續抓取, 避免任務從頭開始, 提高系統的 容錯能力 (Fault Tolerance) 和 恢復速度 (Recovery Speed)。

-

異常處理 (Exception Handling): 優雅處理錯誤,防止系統崩潰。 在大規模的網絡爬蟲系統中, 錯誤 (Errors) 是不可避免的, 也是非常常見的。 網絡連接異常、 服務器響應錯誤、 HTML 解析錯誤、 數據存儲錯誤 等等, 各種錯誤都可能發生。 一個健壯的爬蟲系統, 必須具備完善的 異常處理 (Exception Handling) 機制, 能夠 優雅地 (Gracefully) 處理各種異常情況, 避免因錯誤而導致系統崩潰。 異常處理 (Exception Handling) 通常包括以下幾個方面:

- 錯誤捕獲 (Error Catching): 使用

try-except或try-catch等 異常捕獲機制, 捕獲程序運行過程中發生的各種異常。 - 錯誤日誌 (Error Logging): 將捕獲到的錯誤信息 記錄到日誌 (Log) 文件中, 包括錯誤類型、 錯誤發生時間、 錯誤詳細信息、 發生錯誤的 URL 等。 錯誤日誌 對於 錯誤分析 (Error Analysis)、 故障排查 (Troubleshooting) 和 系統監控 (System Monitoring) 都非常重要。

- 錯誤重試 (Error Retrying): 對於一些 瞬時性錯誤 (Transient Errors), 例如網絡連接超時、 服務器暫時不可用等, 可以嘗試進行 錯誤重試 (Error Retrying), 在等待一段時間後, 重新發送請求。 錯誤重試 (Error Retrying) 可以提高爬蟲的成功率, 減少因瞬時錯誤導致的抓取失敗。 但需要注意 重試次數限制, 避免無限重試, 陷入死循環。

- 錯誤降級 (Error Degradation): 對於一些 非關鍵性錯誤 (Non-critical Errors), 例如 HTML 解析錯誤、 網頁內容提取失敗等, 可以進行 錯誤降級 (Error Degradation) 處理, 例如, 忽略解析錯誤的頁面、 跳過內容提取失敗的頁面, 保證爬蟲程序繼續運行, 而不是因個別錯誤而導致整個系統崩潰。

- 錯誤捕獲 (Error Catching): 使用

-

數據驗證 (Data Validation): 確保數據質量,防止錯誤蔓延。 數據驗證 (Data Validation) 是提高系統 數據質量 (Data Quality) 和 防止系統錯誤 (Preventing System Errors) 的重要措施。 在網絡爬蟲系統中, 需要對多個環節的數據進行驗證, 例如:

- URL 格式驗證: 驗證 URL 格式是否正確、 是否符合 URL 規範。

- HTML 格式驗證: 驗證下載的 HTML 頁面是否是有效的 HTML 文檔, 是否存在語法錯誤或格式錯誤。

- 網頁內容驗證: 驗證提取出的網頁內容是否符合預期, 例如, 檢查正文內容是否為空、 是否包含敏感信息或惡意代碼等。

- 數據存儲驗證: 驗證數據是否成功寫入存儲系統, 數據存儲格式是否正確。

數據驗證 (Data Validation) 可以有效地 預防 (Prevention) 和 檢測 (Detection) 數據錯誤, 保證系統處理的數據是 可靠 (Reliable) 和 有效 (Valid) 的, 從而提高整個系統的 健壯性 (Robustness) 和 可靠性 (Reliability)。

可擴展性 (Extensibility) 設計: 面向未來,靈活擴展功能

隨着互聯網技術的不斷髮展, 網絡環境日趨複雜, 新的內容類型和應用場景層出不窮。 為了應對未來的變化和挑戰, 網絡爬蟲的設計必須具備良好的 可擴展性 (Extensibility), 能夠方便地添加新的功能模塊, 支持新的內容類型, 以適應不斷變化的需求。

文檔強調, 網絡爬蟲系統應該足夠 靈活 (Flexible), 能夠通過 插件式 (Plug-in) 的模塊化設計, 方便開發者 插入 (Plug-in) 新的功能模塊, 擴展爬蟲的功能。 通過模塊化設計, 可以輕鬆地為爬蟲系統添加新的功能模塊, 例如:

- PNG 下載器模塊 (PNG Downloader Module): 如果需要抓取 PNG 圖片文件, 可以開發一個 PNG 下載器模塊, 並將其 插入 (Plug-in) 到爬蟲系統中。 該模塊負責識別 PNG 圖片鏈接, 下載 PNG 圖片, 並進行必要的處理 (例如, 圖片格式轉換、 圖片壓縮等)。

- 域名擴展模塊 (Domain Extension Module): 如果需要監控網絡上的版權和商標侵權行為, 可以開發一個 域名擴展模塊, 並將其 插入 (Plug-in) 到爬蟲系統中。 該模塊負責監控特定域名下的網頁內容, 檢測是否存在侵權行為, 並進行相應的報告和處理。

模塊化設計 (Modular Design) 是實現 可擴展性 (Extensibility) 的關鍵。 通過將爬蟲系統劃分為多個獨立的 模塊 (Modules), 每個模塊負責特定的功能, 模塊之間通過 接口 (Interface) 進行交互。 當需要擴展功能時, 只需要開發新的模塊, 並通過 接口 (Interface) 將其 插入 (Plug-in) 到系統中, 而無需修改核心代碼。 這種 插件式 (Plug-in) 的架構設計, 使得網絡爬蟲系統 易於擴展 (Easy to Extend)、 易於維護 (Easy to Maintain)、 易於升級 (Easy to Upgrade)。

檢測和避免有問題的內容: 提升數據質量,規避風險

在網絡爬蟲的實際應用中, 還需要考慮如何 檢測 (Detection) 和 避免 (Avoidance) 抓取到 有問題的內容 (Problematic Content), 例如 重複內容 (Duplicate Content)、 爬蟲陷阱 (Crawler Traps)、 數據噪音 (Data Noise) 等。 這些有問題的內容, 不僅會降低數據質量, 浪費存儲空間和計算資源, 還可能給爬蟲系統帶來風險 (例如, 陷入無限循環、 抓取到惡意代碼等)。

-

重複內容 (Duplicate Content): 內容去重,節省存儲空間。

如前所述, 互聯網上存在大量的 重複網頁 (Duplicate Pages), 大約 30% 左右的網頁內容是重複的。 抓取和存儲這些 重複內容 (Duplicate Content) 不僅浪費存儲空間, 還會降低數據質量, 影響後續的數據分析和應用效果。 因此, 內容去重 (Content Deduplication) 是網絡爬蟲系統 數據清洗 (Data Cleaning) 的重要環節。

常用的 內容去重 (Content Deduplication) 技術包括:

- 哈希校驗和 (Hash or Checksum): 計算網頁內容的 哈希值 (Hash Value) 或 校驗和 (Checksum) (例如 MD5, SHA-256, Simhash 等)。 將新下載的網頁內容的 哈希值 (Hash Value) 或 校驗和 (Checksum) 與已存儲內容的 哈希值 (Hash Value) 或 校驗和 (Checksum) 進行比較。 如果哈希值或校驗和相同, 則認為內容重複, 可以丟棄。 Simhash 是一種 局部敏感哈希 (Locality Sensitive Hashing) 算法, 特別適用於 網頁文本去重, 即使網頁內容只有輕微的改動, Simhash 也能識別出其相似性。

- 文本相似度比較 (Text Similarity Comparison): 對於文本內容相似度較高的網頁, 可以使用 文本相似度比較算法 進行更精細的去重。 常用的 文本相似度比較算法 包括 Jaccard 係數、 餘弦相似度 (Cosine Similarity)、 編輯距離 (Edit Distance) 等。

-

爬蟲陷阱 (Crawler Traps): 避免無限循環,保護爬蟲資源。

爬蟲陷阱 (Crawler Traps) 是指一些設計不當或惡意構造的網頁結構, 會導致網絡爬蟲陷入 無限循環 (Infinite Loop), 不斷地訪問和抓取無盡的網頁, 浪費爬蟲資源, 甚至導致爬蟲程序崩潰。 常見的 爬蟲陷阱 (Crawler Traps) 包括:

- 無限深度目錄結構: 例如, 形如

http://www.spidertraps.com/foo/bar/foo/bar/foo/bar/...的無限深度目錄結構。 爬蟲程序如果沿着這種鏈接一直抓取下去, 將會永遠無法停止。 - 動態生成無限頁面: 一些網站通過 動態生成 (Dynamically Generate) 網頁的方式, 根據用户的請求參數, 生成無限數量的網頁。 例如, 日曆頁面、 搜索結果頁面等。 如果爬蟲程序不加限制地抓取這些動態生成的頁面, 也可能會陷入無限循環。

避免爬蟲陷阱 (Crawler Traps) 的常用方法包括:

- 限制 URL 最大長度: 對於 URL 長度過長的 URL, 例如超過一定閾值 (例如 2048 字符), 可以認為可能是 爬蟲陷阱 (Crawler Traps), 直接過濾掉。

- 限制抓取深度: 限制爬蟲程序在一個網站內抓取的最大深度 (例如, 最多允許抓取 10 層目錄)。 當達到最大抓取深度時, 停止在該網站的深度抓取, 轉而抓取其他網站。

- URL 模式識別: 通過 URL 模式識別 技術, 識別出 爬蟲陷阱 (Crawler Traps) 常見的 URL 模式, 例如, 包含重複目錄名、 動態參數過多的 URL 等, 並將其過濾掉。

- 人工識別和排除: 對於一些複雜的 爬蟲陷阱 (Crawler Traps), 自動化算法可能難以準確識別。 可以 人工 (Manually) 分析和驗證, 識別出 爬蟲陷阱 (Crawler Traps) 網站, 並將其 排除 (Exclude) 在爬蟲的抓取範圍之外, 或者應用一些 自定義規則 (Custom Rules) 來避免陷入陷阱。

- 無限深度目錄結構: 例如, 形如

-

數據噪音 (Data Noise): 過濾無用信息,提升數據純淨度。

網頁中除了有價值的正文內容, 還常常包含一些對爬蟲來説 價值較低 或 無用 (Useless) 的信息, 例如 廣告橫幅 (Advertisement Banners)、 導航菜單 (Navigation Menus)、 版權聲明 (Copyright Notices)、 代碼片段 (Code Snippets)、 表單 URL (Form URLs) 等等。 這些 數據噪音 (Data Noise) 對於網絡爬蟲的數據分析和應用來説, 通常沒有太多價值, 反而會干擾分析結果, 增加存儲和處理成本。 因此, 儘可能地 過濾 (Filter Out) 這些 數據噪音 (Data Noise), 提升數據純淨度 (Data Purity), 也是網絡爬蟲系統的重要任務之一。

過濾數據噪音 (Filter Data Noise) 的常用方法包括:

- 基於 HTML 標籤的過濾: 根據 HTML 標籤的特點, 識別和移除 數據噪音 (Data Noise) 常見的 HTML 元素, 例如

<script>,<style>,<noscript>,<nav>,<footer>等標籤及其內容。 - 基於 CSS 選擇器的過濾: 使用 CSS 選擇器 精確定位 數據噪音 (Data Noise) 所在的 HTML 元素, 並將其移除。 例如, 使用 CSS 選擇器

#sidebar,.ad-banner,.footer-nav等定位側邊欄廣告、 廣告橫幅、 頁腳導航等元素。 - 基於文本內容特徵的過濾: 根據文本內容的特徵, 識別和移除 數據噪音 (Data Noise), 例如, 識別並移除 版權聲明、 聯繫方式、 法律條款 等文本內容。 可以使用 正則表達式、 關鍵詞匹配、 自然語言處理 (NLP) 等技術進行文本內容特徵識別。

- 機器學習方法: 使用 機器學習 (Machine Learning) 方法, 訓練 數據噪音分類器, 自動識別和分類網頁內容, 將 數據噪音 (Data Noise) 分類為 “無用信息”, 並將其過濾掉。 常用的機器學習算法包括 支持向量機 (SVM)、 樸素貝葉斯 (Naive Bayes)、 深度學習 (Deep Learning) 等。

- 基於 HTML 標籤的過濾: 根據 HTML 標籤的特點, 識別和移除 數據噪音 (Data Noise) 常見的 HTML 元素, 例如

總結

構建一個優秀的、可擴展的網絡爬蟲系統, 絕非易事。 正如文檔總結所言, 一個好的網絡爬蟲需要具備以下關鍵特徵:

- 可擴展性 (Scalability)

- 禮貌性 (Politeness)

- 可擴展性 (Extensibility) (功能上的可擴展性)

- 魯棒性 (Robustness)

構建一個可擴展的網絡爬蟲, 需要綜合運用各種技術和策略, 並不斷進行優化和改進。 互聯網的複雜性和動態性, 也為網絡爬蟲設計帶來了持續的挑戰。

參考資料

ByteByteGo