面向課堂與自習場景的智能坐姿識別系統——從行為感知到可視化部署的完整工程【YOLOv8】

一、研究背景:為什麼要做“坐姿識別”?

在信息化學習與辦公環境中,久坐與不良坐姿已成為青少年與上班族普遍面臨的健康問題。長期駝背、前傾、低頭等坐姿行為,容易引發:

- 脊柱側彎、頸椎病

- 注意力下降、學習效率降低

- 視覺疲勞與肌肉勞損

傳統的坐姿管理主要依賴人工監督或簡單硬件傳感器,不僅成本高、實時性差,而且難以規模化推廣。

隨着計算機視覺與深度學習技術的發展,基於攝像頭的坐姿自動識別系統逐漸成為一種可行且低成本的解決方案。

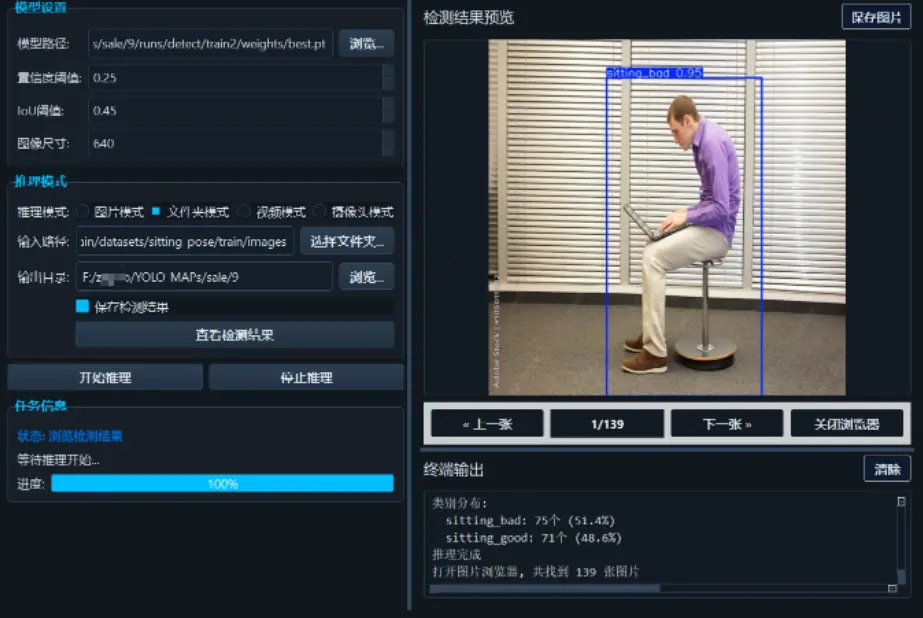

本文將介紹一個 基於 YOLOv8 的智能坐姿檢測系統,實現對 標準坐姿 / 不良坐姿(駝背) 的自動識別,並通過 PyQt5 構建完整圖形化應用,實現從模型訓練到終端部署的完整閉環。

源碼下載與效果演示

嗶哩嗶哩視頻下方觀看:

https://www.bilibili.com/video/BV1R578zKE3o

包含:

📦完整項目源碼

📦 預訓練模型權重

🗂️ 數據集地址(含標註腳本)

二、系統總體設計與技術路線

2.1 系統設計目標

本系統的核心設計目標包括:

- 🎯 實時識別學生或用户坐姿狀態

- 🎯 支持圖片、視頻、攝像頭等多輸入源

- 🎯 檢測結果可視化、可保存

- 🎯 非算法人員也可直接使用

2.2 技術架構概覽

系統整體採用“檢測模型 + 圖形界面 + 推理引擎”的三層結構:

輸入端(圖片 / 視頻 / 攝像頭)

↓

YOLOv8 坐姿檢測模型(2 類)

↓

姿態判定結果(good / bad)

↓

PyQt5 GUI 實時展示與結果保存三、核心功能模塊説明

3.1 多模式坐姿檢測

系統支持以下幾種使用方式:

| 功能模式 | 説明 |

|---|---|

| 單圖檢測 | 適合樣本分析與測試 |

| 文件夾檢測 | 批量評估坐姿數據 |

| 視頻分析 | 行為回放與統計 |

| 攝像頭實時檢測 | 實時提醒與監控 |

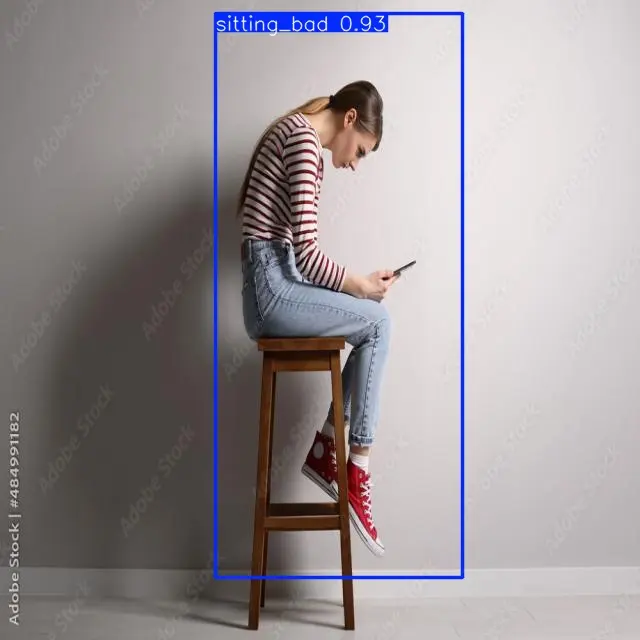

3.2 坐姿類別定義

當前系統聚焦於最具實用價值的兩類坐姿狀態:

sitting_good:標準坐姿sitting_bad:不良坐姿(駝背 / 前傾)

該設計有利於提升模型穩定性,並便於後續擴展更多姿態類型。

四、YOLOv8 在坐姿檢測中的應用優勢

4.1 為什麼選擇 YOLOv8?

YOLOv8 是 Ultralytics 推出的新一代目標檢測模型,在本項目中主要優勢體現在:

- 🚀 推理速度快,適合實時攝像頭場景

- 🎯 Anchor-Free 架構,對姿態變化更魯棒

- 🧠 訓練與部署流程高度工程化

- 🔌 原生支持 ONNX / TensorRT 導出

4.2 坐姿檢測的建模思路

與傳統“關鍵點姿態估計”不同,本項目採用:

基於目標檢測的坐姿狀態判定

即:

通過檢測人體上半身整體姿態區域,直接輸出“坐姿類別”,在實時性與工程複雜度之間取得良好平衡。

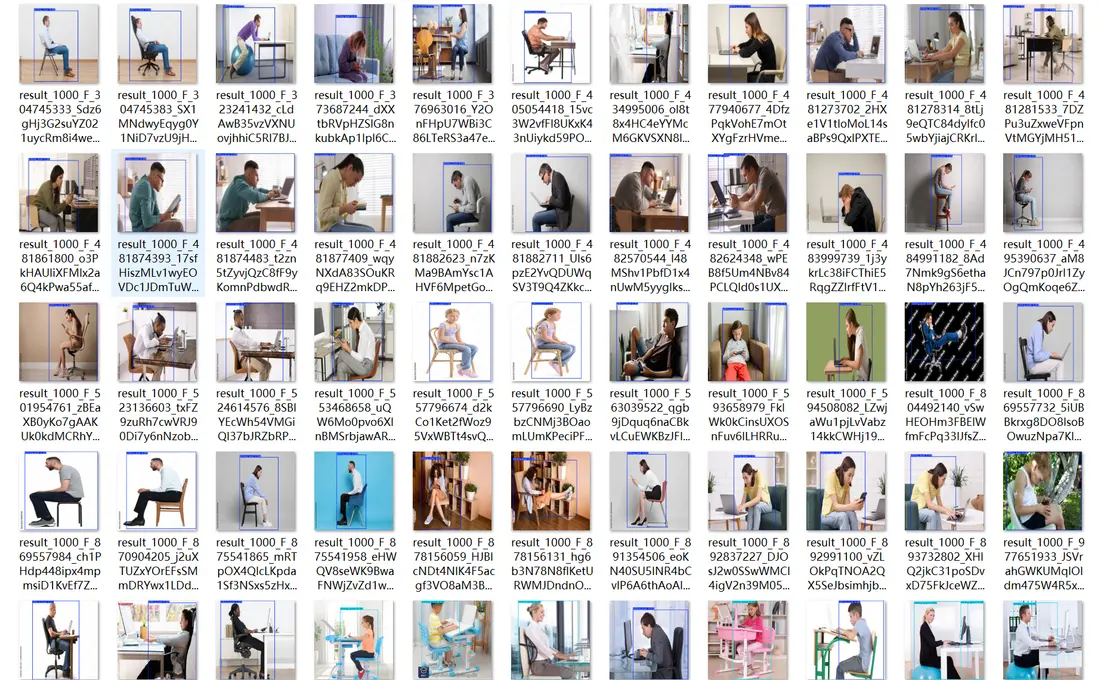

五、數據集構建與標註規範

5.1 數據來源與特點

訓練數據主要來源於:

- 教室與居家學習場景

- 不同光照與拍攝角度

- 多種身高、坐姿習慣

確保模型在真實環境中的泛化能力。

5.2 數據集組織結構

採用 YOLO 標準數據格式:

dataset/

├── images/

│ ├── train/

│ └── val/

├── labels/

│ ├── train/

│ └── val/標籤格式示例:

0 0.51 0.36 0.39 0.32類別定義:

nc: 2

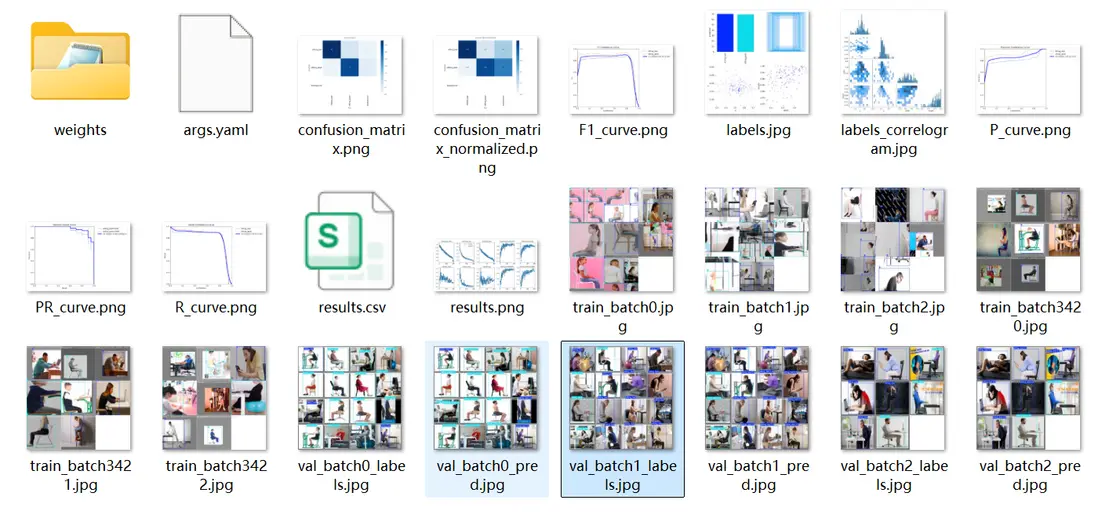

names: ['sitting_bad', 'sitting_good']六、模型訓練與性能評估

6.1 訓練流程

模型訓練基於 Ultralytics YOLOv8 官方接口,核心命令如下:

yolo detect train \

model=yolov8n.pt \

data=data.yaml \

epochs=100 \

batch=166.2 訓練指標分析

訓練過程中重點關注:

box_loss:人體區域定位能力cls_loss:坐姿類別區分能力mAP@0.5:整體檢測性能

當驗證集 mAP@0.5 超過 90%,模型即可用於實際部署。

七、模型推理與結果展示

7.1 推理代碼示例

from ultralytics import YOLO

model = YOLO("best.pt")

results = model("test.jpg", conf=0.25, save=True)7.2 輸出結果説明

推理結果包含:

- 坐姿類別(good / bad)

- 置信度評分

- 邊界框位置

- 自動保存的標註圖像

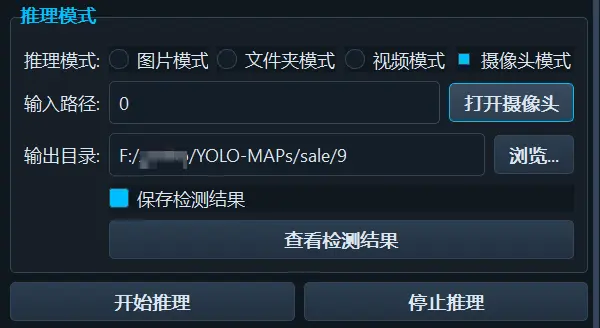

八、PyQt5 圖形界面實現

8.1 GUI 設計理念

圖形界面遵循以下原則:

- 🖱️ 零命令行操作

- 👨🏫 面向教育與日常用户

- ⚡ 實時刷新、低延遲

- 💾 支持結果留存與複查

8.2 實時檢測流程

攝像頭檢測流程如下:

- 獲取視頻幀

- YOLOv8 推理

- 繪製檢測框

- 實時顯示與存儲

系統運行穩定,適合長時間使用。

九、應用場景與拓展方向

9.1 典型應用場景

- 📚 智能教室坐姿管理

- 🧑💻 辦公久坐健康監測

- 🏫 校園行為規範系統

- 🧪 行為識別相關科研實驗

9.2 可擴展方向

- 增加低頭、側身等細分類別

- 融合關鍵點姿態估計模型

- 接入聲音或消息提醒機制

- 部署至邊緣設備(Jetson / RK)

十、總結

本文介紹了一個 基於 YOLOv8 的智能坐姿識別系統,從數據集構建、模型訓練到 PyQt5 圖形化部署,完整展示了一個計算機視覺項目的工程化落地過程。

該系統具備以下特點:

- ✅ 結構清晰、易復現

- ✅ 實時性強、部署成本低

- ✅ 適合教學、科研與實際應用

- ✅ 支持二次開發與功能擴展

在“智慧校園”“健康辦公”等應用背景下,此類基於視覺的行為識別系統具有廣闊的落地空間和實踐價值。