一、簡要介紹

快速發展的大型多模態模型(LMMs)領域催生了多種具有顯著能力的模型。然而,現有的評估標準未能全面、客觀且準確地評估這些模型是否能滿足現實世界中人類的多樣化需求。為了解決這一問題,論文提出了多維度洞察(MDI)基準,該基準包含超過500張圖像,涵蓋了人類生活的六個常見場景。值得注意的是,MDI基準相比現有評估方法具有兩大優勢:(1)每張圖像都附有兩類問題:簡單問題用於評估模型對圖像的理解,複雜問題則用於評估模型分析和推理超出基本內容的能力。(2)考慮到不同年齡段的人在面對相同場景時有不同的需求和視角,論文的基準將問題分為三個年齡組:年輕人、中年人和老年人。這一設計能夠詳細評估語言模型在滿足不同年齡羣體偏好和需求方面的能力。通過MDI基準測試,像GPT-4這樣的強大模型在與年齡相關的任務上達到了79%的準確率,這表明現有的語言模型在解決實際應用問題上仍有很大的提升空間。展望未來,論文預計MDI基準測試將為語言模型中的現實個性化提供新的方向。

二、研究背景

開發個性化的人工智能助手以滿足不同用户的需求,一直是人類的重要追求。在實際應用中,理想的AI輔助工具應能精準滿足不同年齡層、文化背景和職業領域用户的特定需求。

近年來,人工智能領域經歷了重大變革,從專注於特定簡單任務的小型模型轉向能夠處理複雜任務的統一大型多模態模型(LMMs)。這一轉變不僅標誌着向通用人工智能(AGI)邁進的關鍵一步,也凸顯了LMMs成為個性化人類助手的巨大潛力。

為了全面評估語言模型(LMMs)的能力,研究人員構建了多個常見的視覺問答基準測試,這些測試旨在評估LMMs的圖像-文本理解和對話能力。然而,這些基準測試僅限於與標準答案的對比,對模型細粒度能力的洞察有限。為了解決這一問題,後續開發了多模態理解基準測試,這些測試覆蓋了更廣泛的任務和更多的測試樣本。這種改進使得模型能力的評估更加精確,促進了更穩健的LMMs的發展。然而,當前的基準測試主要關注特定任務的技術指標,忽視了兩個關鍵的研究問題。

Q1:這些語言模型(LMMs)是否能夠真正滿足現實世界中人類的實際需求?

Q2:這些語言模型能否解決不同羣體的多樣化需求?

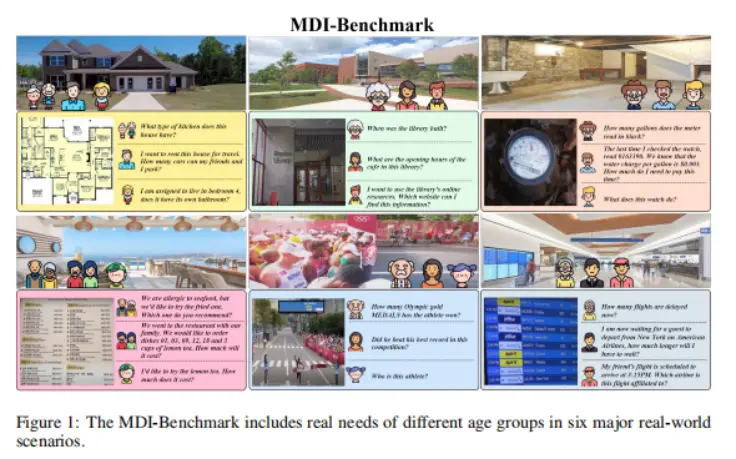

為了解決這些問題,論文引入了一個新的“多維度洞察”(MDI)基準測試,該測試涵蓋了多種現實場景、不同的問題複雜度以及不同年齡段的人羣。具體來説,MDI基準測試包括超過500張真實世界的圖像和1200個與人相關的題目。如圖2所示,它涵蓋了人類生活的六大領域:建築、教育、家務、社會服務、體育和交通。此外,MDI基準測試還從兩個方面評估了語言模型:

問題複雜度維度。這一維度將人類面臨的問題分為兩個複雜度等級。第一級評估了LMMs(語言模型)的基本能力,如物體檢測和光學字符識別(OCR)等。第二級則評估了更復雜的技能,包括邏輯推理、數學計算和知識應用。

年齡維度。年齡是評估個體差異的基本標準,因為不同年齡段的人有不同的需求。論文將個人分為三個年齡段:年輕人、中年人和老年人,以評估LMMs在滿足這些羣體不同需求和偏好的有效性。論文的目標是全面評估LMMs是否能在實際情境中滿足人類的多樣化需求。

總結來説,論文的主要貢獻包括:

•為了滿足人類對大型多模態模型的實際需求,論文首次提出了一個多模態基準,旨在全面評估LMMs在實際場景中的表現。

•MDI基準集包含超過500張真實世界圖像和1200個由人類設計的問題,涵蓋了六個真實的多模態場景。每個場景分為三個子領域,每個子領域又分為兩個複雜度級別。此外,論文在評估中加入了年齡因素,以幫助LMMs為不同的人口羣體提供個性化的響應。

•通過MDI基準集,論文對幾種主流的LMMs進行了全面的評估。具體而言,GPT-4o在所有指標上都取得了最佳成績,但在滿足不同年齡段的需求方面仍有很大的提升空間。進一步分析情景、複雜度和年齡等因素,為開發可靠且個性化的智能助手提供了寶貴的見解。

作者希望論文的研究能夠推動多模態大型模型在現實世界中的應用,併為多維個性化的發展鋪平道路。

三、相關工作

3.1 多模態數據集與基準測試

為了評估語言模型(LMMs)的能力,研究者們採用了多種來自過往研究的基準測試。其中,Flickr30k和Nocaps用於評估LMMs的文本生成和圖像描述能力。Vizwiz、VQA、GQA和OK-VQA則用於評估LMMs對圖像信息的理解和問答能力。為了評估OCR能力,研究者們使用了ST-VQA和OCR-VQA等基準測試。DocVQA專門用於評估模型理解並識別文檔的能力。

為了進一步探索LMMs的細粒度能力,最近的基準測試顯著擴展了評估任務的種類。例如,LVLM-eHub、MMVet、MMBench、SEED-Bench、MME、MMT-Bench、Video-MME、MMMU、MMMU-Pro、MathVista、Mathverse、We-Math和MMEvol。然而,這些基準測試尚未完全探索LMMs解決不同個體多樣化需求的能力。因此,論文希望通過MDI基準測試更好地探索這一能力。

3.2 大型多模態模型

基於大型語言模型(LLMs)的成功,近期研究將大型語言模型與視覺編碼器結合,開發出具有強大視覺理解和語義生成能力的LMMs。許多優秀的開源項目和閉源項目已經開發出來。這些進展進一步提升了實現個性化AI助手的潛力。

3.3 個性化研究

為了實現個性化的AI助手,大型語言模型(LLMs)正嘗試與用户的個性化輸出相結合,以增強其個性化能力,並生成符合用户偏好的輸出。同時,為了進一步提升LLMs在面對不同需求時的理解能力,個性化數據生成也顯得尤為重要。在本研究中,論文利用MDI基準評估現有大型多模態模型解決個性化需求的能力,併為未來LMMs的研究提供見解。

四、MDI基準

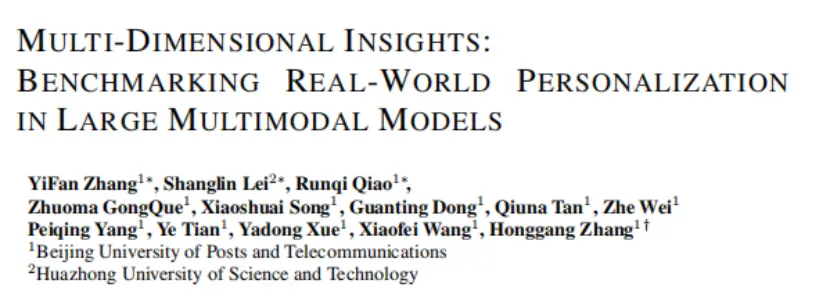

MDI-Benchmark的樣本設計強調了信息的真實複雜性、場景的多樣性和年齡差異。人們的信息關注點會因具體情境而異。如圖1所示,家庭在購買新房時,可能會特別關注與他們生活緊密相關的實際問題,比如廚房類型、車庫容量和卧室設施。而在體育賽事中,觀眾則可能更關注比賽細節、運動員的表現和比賽進程。

4.1 評估維度

與現有的評估方法相比,MDI-Benchmark更加註重模型在特定任務場景中,針對不同年齡層和複雜度的實際問題上的表現,其評估結構圍繞三個維度展開:場景、年齡和問題複雜度。從場景的角度來看,MDI-Benchmark力求貼近人類生活的實際需求。與以往基於能力評估的LMMs評估基準不同,MDI-Benchmark是基於現實生活中的具體場景構建的。

從情景的角度來看,MDI-Benchmark旨在貼近人類生活的實際需求。與以往LMMs評估基準側重於能力評估不同,MDI-Benchmark是基於現實生活中的各種場景構建的。

針對人們在現實生活中遇到的各種情境,論文參考了社會學文獻中的定義,並在此基礎上擴展,確定了30個子領域的情景。為此,論文進行了一次為期一個月的問卷調查,覆蓋了不同年齡、性別和職業的人羣。共發放了2500份問卷,收集到了2374份有效回覆。根據問卷中子領域選擇的頻率,論文選出了前18個子領域,最終歸納為六個主要場景:建築、教育、家務、社會服務、體育和交通。論文從這些子領域中收集了圖像,確保該基準具有豐富的場景信息。

問題複雜度維度。在日常人類活動中,複雜程度差異顯著,難度的定義往往具有主觀性。為了簡化這一定義,論文基於模型的基本能力,將問題分層量化為原子單位。根據這一標準,論文篩選了調查問題,並優化了之前的評估標準。此外,MDI基準分為兩個層次:

(1)第一層次涉及相對簡單的問題類型,主要評估模型提取場景信息的能力,包括檢測、光學字符識別、位置識別、顏色識別等基本功能。

(2)第二層次要求模型能夠熟練地分析場景信息和用户語義信息,具備邏輯敏鋭度,同時整合相關知識,有效滿足用户需求。

年齡維度。年齡作為羣體分類的普遍且具體的準則,比基於文化和宗教信仰的分類更為客觀。作為每個人的基本屬性,年齡易於量化和比較。通過將年齡作為分類標準,論文能夠更好地理解不同羣體的需求,並評估LMMs(語言模型)滿足這些多樣化需求的能力。為了評估和量化,論文確定了三個不同的年齡組:年輕人(10-25歲)、中年人(35-50歲)和老年人(60-75歲)。論文讓這些年齡段的人蔘與實際生活場景,瞭解他們的需求。這些調查結果為MDI-Benchmark(多維度指標基準)的初步版本的創建提供了依據。

4.2 數據收集

數據來源。現有的LMMs評估基準已被廣泛用於評估和訓練新模型。為了確保評估結果的準確性,論文收集了超過500張未包含在現有數據集中的新圖像,並從三個年齡組中招募了120名志願者。每個年齡組中,論文抽取了10名志願者,組成一個30人的數據構建團隊。主要的數據收集過程如下:首先,在確定場景維度信息後,數據構建團隊根據自己的興趣編寫了詳細的場景信息。同時,論文將這些場景維度信息輸入到開源模型(如GPT-4o、Gemini 1.5 Pro)和閉源模型(如LLaVA-Next、MiniCPM)中,以生成更加個性化、多樣性和詳細的場景描述。此外,由人類和模型創建的描述被用作關鍵詞,在互聯網上搜索相關圖像。同時,論文支付給志願者的工資相當可觀,大約每小時七美元。這些志願者的任務是將圖像分類到六個不同的場景維度中。為了確保數據平衡並減少偏見,論文在每個年齡段的性別、職業等方面都保持了多樣性。論文提供了詳細的分類標準和指南,以確保分類的一致性。論文采用了交叉驗證的方法,即每組志願者都會對圖像進行篩選,只保留那些被所有三個小組一致分類的圖像。此外,論文還進行了多次驗證迭代。這一全面的過程有助於構建一個平衡且可靠的數據源。

問題與答案的生成。在收集到圖像後,論文采用啓發式方法手動生成問題和難題。具體步驟如下:(1)構建知識庫。首先,利用多種開源和閉源模型描述圖像中的場景內容,並由專家進行總結。接着,通過網絡搜索獲取更多與場景內容相關的信息,將這些信息與圖像結合,形成知識庫。(2)生成多選題。為了確保生成的問題與圖像內容的一致性,論文邀請了三個不同年齡段的志願者參與數據收集階段,提交問題。這些志願者根據圖像場景和知識庫內容提出了不同難度的問題,並設計了令人困惑的錯誤選項。(3)問題格式。志願者提供的圖像-問題對必須遵循以下格式:[級別]-[年齡]-[場景]。其中,級別分為1級和2級;年齡分為老年、中年和年輕;場景包括建築、教育、家務、社會服務、體育和交通。最後,由專家團隊對志願者提交的問題進行了篩選和評估,以最終確定問題的構建。

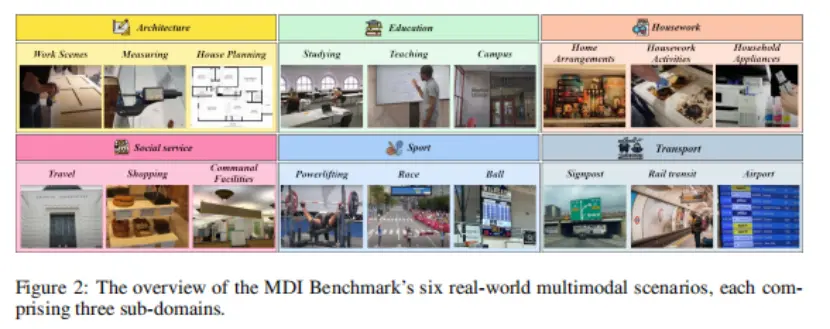

數據統計。MDI基準測試從三個維度收集數據:場景、年齡組和能力。該測試包含514張圖像和1298個問題,所有內容均為新收集。同時,論文努力確保在不同場景、年齡和問題複雜度之間保持數據的平衡。詳細信息見表1。如圖1所示,數據集涵蓋了六個領域,每個領域下設三個子領域,構建了一個全面且結構化的數據體系,覆蓋了多個領域。

五、實驗

5.1 實驗設置

評估協議。為了有效評估模型的輸出,要求模型在響應中提供正確的答案。基於此,計算了響應的準確性。這意味着,如果模型能夠正確表達概念但未能給出精確答案,則會被視為錯誤。這種方法強調了模型準確執行指令的能力,突出了其在這一能力上的不足。此外,由於不同模型的提示輸入格式各不相同,論文對每個模型的輸入格式進行了調查。隨後,論文努力保持提示的一致性,遵循每個模型提供的官方輸入格式。這種方法旨在減少提示差異對模型性能的影響。

提示模板。表4列出了論文實驗中使用的提示模板。

評估模型。論文研究了兩類基礎模型在MDI基準上的表現。

(a)閉源模型:GPT-4o、GPT-4V、Qwen-VL-Plus、Gemini 1.5 Pro;

(b)開源模型:LLaVA-NeXT-110B、LLaVA-NeXT-70B、LLaVANeXT-7B、DeepSeek-VL-7B、DeepSeek-VL-1.3B、Phi3-Vision- 4.2B、MiniCPM-LLaMA3-V 2.5、CogVLM-chat、CogAgent-vqa、mPLUG-Owl2-7B。

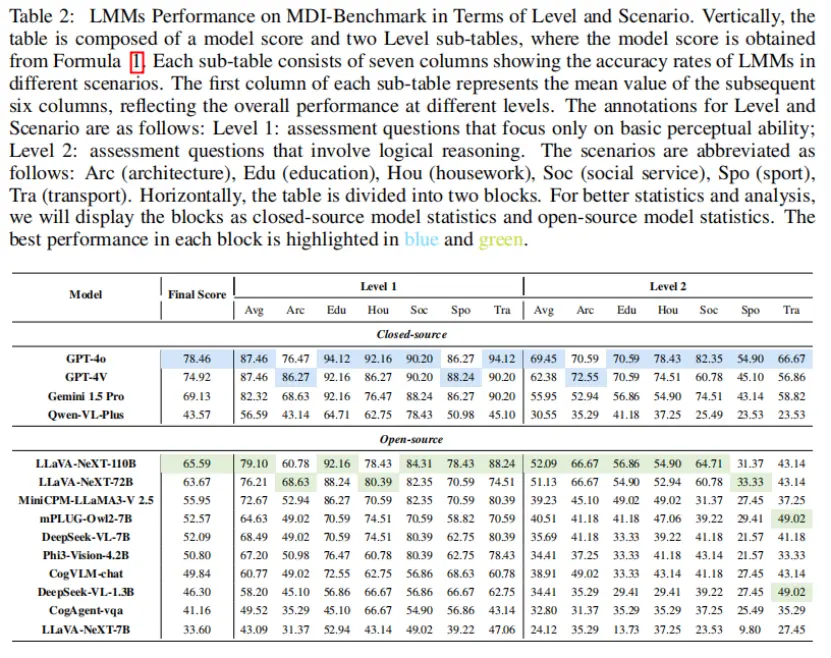

評分指標。表2展示了不同語言模型在兩種問題複雜度水平和六個場景下的整體性能。為了更好地評估模型的能力,論文定義了評分指標:

其中,

和

分別代表LMMs在不同領域第一層級和第二層級的平均表現,論文把默認值α設為0.5。

5.2 主要結果

表2展示了不同語言模型在MDI基準測試中的整體表現。論文發現以下幾點:

GPT系列模型表現出絕對優勢。GPT-4o在所有模型中表現最佳,獲得了最高性能評分。此外,閉源模型普遍優於開源模型。然而,一些強大的開源模型在追趕閉源模型方面遇到了困難。例如,LLaVA-NeXT-110B和LLaVA-NeXT-72B的表現略遜於Gemini 1.5 Pro,但優於Qwen-VL-Plus。

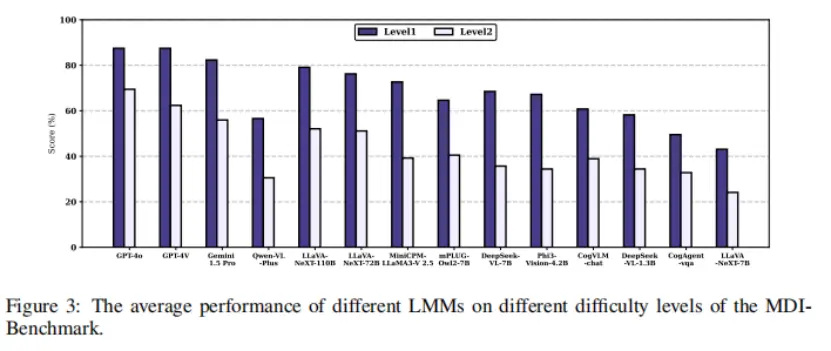

模型性能的規模效應。此外,由於閉源模型數據有限,論文在開源模型中觀察到了一些有趣的現象。論文選擇了不同規模下表現最佳的開源模型,包括LLaVA-NeXT-110B、LLaVA-NeXT-72B、MiniCPM-LLaMA3-V 2.5、DeepSeek-VL-7B、Phi3-Vision-4.2B和DeepSeek-VL-1.3B。如圖4所示(不同LMMs的排行榜),這些模型的最終得分表明,模型參數越大,其在實際場景中解決問題的能力就越強。這與人類的經驗一致:更大的語言模型參數意味着更多的文本邏輯訓練樣本,減少了模型蒸餾的需要。面對更復雜的邏輯推理任務時,這些模型能夠利用更多的底層知識和基本能力。

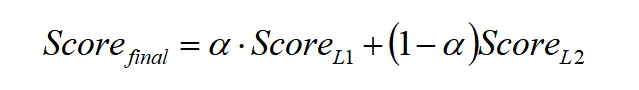

5.3 場景維度分析

LMMs在日常場景中的表現仍有很大的提升空間。為了觀察不同模型在各種場景中的具體表現,如圖3所示,論文計算了不同模型在不同領域的準確率。結果顯示,這14種LMMs在教育場景的Level 1中表現優異。在建築、家務、交通和社會服務場景中,這些模型的表現更加均衡。然而,在體育場景中,LMMs的表現存在一些不足,論文認為這與當前LMMs的訓練數據密切相關。目前,LMMs研究團隊主要致力於利用現有的互聯網文本數據和高質量的教科書數據,提升訓練和測試的質量,但忽視了日常生活領域數據集和能力的改進。MDI基準的出現正是為了彌補這一不足。論文認為,邏輯推理問題的類型及其在體育和交通領域的背景知識比建築領域更為豐富和廣泛,這導致了問題難度的增加和推理性能上的顯著差距。

5.4 複雜性維度分析

隨着問題複雜性的增加,模型的性能顯著下降。同一模型在不同場景中的回答準確性也會顯著變化。例如,在GPT-4o的最佳教育場景中,其準確率從94.12%降至70.59%。這表明問題複雜性對模型性能有顯著影響。

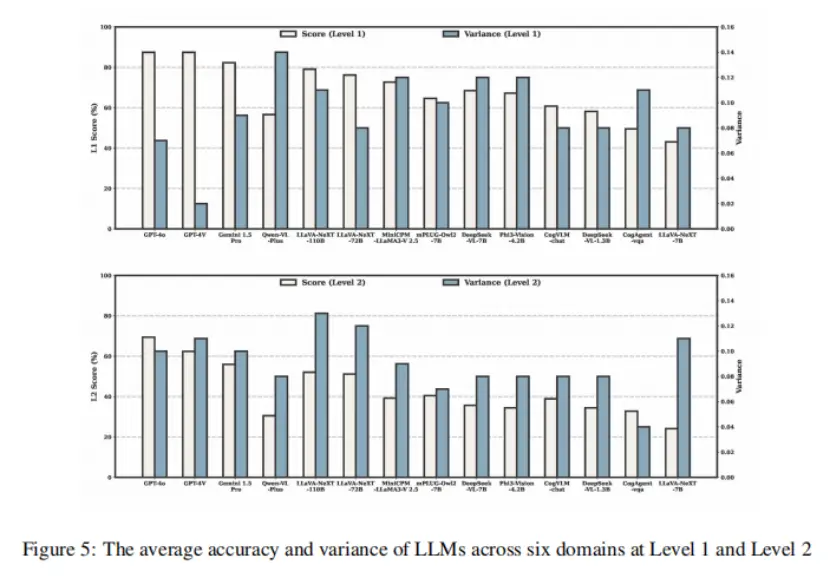

問題的複雜性在不同場景中展現了豐富的概括多樣性。為了分析這些語言模型(LMMs)在多個層級上的詳細表現,論文製作了雷達圖(圖4),展示了14個LMMs在一級和二級不同場景下的表現。為了展示不同問題複雜度對宏觀性能變化的影響,論文還生成了性能方差和總和的統計數據,將平均值和方差數據分別繪製在不同的軸上,以突出宏觀趨勢(圖5)。通常,平均值高且方差低的模型表現出更優和更全面的能力。

在一級考察中,大多數模型表現出平衡的性能,如圖4所示。值得注意的是,CogAgent-vqa和LLaVA-NeXT-7B等模型表現出明顯的例外。在二級考察中,GPT-4o的方差顯著增加,只有GPT系列和Gemini 1.5 Pro保持了平衡的性能。如圖4所示,只有GPT系列顯示出輕微的性能下降,而其他LMMs在體育場景中則出現了急劇的性能下降。

與高級閉源語言模型相比,開源語言模型需要在特定的日常生活能力和複雜問題場景上進行更多的研究,以縮小顯著的差距。值得注意的是,如圖5所示,LLaVA-NeXT-72B在第2級的表現與最優模型LLaVA-NeXT- 110B相似,但方差有所減少,這表明通過有效的蒸餾技術實現更好的性能和更小的參數是一個值得進一步探索的領域。

論文認為,研究社區在這些領域的數據集和能力提升上缺乏關注,加上邏輯推理和所需背景知識的多樣化和廣泛性,比簡單任務更為顯著。這種多樣性導致模型在推理性能上的差距隨着問題複雜性的增加而顯著擴大。因此,需要進一步的研究來解決這些問題,並提高LMM在複雜問題場景中的表現。

5.5 年齡維度分析

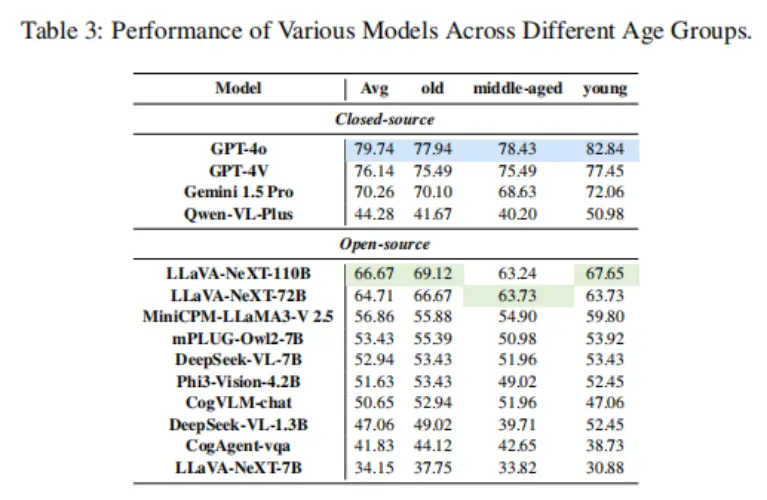

為了進行更直接和宏觀的性能分析,論文在主表中僅展示了平均性能統計數據,如表3所示,主要反映了LMMs在三個年齡分層中的表現。此外,論文還根據年齡組和場景維度詳細分析了模型的性能,詳見附錄D。論文有以下觀察結果。

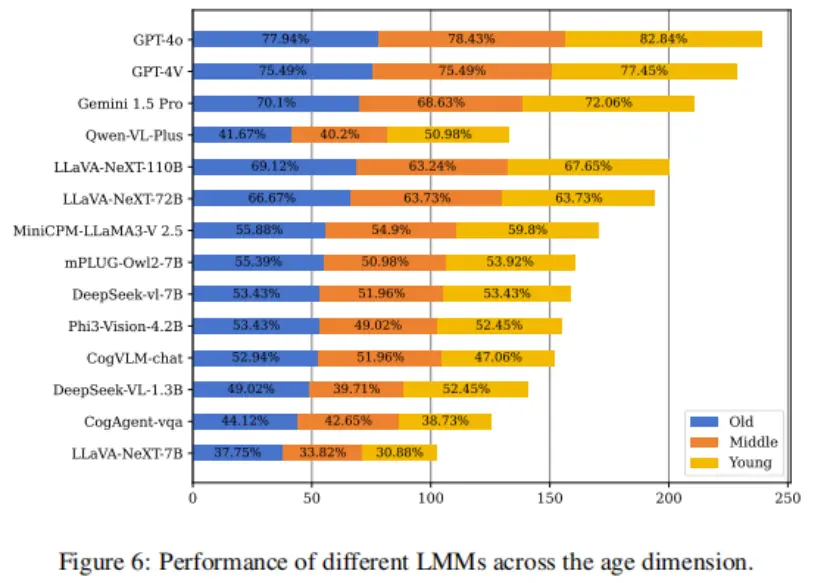

所有模型都遵循了水平評估的維度,但不同年齡段的表現存在差異。如表3所示,GPT-4o在年齡維度上依然表現最佳,比排名最高的開源模型高出13分,比排名最低的閉源模型高出35分。這種在年齡分層評估中的顯著優勢,突顯了GPT-4o強大的泛化能力和在日常使用場景中的領導地位。然而,從年齡維度評估模型的能力時,可以洞察該模型在不同羣體和各種現實場景中的有效性。鑑於個人在日常生活中會遇到多種情況,模型的能力必須全面,以滿足多樣化的人類需求。觀察到不同年齡段的準確性下降,這表明所有模型在這一方面還有很大的提升空間。這一發現強調了進一步研究年齡相關問題的重要性,並突顯了論文工作的必要性和創新性。

模型在不同年齡層的總體泛化能力不足。如圖6所示,論文進一步展示了模型在老年、中年和年輕三個年齡段的表現。通過彙總各年齡段的模型結果,論文發現老年組的總分為856.38,中年組為764.72,年輕組為902.94。這一分佈揭示了不同年齡段問題的實際難度順序:中年組>老年組>年輕組。在實際應用中,中年人提出的問題往往涉及更多方面,需要更強的邏輯推理和背景知識,而老年人或年輕人提出的問題則相對簡單。因此,多模態語言模型需要具備強大的綜合能力,以有效應對這類問題。GPT-4o在這方面表現出色,所有三個與年齡相關的類別中的性能差距都很小。有趣的是,儘管Cog系列模型擁有最大的視覺編碼器,但在年輕組的表現卻明顯下降,這表明其大型視覺編碼器的泛化能力不如CLIP-ViT/L14。

在時間維度上,語言模型的擴展性能顯著,但模型壓縮展現出巨大潛力。論文發現,在每個模型層中,語言模型參數最多的模型表現最佳。實證研究表明,語言模型在語言模型模型(LMMs)中的作用比視覺編碼器更為重要。此外,論文驚訝地發現,Phi3- Vision-4.2B僅使用約4.2B參數,其宏觀性能就超過了閉源模型Qwen-VL-Plus。這表明,LMMs在模型參數壓縮方面仍有很大的探索空間。

六、結論

本文中,論文提出了MDI基準測試,這是一種評估大型多模態模型(LMMs)在多維度場景中解決實際人類需求能力的工具。該基準測試包含超過500張圖像和1200個相關需求,涵蓋了人類生活的六大方面。此外,論文引入了年齡分層和基於老年人、中年人及年輕人需求的抽樣問題,以確保評估的全面性。通過MDI基準測試,論文對14種現有的LMMs進行了評估,揭示了它們在不同場景下的表現偏好。儘管GPT-4o在多個指標上表現最佳,但在所有年齡組和場景中仍存在性能差距。因此,論文建議未來的研究應着重於提高LMMs對人類需求的適應性及其在不同領域和年齡組中的泛化能力。這將為下一代能夠有效滿足人類需求的LMMs鋪平道路。