Spark

Apache Spark是一個多語言引擎,用於在單節點機器或集羣上執行數據工程、數據科學和機器學習。

https://spark.apache.org/

Spark環境搭建

1: 下載spark,解壓後放到了sparks3.5.5目錄中

https://spark.apache.org/downloads.html

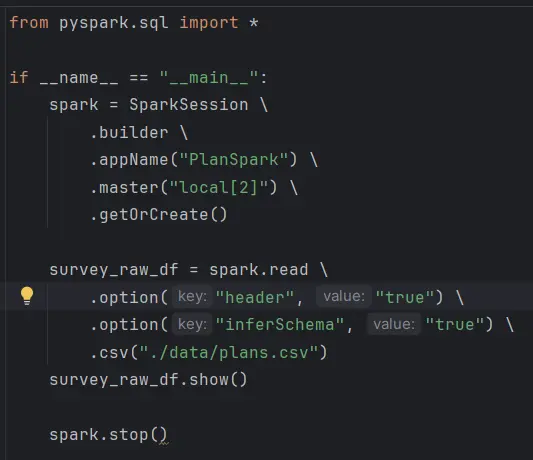

並添加環境變量

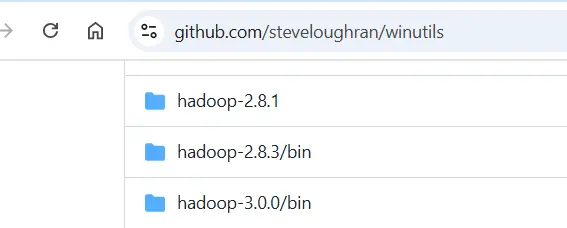

2:訪問https://github.com/steveloughran/winutils,下載hadoop-3.0.0/bin,

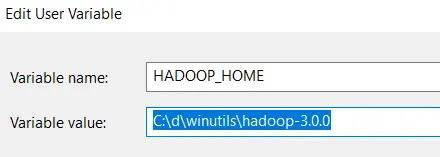

把它解壓放到了C:\d\winutils\目錄中,並

添加了HADOOP_HOME,設置的值是C:\d\winutils\hadoop-3.0.0,然後編輯環境變量Path,把兩個bin目錄放到Path環境變量的值中

注意: Spark目前不能和高於Java11的版本很好兼容,為了搭建環境,我把java 版本改為了openlogic的11.

在把下載來的java解壓到某個目錄後,加上JAVA_HOME變量,並把%JAVA_HOME%\bin目錄也加到Path目錄後,可以新開cmd窗口查看JAVA 設置是否生效 Java -version

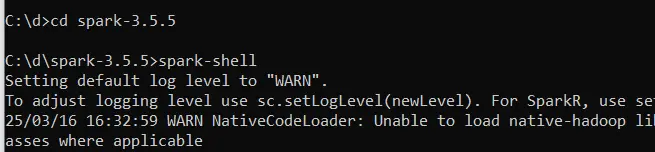

啓動spark:

check pyspark:

Pycharm可以用來作為開發工具來開發spark相關應用, 具體的只要裝上pyspark( pip install pyspark==3.5.5),就可以創建python工程來訪問搭建好的spark環境了。

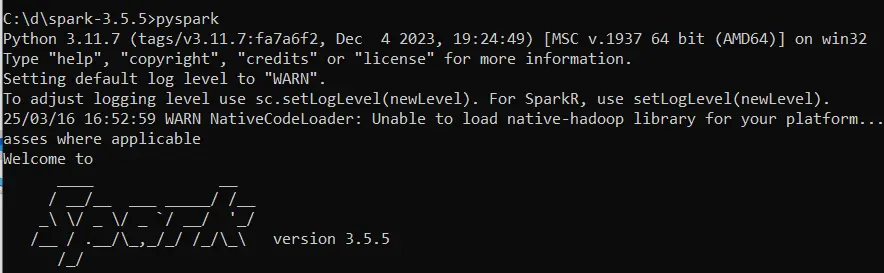

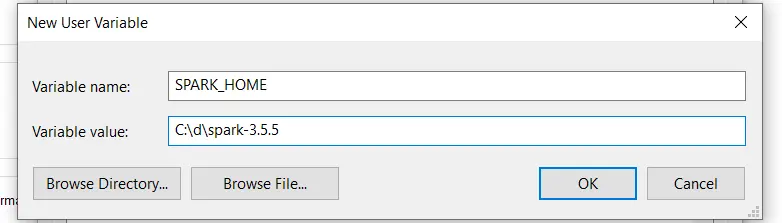

我們把採集到的plans.csv放到python工程中,利用下面的代碼可以利用spark來加載和展示csv的具體內容。這裏的local[2]是指利用本地的spark環境, 2説明起動兩個thread,一個master,一個worker.如果設置為3, 則一個是master,兩個worker.

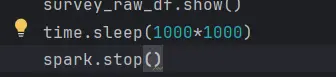

在python 沒有結束退出之前,可以通過http://localhost:4040/jobs來查看Job信息。 為了防止程序完成的太快退出,可以加一個sleep。

Gitee: https://gitee.com/yanghang1977/pyspark