摘要

GMI Cloud 插件正式無縫集成到 Dify!提供高性能的多系列模型,如Minimax、DeepSeek、GPT OSS、Qwen、Keling等,支持市場研究、模型評估、文獻綜述等任務處理。大家只需獲取 GMI Cloud API 密鑰,在 Dify 安裝配置插件,即可藉助模板構建深度研究工作流程。本文為步驟的詳細教程。**

01

概述

GMI Cloud 是一個強大的雲原生 GPU 基礎設施平台,專為高性能 AI 推理服務設計。適配 Dify 的 GMI Cloud 插件可讓你將 GMI Cloud 的功能無縫集成到 Dify 工作流程中。以下是插件的主要功能:

- OpenAI 兼容的 API:支持通過標準 OpenAI 客户端庫和工具實現無縫集成。

- 多個模型系列:獲取豐富的模型資源,包括 DeepSeek、Llama、Qwen、OpenAI OSS 和 GLM 模型。

- 高性能:針對快速推理和低延遲優化,非常適合需大量計算能力的研究任務。

- 流媒體支持:支持實時流式傳輸,實現流暢聊天交互。

- 工具調用:支持函數調用,可將外部工具集成到工作流程中。

- 自定義模型支持:輕鬆部署和使用你自己的微調模型。

- 靈活的端點:可為企業級部署配置自定義 API 端點。

配置插件後,你可以訪問和使用插件附帶的一系列預設模型。目前包含以下類別:

- DeepSeek:

- deepseek-ai/DeepSeek-V3-0324

- deepseek-ai/DeepSeek-V3.1

- OpenAI OSS:

- openai/gpt-oss-120b

- Meta-Llama:

- meta-llama/Llama-4-Scout-17B-16E-Instruct

- Qwen:

- Qwen/Qwen3-32B-FP8

- Qwen/Qwen3-Next-80B-A3B-Instruct

- Qwen/Qwen3-235B-A22B-Thinking-2507-FP8

- Qwen/Qwen3-Coder-480B-A35B-Instruct-FP8

- 智譜(ZAI):

- zai-org/GLM-4.6

這些模型具備多種功能,可用於執行自然語言處理、文本生成、代碼生成等任務。

通過以下鏈接可以獲取該插件的最新文檔(複製到瀏覽器中打開):

https://marketplace.dify.ai/plugins/langgenius/gmicloud

02

分步指南

第 1 步:從 GMI Cloud 獲取 API 密鑰

若你尚未準備好 API 密鑰,請先前往 GMI Cloud 控制枱創建:

- 登錄 GMI Cloud 控制枱,進入 API 密鑰管理頁面。

- 點擊「創建 API 密鑰」,為其設置易記名稱,然後選擇 “範圍” 為 “推理”。

- 請妥善保存你的 API 密鑰,關閉彈出窗口後將無法再次查看。

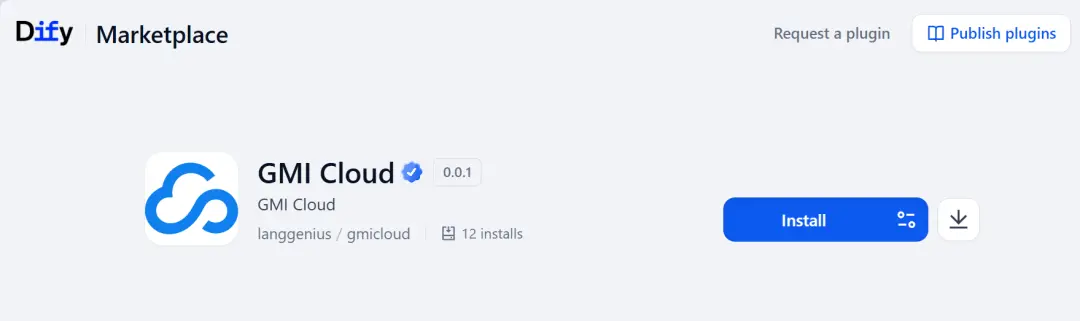

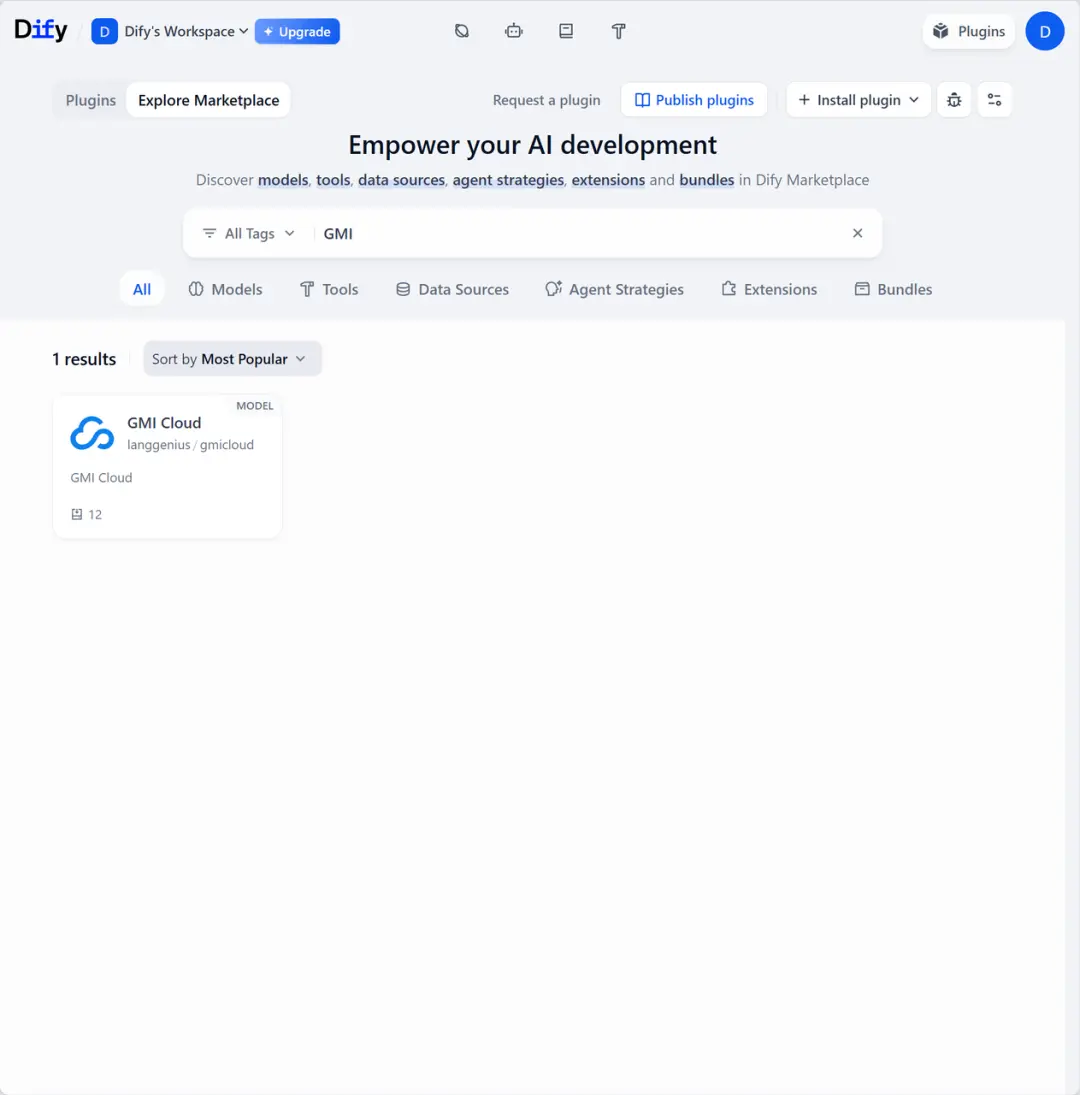

第 2 步:在 Dify 中安裝插件

接下來操作 Dify:前往 Dify 插件市場(路徑:Plugins - Dify https://cloud.dify.ai/plugins?category=discover),搜索並安裝 GMI Cloud 插件。

第 3 步:在 Dify 中配置插件

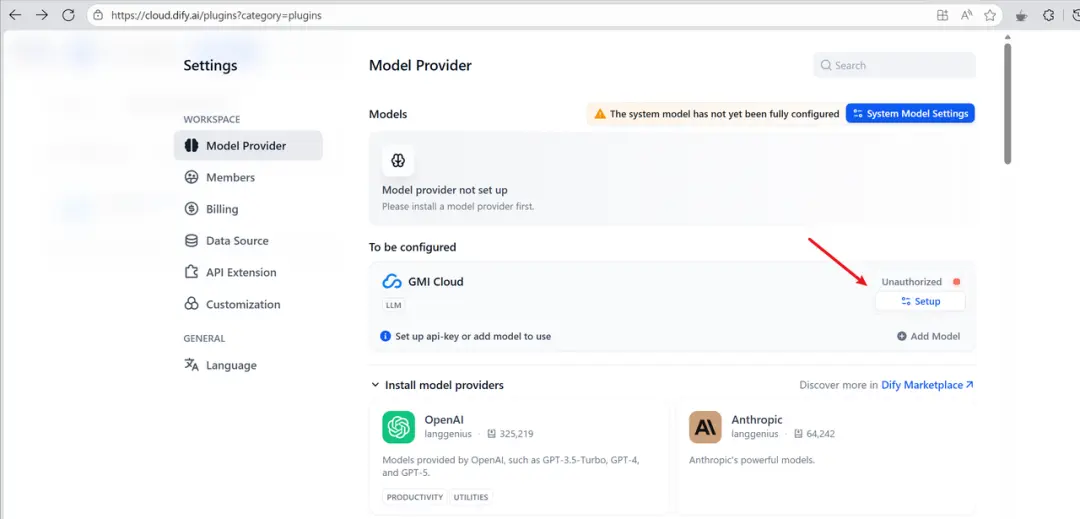

現在為 Dify 中的插件完成配置:

- 打開 Dify,進入設置→模型提供程序。

- 在可用提供商列表中找到 GMI Cloud,點擊「設置」。

- 在 API 密鑰字段中輸入你的密鑰,這是唯一必填項。

- (可選)若你的組織使用自定義端點,可輸入 API 端點 URL;否則插件默認值為:https://api.gmi-serving.com/v1。

- 點擊「保存」激活插件。

Dify 將通過調用 /v1/models 端點驗證你的憑據,確保所有設置無誤。

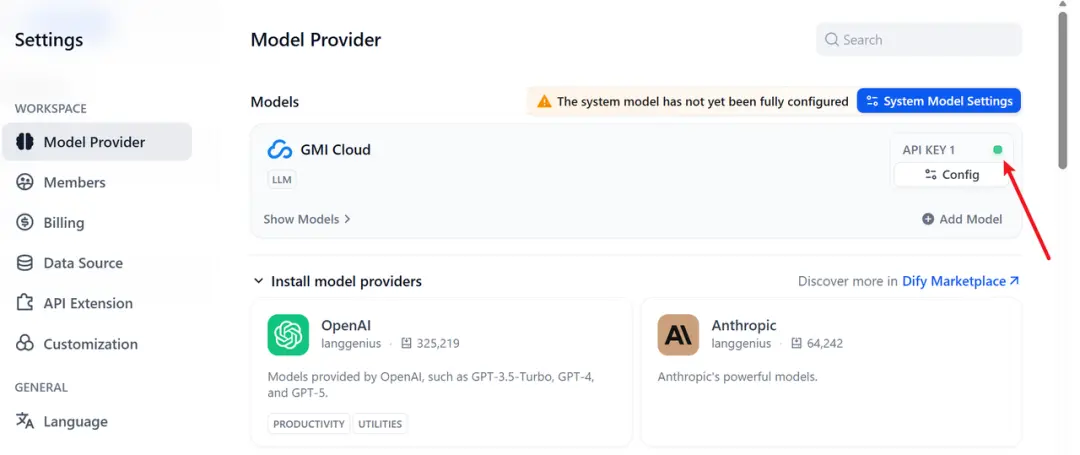

若配置成功,你將看到綠燈提示。此時即可開始構建工作流程!

第 4 步:在 Dify 中構建深度研究工作流程

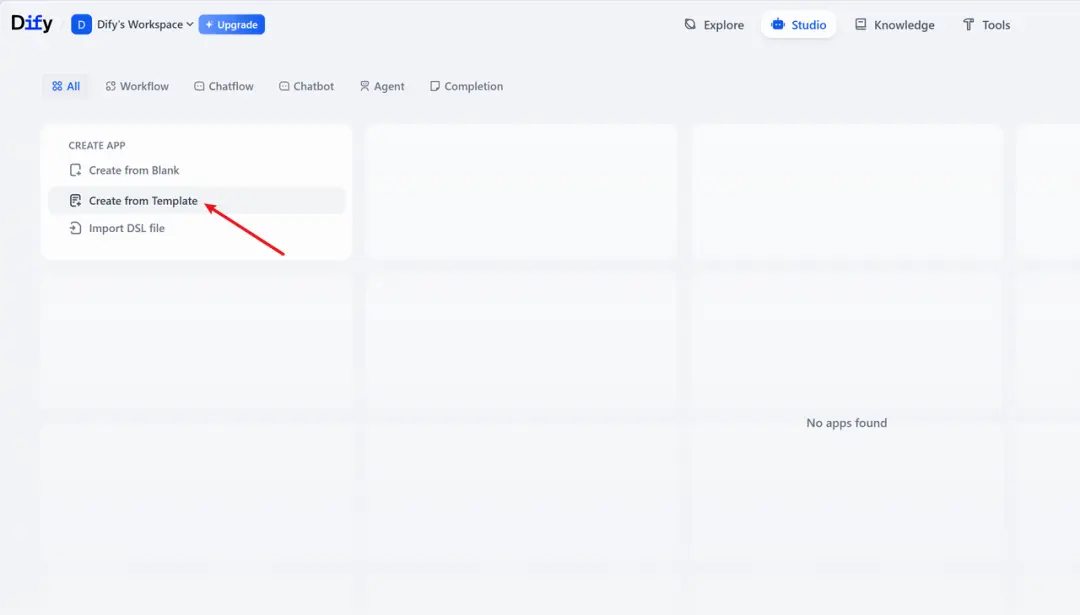

進入首頁,點擊「從模板創建」:

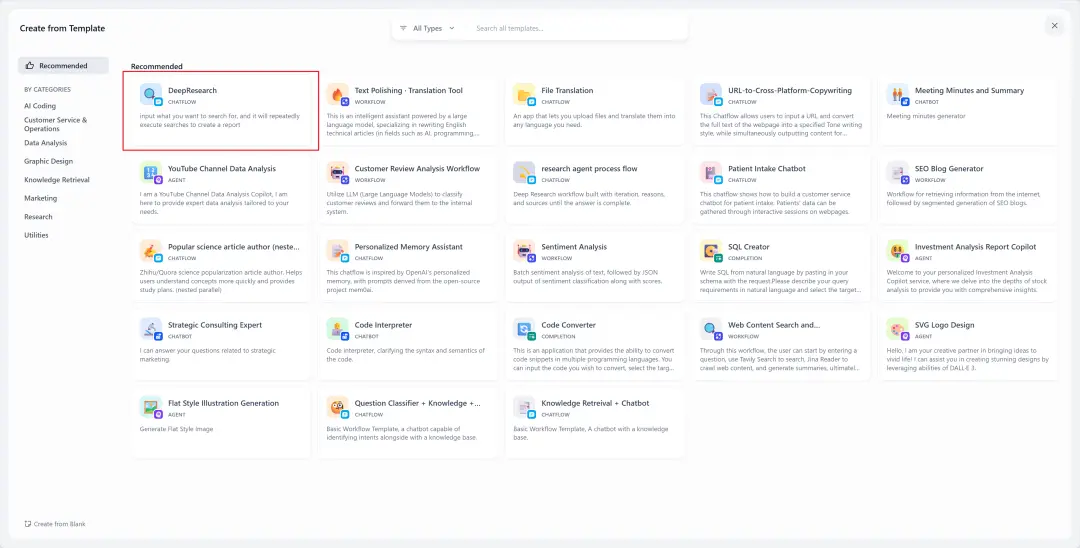

本次將使用 Dify 官方提供的 DeepResearch 模板。

在插件安裝頁面,請務必勾選兩個工具:Tavily 和 JSON Process。無需啓用另外兩個模型提供程序插件,我們將使用 GMI Cloud 的模型端點。

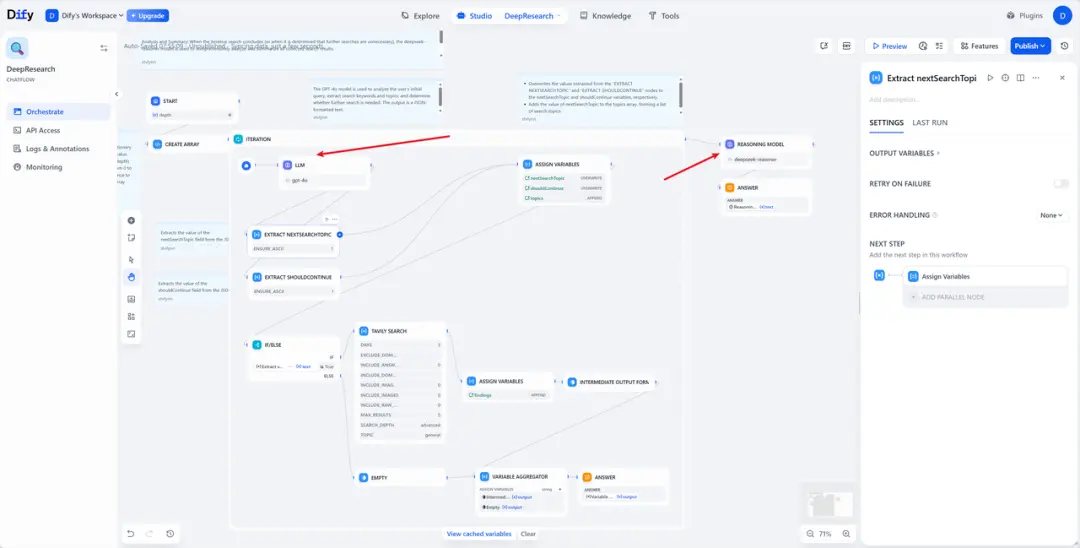

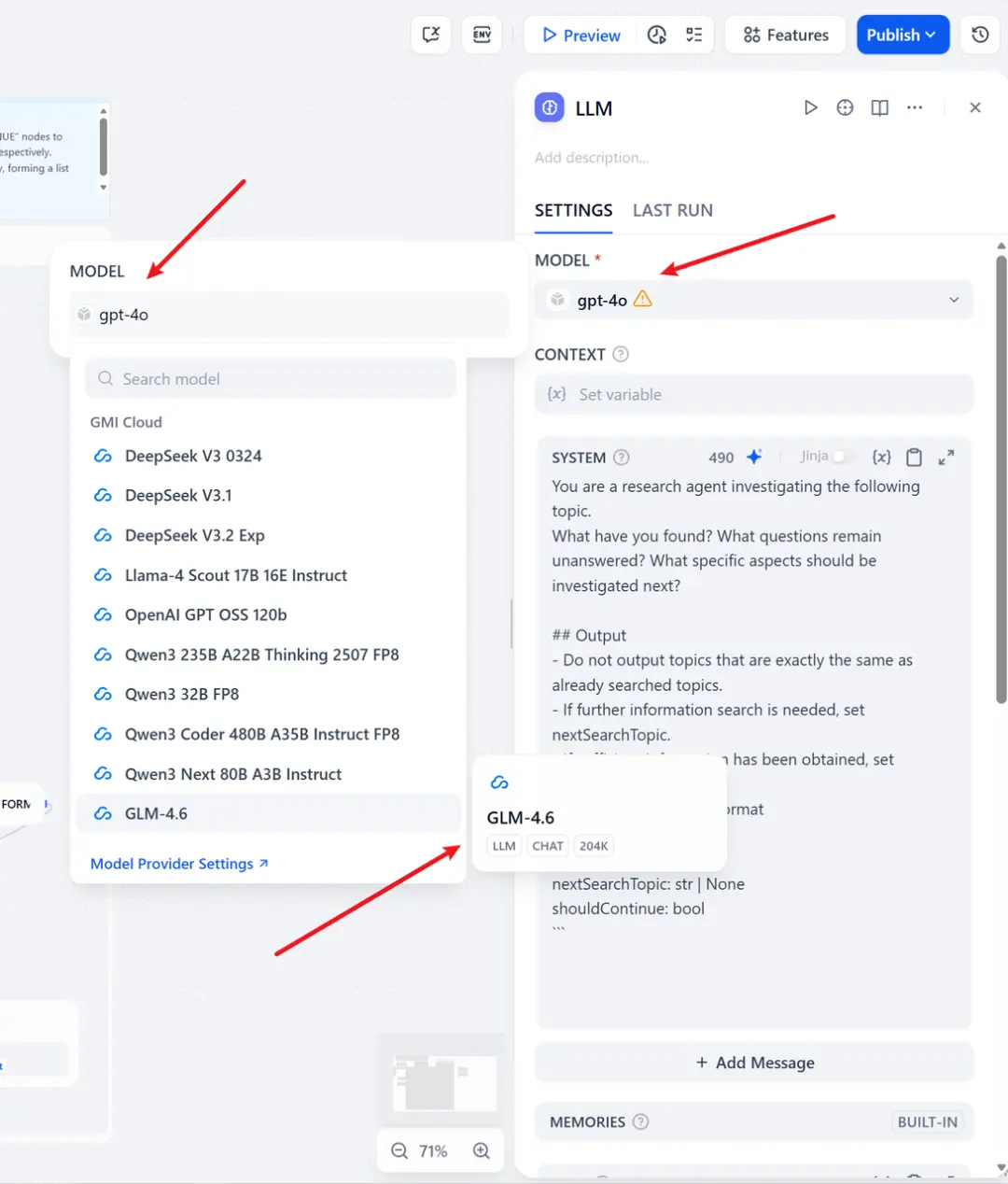

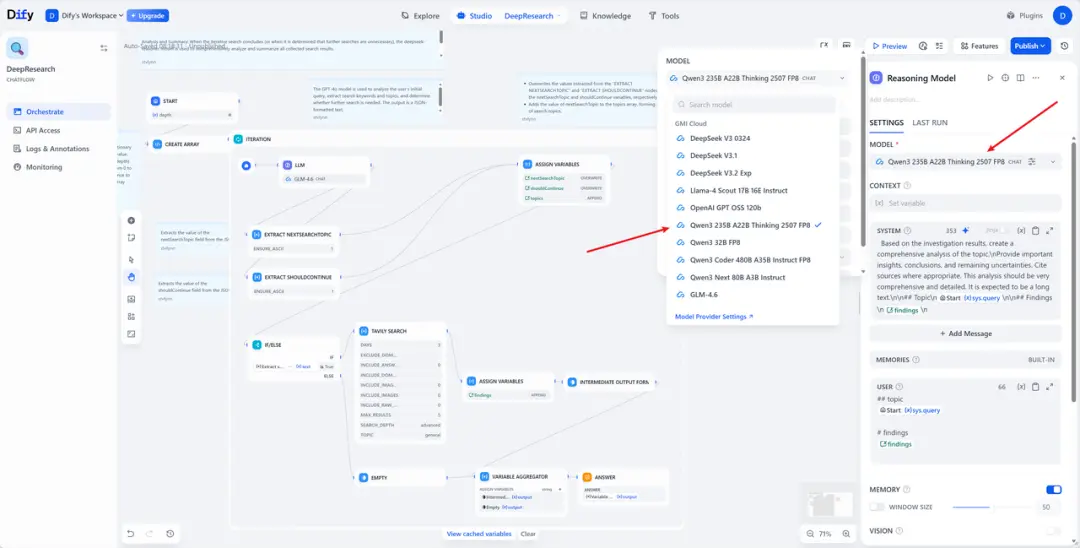

複雜的圖表看似很多,但無需困擾,我們只需關注兩個節點:LLM 節點和推理模型節點——用 GMI Cloud 的模型端點替換它們。

對於 LLM 節點:將 gpt-4o 替換為 GLM-4.6(這是一款性能出色的通用 LLM 模型,擅長各類通用任務。瞭解更多信息可訪問 zai-org/GLM-4.6 · Hugging Face https://huggingface.co/zai-org/GLM-4.6)。

對於推理模型節點:將其替換為 Qwen/Qwen3-235B-A22B-Thinking-2507-FP8(該模型在多項推理基準測試中表現優異。瞭解更多信息可訪問 Qwen/Qwen3-235B-A22B-Thinking-2507-FP8 · Hugging Face

https://huggingface.co/Qwen/Qwen3-235B-A22B-Thinking-2507-FP8)。

完成以上設置後,點擊右上角的「發佈」按鈕,工作流即可運行!

第 5 步:開始試用!

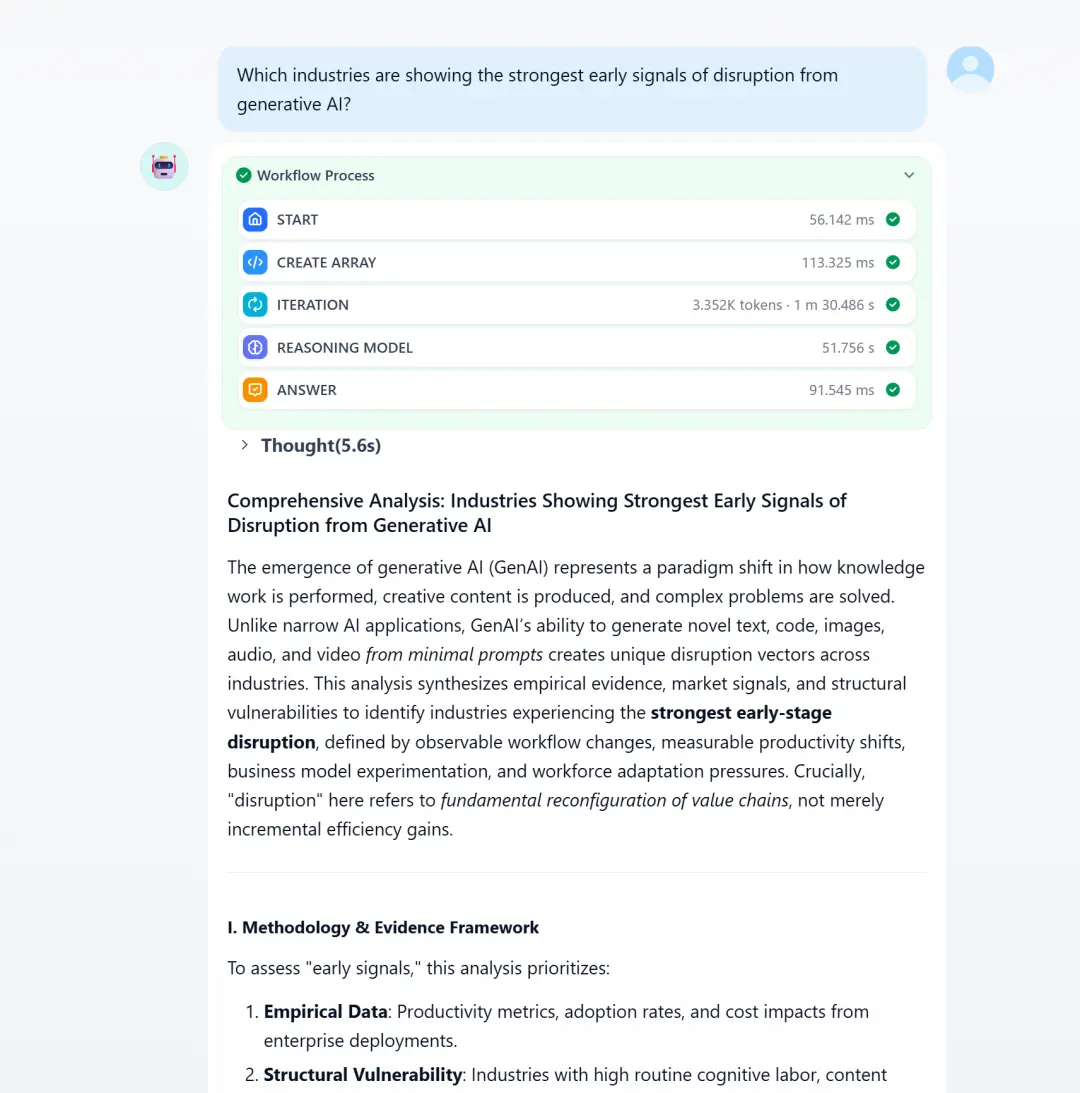

現在讓我們進入工作流應用程序。設置一個可選的深度參數——這就是這個工作流被稱為深度研究的原因,能夠根據指定的深度,會進行多輪迭代搜索。例如,我們把它設為2。

以下是示例提示詞:

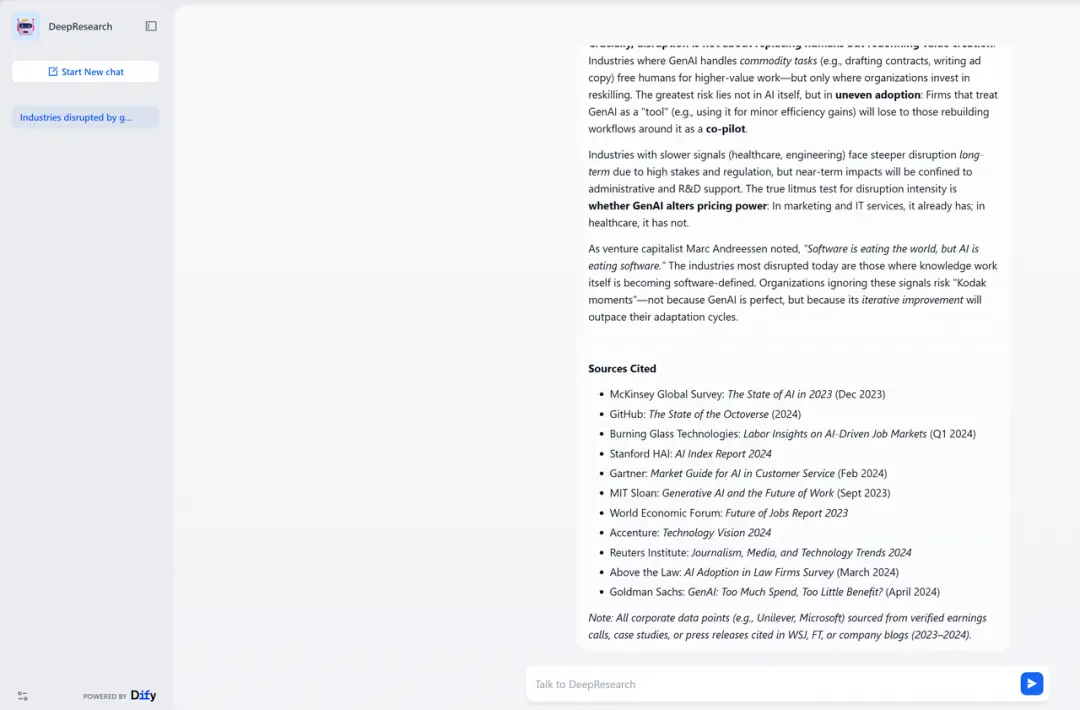

Which industries are showing the strongest early signals of disruption from generative AI?需要注意的是,由於深度研究可能需要多輪推理,完整答案可能需要一兩分鐘才能生成。總之,你最終將獲得一份撰寫規範、來源明確的分析報告。

03

結論

在 Dify 中通過 GMI 插件構建深度研究工作流程,能夠充分利用 GMI Cloud Inference Engine中的 AI 模型和尖端雲基礎設施。無論你是進行市場研究、模型評估還是文獻綜述的撰寫,它都將是你最可靠的夥伴,全力助力你的生產流程。

現在就去安裝 GMI Cloud 插件,完成 API Key 配置,就可以立刻開始構建你的深度研究工作流程啦!如有任何問題,可隨時通過郵箱聯繫我們: support@gmicloud.ai

關於 GMI Cloud

由 Google X 的 AI 專家與硅谷精英共同參與創立的 GMI Cloud 是一家領先的 AI Native Cloud 服務商,是全球六大 Reference Platform NVIDIA Cloud Partner 之一,擁有遍佈全球的數據中心,為企業 AI 應用提供最新、最優的 GPU 雲服務,為全球新創公司、研究機構和大型企業提供穩定安全、高效經濟的 AI 雲服務解決方案。

GMI Cloud 憑藉高穩定性的技術架構、強大的GPU供應鏈以及令人矚目的 GPU 產品陣容(如能夠精準平衡 AI 成本與效率的 H200、具有卓越性能的 B200 以及未來所有全新上線的高性能芯片),確保企業客户在高度數據安全與計算效能的基礎上,高效低本地完成 AI 落地。此外,通過自研“Cluster Engine”、“Inference Engine”兩大平台,完成從算力原子化供給到業務級智算服務的全棧躍遷,全力構建下一代智能算力基座。

作為推動通用人工智能(AGI)未來發展的重要力量,GMI Cloud 持續在 AI 基礎設施領域引領創新。選擇 GMI Cloud,您不僅是選擇了先進的 GPU 雲服務,更是選擇了一個全方位的 AI 基礎設施合作伙伴。

如果您想要了解有關 GMI Cloud 的信息

請關注我們並建立聯繫