本文詳細介紹了Apache DolphinScheduler的RESTful API接口體系及其在企業系統集成中的應用。內容涵蓋API架構設計、核心控制器模塊、統一響應格式、認證授權機制、錯誤處理體系以及Swagger接口文檔。同時深入探討了Java SDK集成開發指南,包括環境準備、核心API接口、工作流編程式創建與管理,以及與企業現有系統的集成方案。文章提供了豐富的代碼示例和最佳實踐,幫助開發者全面掌握DolphinScheduler的API開發與集成能力。

RESTful API接口體系詳解

DolphinScheduler提供了一套完整且規範的RESTful API接口體系,為開發者提供了強大的集成和擴展能力。該API體系基於Spring Boot框架構建,採用標準的RESTful設計原則,支持Swagger文檔自動生成,具備完善的認證授權機制和統一的錯誤處理體系。

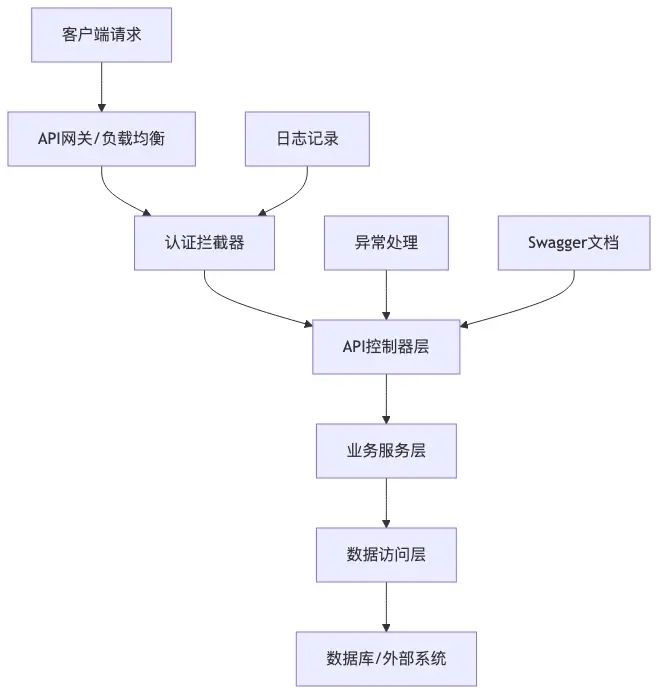

API架構設計

DolphinScheduler的API架構採用分層設計模式,整體架構如下:

核心控制器模塊

DolphinScheduler API包含20多個核心控制器,覆蓋了系統的所有功能模塊:

統一響應格式

所有API接口都遵循統一的響應格式規範:

{

"code": 0,

"msg": "success",

"data": {

// 業務數據內容

}

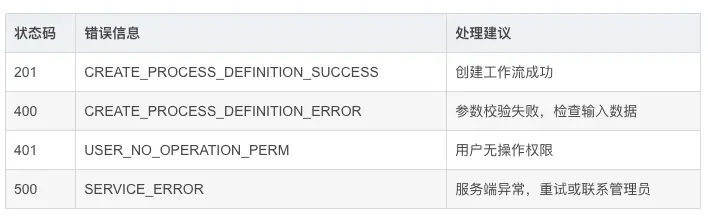

}響應狀態碼説明:

認證授權機制

DolphinScheduler支持多種認證方式:

支持兩種認證模式:

- 密碼認證:基於用户名密碼的傳統認證方式

-

LDAP認證:集成企業級LDAP身份驗證

錯誤處理體系

API採用統一的異常處理機制:

@RestControllerAdvice

public class ApiExceptionHandler {

@ExceptionHandler(Exception.class)

public Result exceptionHandler(Exception e, HandlerMethod hm) {

ApiException ce = hm.getMethodAnnotation(ApiException.class);

if (ce == null) {

return Result.errorWithArgs(Status.INTERNAL_SERVER_ERROR_ARGS, e.getMessage());

}

return Result.error(ce.value());

}

}Swagger接口文檔

系統集成Swagger2和SwaggerBootstrapUI,自動生成API文檔:

- 訪問路徑:/swagger-ui.html

- 支持在線測試接口

- 完整的參數説明和示例

- 實時更新的接口文檔

典型接口示例

創建項目接口:

@PostMapping()

@ApiOperation(value = "create", notes = "CREATE_PROJECT_NOTES")

@ApiException(CREATE_PROJECT_ERROR)

public Result createProject(@RequestAttribute User loginUser,

@RequestParam String projectName,

@RequestParam(required = false) String description) {

Map<String, Object> result = projectService.createProject(loginUser, projectName, description);

return returnDataList(result);

}啓動工作流實例:

@PostMapping("start-process-instance")

@ApiOperation(value = "startProcessInstance", notes = "RUN_PROCESS_INSTANCE_NOTES")

public Result startProcessInstance(@PathVariable long projectCode,

@RequestParam long processDefinitionCode,

@RequestParam FailureStrategy failureStrategy,

@RequestParam WarningType warningType) {

// 業務邏輯處理

}接口調用最佳實踐

- 認證頭信息:所有接口調用都需要攜帶有效的Session或Token

- 參數驗證:嚴格按照Swagger文檔中的參數要求傳遞數據

- 錯誤處理:正確處理各種業務狀態碼和錯誤信息

- 性能優化:合理使用分頁查詢,避免大數據量返回

- 異步操作:長時間操作建議使用異步調用方式

擴展開發指南

開發者可以通過以下方式擴展API功能:

- 新增控制器:繼承BaseController,使用標準註解規範

- 自定義服務:實現業務邏輯,注入到控制器中

- 添加狀態碼:在Status枚舉中定義新的錯誤狀態

- 集成認證:實現Authenticator接口支持新的認證方式

DolphinScheduler的RESTful API體系設計規範、擴展性強,為系統集成和二次開發提供了堅實的基礎架構支持。通過完善的文檔和統一的規範,開發者可以快速上手並進行定製化開發。

Java SDK集成開發指南

Apache DolphinScheduler提供了強大的Java SDK集成能力,允許開發者通過編程方式與調度系統進行交互。本指南將詳細介紹如何使用Java SDK進行工作流定義、任務管理、調度執行等操作。

環境準備與依賴配置

在開始使用Java SDK之前,需要確保項目已正確配置相關依賴。DolphinScheduler的Java SDK主要通過Maven進行依賴管理:

<dependency>

<groupId>org.apache.dolphinscheduler</groupId>

<artifactId>dolphinscheduler-client</artifactId>

<version>3.0.0</version>

</dependency>

<dependency>

<groupId>org.apache.dolphinscheduler</groupId>

<artifactId>dolphinscheduler-common</artifactId>

<version>3.0.0</version>

</dependency>核心API接口概覽

DolphinScheduler Java SDK提供了豐富的API接口,主要分為以下幾類:

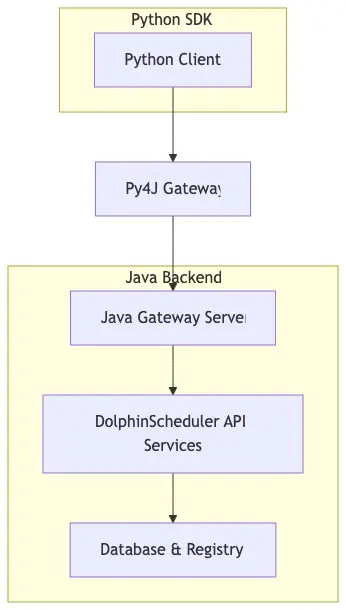

Java Gateway集成架構

DolphinScheduler採用Py4J框架實現Python與Java的跨語言通信,其架構如下:

Java JDK核心集成示例

- 工作流創建與提交

以下示例展示如何通過Java SDK創建和提交一個簡單的工作流:

// 初始化網關連接

GatewayServer gateway = new GatewayServer(new PythonGatewayServer());

gateway.start();

// 創建工作流定義

ProcessDefinition processDefinition = new ProcessDefinition();

processDefinition.setName("daily_etl_workflow");

processDefinition.setDescription("Daily ETL Data Processing");

processDefinition.setProjectName("data_engineering");

processDefinition.setTenantCode("tenant_001");

// 添加Shell任務

ShellTask shellTask = new ShellTask();

shellTask.setName("data_extraction");

shellTask.setCommand("python /scripts/extract_data.py");

shellTask.setWorkerGroup("default");

// 添加SQL任務

SqlTask sqlTask = new SqlTask();

sqlTask.setName("data_transformation");

sqlTask.setDatasourceName("hive_prod");

sqlTask.setSql("INSERT INTO table_dest SELECT * FROM table_src");

// 設置任務依賴關係

processDefinition.addTask(shellTask);

processDefinition.addTask(sqlTask);

processDefinition.setTaskRelation(shellTask, sqlTask);

// 提交工作流

long processDefinitionCode = processDefinitionService

.createProcessDefinition(user, projectCode, processDefinition);

// 發佈工作流

processDefinitionService.releaseProcessDefinition(

user, projectCode, processDefinitionCode, ReleaseState.ONLINE);-

工作流調度執行

// 立即執行工作流 Map<String, Object> result = executorService.execProcessInstance( user, projectCode, processDefinitionCode, null, // scheduleTime null, // execType FailureStrategy.CONTINUE, null, // startNodeList TaskDependType.TASK_POST, WarningType.NONE, 0, // warningGroupId RunMode.RUN_MODE_SERIAL, Priority.MEDIUM, "default", // workerGroup -1L, // environmentCode 3600, // timeout null, // startParams null // expectedParallelismNumber ); // 解析執行結果 if (result.get(Constants.STATUS) == Status.SUCCESS) { int processInstanceId = (int) result.get(Constants.DATA_LIST); logger.info("Process instance started with ID: {}", processInstanceId); } -

定時調度配置

// 創建定時調度 Schedule schedule = new Schedule(); schedule.setProcessDefinitionCode(processDefinitionCode); schedule.setCrontab("0 0 2 * * ?"); // 每天凌晨2點執行 schedule.setFailureStrategy(FailureStrategy.CONTINUE); schedule.setWarningType(WarningType.ALL); schedule.setWarningGroupId(1); schedule.setProcessInstancePriority(Priority.MEDIUM); Map<String, Object> scheduleResult = schedulerService.insertSchedule( user, projectCode, processDefinitionCode, schedule );

高級集成特性

-

參數化工作流

DolphinScheduler支持全局參數和局部參數傳遞:// 設置全局參數 Map<String, String> globalParams = new HashMap<>(); globalParams.put("business_date", "${system.biz.date}"); globalParams.put("input_path", "/data/input/${business_date}"); globalParams.put("output_path", "/data/output/${business_date}"); processDefinition.setGlobalParams(globalParams); // 任務級參數 shellTask.setLocalParams(Collections.singletonList( new Property("file_count", "IN", "VARCHAR", "10") )); -

條件分支與流程控制

// 創建條件任務 ConditionsTask conditionsTask = new ConditionsTask(); conditionsTask.setName("check_data_quality"); conditionsTask.setCondition("${data_quality} > 0.9"); // 成功分支 ShellTask successTask = new ShellTask(); successTask.setName("load_to_dw"); successTask.setCommand("python load_datawarehouse.py"); // 失敗分支 ShellTask failureTask = new ShellTask(); failureTask.setName("send_alert"); failureTask.setCommand("python send_alert.py"); // 設置條件分支 processDefinition.addTask(conditionsTask); processDefinition.addTask(successTask); processDefinition.addTask(failureTask); processDefinition.setConditionRelation(conditionsTask, successTask, failureTask); -

資源文件管理

// 上傳資源文件 ResourceComponent resource = new ResourceComponent(); resource.setName("etl_script.py"); resource.setDescription("ETL Python Script"); resource.setContent(Files.readAllBytes(Paths.get("scripts/etl_script.py"))); resource.setType(ResourceType.FILE); Result uploadResult = resourcesService.createResource( user, resource.getName(), resource.getDescription(), resource.getContent(), ResourceType.FILE, 0, // pid "/" ); // 在任務中引用資源文件 shellTask.setResourceList(Collections.singletonList( new ResourceInfo("etl_script.py", ResourceType.FILE) ));

錯誤處理與監控

-

異常處理機制

try { // 工作流操作 long processDefinitionCode = processDefinitionService .createProcessDefinition(user, projectCode, processDefinition); } catch (ServiceException e) { logger.error("Failed to create process definition: {}", e.getMessage()); // 根據錯誤碼進行特定處理 if (e.getCode() == Status.PROCESS_DEFINITION_NAME_EXIST.getCode()) { logger.warn("Process definition already exists, updating instead..."); // 更新邏輯 } } -

執行狀態監控

// 查詢工作流實例狀態 ProcessInstance processInstance = processInstanceService.queryProcessInstanceById( user, projectCode, processInstanceId); // 監控任務執行狀態 List<TaskInstance> taskInstances = taskInstanceService.queryTaskListPaging( user, projectCode, processInstanceId, null, // processInstanceName null, // taskName null, // executorName null, // startDate null, // endDate null, // searchVal null, // stateType null, // host 1, // pageNo 100 // pageSize ); // 實時日誌查看 String taskLog = loggerService.queryLog( user, taskInstanceId, 0, // skipLineNum 100 // limit );

性能優化建議

-

批量操作優化

// 批量生成任務編碼 Map<String, Object> codeResult = taskDefinitionService.genTaskCodeList(100); List<Long> taskCodes = (List<Long>) codeResult.get(Constants.DATA_LIST); // 批量創建任務 for (int i = 0; i < taskCodes.size(); i++) { ShellTask task = new ShellTask(); task.setCode(taskCodes.get(i)); task.setName("batch_task_" + i); task.setCommand("echo 'Task " + i + "'"); processDefinition.addTask(task); } -

連接池配置

# application.yml 配置 dolphinscheduler: client: pool: max-total: 50 max-idle: 10 min-idle: 5 max-wait-millis: 30000 -

異步處理模式

// 異步提交工作流 CompletableFuture<Long> future = CompletableFuture.supplyAsync(() -> { return processDefinitionService.createProcessDefinition( user, projectCode, processDefinition); }); future.thenAccept(processDefinitionCode -> { logger.info("Process definition created asynchronously: {}", processDefinitionCode); // 後續處理邏輯 }).exceptionally(ex -> { logger.error("Failed to create process definition asynchronously", ex); return null; });

安全最佳實踐

-

認證與授權

// 使用訪問令牌認證 String accessToken = "your-access-token"; User user = usersService.queryUserByToken(accessToken); // 權限驗證 boolean hasPermission = usersService.hasProjectPerm( user, projectCode, "project_operator"); if (!hasPermission) { throw new SecurityException("Insufficient permissions for project operation"); } -

敏感數據保護

// 使用加密參數 String encryptedParam = PasswordUtils.encryptPassword("sensitive_data"); // 安全的數據源配置 DataSource datasource = new DataSource(); datasource.setName("prod_database"); datasource.setType(DbType.MYSQL); datasource.setConnectionParams(PasswordUtils.encryptPassword( "jdbc:mysql://host:3306/db?user=admin&password=secret" ));

調試與故障排除

-

日誌配置

<!-- log4j2.xml 配置 --> <Logger name="org.apache.dolphinscheduler" level="DEBUG" additivity="false"> <AppenderRef ref="Console"/> <AppenderRef ref="File"/> </Logger> -

常見問題處理

// 連接超時處理 try { gateway.entryPoint.createOrUpdateProcessDefinition(...); } catch (Py4JNetworkException e) { logger.warn("Gateway connection timeout, retrying..."); // 重試邏輯 retryOperation(); } // 數據序列化異常 try { String jsonParams = objectMapper.writeValueAsString(taskParams); } catch (JsonProcessingException e) { logger.error("JSON serialization failed: {}", e.getMessage()); // 使用簡化參數 jsonParams = "{}"; }

通過本指南,您可以全面瞭解DolphinScheduler Java SDK的集成方式和最佳實踐。這些示例代碼和模式可以幫助您構建可靠、高效的數據調度解決方案。

工作流編程式創建與管理

Apache DolphinScheduler 提供了完整的 RESTful API 接口,支持通過編程方式對工作流進行創建、更新、查詢和管理操作。這種編程式管理方式為自動化運維、CI/CD集成以及大規模工作流部署提供了強大的技術支撐。

工作流創建API詳解

DolphinScheduler 的核心創建工作流 API 提供了豐富的參數配置能力,支持完整的工作流定義:

@PostMapping()

@ResponseStatus(HttpStatus.CREATED)

public Result createProcessDefinition(

@RequestAttribute(value = Constants.SESSION_USER) User loginUser,

@PathVariable long projectCode,

@RequestParam(value = "name", required = true) String name,

@RequestParam(value = "description", required = false) String description,

@RequestParam(value = "globalParams", required = false, defaultValue = "[]") String globalParams,

@RequestParam(value = "locations", required = false) String locations,

@RequestParam(value = "timeout", required = false, defaultValue = "0") int timeout,

@RequestParam(value = "tenantCode", required = true) String tenantCode,

@RequestParam(value = "taskRelationJson", required = true) String taskRelationJson,

@RequestParam(value = "taskDefinitionJson", required = true) String taskDefinitionJson)關鍵參數説明

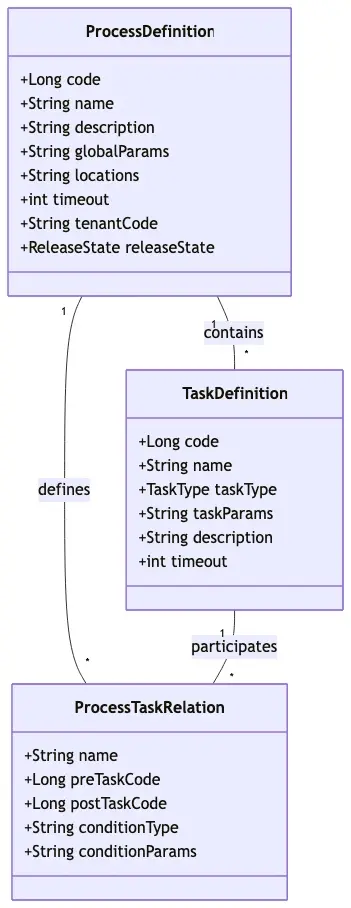

工作流數據結構模型

DolphinScheduler 的工作流採用分層數據結構設計,通過類圖可以清晰展示其核心組件關係:

編程式創建工作流示例

以下是一個完整的Java代碼示例,展示如何通過API編程方式創建工作流:

public class WorkflowCreator {

private static final String API_BASE = "http://dolphinscheduler-api:12345/dolphinscheduler";

private static final String TOKEN = "your-auth-token";

public String createDailyETLWorkflow(long projectCode, String tenantCode) {

// 構建任務定義JSON

String taskDefinitionJson = buildTaskDefinitions();

// 構建任務關係JSON

String taskRelationJson = buildTaskRelations();

// 構建請求參數

Map<String, Object> params = new HashMap<>();

params.put("name", "daily_etl_pipeline");

params.put("description", "Daily data extraction and loading workflow");

params.put("globalParams", "[{\"prop\":\"biz_date\",\"value\":\"${system.biz.date}\"}]");

params.put("timeout", 120);

params.put("tenantCode", tenantCode);

params.put("taskRelationJson", taskRelationJson);

params.put("taskDefinitionJson", taskDefinitionJson);

// 調用API

String url = String.format("%s/projects/%d/process-definition",

API_BASE, projectCode);

return HttpClientUtils.post(url, params, TOKEN);

}

private String buildTaskDefinitions() {

return "["

+ "{\"code\":1001,\"name\":\"extract_mysql_data\",\"taskType\":\"SQL\","

+ "\"taskParams\":\"{\\\"type\\\":\\\"MYSQL\\\",\\\"sql\\\":\\\"SELECT * FROM source_table WHERE dt='${biz_date}'\\\"}\","

+ "\"description\":\"Extract data from MySQL\",\"timeout\":30},"

+ "{\"code\":1002,\"name\":\"transform_data\",\"taskType\":\"SPARK\","

+ "\"taskParams\":\"{\\\"mainClass\\\":\\\"com.etl.Transformer\\\",\\\"deployMode\\\":\\\"cluster\\\"}\","

+ "\"description\":\"Transform extracted data\",\"timeout\":60},"

+ "{\"code\":1003,\"name\":\"load_to_hive\",\"taskType\":\"HIVE\","

+ "\"taskParams\":\"{\\\"hiveCliTaskExecutionType\\\":\\\"SCRIPT\\\",\\\"hiveSqlScript\\\":\\\"INSERT INTO target_table SELECT * FROM temp_table\\\"}\","

+ "\"description\":\"Load data to Hive\",\"timeout\":30}"

+ "]";

}

private String buildTaskRelations() {

return "["

+ "{\"name\":\"\",\"preTaskCode\":0,\"postTaskCode\":1001},"

+ "{\"name\":\"\",\"preTaskCode\":1001,\"postTaskCode\":1002},"

+ "{\"name\":\"\",\"preTaskCode\":1002,\"postTaskCode\":1003}"

+ "]";

}

}工作流管理操作API

除了創建工作流,DolphinScheduler 還提供了完整的管理API:

-

查詢工作流列表

@GetMapping() public Result queryProcessDefinitionListPaging( @RequestAttribute(value = Constants.SESSION_USER) User loginUser, @PathVariable long projectCode, @RequestParam(value = "searchVal", required = false) String searchVal, @RequestParam(value = "pageNo") Integer pageNo, @RequestParam(value = "pageSize") Integer pageSize) -

更新工作流定義

@PutMapping(value = "/{code}") public Result updateProcessDefinition( @RequestAttribute(value = Constants.SESSION_USER) User loginUser, @PathVariable long projectCode, @RequestParam(value = "name", required = true) String name, @PathVariable(value = "code", required = true) long code, // ... 其他參數與創建API類似 @RequestParam(value = "releaseState", required = false) ReleaseState releaseState) -

發佈/下線工作流

@PostMapping(value = "/release") public Result releaseProcessDefinition( @RequestAttribute(value = Constants.SESSION_USER) User loginUser, @PathVariable long projectCode, @RequestParam(value = "code") long code, @RequestParam(value = "releaseState") ReleaseState releaseState)批量操作支持

對於大規模工作流管理場景,DolphinScheduler 提供了批量操作API:

// 批量複製工作流 @PostMapping(value = "/batch-copy") public Result copyProcessDefinition( @RequestAttribute(value = Constants.SESSION_USER) User loginUser, @PathVariable long projectCode, @RequestParam(value = "codes", required = true) String codes, @RequestParam(value = "targetProjectCode", required = true) long targetProjectCode) // 批量移動工作流 @PostMapping(value = "/batch-move") public Result moveProcessDefinition( @RequestAttribute(value = Constants.SESSION_USER) User loginUser, @PathVariable long projectCode, @RequestParam(value = "codes", required = true) String codes, @RequestParam(value = "targetProjectCode", required = true) long targetProjectCode) // 批量刪除工作流 @DeleteMapping(value = "/batch-delete") public Result batchDeleteProcessDefinition( @RequestAttribute(value = Constants.SESSION_USER) User loginUser, @PathVariable long projectCode, @RequestParam(value = "codes", required = true) String codes)

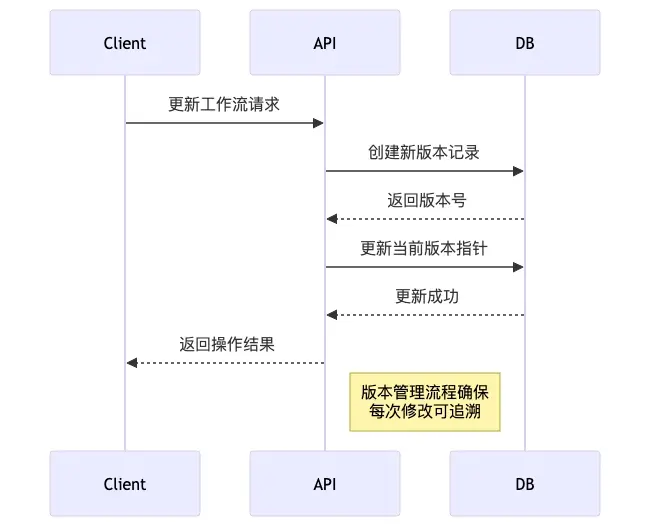

工作流版本管理

DolphinScheduler 支持工作流版本控制,每次修改都會生成新的版本:

版本查詢API示例:

@GetMapping(value = "/{code}/versions")

public Result queryProcessDefinitionVersions(

@RequestAttribute(value = Constants.SESSION_USER) User loginUser,

@PathVariable long projectCode,

@RequestParam(value = "pageNo") int pageNo,

@RequestParam(value = "pageSize") int pageSize,

@PathVariable(value = "code") long code)錯誤處理與狀態碼

編程式創建工作流時,需要正確處理各種異常情況:

最佳實踐建議

- 參數驗證: 在調用API前驗證所有必填參數,特別是JSON格式的任務定義和關係數據

- 異常重試: 對於網絡超時等臨時性錯誤,實現重試機制

- 版本控制: 重要變更前備份當前工作流版本

- 權限管理: 確保API調用具有足夠的項目操作權限

- 性能優化: 批量操作時合理設置分頁大小,避免一次性加載過多數據

通過編程式API管理DolphinScheduler工作流,可以實現高度自動化的數據流水線部署和管理,大大提升數據工程團隊的效率和運維質量。

企業系統集成方案

DolphinScheduler作為現代化的數據調度平台,提供了豐富的API接口和靈活的擴展機制,能夠與企業現有系統實現深度集成。通過RESTful API、Webhook回調、插件擴展等多種方式,DolphinScheduler可以與企業的監控系統、消息通知系統、數據平台等無縫對接。

API認證與授權機制

DolphinScheduler提供了完善的認證和授權體系,支持多種集成方式:

-

Access Token認證

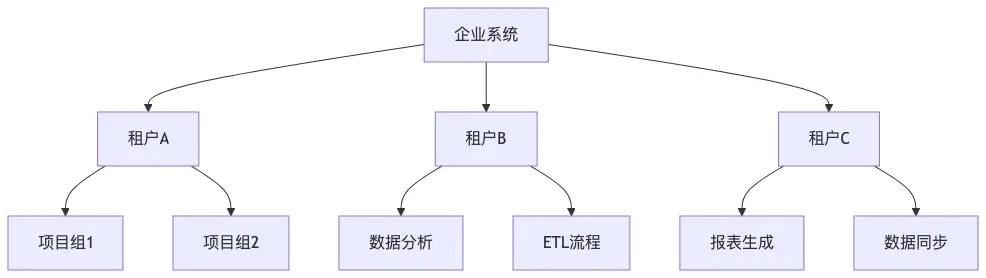

企業系統可以通過Access Token與DolphinScheduler API進行安全交互:// 生成Access Token示例 POST /access-tokens Content-Type: application/x-www-form-urlencoded userId=1001&expireTime=2024-12-31 23:59:59 // 使用Token調用API GET /projects/1001/process-definition Authorization: Bearer {access_token} - 多租户支持

DolphinScheduler支持多租户架構,不同企業部門可以獨立管理自己的工作流:

工作流調度集成

-

程序化工作流觸發

企業系統可以通過API動態觸發工作流執行:// 啓動工作流實例 POST /projects/{projectCode}/executors/start-process-instance Content-Type: application/x-www-form-urlencoded processDefinitionCode=12345 &scheduleTime=2024-01-15 10:00:00 &failureStrategy=END &warningType=ALL &workerGroup=default &timeout=3600 - 批量任務調度

支持批量啓動多個工作流,適用於數據補全或批量處理場景:

// 批量啓動工作流

POST /projects/{projectCode}/executors/batch-start-process-instance

Content-Type: application/x-www-form-urlencoded

processDefinitionCodes=1001,1002,1003

&failureStrategy=END

&warningType=ALL實時狀態監控集成

-

工作流狀態查詢

企業監控系統可以實時獲取工作流執行狀態:// 查詢工作流實例列表 GET /projects/{projectCode}/process-instance ?pageNo=1&pageSize=20&stateType=RUNNING // 響應示例 { "code": 0, "msg": "success", "data": { "totalList": [ { "id": 1001, "name": "daily_etl", "state": "RUNNING", "startTime": "2024-01-15 09:00:00", "host": "worker-node-1" } ], "total": 1, "currentPage": 1, "totalPage": 1 } } -

任務日誌集成

支持實時獲取任務執行日誌,便於故障排查和審計:// 查看任務日誌 GET /projects/{projectCode}/log/detail ?taskInstanceId=5001&skipLineNum=0&limit=100告警通知集成

DolphinScheduler提供了靈活的告警插件機制,支持多種通知方式:

-

HTTP Webhook集成

通過HTTP告警插件,可以將告警信息推送到企業現有的監控系統:# HTTP告警配置示例 url: https://monitor.company.com/api/alerts requestType: POST headerParams: '{"Content-Type": "application/json", "Authorization": "Bearer {api_key}"}' bodyParams: '{"alert_type": "dolphin_scheduler", "priority": "high"}' contentField: "message" -

自定義告警插件

企業可以開發自定義告警插件,實現與內部系統的深度集成:// 自定義告警插件示例 public class CustomAlertPlugin implements AlertChannel { @Override public AlertResult process(AlertInfo alertInfo) { // 與企業內部系統集成邏輯 AlertData data = alertInfo.getAlertData(); Map<String, String> params = alertInfo.getAlertParams(); // 調用企業API發送告警 return sendToEnterpriseSystem(data, params); } }

數據源集成管理

- 多數據源支持

DolphinScheduler支持多種數據源類型,便於與企業現有數據平台集成:

-

數據源API管理

通過API動態管理數據源連接:// 創建數據源 POST /data-sources Content-Type: application/json { "name": "prod_mysql", "type": "MYSQL", "connectionParams": { "host": "mysql.prod.company.com", "port": 3306, "database": "business", "user": "etl_user", "password": "encrypted_password" } }

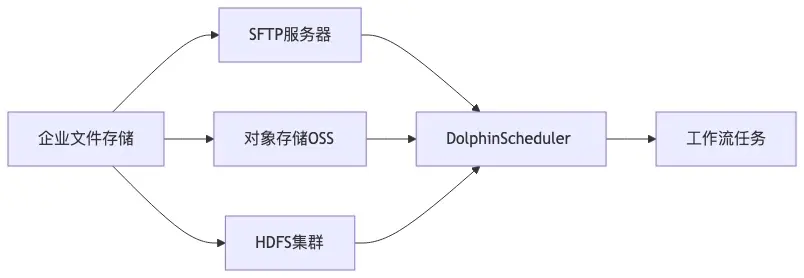

資源文件管理集成

- 統一資源管理

支持與企業現有的文件存儲系統集成,實現資源文件的統一管理:

- 資源API操作

提供完整的資源文件CRUD操作API:

// 上傳資源文件

POST /resources

Content-Type: multipart/form-data

type=FILE&name=etl_script.py&file=@/path/to/script.py

// 在線創建資源

POST /resources/online-create

Content-Type: application/x-www-form-urlencoded

type=FILE&fileName=config.json&suffix=json&content={"key": "value"}用户權限集成

- LDAP/AD集成

支持與企業現有的LDAP或Active Directory系統集成,實現統一身份認證:

# LDAP配置示例

security:

authentication:

type: LDAP

ldap:

urls: ldap://ldap.company.com:389

base-dn: dc=company,dc=com

user-dn-pattern: uid={0},ou=people-

權限同步機制

通過API實現用户權限的自動化同步和管理:// 查詢用户權限 GET /users/authed-project?userId=1001 // 授權用户訪問項目 POST /projects/{projectCode}/grant Content-Type: application/x-www-form-urlencoded userId=1001&permission=READ性能監控與度量

- 系統監控指標

DolphinScheduler提供豐富的監控指標,便於與企業監控系統集成:

- 監控數據導出

支持通過API獲取監控數據,便於集成到企業監控平台:

// 獲取Master節點狀態

GET /monitor/masters

// 獲取Worker節點狀態

GET /monitor/workers

// 獲取數據庫狀態

GET /monitor/databases擴展開發指南

- 自定義任務插件

企業可以開發自定義任務插件,擴展DolphinScheduler的功能:

// 自定義任務插件示例

public class CustomTaskPlugin extends AbstractTask {

@Override

public AbstractParameters getParameters() {

return new CustomParameters();

}

@Override

public TaskResult execute() {

// 調用企業內部服務

return callEnterpriseService();

}

}- SPI擴展機制

DolphinScheduler基於SPI機制,支持靈活的擴展開發:

通過上述集成方案,企業可以充分利用DolphinScheduler的API和擴展能力,實現與現有系統的無縫對接,構建統一的數據調度和管理平台。

總結

DolphinScheduler提供了強大而靈活的API體系,支持多種集成方式和擴展開發。通過RESTful API和Java SDK,開發者可以實現工作流的程序化創建、管理和監控,與企業現有系統無縫集成。文章詳細介紹了認證授權、錯誤處理、資源管理、用户權限集成等關鍵功能,並提供了實際代碼示例和最佳實踐建議。

通過本文為我們可以看到,DolphinScheduler的擴展性使其能夠適應各種企業環境,通過自定義插件和SPI機制,可以進一步擴展其功能,滿足特定的業務需求。這些特性使DolphinScheduler成為構建現代化數據調度平台的理想選擇。

原文鏈接:https://blog.csdn.net/gitblog_00756/article/details/150755498