DolphinScheduler是一個分佈式易擴展的可視化DAG工作流任務調度開源系統,能高效地執行和管理大數據流程。用户可以在DolphinScheduler Web界面輕鬆創建、編輯和調度雲原生數據倉庫 AnalyticDB MySQL 版的Spark作業。

前提條件

- AnalyticDB for MySQL集羣的產品系列為企業版、基礎版或湖倉版。

- AnalyticDB for MySQL集羣中已創建Job型資源組或Spark引擎的Interactive型資源組。

- 已安裝JDK,且JDK的版本為1.8及以上版本。

- 已安裝DolphinScheduler。

- 已將運行DolphinScheduler的服務器IP地址添加至AnalyticDB for MySQL集羣的白名單中。

調度Spark SQL作業

AnalyticDB for MySQL支持使用批處理和交互式兩種方法執行Spark SQL。選擇的執行方式不同,調度的操作步驟也有所不同。詳細步驟如下:

批處理

- 安裝Spark-Submit命令行工具並配置相關參數。

説明:您只需要配置keyId、secretId、regionId、clusterId和rgName這些必填參數。

-

創建項目。

- 訪問DolphinScheduler Web界面,在頂部導航欄單擊項目管理。

- 單擊創建項目。

- 在彈出的創建項目對話框中配置項目名稱、所屬用户等參數。

-

創建工作流。

- 單擊已創建的項目名稱,進入工作流定義頁面。

- 單擊創建工作流,進入工作流DAG編輯頁面。

- 在頁面左側選擇SHELL,並將其拖拽到右側空白畫布中。

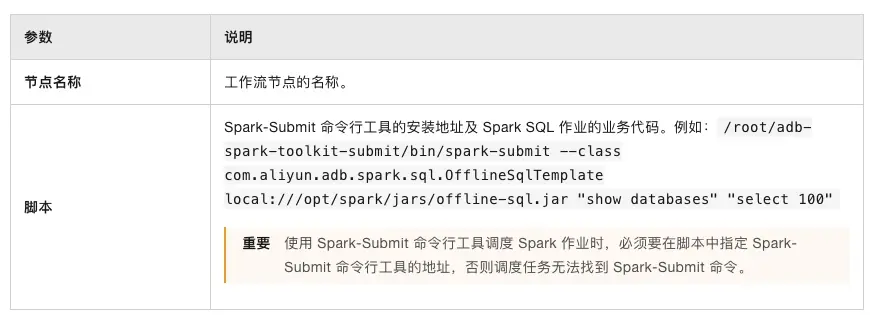

- 在彈出的當前節點設置對話框中配置如下參數:

- 單擊確認。

- 單擊頁面右上角保存,在彈出的基本信息對話框中配置工作流名稱等參數,單擊確定。

説明:其他參數説明請參見DolphinScheduler任務參數。

- 運行工作流。

- 單擊工作流操作列的

按鈕,上線工作流。

- 單擊工作流操作列的

按鈕。

- 在彈出的啓動前請先設置參數對話框中,配置對應參數。

- 單擊確定,運行工作流。

- 查看工作流詳細信息。

- 在左側導航欄單擊任務實例。

-

在操作列,單擊

按鈕,查看工作流執行結果和日誌信息。

交互式

-

獲取Spark Interactive型資源組的連接地址。

- 登錄雲原生數據倉庫AnalyticDB MySQL控制枱,在左上角選擇集羣所在地域。在左側導航欄,單擊集羣列表,在企業版、基礎版或湖倉版頁簽下,單擊目標集羣ID。

- 在左側導航欄,單擊集羣管理 > 資源管理,單擊資源組管理頁籤。

- 單擊對應資源組操作列的詳情,查看內網連接地址和公網連接地址。您可單擊端口號括號內的image按鈕,複製連接地址。

以下兩種情況,您需要單擊公網地址後的申請網絡,手動申請公網連接地址。

- 提交Spark SQL作業的客户端工具部署在本地。

- 提交Spark SQL作業的客户端工具部署在ECS上,且ECS與AnalyticDB for MySQL不屬於同一VPC。

-

創建數據源。

- 訪問DolphinScheduler Web界面,在頂部導航欄單擊數據源中心。

- 單擊創建數據源,選擇數據源類型為Spark。

- 在彈出的創建數據源對話框中配置如下參數:

- 單擊測試連接,測試成功後,單擊確定。

説明:其他參數為選填參數,詳情請參見MySQL數據源。

-

創建項目。

- 訪問DolphinScheduler Web界面,在頂部導航欄單擊項目管理。

- 單擊創建項目。

- 在彈出的創建項目對話框中配置項目名稱、所屬用户等參數。

-

創建工作流。

- 單擊已創建的項目名稱,進入工作流定義頁面。

- 單擊創建工作流,進入工作流DAG編輯頁面。

- 在頁面左側選擇SQL,並將其拖拽到右側空白畫布中。

- 在彈出的當前節點設置對話框中配置如下參數:

- 單擊確認。

- 單擊頁面右上角保存,在彈出的基本信息對話框中配置工作流名稱等參數,單擊確定。

-

運行工作流。

- 單擊工作流操作列的

按鈕,上線工作流。

- 單擊工作流操作列的

按鈕。

- 在彈出的啓動前請先設置參數對話框中,配置對應參數。

- 單擊確定,運行工作流。

- 單擊工作流操作列的

-

查看工作流詳細信息。

- 在左側導航欄單擊任務實例。

- 在操作列,單擊

按鈕,查看工作流執行結果和日誌信息。

調度Spark Jar作業

- 安裝Spark-Submit命令行工具並配置相關參數。

説明:您只需要配置keyId、secretId、regionId、clusterId和rgName這些必填參數。如果您的Spark Jar包在本地,還需要配置ossUploadPath等OSS相關參數。

-

創建項目。

- 訪問DolphinScheduler Web界面,在頂部導航欄單擊項目管理。

- 單擊創建項目。

- 在彈出的創建項目對話框中配置項目名稱、所屬用户等參數。

-

創建工作流。

- 單擊已創建的項目名稱,進入工作流定義頁面。

- 單擊創建工作流,進入工作流DAG編輯頁面。

- 在頁面左側選擇SHELL,並將其拖拽到右側空白畫布中。

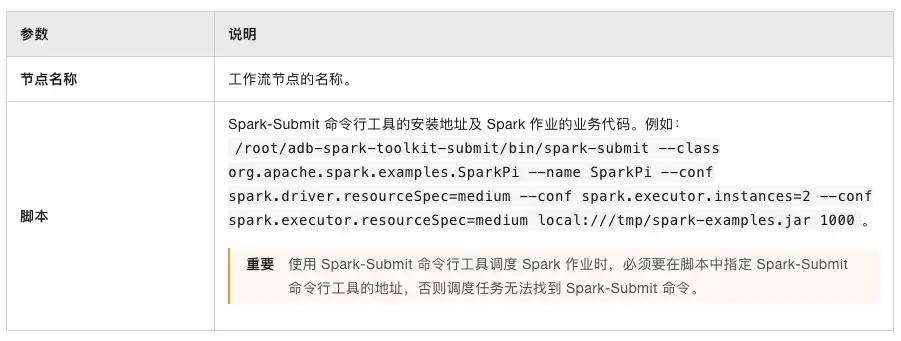

- 在彈出的當前節點設置對話框中配置如下參數:

- 單擊確認。

- 單擊頁面右上角保存,在彈出的基本信息對話框中配置工作流名稱等參數,單擊確定。

説明:其他參數説明請參見DolphinScheduler任務參數。

-

運行工作流。

- 單擊工作流操作列的

按鈕,上線工作流。

- 單擊工作流操作列的

按鈕。

- 在彈出的啓動前請先設置參數對話框中,配置對應參數。

- 單擊確定,運行工作流。

- 單擊工作流操作列的

-

查看工作流詳細信息。

- 在左側導航欄單擊任務實例。

- 在操作列,單擊

按鈕,查看工作流執行結果和日誌信息。