當你開始懷疑“是不是數據還不夠多”的時候,事情往往已經不對了

如果你做過大模型微調,很可能經歷過這樣一個心理過程。

一開始,你對效果還有信心。

模型確實發生了一些變化,雖然不完美,但方向看起來是對的。

然後你開始測試更多問題。

有些好,有些不太好,還有些開始變得奇怪。

這時候,一個幾乎是條件反射式的念頭就會冒出來:

“是不是數據還不夠多?”

於是你開始繼續收集數據。

多抓一點日誌,多爬一點問答,多加一些歷史樣本。

數據集從幾百條變成幾千條,從幾千條變成幾萬條。

但結果往往是:

- 訓練時間變長了

- 顯存壓力更大了

- 模型輸出卻越來越説不清楚“好在哪裏”

很多微調項目,正是在這個階段,從“有點希望”,慢慢走向“徹底失控”。

一個必須先説清楚的前提:數據在微調裏不是“燃料”,而是“約束”

這是理解“數據不是越多越好”的關鍵。

在預訓練階段,數據確實更像燃料。

數據越多,模型見過的語言模式越豐富,整體能力上限越高。

但在微調階段,數據的角色發生了根本變化。

微調數據,並不是在“拓展模型視野”,而是在收緊模型的行為空間。

你給模型看的每一條數據,都在告訴它:

“在類似情況下,你應該更像這樣,而不是那樣。”

也正因為如此,數據越多,約束越強。

第一個常見誤區:把“覆蓋面”當成“質量”

很多人在準備微調數據時,第一反應是追求覆蓋面。

- 要覆蓋儘可能多的場景

- 要包含儘可能多的問法

- 要讓模型“什麼都見過一點”

聽起來很合理,但在微調裏,這往往是個陷阱。

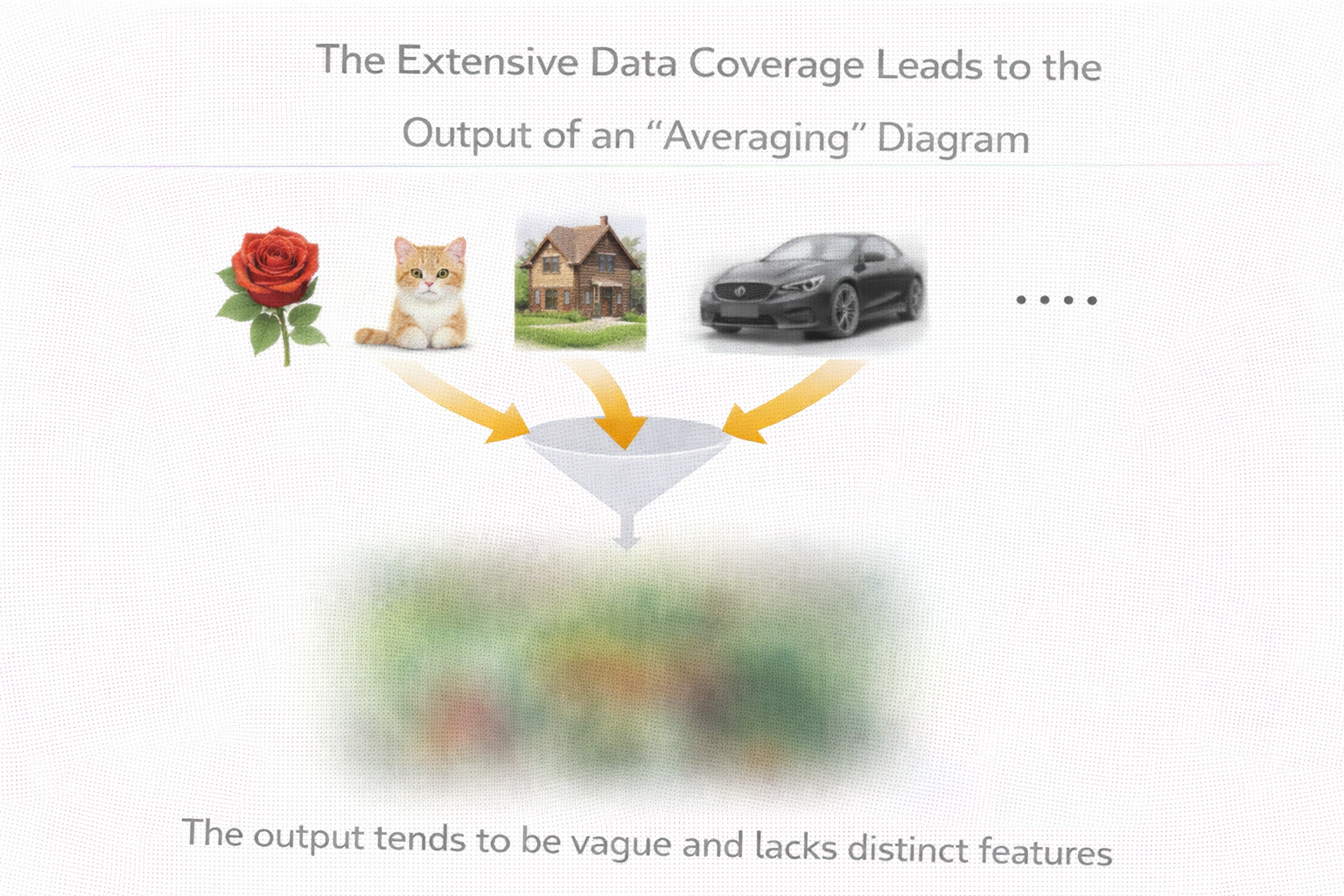

因為當你的數據覆蓋面不斷擴大,但目標卻沒有隨之拆分清楚時,你其實是在給模型傳遞一條非常模糊的信息:

“什麼情況都學一點,但沒有哪一類是特別重要的。”

模型最後學到的,很可能只是一個“平均態”。

看起來什麼都能説一點,但沒有任何一個方向是真正可靠的。

數據覆蓋過廣導致輸出“平均化”的示意圖

第二個誤區:把“真實世界的噪聲”原封不動塞給模型

很多人會覺得:

“這些都是線上真實數據,肯定很有價值。”

但真實世界的數據,往往也是最髒、最矛盾的。

真實客服對話裏:

- 有情緒化表達

- 有不完整信息

- 有前後矛盾的回答

- 有人工臨時發揮的措辭

這些數據,對“理解業務”當然有價值,

但對“教模型學穩定行為”,未必合適。

如果你沒有先想清楚:

- 哪些是你希望模型學的

- 哪些只是背景噪聲

那你給模型的,其實是一堆互相沖突的信號。

一個非常危險的情況:數據越多,問題越難定位

這是“數據不是越多越好”最工程化的一個原因。

當你的數據集只有 200 條時,模型輸出變怪了,你還能去翻數據,看看是不是哪幾條示例在“帶偏模型”。

但當你的數據集有 2 萬條時,情況就完全不同了。

你會發現:

- 你不知道是哪一類數據在影響模型

- 你不知道問題是出在格式、風格,還是內容

- 你甚至不知道該從哪裏開始排查

數據一旦超過你認知可控的規模,它就不再是資產,而會迅速變成負擔。

微調數據最重要的三個特性,而不是“數量”

在我自己的經驗裏,微調數據是否有效,幾乎從來不取決於量,而取決於這三點。

第一,目標一致性

這些數據,是不是在反覆強調同一類行為?

第二,表達穩定性

同一類場景,回答風格是不是高度一致?

第三,邊界是否清晰

數據有沒有明確告訴模型:什麼情況下該這麼做,什麼情況下不該這麼做?

只要這三點成立,哪怕數據量不大,模型也很容易學到你真正想要的東西。

為什麼“小而乾淨”的數據,反而更容易成功

這是一個非常反直覺、但在工程裏被反覆驗證的結論。

小數據集有幾個天然優勢:

- 你更清楚每一條數據在教什麼

- 你能快速定位異常樣本

- 你能更快驗證方向是否正確

- 你不容易被“數據規模幻覺”迷惑

在這個階段,微調更像是一種“對齊實驗”,而不是規模化訓練。

一個非常實用的建議:先用數據“教會一句話”

在準備微調數據時,我經常會用一個非常簡單的自檢方法。

假設你只能用一句話來描述這批數據在教模型什麼,那句話你能不能説清楚?

比如:

- “遇到不確定問題,優先澄清而不是直接回答。”

- “客服回答要先安撫情緒,再給信息。”

- “技術問題回答要先給結論,再給解釋。”

如果你説不出來,那説明你的數據目標本身就是混亂的。

數據重複,其實比你想象中更危險

很多人會覺得:

“重複的數據沒關係,反正模型多看幾遍。”

但在微調裏,重複樣本等價於人為放大某些信號的權重。

如果這些信號本身是你想強化的,那還好;

如果不是,那模型會被推向一個你沒預料到的極端。

這也是為什麼,數據去重在微調裏遠比很多人想象得重要。

下面是一個非常簡單的示意代碼,用來檢測高相似樣本:

from sentence_transformers import SentenceTransformer, util

model = SentenceTransformer("all-MiniLM-L6-v2")

embeddings = model.encode(texts, convert_to_tensor=True)

scores = util.cos_sim(embeddings, embeddings)

# 找出相似度過高的樣本對

duplicates = [(i, j) for i in range(len(texts))

for j in range(i+1, len(texts))

if scores[i][j] > 0.95]

這段代碼不是為了“完美去重”,

而是幫你意識到:

你可能在無意中,讓模型反覆學同一件事。

一個很少被提到的問題:數據其實在“定義評估標準”

很多人以為:

數據是訓練用的,評估是後面的事。

但在微調裏,這兩者是強綁定的。

你用什麼樣的數據訓練模型,

你就會不自覺地用“類似的數據風格”去評估它。

這也是為什麼很多項目在內部測試時感覺很好,一上線就問題百出。

不是模型突然變了,

而是你從一開始,就在一個很窄的世界裏看它。

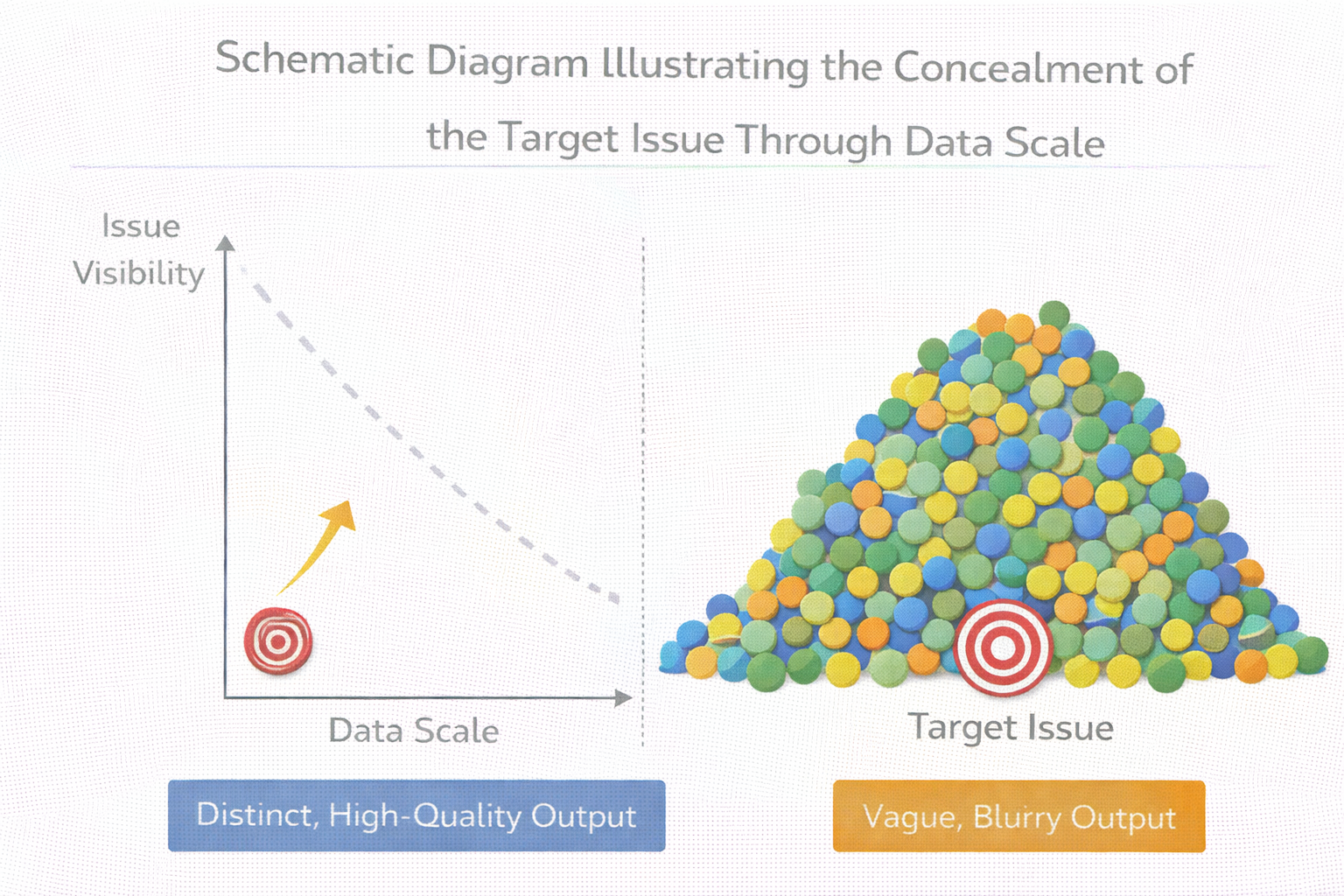

數據越多,越容易掩蓋“目標本身的問題”

這是一個非常現實、也非常殘酷的事實。

當數據量很小的時候,效果不好,你會被迫反思:

“是不是目標定義錯了?”

但當數據量變大之後,你更容易給自己一個心理安慰:

“方向應該沒問題,可能只是數據還不夠多。”

於是你繼續加數據,

繼續訓練,

卻從未真正質疑過:

我到底想讓模型學會什麼?

用數據規模掩蓋目標問題的示意圖

一個更健康的節奏:數據是用來“驗證假設”的

在成熟的微調流程裏,數據不是一次性準備完的。

它更像是:

提出一個假設 → 準備一小批數據 → 看模型是否朝這個方向變化 → 再決定是否擴展。

在這個階段,速度和可控性,遠比規模重要。

在驗證數據方向是否有效時,先通過 LLaMA-Factory online 這類方式快速跑通小規模微調、對比輸出變化,比一開始就準備大數據集更省力,也更安全。

一個非常重要的判斷:什麼時候你應該“停止加數據”

我給一個非常樸素、但很好用的判斷標準。

如果你現在已經説不清楚:

“新加的這些數據,具體是想強化模型哪一類行為?”

那你就應該停下來。

繼續加數據,只會讓模型和你一起更困惑。

總結:數據不是“越多越好”,而是“越清楚越好”

寫到這裏,其實結論已經非常明確了。

在微調裏,數據不是燃料,而是規則;

不是資源,而是約束。

當你把“多”當成目標時,模型往往會變得模糊;

當你把“清楚”當成目標時,哪怕數據不多,模型也能學得很準。

真正成熟的微調,不是“誰的數據多”,

而是誰更清楚自己在教模型什麼。