安全問題,往往不是在“上線那一刻”出現的

如果你做過幾次大模型微調項目,很可能有一種錯覺。

項目初期,一切看起來都很安全。

數據在內網,模型在內網,訪問有權限控制,

甚至你可能會想:

“我們又不是直接對外提供服務,哪來的安全風險?”

但很多隱私和安全問題,並不是在模型“上線”那一刻才出現的。

它們更像是被慢慢埋進模型參數裏的定時炸彈。

等你意識到問題的時候,往往已經很難回頭了。

而微調,正是最容易在不經意間放大這些風險的一步。

一個必須先講清楚的事實:微調 ≠ 只是“更聽話”

很多人第一次接觸微調時,會把它理解成一件相對“温和”的事情。

你並沒有重新訓練模型,

只是用一些數據,讓它更符合你的業務需求,

更像你想要的風格。

從這個角度看,微調好像只是“調教”,而不是“重塑”。

但從安全和隱私的角度看,微調的本質是:

你在顯式地告訴模型:哪些信息值得被強化記住。

而模型一旦記住了某些東西,你就幾乎失去了“撤回”的能力。

預訓練 vs 微調中“記憶方式”的對比圖

內容建議:

- 預訓練:分佈式、模糊、不可定位

- 微調:集中、明確、可觸發

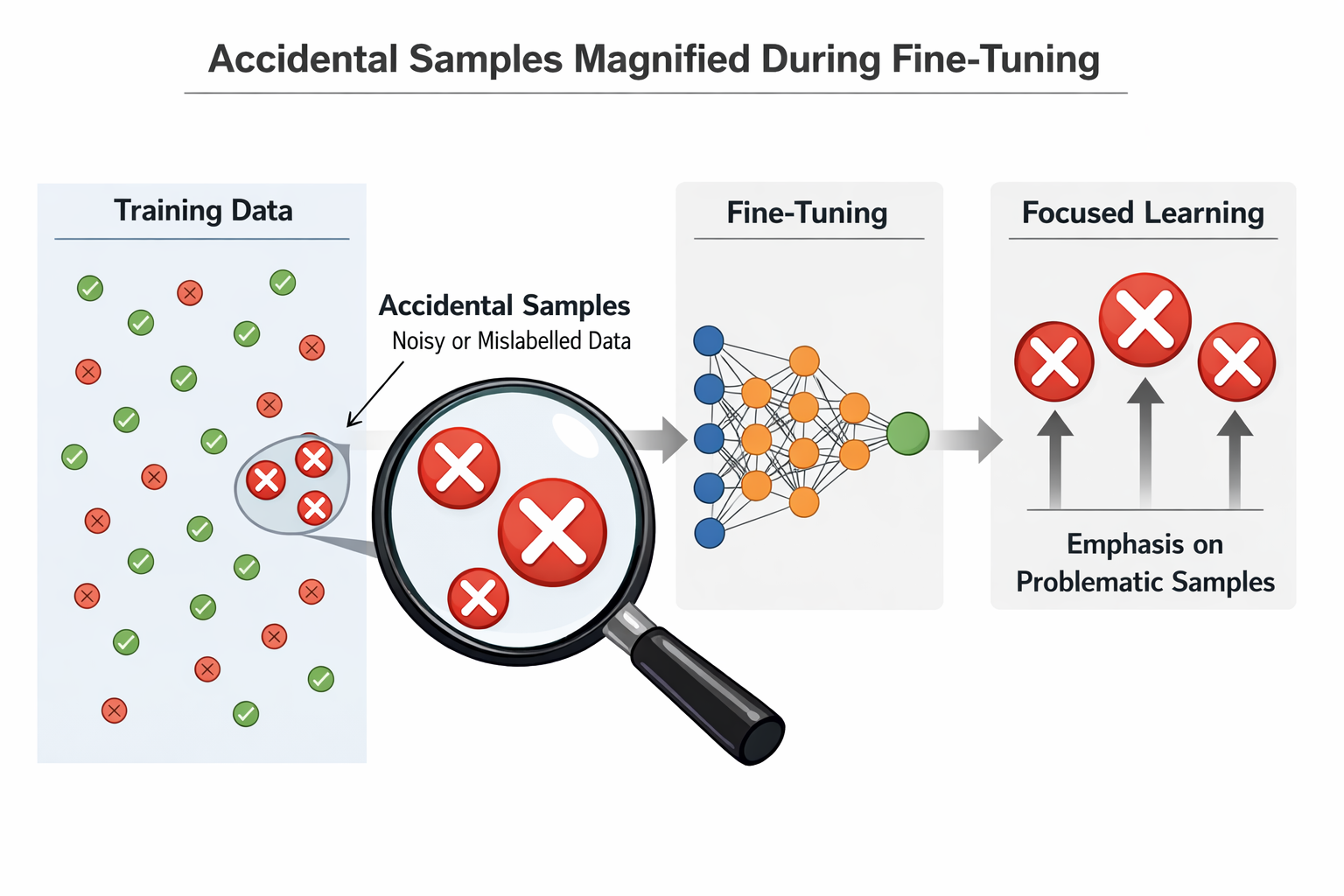

微調放大風險的第一個原因:它會讓“偶然信息”變成“穩定行為”

在預訓練階段,模型看到的數據是海量、混雜、去個體化的。

哪怕某些信息本身是敏感的,它們也會被淹沒在整體分佈中。

但微調完全不同。

微調數據往往有三個特點:

- 數量小

- 風格集中

- 場景明確

這意味着什麼?

意味着只要你的數據裏偶然出現了一些敏感信息,

模型就很容易把它們當成“高價值信號”。

比如:

- 某些真實用户的完整對話

- 內部系統的真實返回字段

- 人工客服在特殊情況下給出的“例外回答”

這些在人工看來是“個例”,

但在模型看來,很可能是:

“這是一個應該被認真學習的模式。”

偶然樣本在微調中被放大的示意圖

第二個放大器:過擬合,本身就是一種隱私風險

很多人談隱私泄露時,第一反應是“模型會不會背答案”。

但在微調場景裏,背答案只是最極端的一種表現。

更常見、也更隱蔽的風險,是:

模型開始在相似問題上泄露相似信息。

這是過擬合在安全層面的直接後果。

舉個例子:

你用了一批真實客服對話做微調,其中包含一些用户身份特徵。

模型未必會原樣複述某個用户的信息,

但它可能會學會一種“默認假設”:

- 在某類問題下,自動補全一些不該出現的背景信息

- 在回答中暴露內部流程或狀態

這類問題,非常難通過簡單測試發現。

一個非常容易被忽略的事實:模型不會區分“能用”和“該用”

這是很多工程師在安全問題上最大的誤判。

人類在使用數據時,會有天然的判斷:

“這條信息我雖然知道,但不該説。”

模型沒有這種意識。

對模型來説,只存在兩件事:

- 這條信息是否有助於降低訓練損失

- 在當前輸入下,它是否“看起來合適”

如果你通過微調數據暗示模型:

“在某些問題下,説這些內容是對的”,

那模型就會毫不猶豫地照做。

微調 vs RAG:為什麼微調的安全邊界更難控制

在很多項目中,安全問題並不是“有沒有”,而是“誰更可控”。

從安全角度看,微調和 RAG 有一個本質區別:

- RAG:信息在模型外部,可隨時撤回

- 微調:信息進入模型參數,幾乎不可刪除

這意味着:

- RAG 出問題,你可以改文檔、改權限、改索引

- 微調出問題,你往往只能:重新訓練一個模型

而且,你很難精確知道:

到底是哪一條數據,導致了哪個行為變化。

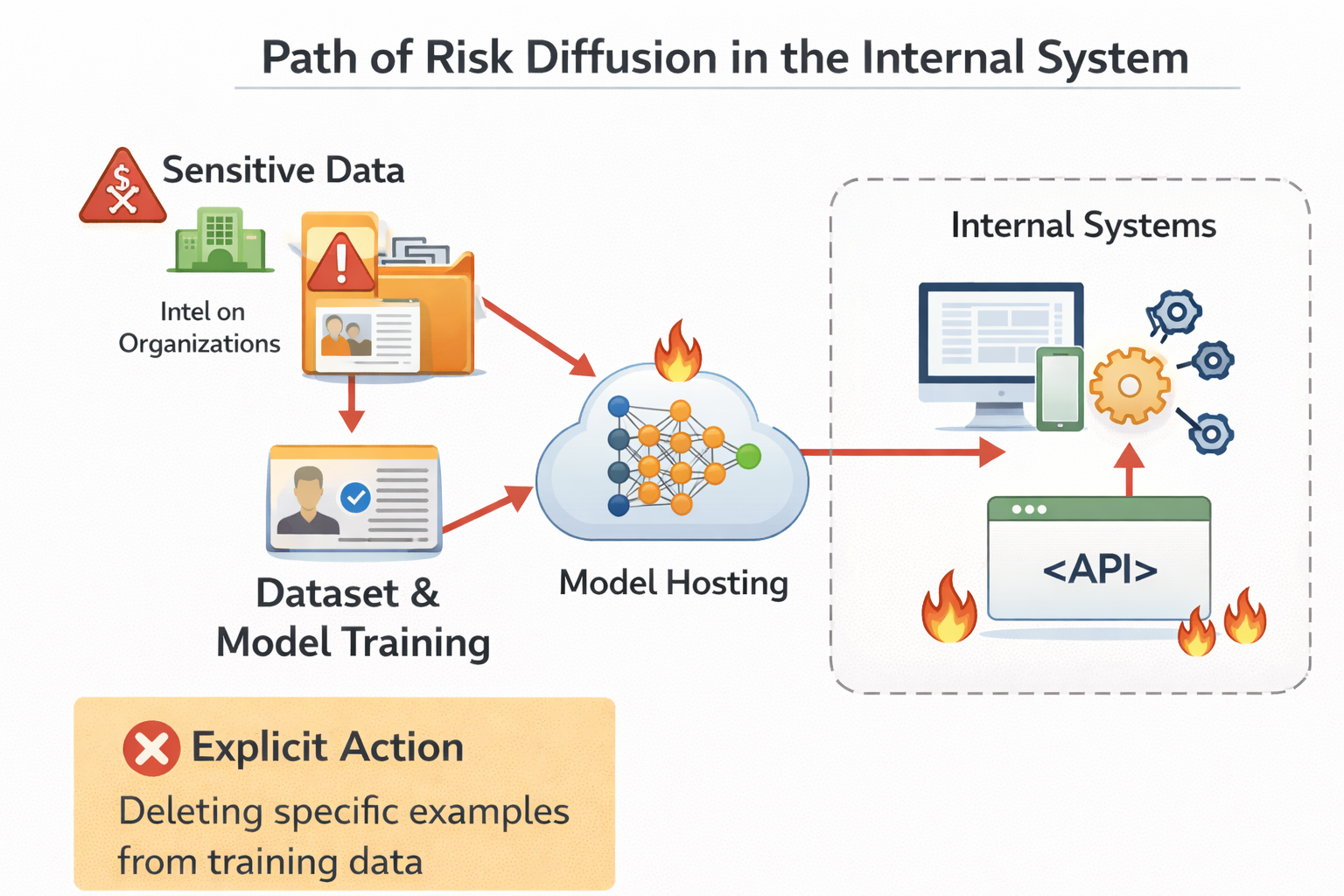

為什麼“只在內部用”並不等於“沒有風險”

這是一個非常常見、也非常危險的心理安慰。

很多團隊會覺得:

“我們這個模型又不對外,只給內部員工用。”

但內部使用,往往意味着:

- 輸入更隨意

- 權限更寬鬆

- 問題更接近真實業務

反而更容易觸發模型的“記憶邊界”。

而且,一旦模型輸出了不該輸出的內容,

內部擴散的速度,往往比外部更快。

內部系統中風險擴散路徑示意圖

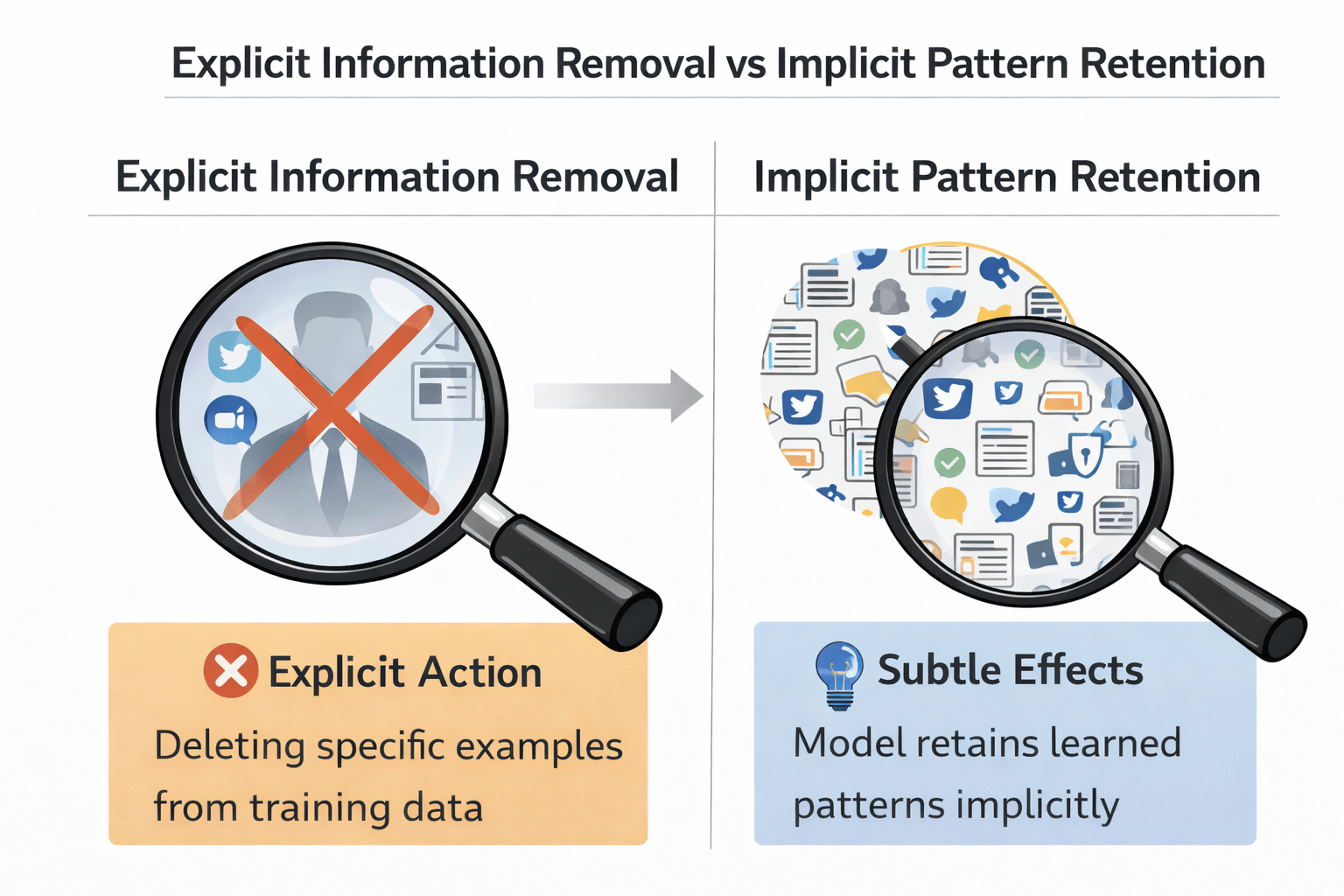

數據匿名化,並不能完全解決微調的隱私問題

很多人會試圖通過“脱敏”來降低風險。

比如:

- 去掉用户名

- 替換 ID

- 模糊時間

這些做法當然是必要的,但遠遠不夠。

因為模型並不只學習“字段值”,

它還在學習結構、關係和默認推斷方式。

你可能已經把名字去掉了,

但模型仍然學會了:

“在這種場景下,可以默認用户具有某種特徵”。

這類風險,是結構性的,而不是字段級的。

顯式信息去除 vs 隱式模式保留示意圖

一個現實問題:你很難“證明模型是安全的”

在微調項目中,安全評估往往面臨一個非常尷尬的處境。

你可以證明模型“在這些測試用例下沒問題”,

但你幾乎無法證明:

“模型在所有情況下都不會泄露不該泄露的東西。”

而微調,恰恰增加了這種不確定性。

因為你改變了模型原本的行為分佈,

卻很難窮舉所有可能被觸發的路徑。

為什麼安全問題,往往在“效果很好之後”才暴露

這是一個非常諷刺、但真實存在的現象。

很多安全問題,恰恰是在你對微調效果最滿意的時候出現的。

原因很簡單:

- 模型越“貼合業務”,

- 它掌握的內部信息和默認假設就越多,

- 可被誤用或誤觸發的空間也就越大。

你可能會發現:

模型確實更聰明瞭,但也更“危險”了。

一個更健康的認知:微調不是免費能力,而是風險交換

如果要用一句話總結微調與安全的關係,那就是:

微調從來不是“白送的能力”,

而是用可控性,換取定製化。

當你接受微調帶來的收益時,你也必須接受一個事實:

風險邊界,變得更加模糊了。

工程上,哪些數據最不該進入微調

結合實際項目經驗,我會非常明確地説:

下面這些數據,哪怕“看起來很有用”,也極不適合直接用於微調:

- 原始用户對話(未充分清洗)

- 帶強身份特徵的樣本

- 內部系統的完整返回結果

- 明顯依賴人工判斷的“特例處理”

這些數據,更適合通過 RAG、規則或人工流程來處理。

高風險數據類型清單圖

一個現實建議:在決定微調之前,先問三個安全問題

在真正開始微調之前,我非常建議你停下來,問自己三個問題:

第一:

如果模型在不合適的場景下輸出了這些內容,我能接受嗎?

第二:

我是否清楚哪些信息一旦進入模型,就無法撤回?

第三:

這個需求,是否真的必須通過微調來解決?

如果這三個問題你都回答不上來,那繼續微調,很可能只是把問題推遲。

在安全敏感場景下,更適合的節奏是什麼

在安全或隱私要求較高的場景中,一個更健康的實踐路徑往往是:

- 先用規則和 RAG 驗證需求

- 再用小規模、嚴格篩選的數據做試探性微調

- 明確評估“行為變化”,而不是隻看效果提升

在這種需要反覆驗證、謹慎試探的階段,使用 LLaMA-Factory online 先進行小規模微調、快速對比模型行為變化,會比一開始就大規模訓練更容易控制風險。

總結:微調不是“危險”,但它會放大你原本就存在的風險

寫到最後,其實結論已經很清楚了。

微調本身不是安全問題的源頭,

但它會:

- 放大數據裏的隱患

- 固化原本的偶然決策

- 提高錯誤行為的觸發概率

真正成熟的團隊,不是“不做微調”,

而是清楚地知道:自己正在用什麼,交換什麼,又承擔什麼。

如果你開始用“風險”而不是“效果”來理解微調,很多之前模糊的問題,反而會變得清晰。