大家好,這裏是架構資源棧!

大家總説模型會 過擬合數據,但很少有人注意到:Prompt 也會過擬合模型。

很多開發者遇到過這種情況:新模型明明更強,但接入後效果不升反降,甚至用户還嫌棄。比如當 Cursor 第一次接入 GPT-5 時,網上一度罵聲一片,直到官方和 OpenAI 一起做了 Prompt 調優,體驗才逐漸反轉。

結論很簡單:

👉 模型升級時,不重寫 Prompt = 用老鑰匙開新鎖,必然卡殼。

下面從三個角度聊聊,為什麼 Prompt 不能一招鮮吃遍天。

1. Prompt 格式差異

不同模型對輸入格式的“偏好”差異巨大。

- OpenAI 系列:從早期到現在,幾乎一直偏愛 Markdown,官方教程和系統提示大多都是這種格式。

- Anthropic Claude 系列:則更適配 XML。Claude 3.5 的系統提示直接就是 XML,因為它在訓練中接觸了大量 XML 數據,自然更懂這一套。

案例:

同樣一段 XML 格式 Prompt,Claude 表現出色,而 GPT-4 可能就完全不行。

所以換模型時,如果你還抱着老 Prompt 不放,就像讓一個沒學過 LaTeX 的人硬讀公式,效果可想而知。

2. 位置偏差(Position Bias)

模型並不會平均對待 Prompt 的每個位置。

- 有的模型更看重開頭;

- 有的模型則對結尾權重更高;

- 甚至同一個模型,在不同語言、不同上下文下,偏好還會變化。

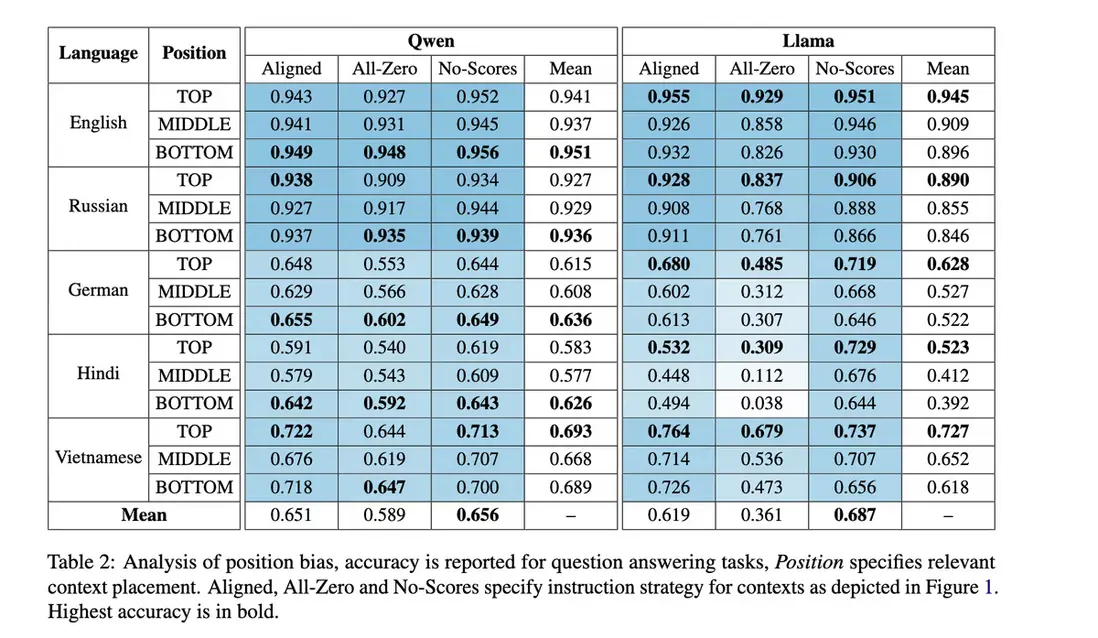

一篇 2025 年的跨語言研究表明:

- Qwen 系列 → 更在意最後的內容;

- Llama 系列 → 更看重開頭。

這意味着:在 RAG 場景下,你放在 Prompt 開頭還是結尾的示例,直接決定了模型能不能答好問題。

3. 模型固有偏差(Model Biases)

除了格式和位置,不同模型本身也有“性格差異”。

- 顯性偏差:比如部分中文大模型會主動規避敏感話題。

- 隱性偏差:有的模型默認話多囉嗦,有的則簡潔直接;有的喜歡生成額外字段,有的更保守。

問題是,大多數人寫 Prompt 時都在 跟模型的偏差作對。

比如反覆加“Be concise”,但如果新模型本身已經足夠簡潔,這些約束就成了贅餘,反而影響效果。

3a. 學會順勢而為

與其強行矯正,不如利用模型的默認傾向。

如果模型總會加幾個 JSON 字段,與其拼命阻止,不如考慮接受並調整下游邏輯,結果可能更穩定。

關鍵結論

- 模型不是“即插即用”的,Prompt 過擬合是常態;

- 每換一個模型,都要 重寫 / 調優 Prompt;

- 甚至在同一模型的升級版本之間,Prompt 也可能需要微調;

- 最佳實踐:寫完就 eval,和模型“磨合”,順着它的天性去設計。

換句話説:

👉 Prompt 就是“模型的 API”,新版本上線,API 可能改了,你不更新調用方式,必然踩坑。

給公眾號讀者的實操建議

如果你在做 LLM 應用,可以嘗試以下三步:

- 對比 Prompt 格式:在新模型上分別用 Markdown 和 XML 測試同一任務,看看差異;

- 測試位置敏感性:調換上下文示例的順序,觀察輸出變化;

- 監控默認風格:比如字數長短、是否愛加説明、輸出結構是否穩定,決定要不要順勢而為。

這樣,你就能快速判斷 是否需要重寫 Prompt,而不是把問題歸咎於“新模型不行”。

喜歡就獎勵一個“👍”和“在看”唄~