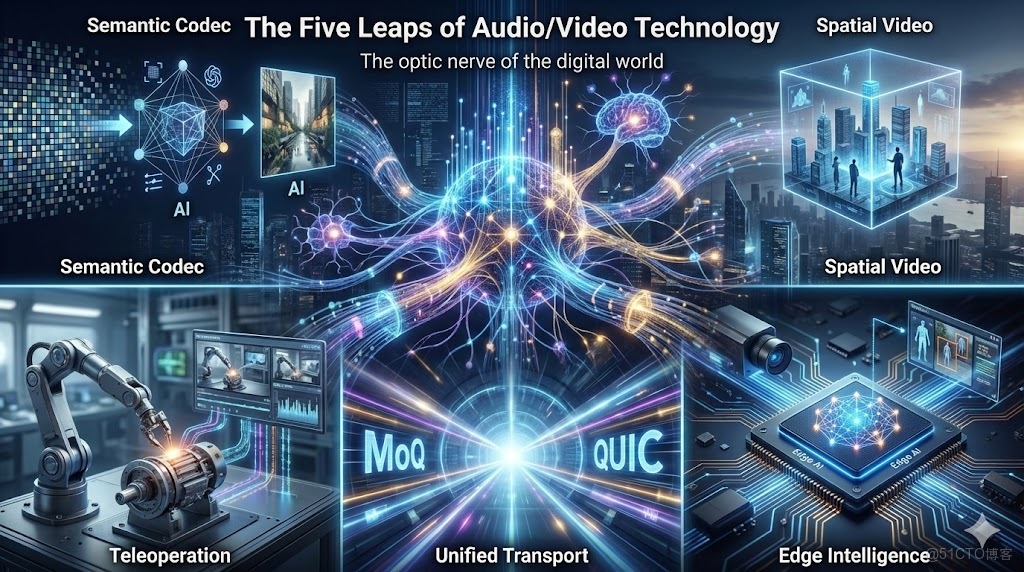

前言

過去十年,音視頻技術的演進幾乎都圍繞同一個方向:

在有限資源下榨出更高畫質、更低延遲和更強穩定性。

我們在帶寬中擠空間、在協議中摳時延、在設備差異裏尋求兼容性。

但到了 2025 年,這條傳統進化路徑正在顯露疲態。

H.266 的壓縮效率提升開始進入“邊際衰減”,WebRTC 的交互延遲觸碰物理極限,1080P 與 4K 成為默認配置,RTMP、SRT、WebRTC 各自的適用邊界也愈發清晰。

“更清晰、更流暢、更低延時”不再是增量優勢,而是行業的基礎設施。

那麼,當傳統指標被捲到極限之後,音視頻的下一步是什麼?

基於 SmartMediakit 在安防、工業、車載、無人機等高要求場景的長期實踐,我們看到的趨勢是:音視頻技術正從“展示”邁向“理解”,從“信號”邁向“數據”,從“人觀看”邁向“機器使用”。

換句話説,它正在經歷一場底層範式的轉向:

- 從傳像素 → 傳語義

- 從二維視頻 → 三維空間

- 從多協議割裂 → 統一傳輸層

- 從觀看畫面 → 遠程操控

- 從 SDK 工具 → 邊緣智能的操作系統

未來五年,音視頻不會被替代,它會進化為數字世界的“視神經”。

以下,是音視頻未來最值得提前理解的五次躍遷。

躍遷一:從“信號壓縮”到“語義還原”——AI-Native Codec 的範式重構

過去二十年,視頻編碼的核心思想始終沒變:

儘可能保留像素信號,在有限帶寬中壓縮出更高的保真度。

H.264、H.265 到 H.266 皆基於同一套數學框架——預測、變換、量化與熵編碼。

但在 AI 時代,這條路徑走到了盡頭。

接下來真正的突破,不再來自更復雜的數學模型,而是來自 編碼哲學的改變:

從“保存信號”轉向“還原語義”。

1. 視頻不再是像素,而是“語義信息流”

AI-Native Codec 的核心思想是:

摒棄逐像素保真,轉而傳輸內容本身的語義結構。

未來的視頻流可能只包含:

- 關鍵結構點(Keypoints)

- 姿態與運動軌跡

- 場景的幾何特徵

- 紋理抽象

- Prompt + 模型參數(供生成器還原畫面)

接收端不再“解碼畫面”,而是利用輕量模型進行 實時生成 / 重建,就像“推送畫面草圖,終端自行繪製高保真圖像”。這是從“壓縮信號”到“重建世界”的遷移。

2. 評價體系全面換軌:從 PSNR 到 LPIPS

在 AI-Native Codec 裏:

- 畫面是否逐像素一致不再重要

- 是否符合人眼與機器視覺的“感知一致性”才重要

LPIPS、FID 等感知指標將取代傳統 PSNR/SSIM。這意味着“模糊但真實”會比“清晰但假”更可接受。

3. 帶寬需求可能下降一個數量級

當推流只推“語義特徵”,而非完整像素矩陣時:

- 數據量將變得更小

- 弱網表現更穩

- 移動端、無人機、車載等場景將迎來質變

音視頻的傳輸能力,將從帶寬限制中被釋放出來。

4. 對 SDK 的真正啓示:從封裝庫到輕推理框架

未來的 SmartMediakit 或同類 SDK,其核心能力將發生改變:

- 端側推理能力(NCNN / MNN / TFLite)成為標配

- 編碼鏈路中直接集成 AI 特徵提取

- 視頻流等於語義流,處理管線全面進化

推流邏輯也將從:

“推像素” → “推信息” → “推數據結構”

這對整個行業都是一次底層範式重構。

躍遷二:從二維畫面到三維場景——Spatial Video 的時代已悄然到來

當視頻仍停留在“平面影像”階段時,我們的交互方式就被平面束縛。

但隨着 Vision Pro、Quest 3 等設備引爆空間計算浪潮,視頻的載體不再是屏幕,而是現實空間本身。

未來的視頻不再是“一張圖”,而是“一處場景”。

1. 視頻將從觀看素材,變成重建空間

空間視頻(Spatial Video)背後真正的價值在於:

- 它讓內容具備 幾何結構

- 讓信息具備 空間維度

- 讓觀看者具備 沉浸視角

這意味着視頻不再是“平面投影”,

而是 世界的輕量復刻。

3DGS(3D Gaussian Splatting)、NeRF、深度推理等技術會成為底層基石,但不需要普通開發者精通其數學本質,只需要知道:

視頻從二維記錄變成三維存在,這是下一代應用的基礎形態。

2. 多攝同步將成為基礎能力

未來的視頻採集將逐漸從單路攝像頭,轉向:

- 多攝陣列

- 深度攝像

- 多角度融合

如何讓多個畫面在時間和空間上保持一致,不是某個“功能點”,而會成為空間視頻時代的基本能力。

3. 傳輸也將從“畫面壓縮”變成“空間壓縮”

當內容載體變成場景,傳輸壓力自然成倍增加。

這時比拼的就不是幀率和清晰度,而是:

- 空間更新速度

- 數據重建效率

- 傳輸鏈路的連貫性

換句話説:

誰能把空間數據傳得順、渲得穩,誰就擁有了新一代終端的入口。

躍遷三:從協議割裂到統一傳輸——MoQ 的體系化重構

過去十年,實時音視頻協議生態呈現出一種“被動多樣性”:

- RTMP:成熟穩健,但歷史包袱大

- HLS:通用性強,但偏向高延遲場景

- WebRTC:實時性優秀,但體系龐大、實現複雜

- SRT:抗抖動能力強,但更偏定製化場景

這些協議生於不同年代、服務於不同需求,因此整個行業被迫面對“多場景、多協議、多實現”的割裂狀態。

這種碎片化本身不是問題,但不斷增加的業務要求——移動性、多路協同、弱網環境、大規模分發——讓這種割裂逐漸成為瓶頸。

MoQ(Media over QUIC)正是在這個歷史節點出現的:

它不是為了替代某個協議,而是為了從底層統一整個流媒體體系。

1. MoQ 的意義不是“又一個協議”,而是“為現代互聯網重寫傳輸層”

MoQ 的價值不在於與 RTMP/WebRTC/SRT 競爭,而在於:

- 將 實時傳輸 與 內容分發 收斂到同一框架

- 把音頻、視頻、信令與元數據整合為統一語義層

- 簡化現代音視頻管線中冗餘且重複的傳輸邏輯

- 提供一個真正面向“互聯網原生”的媒體底座

換句話説,它讓應用層不必再糾結於“該選 RTMP 還是 WebRTC”,

因為 流媒體的根問題被下沉到了傳輸層本身。

MoQ 不是新品,它是一次體系級重建。

2. MoQ 讓“流”變成統一的數據結構,而非協議碎片

基於 QUIC,MoQ 天生具備:

- 多路複用

- 無隊頭阻塞

- 更穩定的弱網表現

- 更可控的延遲

- 更一致的資源管理方式

在 MoQ 中,多個媒體軌(音頻、視頻、字幕、控制指令)不再是“各自獨立的協議實現”,

而是一個統一語義的數據結構。

這對實時音視頻尤其關鍵:

不再因為某條子流擁塞而阻塞整個傳輸,不再需要為每條軌道單獨實現策略。

本質上:

MoQ 不是在“傳視頻”,而是在“統一媒體數據”。

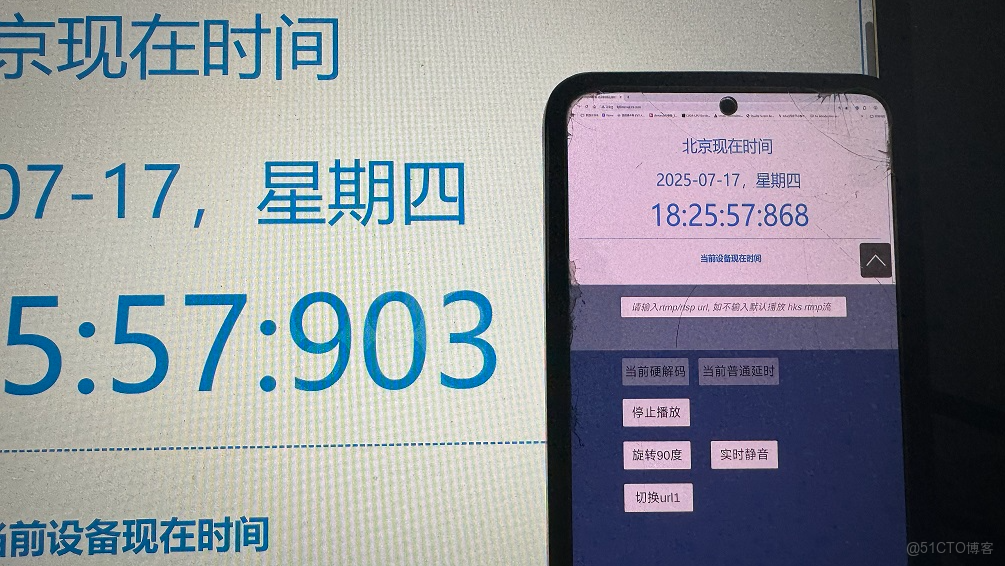

3. SmartMediakit 的工程經驗:傳統協議已經被挖到極限,但體系升級仍然必要

SmartMediakit 在多年安防、工業、車載、無人機等真實落地場景中已證明:

在 RTSP、RTMP 體系下,通過深度優化仍能穩定實現 100–200ms 的端到端延遲。

並且不是實驗室數據,而是在:

- 公網

- 移動網絡

- 弱網

- 複雜環境

- 多設備異構環境

下長期穩定運行的真實表現。

這是傳統協議棧經過十多年工程經驗、緩衝策略、調度機制、跨平台適配“打磨出來的極限能力”。

但同樣需要看到:

傳統協議之所以能達到這個水平,是靠工程堆棧做到“極致可用”,

而不是因為協議本身足夠現代。

移動網絡切換、車載高速移動、多路協同、媒體+控制的同步需求……

這些新場景都已經超出了傳統協議誕生時的設計邊界。

因此:

- SmartMediakit 已經把 RTSP/RTMP 的潛力發揮到極致(100–200ms 穩定低延遲)

- MoQ 則代表下一代協議的“正常形態”,減少對工程經驗的過度依賴

它們的關係不是取代,而是 “現有極限” → “未來體系” 的自然演進。

總結:MoQ 讓穩定性從“調優能力”變成“體系能力”

傳統協議時代,秒開、弱網穩定、跨網絡一致性,

都依賴 SDK 廠商的大量經驗與調優。

MoQ 出現後,這些能力有機會下沉到傳輸層本身,

讓實時體驗從“工程技巧”變成“協議特性”。

對 SmartMediakit 而言,這不是威脅,而是機遇:

它意味着能在更現代、更乾淨的底層上,構建更強的實時鏈路能力。

躍遷四:從觀看畫面到操控世界——Teleoperation 才是真正的增量市場

視頻的上半場是娛樂,下半場是生產力。

未來五年,音視頻增長最快的賽道不會是直播,而是 實時操控類場景(Teleoperation):

- 無人機巡檢

- 遠程機械協作

- 工業臂示教

- 危險環境的可視化操作

- 車載輔助與遠控應用

這些場景與傳統視頻最大的不同在於:

視頻不是讓人“看”的,而是讓系統“行動”的。它從展示層變成了反饋層。

1. 在 Teleoperation 中,視頻是一條“操作鏈路的一部分”,而不是單純內容

真實的工程世界裏,延遲不是越低越好,而是越 穩定 越重要。

對於絕大多數工業可視化、安防監控、車載探測、移動終端等場景,100–200ms 的端到端延遲已是成熟、可落地、可靠的行業標準。

SmartMediakit 的 RTSP/RTMP 播放器在多年的落地場景中已經證明:

即便在公網、弱網、移動網絡等複雜環境下,

仍能將鏈路穩定保持在這一延遲區間,並同時保證:

- 畫面連續

- 緩衝穩定

- 弱網可控

- 操控“手感”自然

這類“穩定低延遲”遠比極端數值更關鍵。

對於特定的工業遠控應用(如精密操控、機械臂示教),

進一步壓縮延遲通常依靠:

- 專線/局域網

- 私有協議

- 深度定製的緩存策略

但這屬於特定場景的工程定製,並不是實時音視頻的普適門檻。

換句話説:

Teleoperation 的核心不是追求極限數字,而是讓系統在真實世界裏“可操作、可預期、不中斷”。

2. 通用協議無法滿足真實世界的操控需求

會議軟件為了保證“看得順”,往往增加緩衝、加大平滑策略。

但在操控鏈路中,這些策略反而適得其反。

工業級 Teleoperation 需要:

- 足夠連貫(不跳變、不頓挫)

- 足夠可控(延遲可預測)

- 足夠穩態(網絡波動不造成斷鏈)

通用協議無法保證這些,因此垂直 SDK(如 SmartMediakit)才能在這裏承擔核心角色:

- 允許按場景重寫緩存策略

- 按實時性要求調整丟包處理

- 在極端弱網中維持鏈路連續性

- 對視頻與動作之間的協同進行微調

這類“場景級調優”是行業真正的壁壘。

3. Teleoperation 的規模化,將重塑“實時”的行業定義

過去我們定義實時:

“儘可能快。”

未來我們定義實時:

“快得足夠自然,穩得足夠可控。”

這是一種從“編碼指標”向“系統體驗”的遷移。

它意味着音視頻不再是一個單獨模塊,而是整個操作鏈路的一部分。

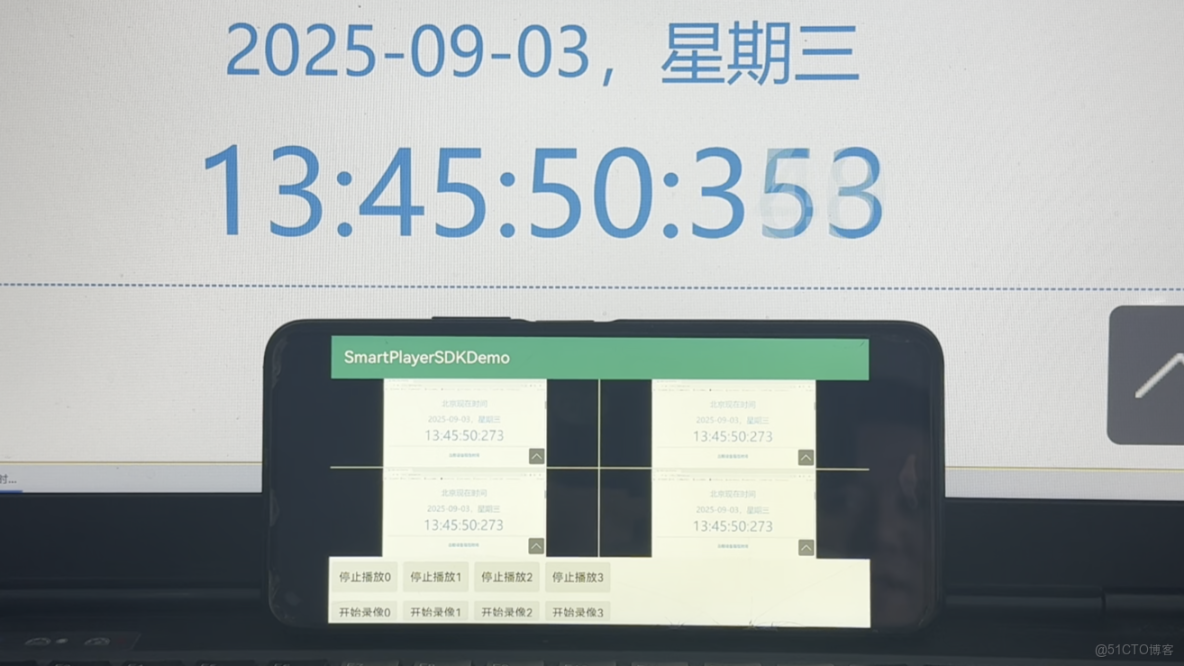

躍遷五:從 SDK 到邊緣智能系統——未來是 Edge-Integrated Streaming

NPU 正在成為終端標配,如今的手機、工業相機、XR 設備、車載平台都具備端側推理能力。

這使音視頻的角色從簡單的“通路層”,變成 “邊緣智能的入口”。

1. SDK 的邊界會持續外擴

未來的音視頻 SDK(如 SmartMediakit)不只是:

- 採集

- 編碼

- 傳輸

- 渲染

它還將承擔:

- 輕量化模型推理

- 畫面增強

- 隱私處理

- 實時檢測與篩選

- 數據結構化(metadata pipeline)

它會更像一個 輕量操作系統(Edge OS),負責調度:

- CPU

- GPU

- NPU

- VPU

並確保設備在功耗、發熱、算力之間取得平衡。

2. “算力在哪裏,音視頻就在哪裏”

當終端具備智能能力:

- 視頻不再只是被上傳,而是被“處理後上傳”

- 雲不再承擔全部分析,而是做最終決策

- 邊緣端成為新的計算中心

這將徹底重構行業架構。

3. 未來的競爭不在於能否“跑視頻”,而在於能否“調度設備本身”

這就是邊緣智能時代音視頻 SDK 的終極形態:

它是數據入口、計算調度器、鏈路管理者,也是未來智能系統的第一環。

結語:真正的進化,不在技術,而在視角

回看過去十幾年,音視頻行業的競爭,大多圍繞清晰度、延遲、兼容性等傳統指標展開。

但未來五年,這些將不再是核心戰場。

它們會變成基礎能力,像水、電、網絡一樣“理所當然”。

真正的競爭,將發生在更深層的地方:

誰能把視頻從畫面變成數據?

誰能讓鏈路從傳輸變成理解?

誰能讓端側從渲染變成智能?

誰能讓現實世界被數字世界真實地、穩定地復刻進去?

這意味着音視頻不再是一個“技術模塊”,

而是在 AI 時代承載 感知、行動、協作、空間重建 的基礎設施。

在這條進化軌道上,通用能力會被 AI 迅速補齊,

但那些與物理世界深度綁定、與場景複雜性交織、與設備異構性緊密耦合的部分——

反而會變成新的稀缺資源。

這正是 SmartMediakit 的位置所在:

不是與 AI 競爭誰能寫更多代碼,而是負責把真實世界的每一幀、每一毫秒、每一次動態,

以最高的可靠性、最低的代價、最適合機器理解的方式,送入智能系統的入口。

當視頻成為數據,當空間成為接口,當邊緣成為算力中心,

音視頻技術的角色也將徹底改寫:

它將成為整個智能時代的“視神經”,

連接真實世界與數字世界的橋樑。

未來五年,音視頻不會消失,更不會被替代——

它會變得更底層、更關鍵、更不可或缺。

我們正站在一個時代交匯點:

不是“視頻如何做得更好”,

而是“如何讓世界被機器看到得更準、更完整、更實時”。

這,就是下一代音視頻技術的真正方向。