在過去的十多年裏,大牛直播SDK(SmartMediakit)幾乎只做了一件事:把音視頻的採集、傳輸與播放這條鏈路,磨到“可用”、磨到“穩定”、再磨到“可控”。

我們見證了 RTMP 從 Flash 時代的霸主,變成移動直播的事實標準;也見證了 RTSP 在安防與工業領域長盛不衰。更重要的是,我們在數萬個開發者的真實業務裏,看到了一個清晰的分叉點:

音視頻的下一個 5 年,不再屬於“娛樂敍事”,而屬於“控制敍事”。

過去的成功指標,是“用户能不能看清楚、看不卡、看得久”;

未來的生死指標,是“系統能不能在足夠短的時間裏完成一次閉環”:感知 → 決策 → 行動。

如果説過去我們是為了讓用户看清楚直播間裏的口紅色號,那麼未來,我們的客户更在意的是:礦山挖掘機的操作者、低空物流飛手、手術室的遠程會診、以及流水線上的質檢算法,能不能做到“看見即反應”、甚至“看見即控制”。

這篇文章,我們不討論“又一個協議”或“又一個參數”。我們嘗試從工程事實出發,講清楚一個判斷:

不做極致低延時,音視頻廠商的技術護城河會被迅速抹平;做到了極致低延時,音視頻會從“內容基礎設施”升級為“工業操作系統的神經系統”。

一、重新定義“實時”:從秒級到毫秒級,是兩個物理世界

在泛娛樂直播時代,3 秒延時是行業慣例。甚至很多場景裏,5 秒也不是問題:彈幕慢一點、互動遲一點,用户不會付出真實代價。

但當業務從“觀看”走向“控制”,時間的意義就變了。

- 在遠程操控裏,3 秒等於事故:挖掘機一剷下去,畫面還停留在三秒前,你控制的不是機器,而是“歷史回放”。

- 在低空經濟裏,3 秒等於越界:無人機避障、測繪、巡檢、投送,每一個動作都在“運動系統”裏發生,延遲放大的是動能風險。

- 在工業質檢裏,3 秒等於報廢:流水線不會等你,算法看見缺陷時,產品可能已經進入下一個工位。

所以我們認為,未來音視頻會出現一條新的行業分水嶺——不是“清晰度”,不是“併發量”,而是延時等級。

我們把它粗暴地劃成兩條線:

- 交互級低延時(< 400ms)

適用於在線教育、會議、指揮調度、客服對話。你需要的是“對話自然”,允許輕微緩衝換取穩定。 - 操控級極致延時(< 200ms,且越低越好)

適用於遠程駕駛、無人機圖傳、精密機械臂、具身智能遙操作。你需要的是“時效第一”,寧可瞬間花屏/丟幀,也不能滯後。

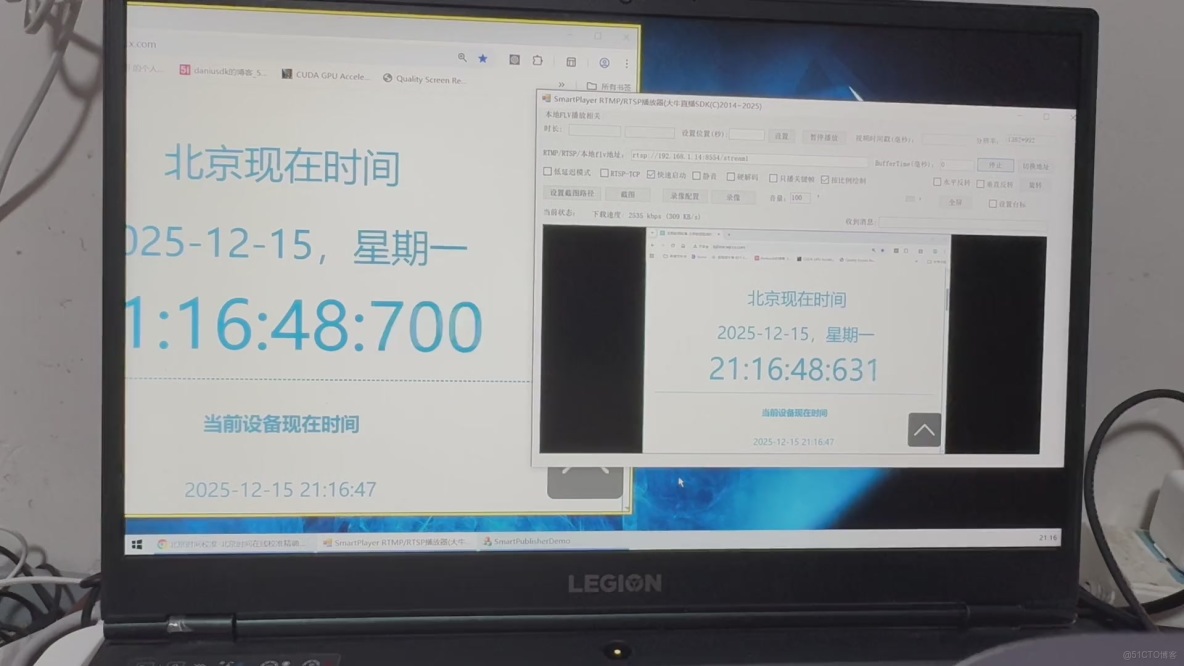

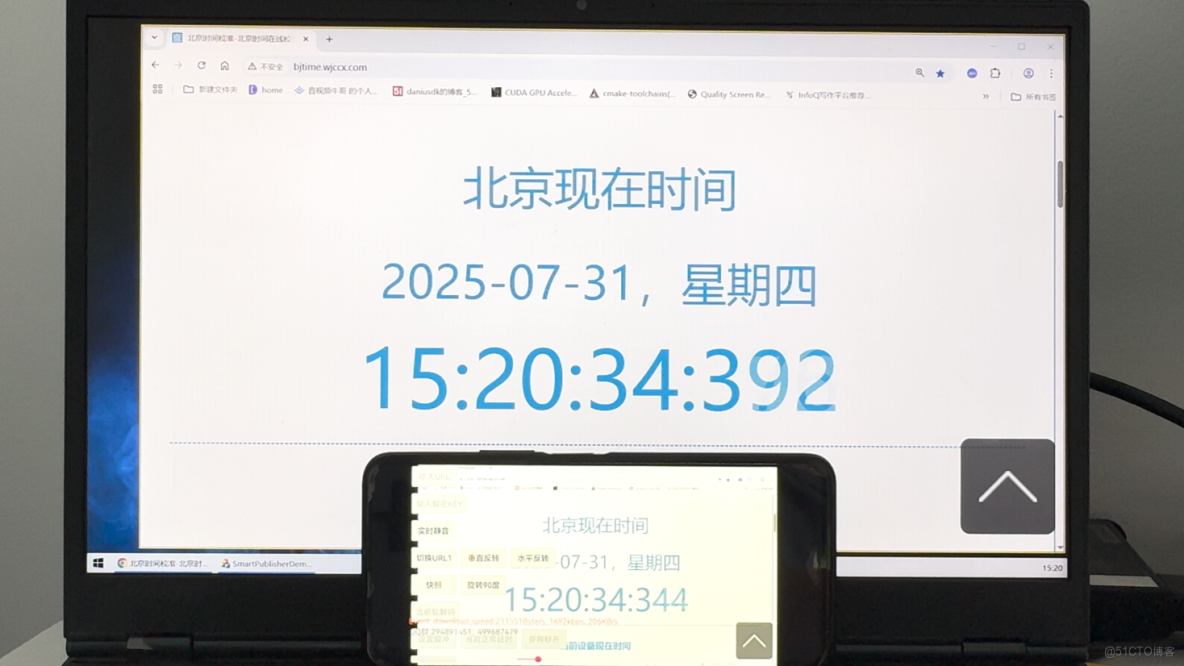

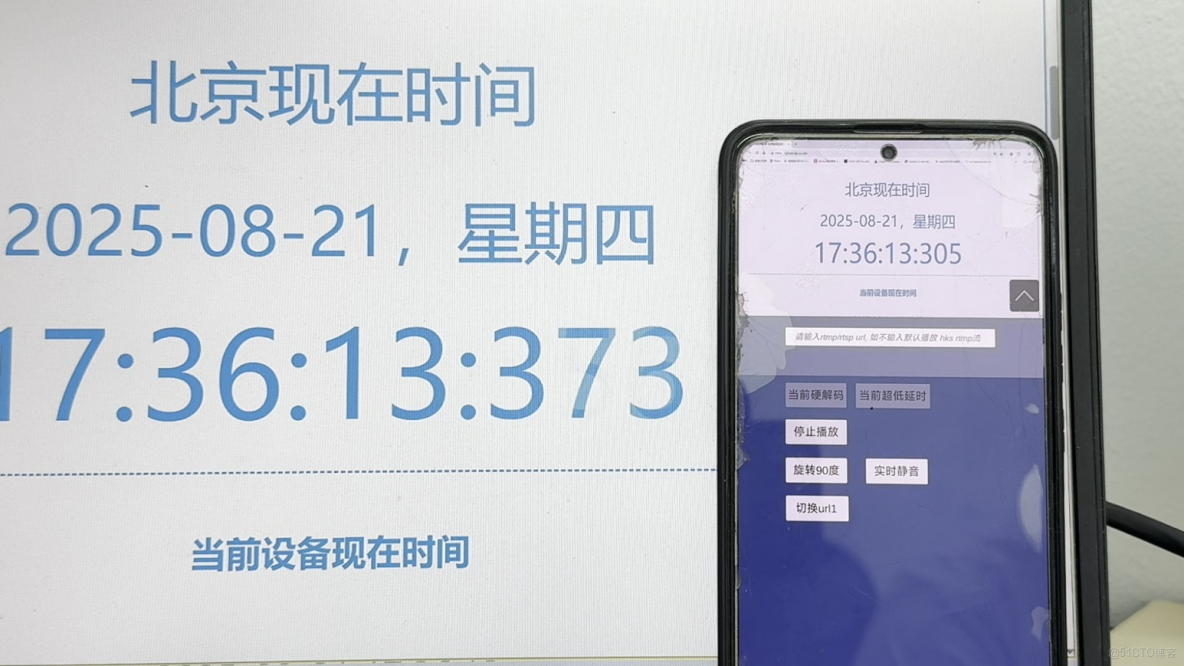

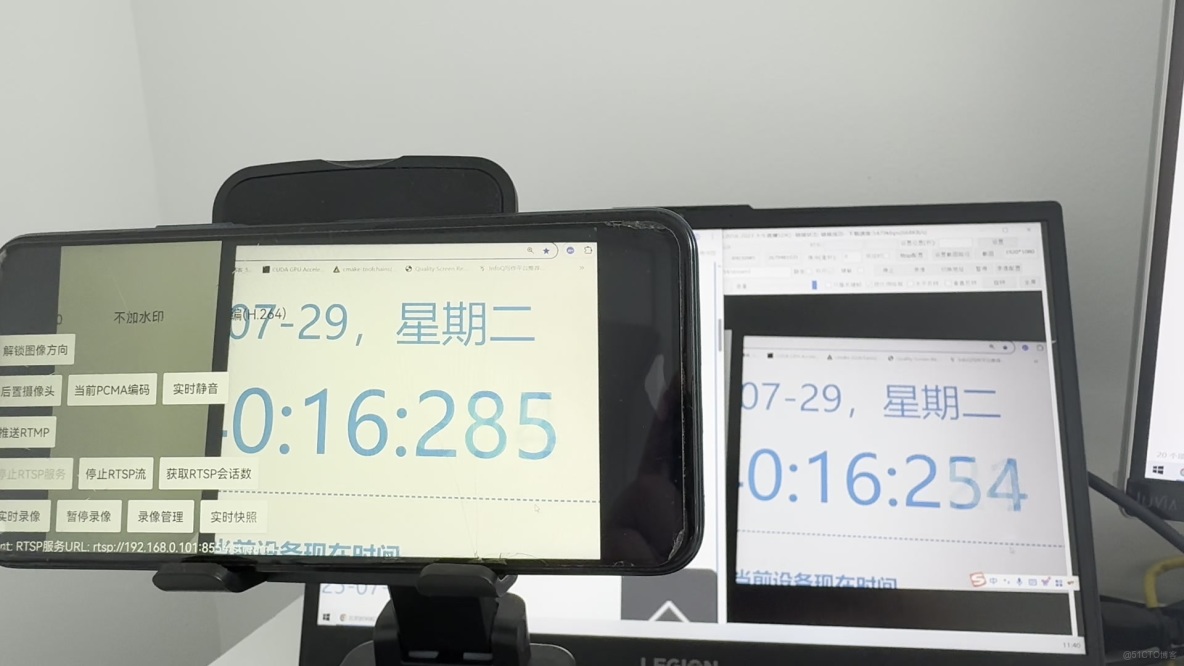

SmartMediakit 的主戰場,就是 100-200ms區間延遲。

而且更殘酷的事實是:你一旦進入操控場景,“低延時”不是一個開關,而是一整套工程體系——要麼全鏈路一起變快,要麼局部再快也沒意義。

二、為什麼開源方案很難做到?因為它的目標函數不是“現在”

很多開發者會問:“我用 FFmpeg 等各種開源播放器堆起來,為什麼延時總是 1 秒以上?”

原因並不神秘:通用開源方案默認追求的是“連續性”和“觀感”,而不是“時效性”。

它們的默認策略,往往是:

- 多攢一點緩衝,避免抖動導致卡頓

- 寧可慢一點,也要穩定播放

- 音視頻同步優先,寧可讓視頻等音頻

這些策略在“觀看內容”時是對的,但在“控制物理世界”時幾乎是錯的。

操控場景的正確目標函數應該是:

畫面必須儘可能靠近“當前時間”,哪怕為此丟掉過去的幀。

這意味着:

低延時不是“把 buffer 調小”,而是要把採集、編碼、傳輸、抖動處理、解碼、渲染、音畫同步策略,全部重寫成“面向實時”的邏輯。

這也是商業 SDK 的價值所在:我們做的不是功能拼圖,而是長年累月的“髒活”和“手術”。

三、拆解黑盒:我們如何在全鏈路裏“摳”出時間?

很多人談低延時,會把注意力放在“網絡快不快”。但在大量真實終端場景裏,延時更像是一種“系統性債務”:它會在採集、編碼、傳輸、緩衝、解碼、渲染每一環裏一點點累積,最後變成肉眼可見的滯後。

要把延時壓到“操控級”,靠的不是某一個神奇參數,而是一套貫穿全鏈路的工程取捨:寧可犧牲部分觀感與完美性,也要確保時間軸儘量貼近“現在”。

1)採集與編碼:第一公里決定上限

很多團隊的誤區是:以為“源頭沒問題”,實際上終端側最常見的延時來自兩件事:

- 數據在不同模塊之間被反覆搬運、轉換

- 編碼器為了“效率/質量”天然傾向於引入等待與緩存

(1)減少無意義的搬運:讓數據少繞路

我們更關注“路徑是否足夠短”,而不是某一個接口是否調用成功。終端側的關鍵原則是:

- 能不復制就不復制,能不轉換就不轉換

- 讓數據儘量在更貼近渲染/編碼的路徑裏流動

- 把“額外的中間態”壓到最低

對低延時而言,這類優化的價值不在於“某一次能省多少毫秒”,而在於它會顯著降低系統波動時的延時放大效應:當負載上來、GC/內存抖動出現時,你的鏈路不至於因為搬運過多而崩掉。

(2)編碼“實時化”:把編碼器從“追求完美”拉回“追求時效”

在內容分發場景裏,編碼器的目標往往是“更高壓縮效率、更穩定畫質”;但在操控場景裏,編碼器更應該服務於兩個目標:

- 儘量減少“必須等待”的結構(避免形成隊列)

- 在波動出現時,優先保證“當前幀能及時出去”

因此,我們更傾向於採用一類“面向實時”的編碼策略:讓編碼器不要為了更漂亮的畫面去積攢太多歷史、不要為了更高的壓縮比去引入更深的依賴鏈。簡言之:

把編碼器從“內容生產模式”,拉回到“控制信號模式”。

2)傳輸與抗抖:弱網不可怕,可怕的是“越播越慢”

操控場景的真正敵人往往不是丟包,而是“堆積”。

一旦鏈路出現波動,數據在某個環節開始排隊,如果系統選擇“把隊列播完”,延時就會進入一種自我強化的狀態:越慢越積、越積越慢。

(1)追趕時間軸:不要温柔地播放歷史

當延時出現明顯累積時,我們更強調一種“及時糾偏”的機制:與其讓系統穩定地播放過去,不如在合適的策略下,儘快把時間軸拉回接近實時的位置。

這種做法的核心不是“激進”,而是“正確性”:在操控場景裏,畫面是否順滑往往是次要的,畫面是否接近“此刻”才是第一性。

(2)協議不是關鍵,關鍵是實現是否為“實時”而生

很多討論會陷入“選哪個協議更低延時”,但工業落地裏常見的現實是:協議本身差異有限,真正決定效果的是:

- 數據組織與處理是否高效、是否引入不必要等待

- 在不同網絡形態下,系統是否具備自適應能力

- 延時指標是否可觀測、可定位、可驗證

低延時不是某個協議贏了,而是整套傳輸鏈路的目標函數變了:從“儘量完整地傳到並播放”,變成“儘量及時地傳到並保持貼近現在”。

3)解碼與渲染:最後一公里決定“能不能反應”

很多系統前面做了一堆低延時努力,最後卻在“上屏”這一步把時間又還回去:解碼出來了,但渲染路徑慢、線程阻塞、額外拷貝,最終表現就是“看起來還是慢半拍”。

(1)硬件加速的意義:不是更強性能,而是更短路徑

我們更關注的是“從解碼輸出到顯示呈現”的路徑長度與阻塞點是否足夠少。低延時場景裏,真正致命的不是平均耗時,而是:

- 某些時刻的阻塞導致隊列形成

- 隊列一形成,延時就很難自動回到低位

(2)沉重的同步接口:往往是隱藏的延時税

在一些引擎或跨平台環境裏,最容易踩坑的是那些“看似簡單但同步阻塞”的更新路徑:它們在壓力不大時不明顯,一旦遇到高分辨率、高幀率或系統負載波動,就會成為延時放大的觸發器。

因此,我們更傾向於採用更貼近圖形管線的方式,讓視頻幀儘量“直接參與渲染”,減少跨線程、跨內存域的同步與等待。

四、趨勢預測:未來 5 年,音視頻會從“內容管道”變成“人機系統的反射弧”

1)協議進入“混血時代”:單一協議會越來越少見

未來不會是“RTMP vs WebRTC”這種站隊題,而是:

- 內網/專網:RTSP、GB28181 仍然強勢(工程存量 + 行業標準)

- 公網/多端:WebRTC、HTTP-FLV/WS-FLV、以及更多“可穿透/可擴展”的形態會變成標配

- 更關鍵的是:協議互轉能力會成為基礎設施能力

老舊 RTSP 攝像頭也必須能被瀏覽器、移動端、調度大屏“毫秒級接入”,否則存量資產就會被淘汰。

2)邊緣計算 + SDK:終端會長出“小腦”,不是隻做傳輸

過去 SDK 是“管道”,未來 SDK 會變成“端側智能的接口層”:

- 推流前做遮擋、脱敏、區域裁剪

- 端側做安全帽/煙火/缺陷檢測

- 只回傳“關鍵片段”或“結構化事件”,把帶寬和時延預算留給更重要的動作

一句話:視頻即傳感器,SDK 即邊緣算力的實時總線。

3)具身智能會反向定義音視頻:不是“播得好”,而是“閉環快”

當具身智能、遙操作、機器人進入工業現場之後,音視頻系統會被新的需求反向塑形:

- 端到端延時需要可測量、可承諾、可驗收

- 異常時要“降級但不失控”:畫質降、幀率降,但不能失去“現在”

- 系統要具備可觀測性:延時、抖動、丟包、追幀次數、關鍵幀間隔,都要可視化

這會把音視頻從“媒體技術”推向“控制系統工程”。

五、盈利模式:未來賣的不是“授權”,而是“可承諾的延時與可靠性”

當音視頻真正進入工業與控制領域,客户的採購邏輯會發生根本性的轉變。

在傳統內容分發或泛娛樂場景中,採購關注點往往集中在功能清單:

是否支持 RTSP / RTMP?是否支持硬解?是否支持錄像與回放?

但在工業、能源、醫療、低空等場景中,這類問題只屬於“入場門檻”。真正進入決策核心的,是另一組問題:

- 在我的網絡條件與設備環境下,系統的端到端延時大致處於什麼區間?

- 當網絡波動或負載異常時,系統的行為是失控、堆積,還是可預期地自我調整?

- 延時、穩定性、可用性,能否被量化、被驗證、被長期維持?

- 這些指標,是否可以寫入 SLA,並在實際運行中持續達標?

這意味着,音視頻系統正在從“功能型軟件”,走向具備工程責任的工業級系統。

1)延時等級 SLA:為“確定性”付費

在控制型場景中,客户真正購買的並不是“某個協議支持”或“某項功能開關”,而是系統行為的確定性。

例如:

- 在絕大多數運行時間內,端到端延時被穩定控制在某一可接受區間

- 在異常發生時,系統的退化路徑是可預期、可監控、可恢復的

- 指標不是一次性測試結果,而是長期運行下的統計結論

這種“延時等級”的承諾,本質上已經接近工業軟件的 SLA 模式。

它背後依賴的不是某個參數,而是一整套長期工程能力的積累:對複雜網絡環境的適應能力、對異常場景的處理策略、對運行狀態的可觀測性,以及持續演進和維護的能力。

客户為此付費,本質上是在購買一種風險可控性。

2)私有化超低延時視頻中台:交付的是“可運行的體系”

在央國企、能源、軍工等行業,公有云往往並非選項,數據合規與網絡隔離是剛性前提。

在這種背景下,音視頻能力更傾向於以“系統組件”的形式,完整地交付到客户內網環境中。

這類私有化部署,關注的不只是“能不能跑”,而是:

- 是否能夠在複雜內網環境中長期穩定運行

- 是否具備統一接入、分發、協議適配、存儲與審計能力

- 是否便於運維、升級、擴展,並與現有業務系統協同

從商業視角看,這類方案的價值不在於一次性交付,而在於持續運行與持續服務。

客户購買的不是一段代碼,而是一套能夠長期承擔關鍵業務的視頻基礎設施;相應的,商業模式也自然從“授權費用”轉向更長期的運維與服務價值。

六、結語:快,不再是體驗指標,而是系統正確性

在很長一段時間裏,我們談“快”,更多是圍繞體驗:畫面是否順滑、操作是否跟手、觀看是否舒服。延時高一些,最多影響的是滿意度。

但當音視頻開始進入工業與控制領域,“快”不再只是體驗問題,而是系統是否做出正確反應的問題。

慢一點,意味着動作與現實脱節;慢得足夠多,錯誤就會被不斷放大,最終演變成風險與事故。

未來的世界,將是一個物理系統與數字系統高度糾纏的世界:無人機在空中運動,機器人在現場執行,攝像頭持續感知環境,算法不斷給出判斷,操作者在遠端下達指令。

在這樣的系統裏,音視頻不再是“展示層”,而是連接感知、決策與執行的關鍵通道。

真正決定系統上限的,不是更高的碼率,也不是更復雜的功能,而是:信息是否足夠接近“現在”。

這也是大牛直播SDK(SmartMediakit)始終堅持的方向。我們願意把大量精力投入到那些並不顯眼、卻決定成敗的細節裏:在採集、編碼、傳輸、解碼、渲染的每一個環節,儘量減少不必要的等待,讓端到端時間儘可能貼近物理世界本身。

這條路並不討巧,也不容易被簡單的參數對比體現出來,但它決定了音視頻系統能否真正進入“控制級應用”的核心場景。

如果你正在構建遠程操控、工業巡檢、低空經濟、具身智能等系統,不妨換一個視角來看音視頻:

不要只把它當作播放器或傳輸工具,而把它當成你係統的反射弧。

感知是否及時,決定了行動是否正確。

而這,才是下一個時代真正稀缺的能力。