視頻演示

基於深度學習的35種鳥類測系統演示與介紹

1. 前言

在自然與科技深度交織的時代,我們對周遭生命的觀察與認知,正被算法悄然拓展邊界。鳥類作為生態系統中靈動的註腳,其多樣性與分佈狀態不僅是自然研究的課題,更牽動着無數觀鳥愛好者、生態保護者的目光。然而,傳統的人工觀測與識別方式,常受限於經驗門檻、效率瓶頸,難以應對複雜場景下的精準捕捉——當鏡頭掠過林梢、水面或城市綠地,那些轉瞬即逝的身影,如何被清晰記錄並準確命名?

技術的演進給出了新的可能。計算機視覺領域的目標檢測算法,正以“讓機器看懂世界”的能力,為生物識別注入新的活力。其中,YOLO系列算法憑藉高效的實時性與精準的定位能力,成為連接圖像像素與語義信息的關鍵橋樑。將這一技術落地於鳥類檢測場景,不僅能突破人眼觀察的侷限,更能為生態監測、物種保護乃至科普教育提供可量化的工具支撐。

我們聚焦的這套系統,正是圍繞“35種鳥類檢測識別”展開的具象實踐。它不止於簡單的“看見”,更試圖構建從圖像/視頻輸入、多源數據處理到結果可視化與交互的全流程能力——無論是單張照片裏的駐足身影,還是視頻流中的振翅軌跡,抑或是攝像頭實時捕捉的動態畫面,系統都能快速框定目標、判別種類,並以直觀的界面反饋關鍵信息;而模型切換、參數調節、類別統計與過濾等功能的設計,則讓技術更貼近實際使用需求,兼顧靈活性與易用性。此外,從用户登錄管理到模型訓練支持,從腳本化批量檢測到個性化信息維護,系統的功能延伸亦指向更完整的應用閉環,試圖讓技術真正“可用”“好用”。

接下來,我們將通過功能拆解與實操演示,呈現這套系統如何將YOLO算法的潛力轉化為具體的鳥類識別能力,也期待它能為探索自然與科技融合的更多可能,提供一個可觸摸的樣本。

2. 項目演示

2.1 用户登錄界面

登錄界面佈局簡潔清晰,左側展示系統主題,用户需輸入用户名、密碼及驗證碼完成身份驗證後登錄系統。

2.2 新用户註冊

註冊時可自定義用户名與密碼,支持上傳個人頭像;如未上傳,系統將自動使用默認頭像完成賬號創建。

2.3 主界面佈局

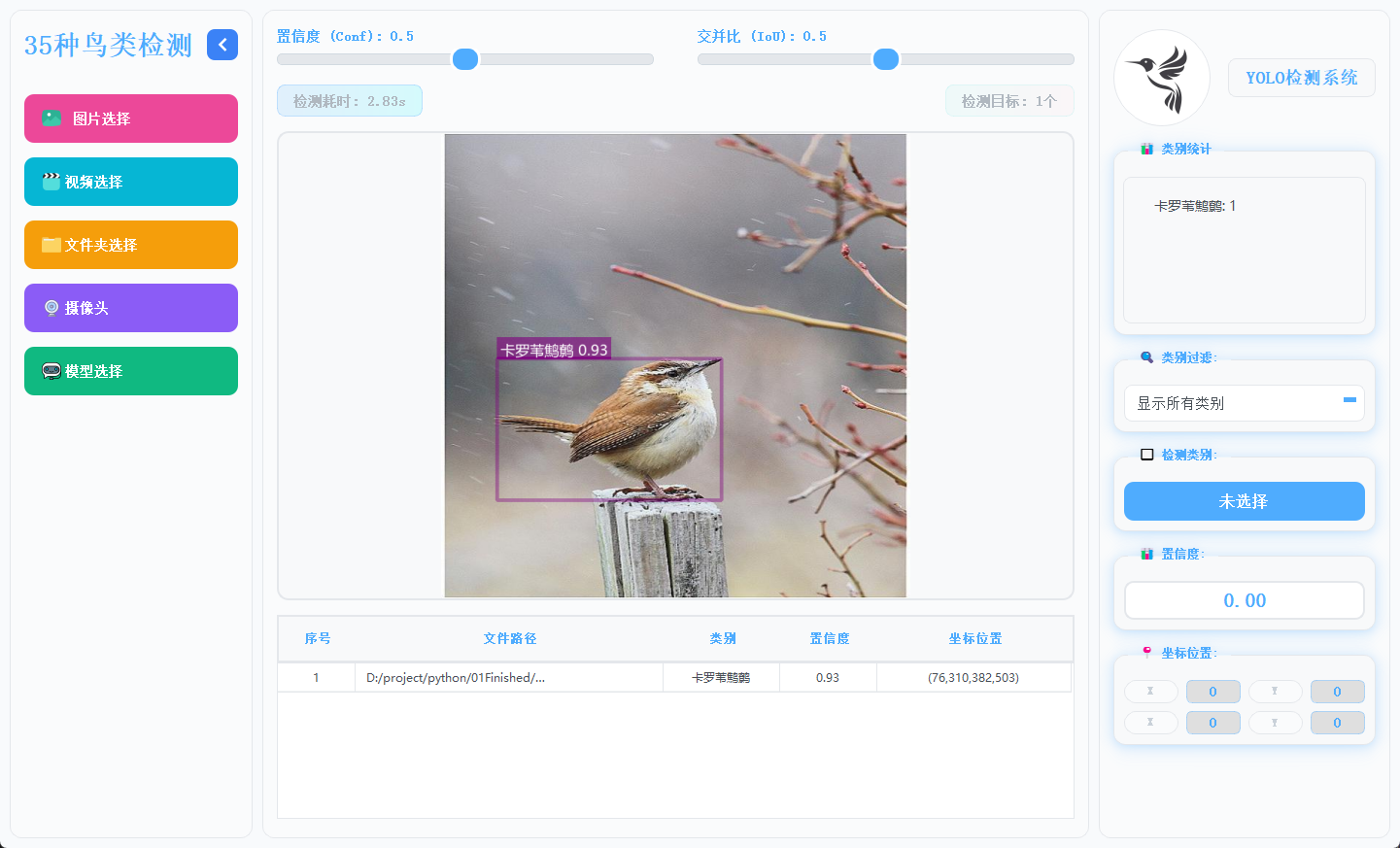

主界面採用三欄結構,左側為功能操作區,中間用於展示檢測畫面,右側呈現目標詳細信息,佈局合理,交互流暢。

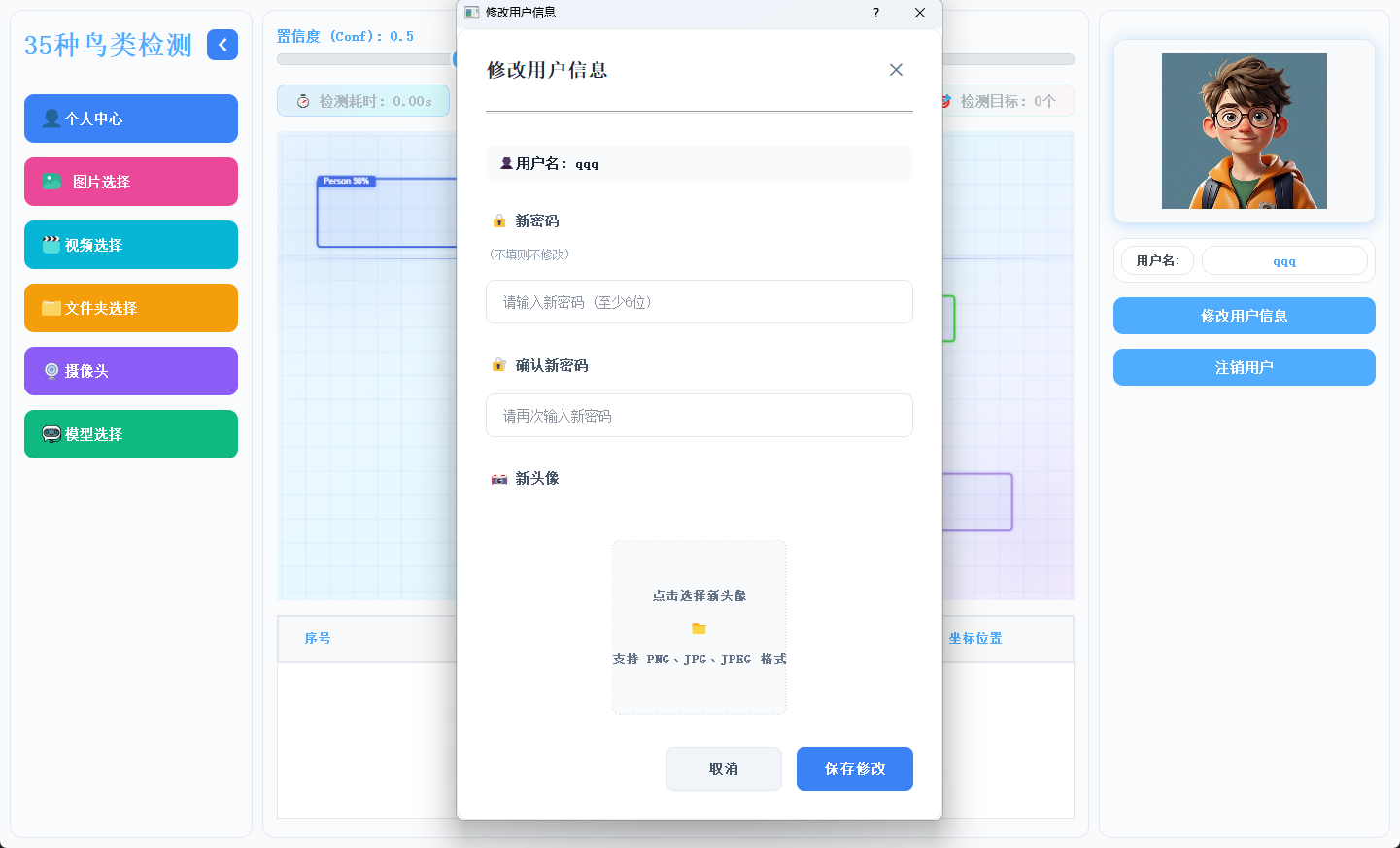

2.4 個人信息管理

用户可在此模塊中修改密碼或更換頭像,個人信息支持隨時更新與保存。

2.5 多模態檢測展示

系統支持圖片、視頻及攝像頭實時畫面的目標檢測。識別結果將在畫面中標註顯示,並在下方列表中逐項列出。點擊具體目標可查看其類別、置信度及位置座標等詳細信息。

2.6 多模型切換

系統內置多種已訓練模型,用户可根據實際需求靈活切換,以適應不同檢測場景或對比識別效果。

3.模型訓練核心代碼

本腳本是YOLO模型批量訓練工具,可自動修正數據集路徑為絕對路徑,從pretrained文件夾加載預訓練模型,按設定參數(100輪/640尺寸/批次8)一鍵批量訓練YOLOv5nu/v8n/v11n/v12n模型。

4. 技術棧

-

語言:Python 3.10

-

前端界面:PyQt5

-

數據庫:SQLite(存儲用户信息)

-

模型:YOLOv5、YOLOv8、YOLOv11、YOLOv12

5. YOLO模型對比與識別效果解析

5.1 YOLOv5/YOLOv8/YOLOv11/YOLOv12模型對比

基於Ultralytics官方COCO數據集訓練結果:

|

模型 |

尺寸(像素) |

mAPval 50-95 |

速度(CPU ONNX/毫秒) |

參數(M) |

FLOPs(B) |

|---|---|---|---|---|---|

|

YOLO12n |

640 |

40.6 |

- |

2.6 |

6.5 |

|

YOLO11n |

640 |

39.5 |

56.1 ± 0.8 |

2.6 |

6.5 |

|

YOLOv8n |

640 |

37.3 |

80.4 |

3.2 |

8.7 |

|

YOLOv5nu |

640 |

34.3 |

73.6 |

2.6 |

7.7 |

關鍵結論:

-

精度最高:YOLO12n(mAP 40.6%),顯著領先其他模型(較YOLOv5nu高約6.3個百分點);

-

速度最優:YOLO11n(CPU推理56.1ms),比YOLOv8n快42%,適合實時輕量部署;

-

效率均衡:YOLO12n/YOLO11n/YOLOv8n/YOLOv5nu參數量均為2.6M,FLOPs較低(YOLO12n/11n僅6.5B);YOLOv8n參數量(3.2M)與計算量(8.7B)最高,但精度優勢不明顯。

綜合推薦:

-

追求高精度:優先選YOLO12n(精度與效率兼顧);

-

需高速低耗:選YOLO11n(速度最快且精度接近YOLO12n);

-

YOLOv5nu/YOLOv8n因性能劣勢,無特殊需求時不建議首選。

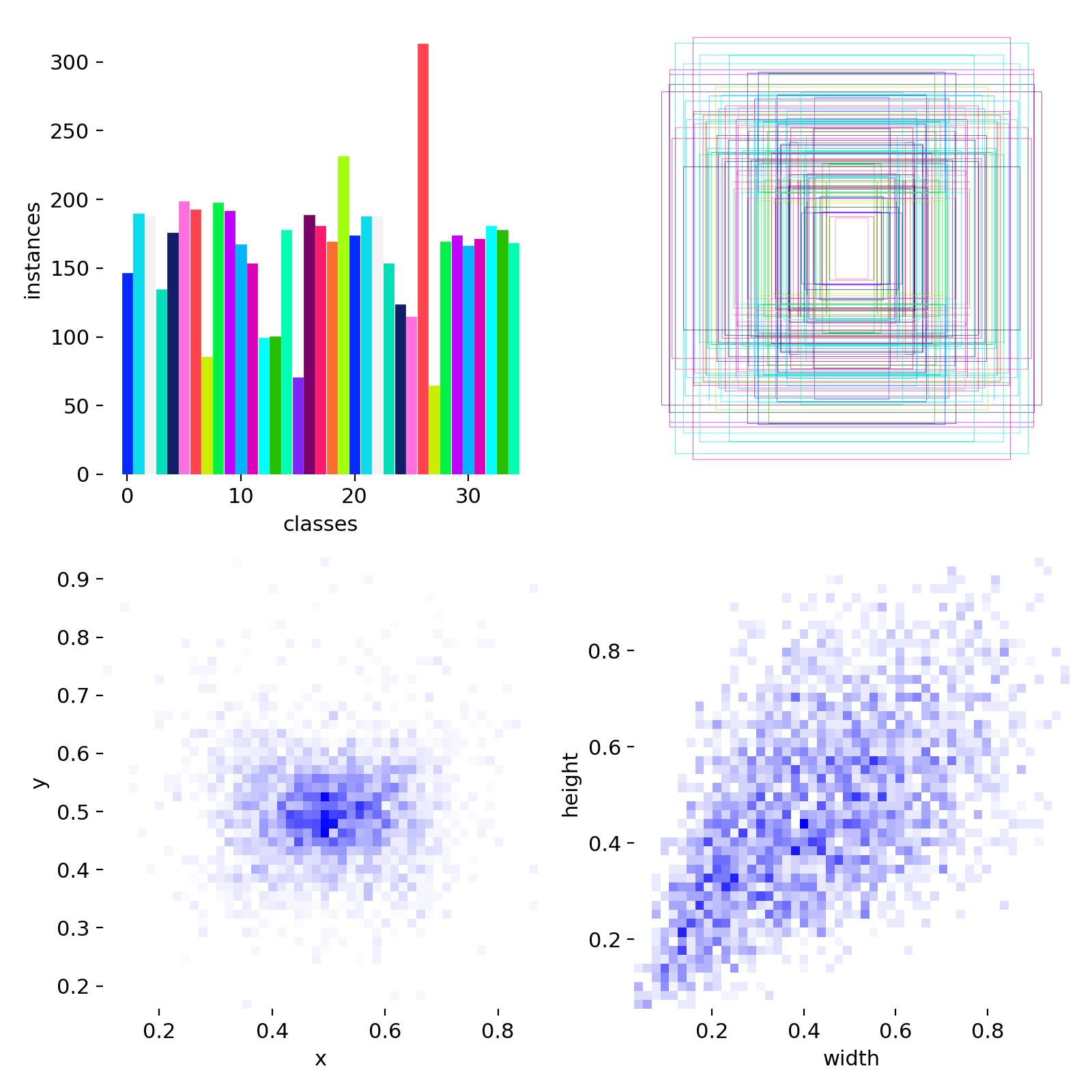

5.2 數據集分析

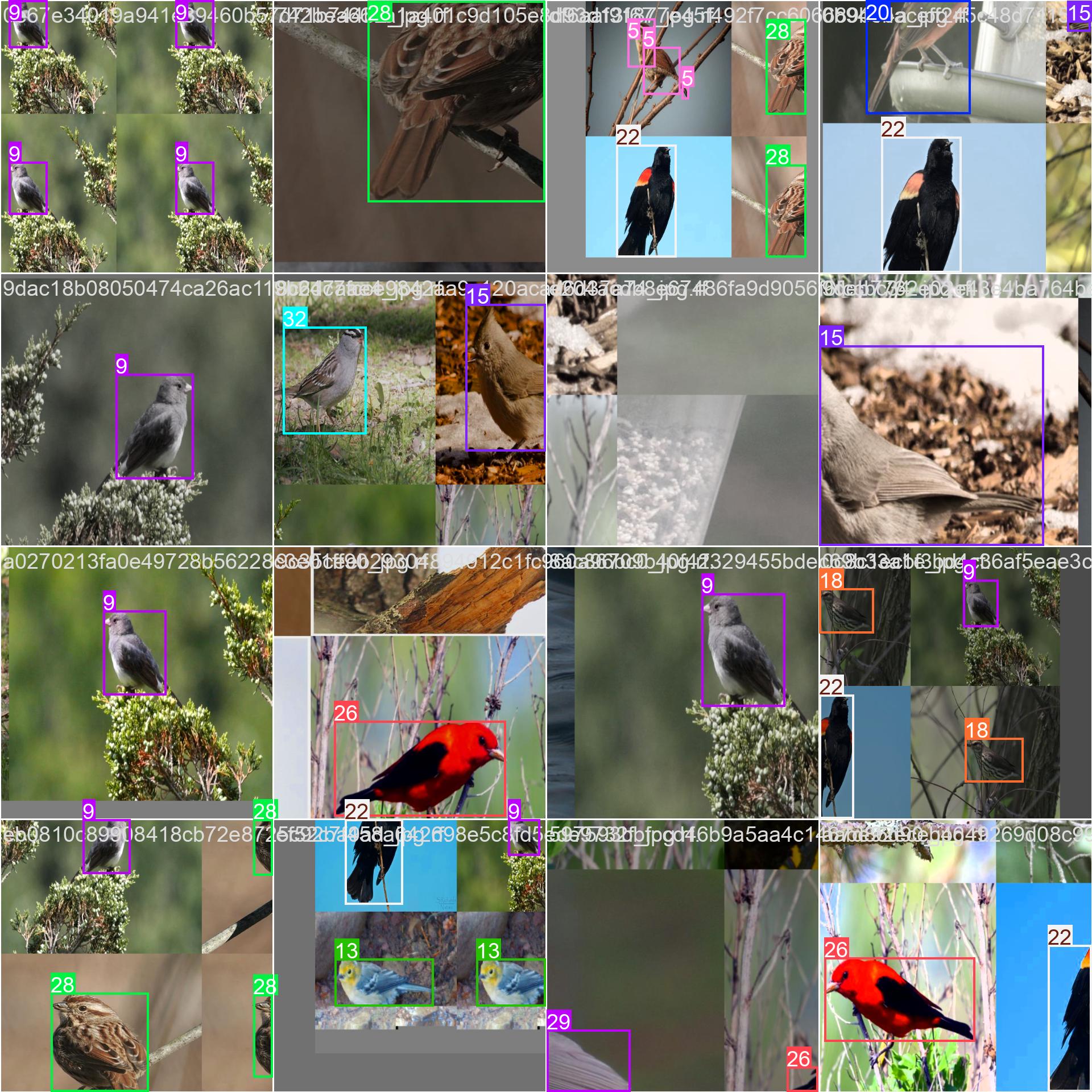

數據集中訓練集和驗證集一共大概將近4000張圖片,數據集目標類別35種鳥類,數據集配置代碼如下:

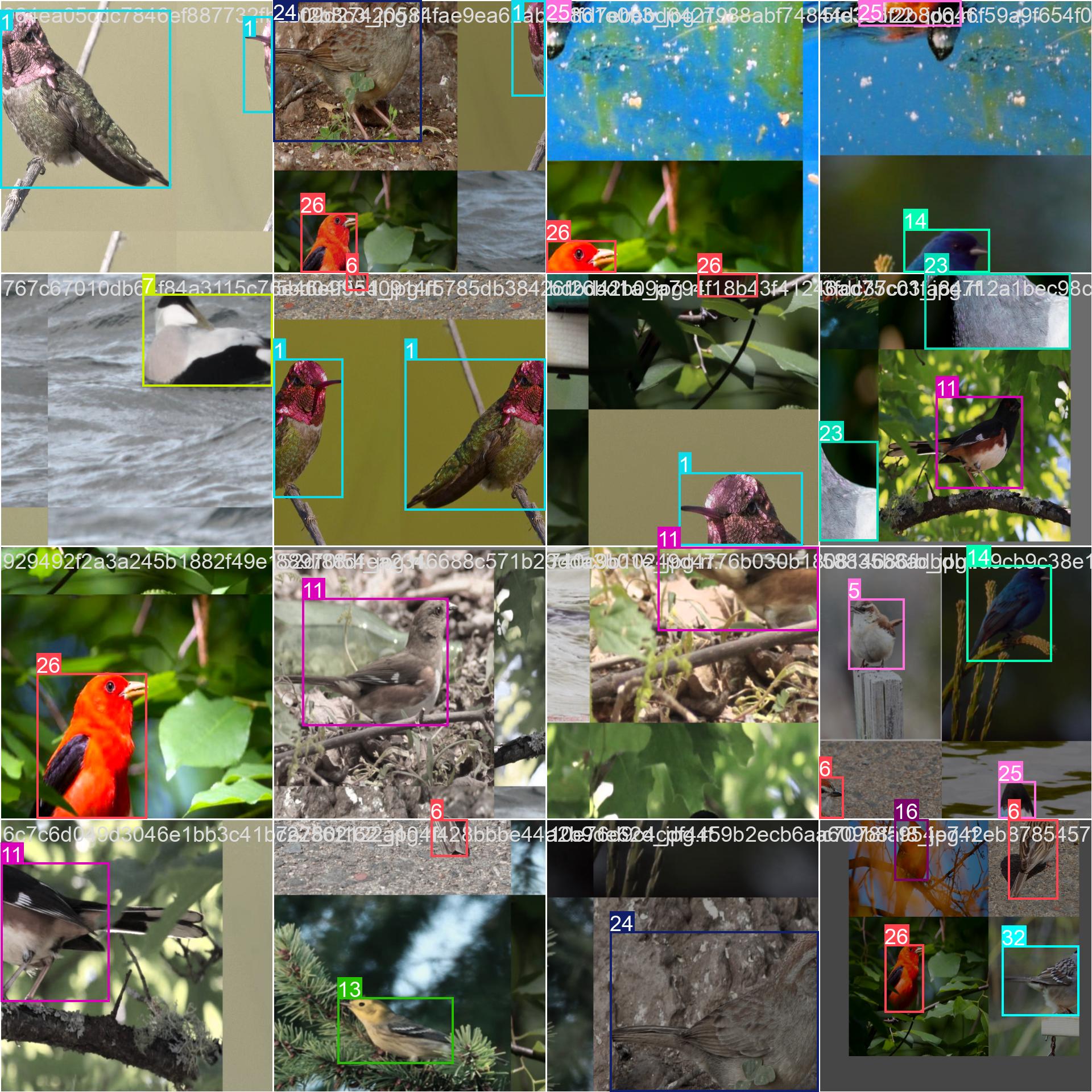

上面的圖片就是部分樣本集訓練中經過數據增強後的效果標註。

5.3 訓練結果

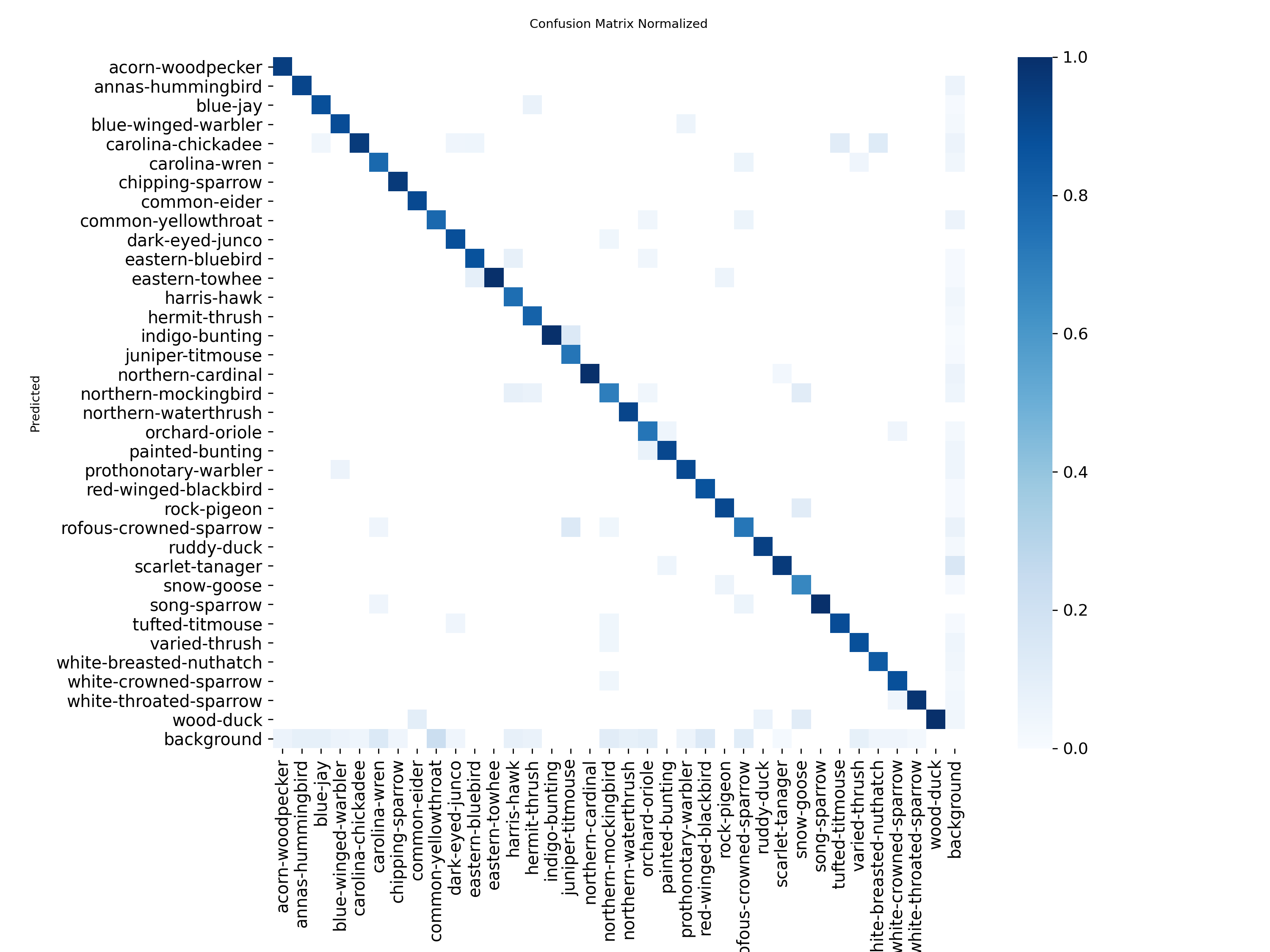

混淆矩陣顯示中識別精準度顯示是一條對角線,方塊顏色越深代表對應的類別識別的精準度越高了,圖像顯示識別精準度非常高。

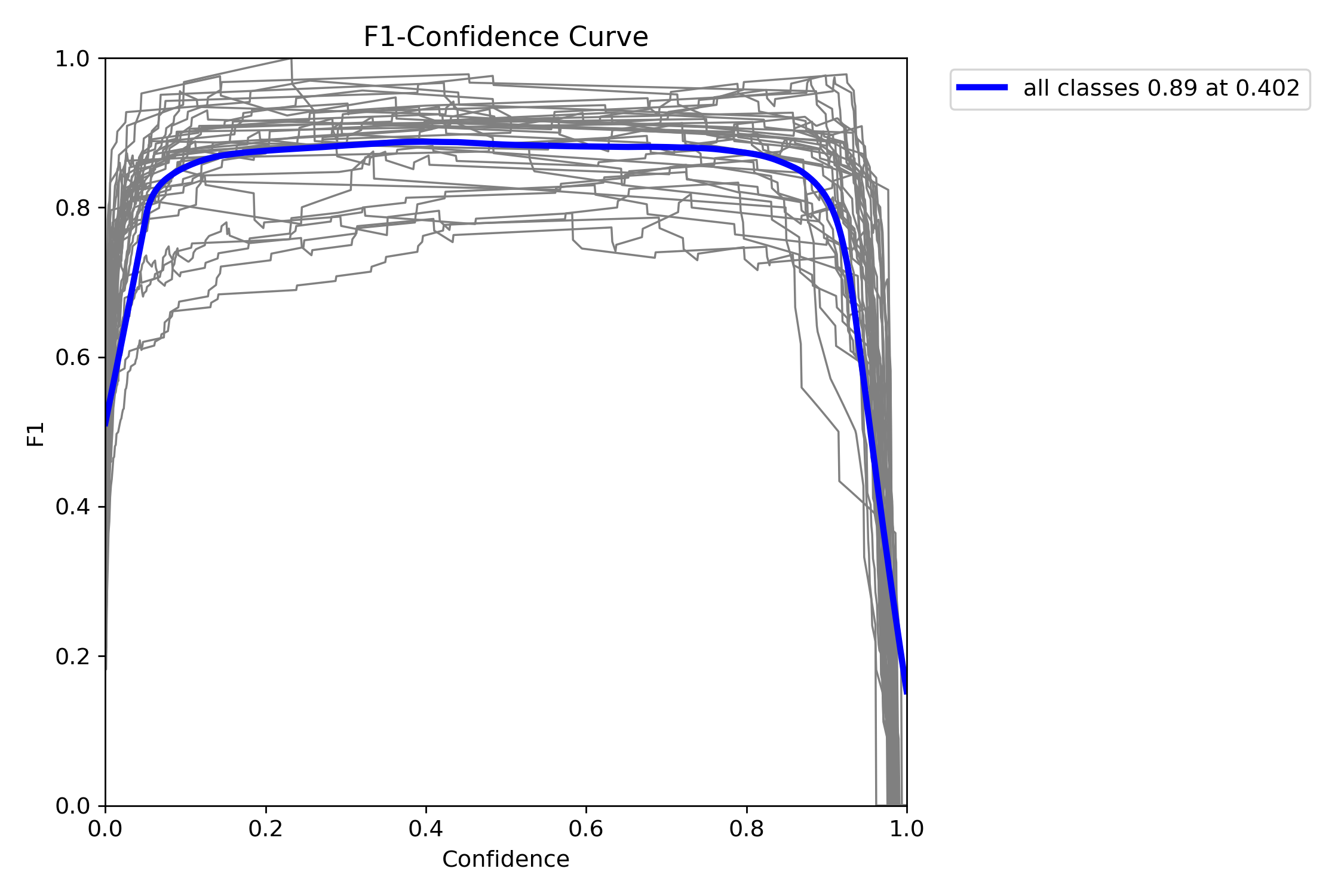

F1指數(F1 Score)是統計學和機器學習中用於評估分類模型性能的核心指標,綜合了模型的精確率(Precision)和召回率(Recall),通過調和平均數平衡兩者的表現。

當置信度為0.402時,所有類別的綜合F1值達到了0.89(藍色曲線)。

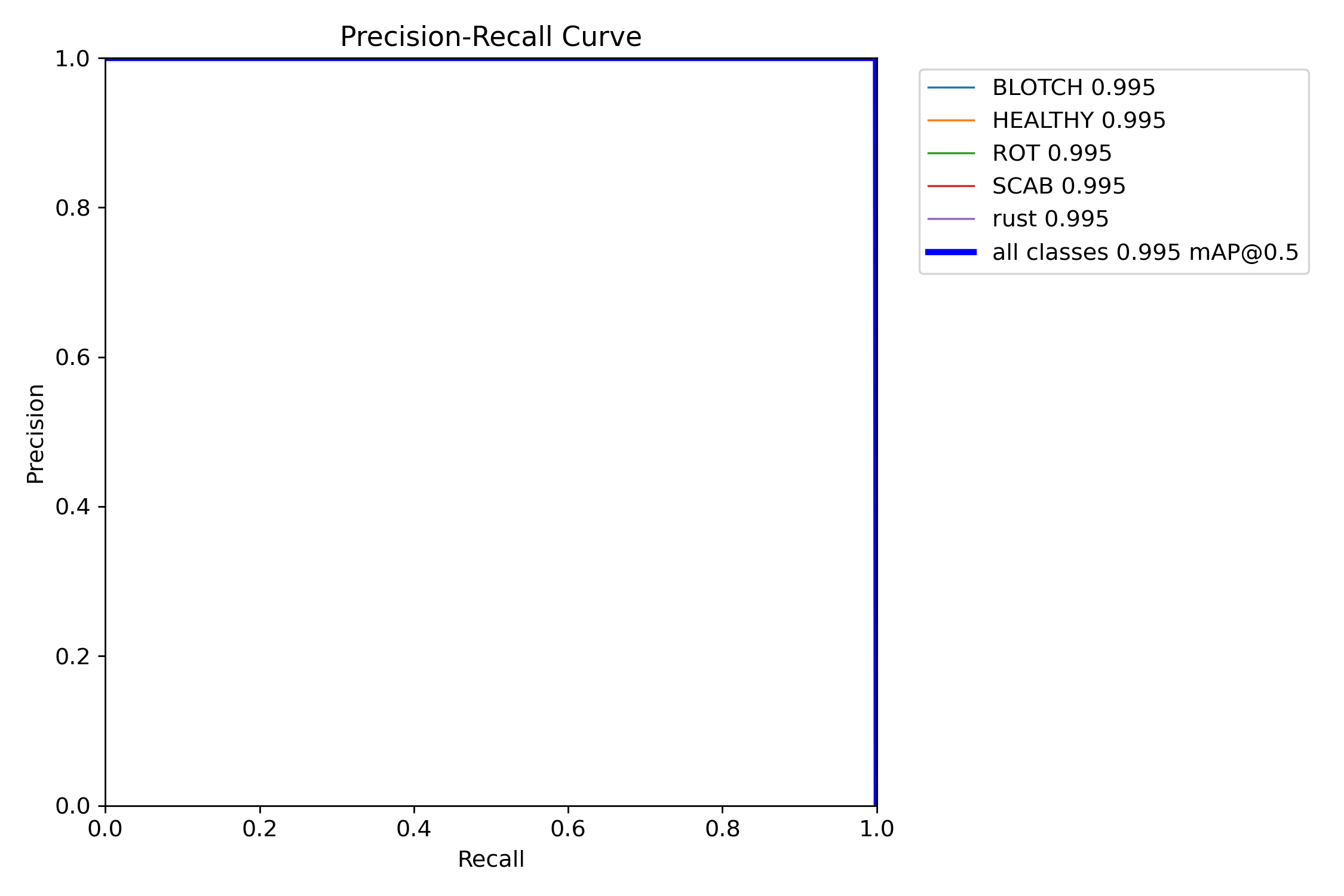

mAP@0.5:是目標檢測任務中常用的評估指標,表示在交併比(IoU)閾值為0.5時計算的平均精度均值(mAP)。其核心含義是:只有當預測框與真實框的重疊面積(IoU)≥50%時,才認為檢測結果正確。

圖中可以看到綜合mAP@0.5達到了0.995(99.5%),準確率非常高。

源碼獲取方式:https://www.bilibili.com/video/BV1EACiBgEi7