如果説 OpenAI 的 ChatGPT 拉開了「百模大戰」的序幕,那 Meta 的 Ray-Ban Meta 智能眼鏡無疑是觸發「百鏡大戰」的導火索。自去年 9 月在 Meta Connect 2023 開發者大會上首次亮相,短短數月,Ray-Ban Meta 就突破百萬銷量,不僅讓馬克·扎克伯格直呼 Amazing,更促使了谷歌、三星、字節跳動等國內外大廠的紛紛入局!

時隔一年,Meta 再次在 Connect 開發者大會上推出了智能眼鏡新產品 Orion,這是該公司推出的首款全息 AR 眼鏡,扎克伯格稱其為世界上最先進的眼鏡,將會改變未來人與世界的交互方式。

此外,按照慣例,Meta 通常會在 Connect 大會推出 Quest 頭顯新產品,今年亦是如此。鑑於去年發佈的 Meta Quest 3 被用户們普遍反映價格過高,今年 Meta 推出了一款性能與 Quest 3 相近但價格更親民的新頭顯 Quest 3S,這款頭顯被認為是當前市場上最佳的混合現實設備,可以提供極佳的超現實體驗。

當然,作為 Meta 旗下備受矚目的核心技術之一,Llama 模型也在此次發佈會上迎來了重大更新。多模態 Llama 3.2 能夠同時理解圖像和文本,手機也能跑大模型,為其開源生態再添助益。

Meta 的 AR 夢想成真,Orion 眼鏡開啓全新交互時代

今年 4 月,為慶祝 Reality Labs 成立 10 週年,Meta 曾發佈一篇文章概述該部門的發展歷史,並在文中預告了其下一個核心產品——首款 AR 眼鏡。Meta 表示,Quest 3 能夠讓用户在物理世界中與數字內容沉浸式互動,Ray-Ban Meta 眼鏡讓用户享受到 Meta AI 的實用性和娛樂性,而新款 AR 眼鏡則會結合這兩者的優點,實現最佳的技術融合。

隨着 Meta Connect 2024 的臨近,市場上越來越多的聲音推測,這款 AR 眼鏡將會在本次大會中發佈。不出所望,今天,Meta 發佈了其首款 AR 眼鏡 Orion。

扎克伯格表示,Orion 致力於改變人與世界的交互方式,是有史以來最先進的 AR 眼鏡,歷經 10 年研發而成。它擁有最先進的 AR 顯示屏、定製的硅芯片、碳化硅鏡片、複雜的光波導 (waveguides)、uLED 投影儀等,多種技術加持讓強大的 AR 體驗能夠在一副眼鏡上運行,而所消耗的電力和重量僅為 MR 頭顯的一小部分。

簡單來説,這種 AR 眼鏡採用一種全新的顯示架構,利用微型投影儀將光線投射到波導中,再將不同深度和大小的全息圖投射到用户面前的世界,並由一塊裝在眼鏡腿裏的電池供電。例如,用户如果想與遠方的朋友相聚,他們將以全息圖的形式出現在客廳,就像真的在身旁一樣。

值得一提的是,Orion 在鏡框邊緣嵌入了 7 個微型攝像頭和傳感器,並結合語音、眼動和手勢追蹤,配備 EMG 腕帶,用户可以輕鬆地進行滑動、點擊和滾動操作。例如,如果晨跑時想拍照,只需輕輕一按指尖,Orion 就能定格精彩瞬間。此外,只需輕敲手指,還能召喚紙牌遊戲、國際象棋或全息乒乓球等娛樂活動。

英偉達創始人兼 CEO 黃仁勳都迫不及待試用啦!

最佳混合現實設備 Quest 3S,性價超高

繼去年 Meta 在 Connect 大會上發佈全球首款混合現實頭顯 Meta Quest 3 之後,Meta 今年推出了 Quest 3 的精簡版本——Quest 3S。

扎克伯格表示,「Quest 3S 不僅性價比高,而且是目前市面上能買到的最佳混合現實設備!」它具備與 Quest 3 相似的核心功能,即高分辨率全綵混合現實,用户可以在物理世界和虛擬世界中「無縫穿越」,能夠進行娛樂、健身、遊戲、社交體驗等一系列活動。不同的是,Quest 3S 改進了鏡片,並在技術棧、有效分辨率和延遲等方面做了優化,其混合現實手部追蹤軟件表現更為出色。

混合現實的神奇之處在於,它將寫實的空間帶入元宇宙,讓用户有一種身臨其境的感覺,並在不同的體驗間自由切換。比如,用户可以選擇影院模式,把屏幕放大成一個電影院,獲得最佳的劇場觀看體驗。

在現場演示中,扎克伯格展示了從 2D 移動應用到遠程桌面的 PC 的沉浸式體驗,用户可以打開屏幕並將其放置在任何位置,形成一個巨大的虛擬顯示器,並進行工作。他提到,Meta 一直在與微軟合作升級遠程桌面功能,不久之後,這種功能或許就可以連接到 Windows 11 電腦上。

值得一提的是,Meta Quest 3S 以難以置信的價格提供超現實的體驗,起價僅為 299.99 美元,將在 10 月 15 日上市。今年秋天購買 Quest 3S 的用户,還將獲贈《Batman: Arkham Shadow》遊戲的 VR 體驗。

首個支持視覺任務的 Llama 模型,多模態且開源

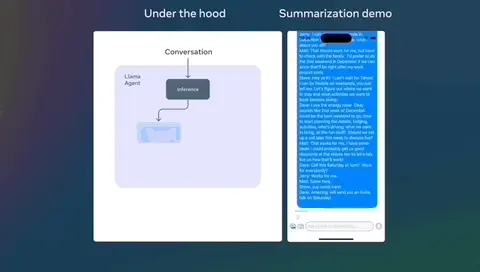

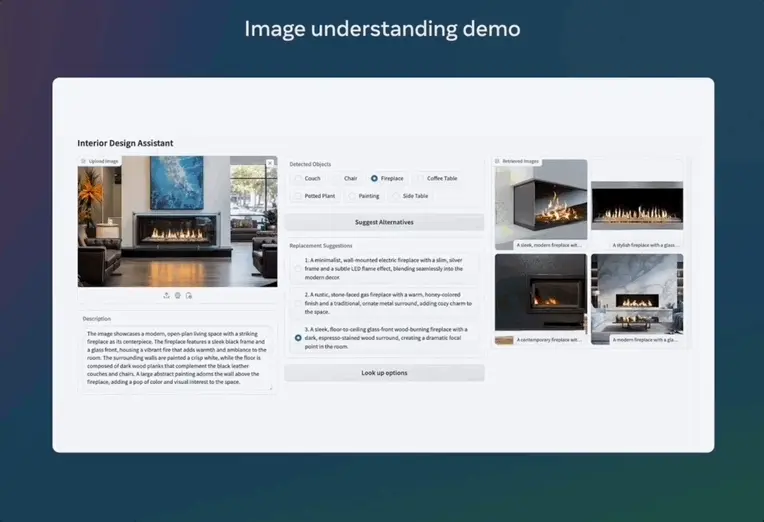

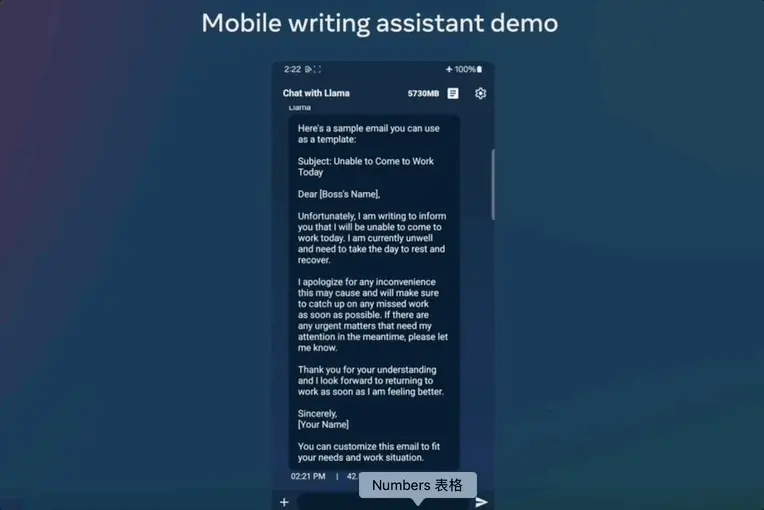

除了重磅的硬件發佈外,小扎還帶來了 Llama 的更新,推出 Llama 3.2 模型。作為第一個支持視覺任務的 Llama 模型,Llama 3.2 能夠同時理解圖像和文本。其中包含適用於邊緣和移動設備的中小型視覺模型 (11B 和 90B) 以及輕量級純文本模型 (1B 和 3B),這兩個類別均包括預訓練版和指令微調版。值得一提的是,這些不同規格的模型均可通過 Meta AI 進行試用。

模型性能評估

研究人員在超過 150 個跨語言的基準數據集評估模型性能。結果顯示,Llama 3.2 1B 和 3B 模型支持 128K tokens 的上下文長度,在遵循指令、總結、提示改寫和工具使用等任務上,3B 模型優於 Gemma 2 2.6B 和 Phi 3.5-mini 模型,而 1B 模型則能夠與 Gemma 模型一爭高下。

此外,研究人員評估了模型在圖像理解和視覺推理基準的性能。結果顯示,Llama 3.2 11B 和 90B 視覺模型可以無縫替代相應的文本模型,同時在圖像理解任務上超越了諸如 Claude 3 Haiku 之類的閉源模型。

輕量級模型訓練

對於 Llama 3.2 1B 和 3B 模型,研究人員採用剪枝和蒸餾兩種方法,從 8B/70B 模型中提煉出高效的 1B/3B 模型。

具體而言,研究人員將 Llama 3.1 的 8B 和 70B 模型的 Logit Date 納入預訓練階段,使用這些較大模型的輸出 (logit date) 作為 token 級別的目標,進行結構化剪枝。剪枝完成後,研究人員利用知識蒸餾來恢復模型的性能。

視覺模型訓練

Llama 3.2 的訓練流程分為多個階段。首先,從預訓練的 Llama 3.1 文本模型開始。接着,研究人員添加圖像適配器和編碼器,並在大規模的噪聲(圖像、文本)配對數據上進行預訓練。然後,在中等規模的高質量域內和知識增強的(圖像、文本)配對數據上進行訓練。

在後期訓練中,研究人員採用與文本模型相似的方法,通過多輪對齊來進行監督微調、拒絕採樣和直接偏好優化。研究人員使用 Llama 3.1 模型生成合成數據,對域內圖像的問題和答案進行過濾和增強,並使用獎勵模型對所有候選答案進行排序,從而確保高質量的微調數據。

此外,研究人員還引入了安全緩解數據,以打造一個兼具高度安全性和實用性的模型。最終,能夠同時理解圖像和文本的 Llama 3.2 模型誕生,標誌着 Llama 模型在通向更豐富代理能力的道路上又邁出了重要的一步。

本地部署模型及時且安全

研究人員指出本地運行 Llama 3.2 模型有兩大優勢。首先,在響應速度上,由於處理全部在本地完成,提示和響應的速度可以達到接近即時的效果。

其次,在隱私安全上,本地運行模型無需將消息和日曆等數據發送到雲端,保障了用户隱私,使應用程序更加私密。通過本地處理,應用程序可以明確控制哪些查詢留在設備上,哪些查詢需要交由雲端更大的模型來處理。

堅守開源初心,模型部署更加簡化和高效

Meta 始終堅守開源初心,為了大幅簡化開發者在不同環境(包括單節點、內部部署、雲端和設備)中使用 Llama 模型的流程,實現檢索增強生成 (RAG) 和工具支持型應用的一鍵部署,並集成安全功能,Meta 宣佈將分享首批官方 Llama Stack 發行版。

據官方介紹,Llama 3.2 模型將在 llama.com 和 Hugging Face 上提供下載,並將在包括 AMD、AWS、Databricks、Dell、Google Cloud、Groq、IBM、Intel、Microsoft Azure、NVIDIA、Oracle Cloud、Snowflake 等在內的合作伙伴平台上提供即時開發支持。

作為一貫的開源倡導者,扎克伯格曾在與黃仁勳的對談中介紹道,「Meta 從開源生態中獲益,已節省數十億美元」。而 Llama 無疑是其打造開源生態的重要觸手,Llama 3.2 進一步向視覺任務拓展,實現多模態,也勢必將為其開源生態再添助益。