導讀

從2023年成立到如今日均服務2萬+直播間,百度慧播星已演進為覆蓋腳本生成、實時問答、智能決策、音視頻克隆的全鏈路AI直播平台。本文深入解讀其技術架構:如何通過檢索增強和強化學習生成高轉化腳本;如何利用強化學習智能中控動態優化直播策略;以及如何將語音與形象克隆效率提升至“小時級”;如何構建“先驗-後驗”數據飛輪,讓模型自主進化;。羅永浩數字人直播GMV突破5500萬的案例,驗證了其“超越真人”的帶貨能力。未來,慧播星正朝着更智能、更擬真、更高效的方向持續迭代。

01 慧播星介紹

電商數字人直播(慧播星)正式成立於2023年,是一款彙集了百度在視覺,語音和語言方面AI能力的原生AI應用產品,致力於打造代際領先的超越真人的直播體驗。25年底日均開播直播間已達2萬多個,覆蓋電商、教育、健康、金融、泛知識內容等多個行業。經過兩年多的產品打磨和技術突破,慧播星數字人直播已具備超越真人的能力。例如,這些能力支撐了羅永浩2025年6月15 日的數字人直播首秀,吸引了超 1300 萬人次觀看,GMV(商品交易總額)突破 5500 萬元,這一成績超過了其同年 5 月的真人直播首秀(GMV 5000 萬)。

1.1 商家業務視角——開播流程

商家在慧播星獲得帶貨權限後,即可自助開啓數字人直播,主要包括如下流程。

- 商品選擇,可從百度直營店鋪(度小店),三方電商平台(京東淘寶拼多多)和百度本地生活的海量商品中選擇帶貨商品

△ 海量內外部商品一鍵掛接

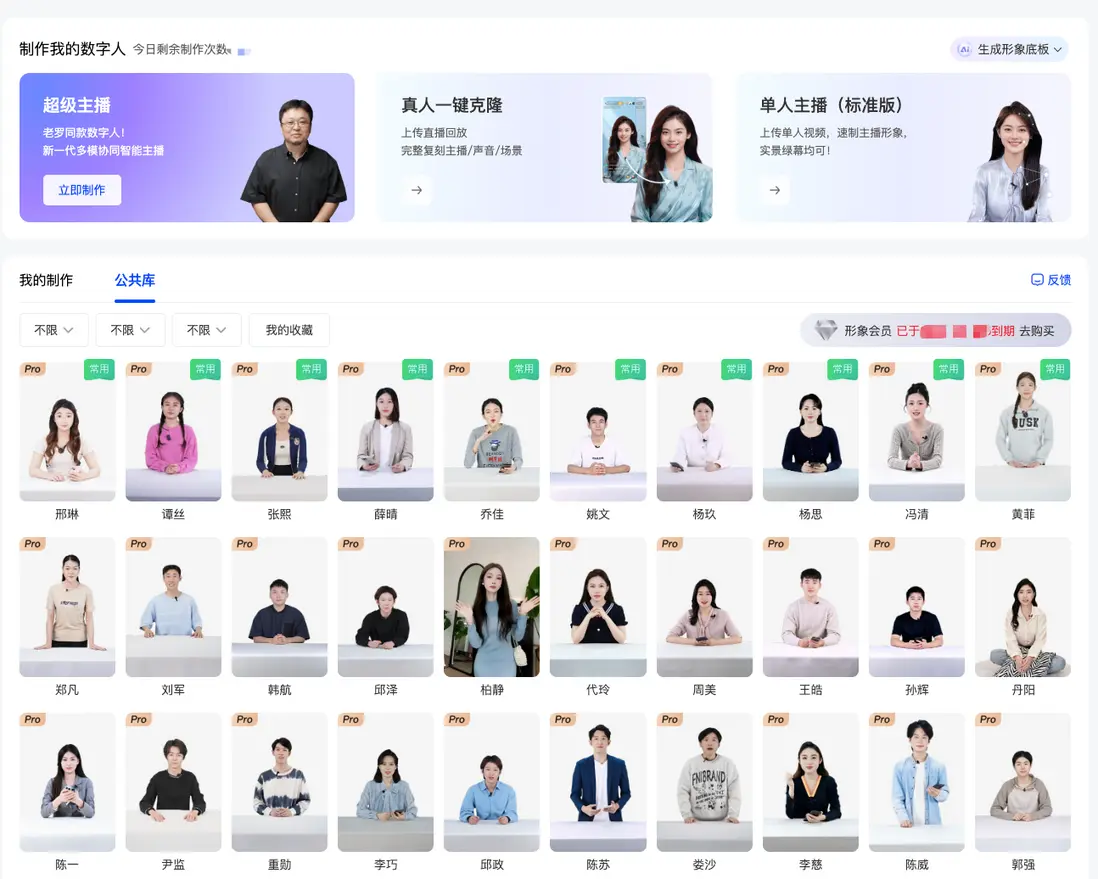

- 形象選擇或者定製,從7800+公共庫形象中選擇主播形象,或通過自助錄製5分鐘視頻定製私有形象

△ 形象選擇或定製

- 直播間裝修,從3600+套直播間模板中選擇裝修風格和元素,或通過AI自動生成直播間背景圖和營銷掛件

△ 直播間裝修,豐富的模板&組件

- 腳本生成,從多種公共風格中選擇腳本帶貨風格,或自定義目標帶貨風格,補充少量營銷信息,一鍵生成專業的直播腳本

△ 一鍵腳本生成 - 音色選擇,從3200+個公共庫音色中選擇主播音色,或通過手百自助錄製,3天內得到私有定製音色

△ 音色選擇或製作

- 直播間互動配置,一鍵開啓一言問答接管,也支持手動配置預置問答對,補充商家知識

△ 直播間互動配置

02 整體技術架構

慧播星整體架構主要由商家端、視覺語音和文本各模態模型、實時渲染引擎、站內外分發系統組成。

為實現更好的直播體驗,數字人採用雲端生成方案,雲端生成系統主要包括如下幾個子系統。

- 商品理解,為腳本,問答,互動等各種內容生成模型提供商品知識增強

- 腳本生成,圍繞商品自動生成風格化口語化的帶貨腳本

- 智能問答,用户提問時實時檢索商品知識,生成精準的回覆,支持彈幕和口播回覆

- 智能互動,以直播效果(評論率、用户退場率、觀看時長等)為目標主動向用户發起互動

- 直播間裝修,智能生成直播間背景,合成帶營銷內容的掛件

03 內容生成

3.1 風格化腳本生成

直播腳本水平與帶貨效果息息相關,優秀主播的腳本能夠打動用户,循循善進引導用户成交。由於普通商家的帶貨營銷水平有限,商家希望僅表達學習某某主播,系統自動為其生成風格相似的腳本。在此需求背景下,慧播星利用多模態商品理解富集構建商品知識庫,藉助EB4/turbo在電商直播語料上進行大規模預訓練,結合人工專家精標數據SFT,通用和電商知識增強等手段實現一鍵風格化仿寫。

- 商家僅需選定商品和補充少量營銷信息,即可按預設風格或者自定風格(提供最少400字的帶貨文案)一鍵生成風格相似的帶貨腳本。客户採納率92%,開播滲透率67%,相比客户腳本轉化率+14%。

- 考慮到風格化腳本創作需求的獨立性,慧播星已將腳本生成獨立為工具,商家可脱離直播業務流使用工具。

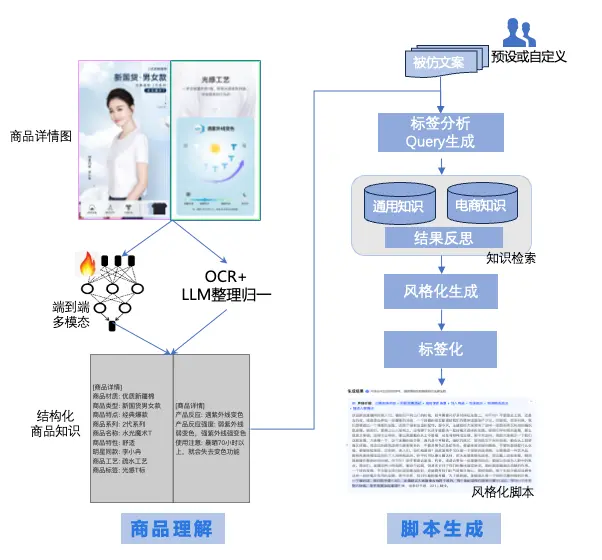

技術架構

整體技術主要包括商品理解、檢索增強、強化學習風格化生成和後處理階段。

- 商品理解。系統通過多模態商品解析技術對商品詳情頁、海報圖、參數圖等視覺素材進行

OCR、版面結構識別與多模態模型融合,自動抽取核心賣點、適用人羣、功能亮點、使用場景等結構化商品知識。可在單張圖裏同時捕獲“文本內容 +

圖示含義 + 排版語義”等特徵,並利用 LLM 對解析結果進行歸一化和字段對齊,形成高覆蓋、高一致性的商品知識庫。 - 檢索增強(RAG)鏈路。用户輸入的風格範文(不少於 400

字)會先經過標籤分析模塊,由大模型識別出其關鍵風格維度,如:表達節奏(快/慢)、情緒濃度(熱情/剋制)、營造氣氛策略(故事、對比、疑問句)、用户痛點定位、直播常用帶貨技巧(強調稀缺、促單壓力、利益點遞進)等。基於這些風格標籤,系統自動生成

Query,用於從通用知識庫與電商知識庫中檢索對應表達方式、句式模板與知識上下文(賣點順序推薦、商品類別常用話術、場景化句法等)。 - 風格化生成模型。模型基於電商專精的電商直播語料預訓練能力,並結合海量運營專家的精細化標註數據(SFT),能夠在保持範文風格一致性的同時,將內容自動替換為目標商品的賣點和營銷邏輯。為確保生成內容既符合直播場景使用習慣,又具備高情緒感染力,系統引入輕量級

RLHF/強化學習優化,通過人類偏好數據持續調優,使模型能夠穩定輸出“自然、順暢、帶貨效果強”的腳本。為持續提升模型能力,通過數據飛輪對該生成模型進行對齊。 - 標籤化與後處理。腳本被進一步結構化,包括:分鏡邏輯、開場引導、利益點鋪墊、情緒高點、促單推進、收尾金句等,方便商家在實際直播中靈活調用或進行定製化編輯。

腳本數據飛輪

數字人直播的內容絕大部分來自大模型生成,前期領域專家知識為生成標準,腳本、問答、互動場景的生成質量已達到普通真人主播的水平。然而人工先驗知識存在主觀偏差,且缺乏全面性和快速適應新變化的能力,完全依賴人工只能達到次優水平。為持續攀升超越域內外頭部真人主播,需建立業務和大模型的數據飛輪,通過飛輪效應持續提升模型在數字人直播場景的後驗效果。

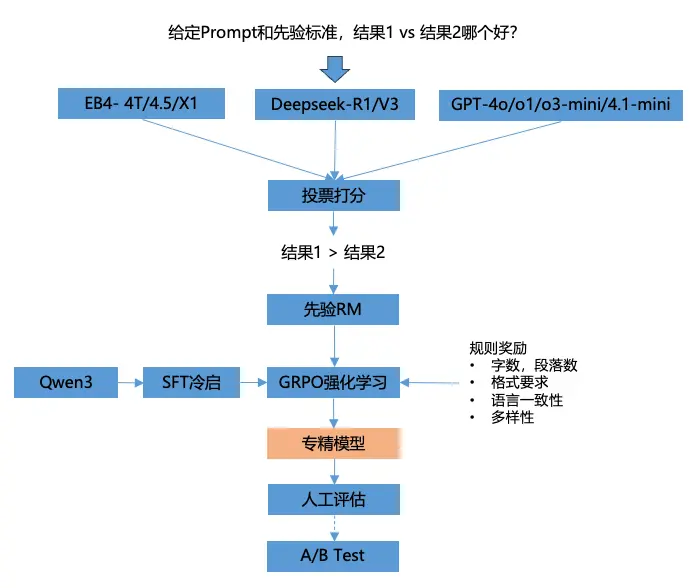

先驗對齊

在真實直播場景中,數字人模型最終追求的是“後驗效果最優”——即用户停留、評論增長、轉化提升等真實業務指標。然而後驗目標往往天然伴隨風險:例如激進促單、誇大效果、模糊描述等內容可能在短期內獲得更高的用户反饋,卻越過事實邊界與平台規範,形成安全問題。因此,在模型全面對齊後驗之前,必須構建一套穩健、可解釋、與平台規範一致的先驗對齊體系作為基礎。先驗獎勵模型作為“守門人”,以推理專家模型為判斷核心,通過結構化的偏好評分與規則獎勵引導模型學習合規、高質、可控的內容風格,實現“先驗對齊 → 強化學習 → 專精模型 → 迴流驗證”的閉環。

自動偏好合成。傳統先驗獎勵完全依賴人工標註,成本高且存在主觀性。為解決這一問題,我們集成了多個先進推理類基模型(如 EB4-4T、Deepseek-R1/V3、GPT-o 系列等),通過多模型投票、結果對比分級等方式自動合成偏好。這一自動化偏好生成機制能夠模擬“專家標註”,但具備:

- 一致性更高,減少人工主觀波動

- 覆蓋範圍更廣,數百萬級先驗數據

- 適應變化更快,模型可隨平台規範或內容趨勢變化即時更新

最終形成先驗 RM(Reward Model)的核心訓練數據。先驗 RM 的核心職責是確保模型在任何情況下都不會突破內容安全邊界,為後續後驗對齊提供穩固底座。

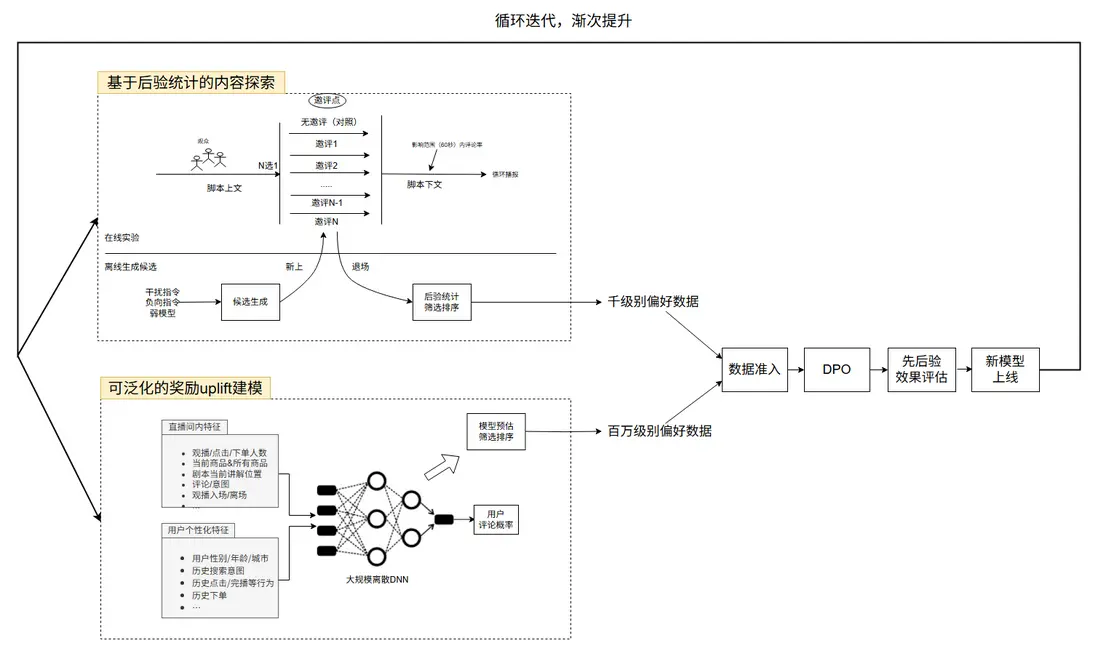

後驗數據飛輪

為了讓模型吸收用户的真實後驗反饋,慧播星構建了一套以“內容探索 + 獎勵建模”為兩條主線的數據飛輪,實現模型的自主進化與持續增強。

基於後驗統計的內容探索:可控、高解釋的偏好數據生成鏈路。後驗統計路徑主要面向高精度、強可控、可解釋性強的偏好數據生產需求,結合在線實驗框架,通過真實用户反饋驅動的方式生成偏好樣本。通過高頻在線實驗,系統不斷沉澱千級規模的偏好數據,支撐後續的模型偏好對齊訓練(如 DPO/IPO 等策略優化方法)。

可泛化的獎勵 uplift 建模:大規模偏好數據的高效補充路徑。相比基於後驗統計的實驗方式,uplift 建模路徑旨在解決用户行為稀疏、實驗成本高的問題,通過泛化模型直接對用户偏好進行預測,生成百萬級的偏好數據,實現更高效的數據擴容。採用 S-Learner / T-Learner 等 uplift 方法,構建用户行為因果效應模型,直接預測“某段內容是否會提升用户的互動/評論/停留等關鍵指標?”

3.2 智能問答

慧播星建設了一套完備的直播場景RAG系統,包括電商領域知識檢索模型,通過千億模型蒸餾的低時延生成模型(12s->2s),數據飛輪。目前已實現多模素材調度,高擬真明星問答,客户個性化表達,垂類適配,商家/商品知識庫等產品能力。客户可一鍵開啓智能問答,問答端到端可用率95%,優質率90%,客户開啓率94%,運營和客户反饋較好。

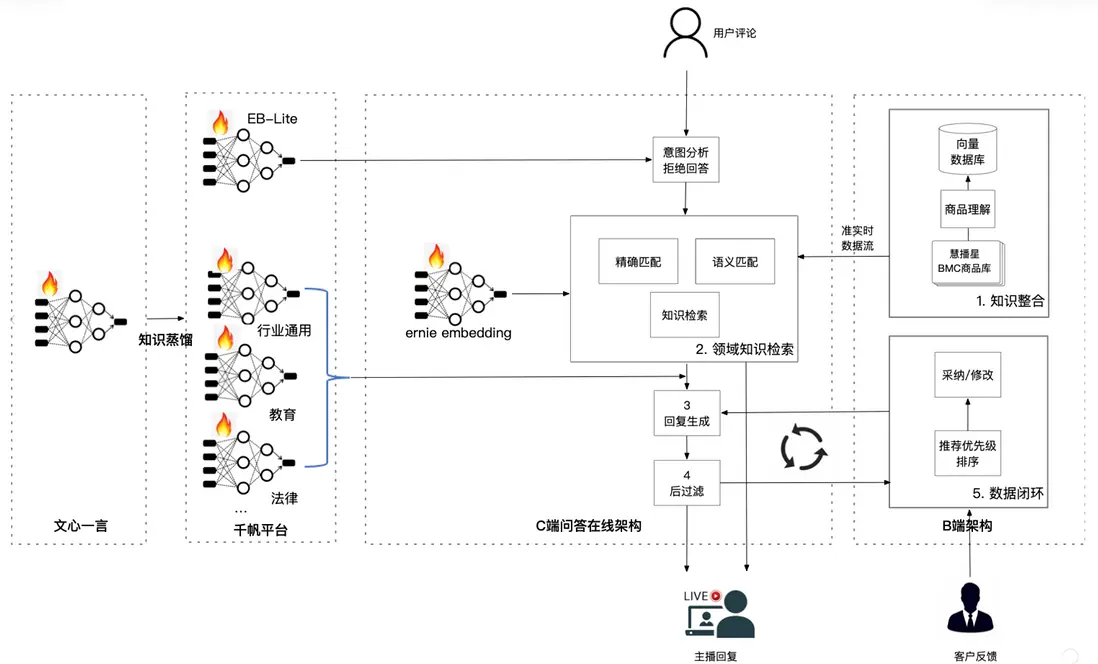

技術架構

慧播星的直播實時問答系統在工程上形成了知識整合 → 領域檢索 → 低延遲生成 → 後處理 → 數據飛輪的完整閉環,為超擬真數字人提供了媲美真人的實時互動能力。

△ 智能問答架構

- 在知識整合層,系統將商家側的商品圖文、賣點、FAQ、視頻腳本、類目屬性以及運營沉澱的數據統一入庫,並通過向量化處理構建高可用的電商知識底座。

- 領域知識檢索模塊結合了千幀蒸餾後的 EB-lite/行業模型與高維向量語義搜索,通過「意圖識別 → 精準匹配 → 語義聚類 → 知識召回」的流水線,確保系統能夠從複雜直播語境中準確捕捉用户提問意圖。直播場景中存在大量口語化、短句化、甚至噪聲語料(如: “這個能用多久啊”。“有別的顏色嗎?”),系統通過深度語義 embedding(如 ernie embedding)實現高魯棒性的實時檢索,使檢索召回的準確率在實時環境下依然保持穩定。

- 低延時生成模塊。基於千億模型蒸餾結果構建,針對直播高併發、低時延、強一致性的要求,模型經過結構裁剪、張量並行優化與 Prompt 規約,使單輪響應時延從 12s 壓縮到 2s,在保證語義豐富度和口播自然度的同時提升端到端體驗。

- 數據飛輪實現持續自我優化:運營反饋、用户互動日誌、誤匹配案例以及高質問答樣本會自動迴流到數據處理模塊,驅動知識庫更新與模型重訓練。

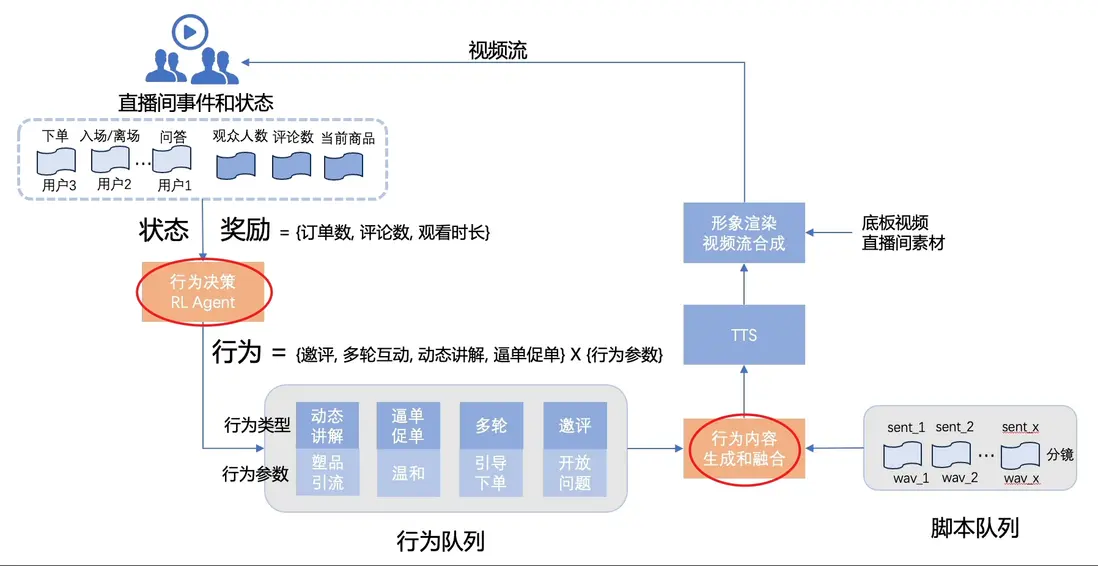

3.3 智能中控

真人主播會根據直播間實時狀態決策當前應發起何種動作(action),比如直播間互動氛圍差的時候是應該邀評,換賣點講解還是促單?確定動作後主播知道如何最好的的執行動作,例如怎麼把邀評講出來?説什麼話,用什麼語氣,邀請特定觀眾還是所有觀眾。行為決策和行為內容生成兩者相結合實現直播間下單,關注,留聯等最大化目標。超擬真數字人需要具備上述兩種核心能力,即給定一個長期目標(如每場次的訂單總數,評論總數,觀看時長等),要求數字人1)判斷在不同直播間狀態下應該做出什麼行為,是切換賣點講解,促單逼單,邀評還是多輪互動?2)確定某種行為後生成適合的的行為內容,如塑品講解,優惠講解,促單逼單等的具體口播內容。

技術架構

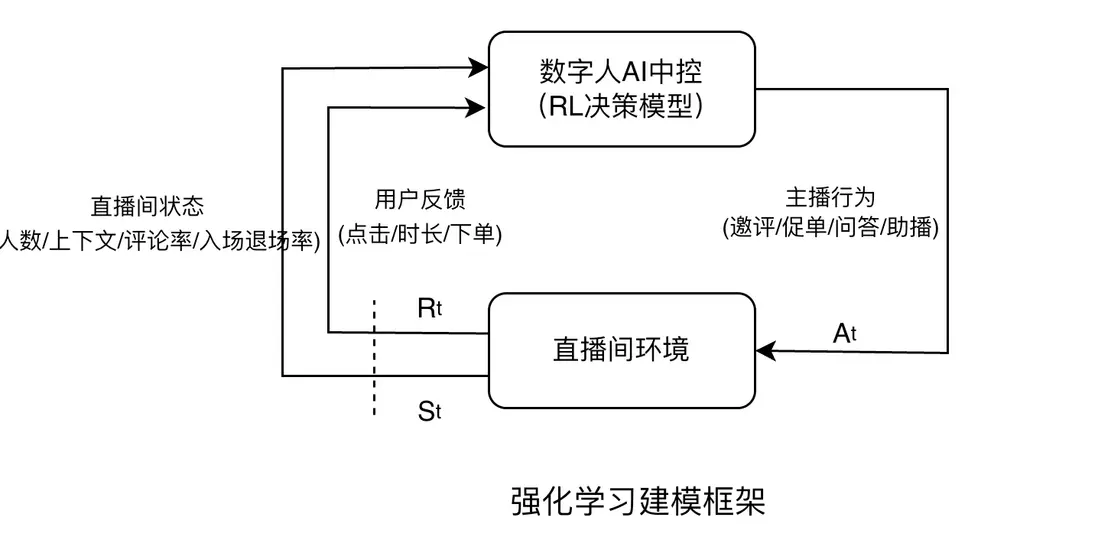

智能中控架構核心由基於強化學習的決策Agent,和基於一言大模型的多任務融合兩個部分組成。

基於強化學習的行為決策Agent

行為決策的目標是在不同直播狀態下選擇最優動作,最大化長期目標(訂單、評論、觀看時長等)

上圖展示了直播環境與RL決策Agent的交互流程:

- 狀態 St:觀看人數、評論頻率、當前商品、用户行為序列、是否有提問等

- 動作 At:邀評 / 多輪互動 / 促單 / 動態講解 / 切換賣點 / 回答問題……

- 獎勵 Rt:訂單數變化、評論數增加、停留時長、轉化率提升等

- Agent 通過不斷試錯 & 策略迭代,獲得最優策略。

這使數字人能夠像真人主播一樣:氛圍低時發起互動,用户觀望時進行促單,新觀眾進入時進行商品介紹。RL 的優勢在於目標導向:不是優化單句話,而是優化整場直播的 KPI。

基於大模型的行為內容生成與融合

當 RL Agent 選擇了一個動作後,例如“促單”,還需要生成對應的動作參數:如促單的口播內容,使用什麼語氣?內容是偏温和還是強節奏?是否引用當前觀眾的評論?實踐中我們通過強化學習訓練了一系列action內容生成專精模型,能夠生成特定參數指定的直播內容。

未來我們將以語言模型為基座對決策和內容生成任務進行端到端訓練,減少分階段建模帶來的累計誤差。

04 語音克隆與合成

普通商家原聲演繹狀態不佳,缺乏帶貨感。慧播星利用風格遷移TTS技術自動合成感染力強,擬真度高的直播音頻。經過兩年多的迭代TTS開播使用率從30.3%提升至92.8%,製作時效性從1月降低到1分鐘。

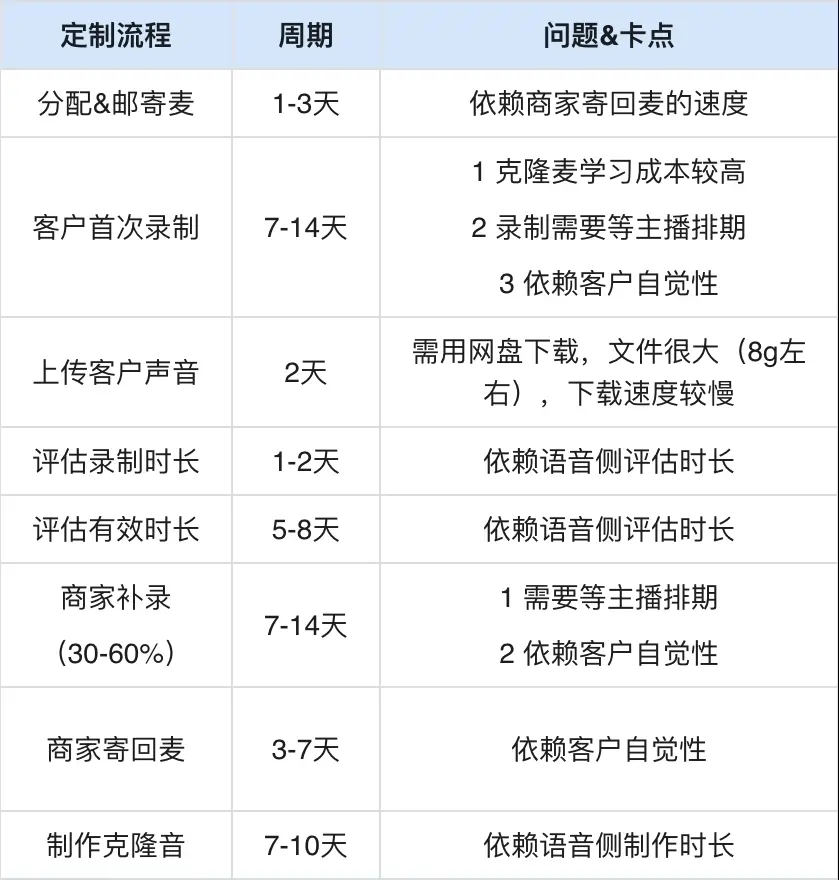

電商TTS發展主要經歷兩個階段:

第一階段(2023.3~2024.Q2):語音定製工牌麥收音,依賴大量人工傳導,整個週期長達一個月

第二階段(2024.Q3至今):小程序自助收音提高收音效率,自動訓練架構升級,抑揚頓挫帶貨效果持續優化

第一階段:工牌麥收音效率低下

第二階段:小程序自助錄製

現狀:當前慧播星支持原生和激情帶貨兩種音色克隆,客户僅需在手百小程序上錄製15分鐘語音,系統在1天內自動為客户生成克隆音(對比如下)。目前慧播星已製作12w多個音色,2.7w多個客户定製音色。

兩種音效可選

- 原聲效果:還原本人説話特點,如語速和語調

http://blob:https://unitools.fun/fb87134d-97ec-42a5-a0a0-b749...

- 激情帶貨效果:讓整體情緒更激昂,抑揚頓挫

http://blob:https://unitools.fun/85e53903-5672-4988-85ae-19a4...

未來計劃利用海量直播場景的語料數據,進一步降低克隆門檻(對齊競品的30s)、提升克隆效率(分鐘級可完成克隆進行合成)、優化朗讀效果(對標直播/視頻/講述/諮詢等不同語境的真人) ,同時從單聲音的克隆和合成成本達到業內頭部領先水平。

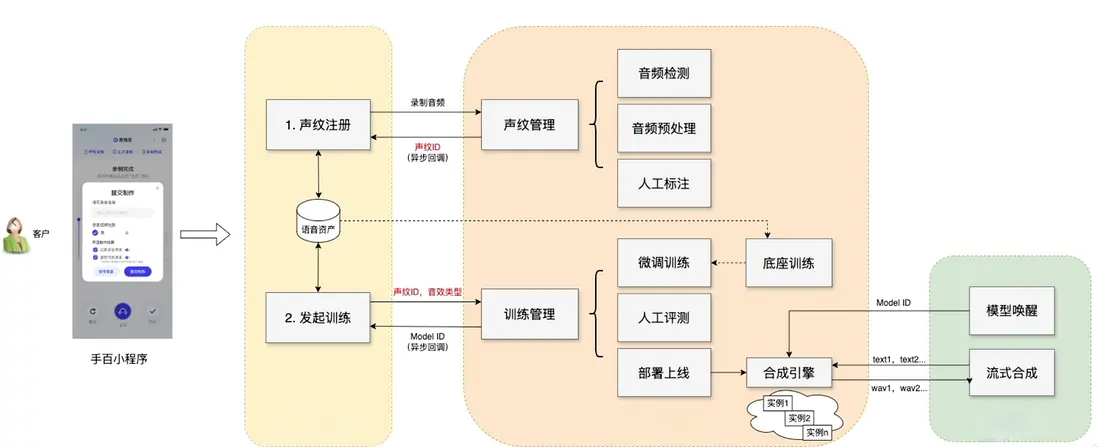

克隆+合成技術架構

整體架構主要包括離線聲紋註冊和模型訓練,在線合成三個部分。

△ 形象克隆及合成架構

05 形象克隆與合成

主播形象是直播的核心要素,高擬真形象能夠提升用户觀看時長,進而提升成單效果。慧播星與視覺技術部深度合作,基於2D數字人技術針對直播場景定製形象克隆和合成能力,建設了接近7800+個公共庫形象,有效地支撐商家在慧播星的前期探索,為自建形象做好準備。

△ 慧播星形象製作

形象克隆技術發展主要經歷了四個階段:

第一階段(2023.3~2023Q4):V1版本唇形驅動方案適配電商直播場景,跑通錄製約束較多的閉嘴且無遮擋錄製+形象克隆流程,建立起第一批公共庫形象

第二階段(2024.Q4~2024.Q2):V3V4版本唇形驅動通過數據建設和模型算法優化實現張嘴錄製和更自然的唇動效果

第三階段(2024.Q3~2025.Q2):進一步降低錄製門檻,支持錄製中遮擋、大幅度側臉和人臉出鏡。

當前階段客户僅需上傳5分鐘左右的自然演繹視頻,系統在3小時內即可自動為客户生成克隆形象。時至25年底慧播星已累計製作32萬多多個形象,8萬多個客户定製形象,線上可用率95%。

第三階段(2025.Q3~至今):突破唇形驅動,建設多人出鏡,動作驅動,表情驅動,持物驅動等下一代形象生成能力(多模協同的超級主播)。

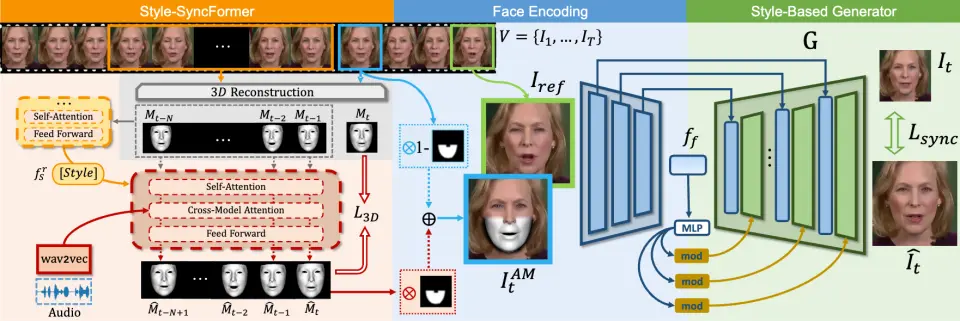

視覺技術

實時場景下早期的唇動方案採用單階段建模(如wav2lip),輸入音頻直接輸出像素空間的唇形圖片。實踐中單階段方案無法達到逼真的唇動效果,後來的商用方案几乎都採用兩階段方案:第一階段將音頻轉化為2D關鍵點或3D人臉模型作為中間表達,第二階段將中間表達利用GAN網絡解碼到像素空間。

視覺生成模型

核心由三個模型組成,3D人臉重建模型,音頻到3D人臉生成模型,3D空間到像素空間人臉生模型。

- 3D人臉重建利用3DMM將人臉圖片(像素)轉換為3D mesh(三維空間點)

- 基於Faceformer改進的音頻到3Dmesh預估模型,mesh作為中間表達攜帶了豐富的面部動態,使得生成模型能夠生成逼真的唇形圖片。

- 基於StyleGan2改進的人臉生成模型,訓練目標包括像素空間的重建損失,特徵空間的感知損失,以及對抗生成損失。實現個性化增量微調方案,複用預訓練底座只學習每個主播的個性化唇動風格,新形象僅需微調,3小時內完成製作。

模型pipeline

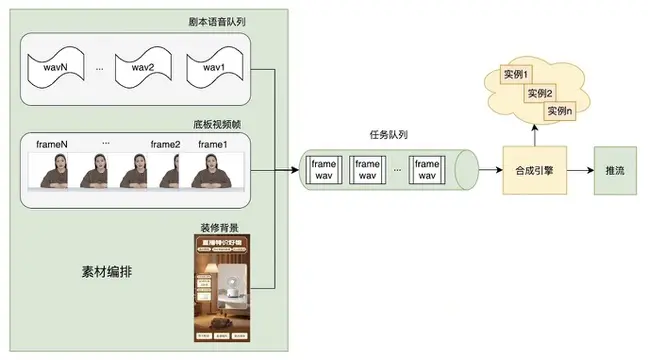

在線合成架構

形象合成以tts音頻、底板視頻幀和直播間背景為輸入,通過生成模型實時合成主播嘴部區域,最後組裝成視頻流推送給用户。其中任務隊列建立緩衝區,保障了視頻流的連續性。目前已實現單卡多路流式渲染,支撐2萬多直播間同時開播

在線流式合成架構

06 總結

歷經兩年多的持續打磨與技術突破,慧播星已經從一款數字人直播工具,成長為覆蓋腳本生成、實時問答、智能中控、語音克隆、形象合成等多模態全鏈路的原生 AI 直播平台。它不僅復刻了真人主播的內容表達與帶貨節奏,更通過商品理解增強、強化學習決策、先驗—後驗數據飛輪、大規模音視頻生成模型等關鍵技術,實現了“超越真人”的直播能力。隨着業務規模的快速擴張與技術體系的持續演進,慧播星已在日均2萬+直播間、萬級定製形象與音色、覆蓋電商與泛行業場景的真實生產環境中驗證了 AI 直播的成熟度和商業價值。未來慧播星將繼續沿着“更智能、更具説服力、更高效”的方向迭代:讓腳本更精準、互動更自然、視覺更逼真、聲音更生動、決策更智慧,並通過持續運轉的數據飛輪不斷突破直播體驗的天花板。