1. 背景介紹

在企業 AI 應用實踐中,並非所有任務都需要部署參數量數百億的大型模型。大量業務場景如工單分類與路由、客服評論情感分析、關鍵信息提取、實時文本翻譯等,屬於高頻但相對簡單的任務,這些場景對響應速度和成本更為敏感。Amazon Graviton 處理器與 Qwen3 0.6B 輕量級模型的結合,為這類場景提供了一個極具性價比的推理解決方案。

通過在多種實例類型上的全面測試,我們發現 Graviton實例相比同配置的 Intel c7i.xlarge 實例,推理速度提升 42%,單次請求成本降低 31%,端到端延遲減少 23%。對於不需要複雜多輪推理的應用場景,基於 CPU 的 Graviton 實例提供了除 GPU 之外的另一種高性價比推理方案選擇,為企業構建成本可控、性能優異的智能化服務提供了理想的技術基礎。

📢限時插播:在本次實驗中,你可以在基於 Graviton 的 EC2 實例上輕鬆啓動 Milvus 向量數據庫,加速您的生成式 AI 應用。

⏩快快點擊進入《創新基石 —— 基於 Graviton 構建差異化生成式AI向量數據庫》實驗

📱 即刻在雲上探索實驗室,開啓構建開發者探索之旅吧!

1.1 Amazon Graviton 處理器:為雲端工作負載優化的 ARM 架構

Amazon Graviton 是亞馬遜雲科技自研的基於 ARM 架構的處理器系列,專為雲端工作負載優化設計。在機器學習推理任務中,Graviton 處理器展現出色的性能表現。相比同等性能的 x86 實例,Graviton 實例可以節省高達 20% 的成本,這對於需要長期運行推理服務的企業而言具有顯著的經濟價值。ARM 架構天然的低功耗特性使得 Graviton 處理器在性能功耗比方面具有明顯優勢,在相同計算能力下消耗更少的能源。

針對 AI 推理工作負載,Graviton 處理器提供了優化的內存帶寬設計,為模型推理過程中的大量數據讀寫操作提供充足的帶寬支持。Graviton 實例與亞馬遜雲科技你服務深度集成,包括 Amazon SageMaker、Amazon Elastic Container Service(Amazon ECS)、Amazon Elastic Kubernetes Service(Amazon EKS)等核心服務,為用户提供 seamless 的部署體驗。這種原生的雲集成能力使得基於 Graviton 的推理服務可以充分利用亞馬遜雲科技生態系統的各項能力。

1.2 Qwen3 0.6B:輕量高效的大語言模型

Qwen3 0.6B 是阿里巴巴通義千問系列的輕量級大語言模型,採用基於 Transformer 的 decoder-only 架構設計。該模型擁有 6 億參數規模,經過完整的預訓練和後訓練階段優化,支持 32K tokens 的上下文長度。儘管參數量相對較小,Qwen3 0.6B 仍然保持了良好的語言理解能力,在多個評測基準上展現出令人印象深刻的性能表現。

從性能特點來看,Qwen3 0.6B 具有多項顯著優勢。模型的輕量化設計使其推理速度快,能夠滿足實時應用場景的響應要求。內存佔用低是該模型的另一大特點,即使在資源受限的環境下也能穩定運行,這為邊緣計算和私有化部署提供了可能。模型對中英文都有良好的支持,特別是在中文語境下表現突出。

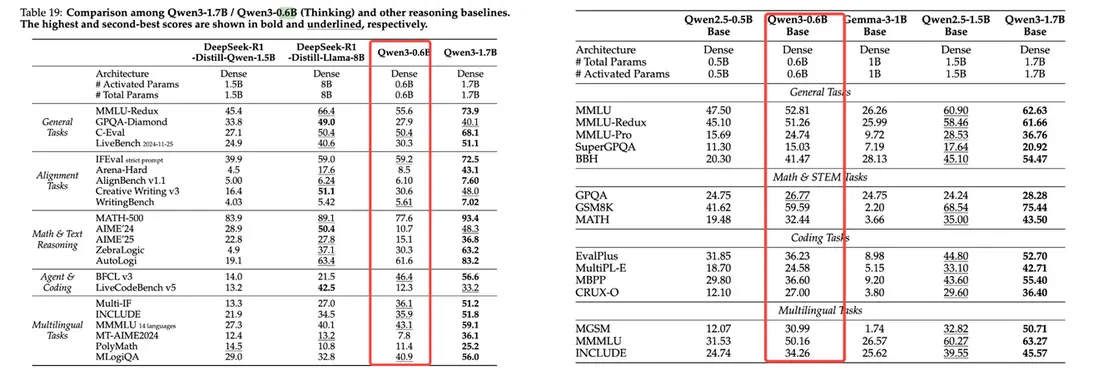

根據圖1官方評估結果,Qwen3 0.6B 在多個評測基準上的表現甚至超過了參數量更大的模型。在 MMLU 任務中,Qwen3 0.6B 獲得了 52.81 的分數,在 Math & STEM 類任務的 GPQA 測試中得分 26.77,在 Coding 類任務的 EvalPlus 中達到 36.23 分。這些數據充分體現了模型在通用語言理解、數學推理和代碼生成等多個維度的綜合能力。對比 Gemma-3-1B(1B 參數)和 Qwen2.5-1.5B(1.5B 參數)等更大規模的模型,Qwen3 0.6B 在某些特定任務上展現出相當甚至更優的性能,證明了其訓練和優化策略的有效性。

從應用場景角度看,Qwen3 0.6B 特別適合部署在邊緣計算設備上,為終端用户提供本地化的 AI 能力。在實時對話系統中,模型的快速響應特性能夠提供流暢的交互體驗。對於文本分類和情感分析等任務,模型的輕量化特性使得大規模部署成為可能。此外,模型還適用於構建知識問答系統,為用户提供基於企業知識庫的智能問答服務。

圖1 Qwen3 系列模型評估結果

Qwen3 0.6B 與 Graviton 處理器的結合,為用户提供了一個成本效益極高的 LLM 推理解決方案。這一技術組合將 ARM 架構的能效優勢與輕量級模型的資源友好特性相結合,在保持推理性能的同時顯著降低了運營成本。在輕量級大語言模型推理場景中,Amazon Graviton 處理器展現出顯著的成本和性能優勢。通過在多種實例類型上對 Qwen3 0.6B 模型進行全面測試,我們發現 Graviton 4 c8g.xlarge 實例相比同配置的 Intel c7i.xlarge 實例,推理速度提升 42%,單次請求成本降低 31%,端到端延遲減少 23%。對於文本分類、情感分析、工單路由、輕量級翻譯等高頻簡單任務,基於 CPU 的 Graviton 實例提供了除 GPU 之外的另一種高性價比推理方案選擇。

2. 部署方法

2.1方案架構

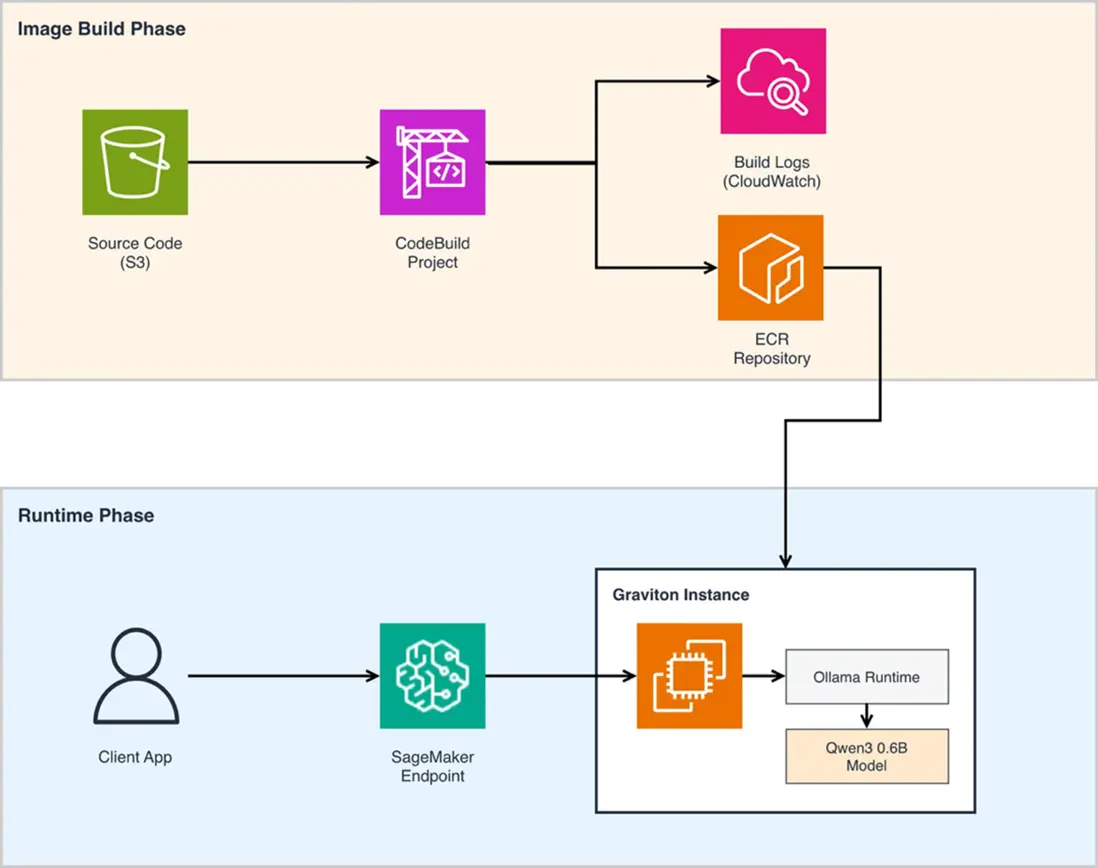

本方案提供了一個完整的部署流程,通過 Amazon SageMaker 和 Ollama 在 Graviton 實例上部署 Qwen3 0.6B 模型。這個方案的核心優勢在於將 Ollama 的簡便性與 Amazon SageMaker 的企業級能力相結合,既保留了 Ollama 在模型管理和推理方面的易用性,又獲得了 SageMaker 在可擴展性、監控和運維方面的強大支持。

整體架構分為兩個核心階段。在鏡像構建階段(Image Build Phase) ,源代碼首先存儲在 Amazon Simple Storage Service(Amazon S3)中,Amazon CodeBuild 項目從 S3 拉取源代碼並執行容器鏡像的構建過程。構建完成後,鏡像被推送到 Amazon Elastic Container Registry(Amazon ECR)進行存儲和版本管理。構建過程中的日誌通過 Amazon CloudWatch 進行集中管理。使用 Amazon CodeBuild 來構建 ARM 架構的容器鏡像,避免了需要單獨啓動 Graviton 實例進行鏡像打包的額外成本和複雜度。

在運行時階段(Runtime Phase) ,客户端應用通過 Amazon SageMaker Endpoint 發起推理請求。SageMaker Endpoint 將請求路由到運行在 Graviton 實例上的容器。在 Graviton 實例內部,Ollama Runtime 負責模型的加載和推理執行,Qwen3 0.6B 模型以優化的方式運行在 ARM 架構上。這種架構使得推理服務可以充分利用 SageMaker 的自動擴縮容、流量分配和模型版本管理等能力。

圖2 在SageMaker上部署Ollama模型推理

2.2部署步驟

完整的部署代碼已開源在 GitHub 倉庫 ,用户可以通過 Jupyter Notebook 腳本一步步完成整個部署流程。以下章節將詳細介紹部署過程中的關鍵步驟,涵蓋從代碼準備到推理調用的完整生命週期。

2.2.1. 克隆部署代碼

首先從 GitHub 倉庫獲取部署所需的全部代碼和配置文件:

git clone https://github.com/aws-samples/llm_deploy_gcr.git

cd llm_deploy_gcr/sagemaker/sagemaker_ollama2.2.2. 鏡像打包

容器鏡像封裝了 Ollama 運行環境、模型推理代碼以及與 SageMaker 集成所需的接口層。Dockerfile 基於 Ollama 官方鏡像構建,並添加了 FastAPI 框架來實現與 Amazon SageMaker Endpoint 的協議適配。

鏡像中的 FastAPI 應用實現了對高併發場景的支持,能夠同時處理多個推理請求。端口 8080 是 SageMaker 推理容器的標準端口。方案使用 Amazon CodeBuild 執行鏡像構建,CodeBuild 支持原生的 ARM64 構建環境,可以直接構建適配 Graviton 處理器的容器鏡像。

2.2.3. 創建和部署 SageMaker Endpoint

接下來需要創建 SageMaker 模型、Endpoint 配置,並部署 Endpoint。在模型配置中,需要指定容器鏡像位置和環境變量,其中 OLLAMA_MODEL_ID 指定加載的模型,OLLAMA_NUM_PARALLEL 控制並行請求數量。在 Endpoint 配置中,明確指定使用 Graviton 實例類型(如 ml.c7g.xlarge),並將 ContainerStartupHealthCheckTimeoutInSeconds 設置為 1200 秒,因為首次啓動時 Ollama 需要下載模型文件。

部署過程是異步的,可以通過輪詢 API 監控部署狀態。當狀態從 “Creating” 變為 “InService” 時,Endpoint 即可開始處理推理請求。完整的代碼實現請參考 GitHub 倉庫中的 Notebook 。

2.2.4. 調用推理接口

部署完成後,客户端可以通過 SageMaker Runtime API 調用推理服務。方案支持流式響應(streaming response),這對於大語言模型的實時交互體驗至關重要。

payload = {

"model": MODEL_ID,

"messages": messages,

"max_tokens": max_tokens,

"stream": True

}

response = sagemaker_runtime.invoke_endpoint_with_response_stream(

EndpointName=endpoint_name,

ContentType='application/json',

Body=json.dumps(payload)

)

buffer = ""

for t in response['Body']:

buffer += t["PayloadPart"]["Bytes"].decode()

last_idx = 0

for match in re.finditer(r'(^|\n)data:\s*({.+?})\n', buffer):

try:

data = json.loads(match.group(2).strip())

last_idx = match.span()[1]

if data["choices"][0]["delta"].get("content", None):

print(data["choices"][0]["delta"]["content"], end="", flush=True)

except (json.JSONDecodeError, KeyError, IndexError) as e:

pass

buffer = buffer[last_idx:]

print()調用代碼使用 invoke_endpoint_with_response_stream 方法實現流式調用,響應數據以 Server-Sent Events(SSE)格式返回。代碼中的緩衝和解析邏輯處理了流式傳輸中可能出現的部分數據和分包問題,確保每個完整的 JSON 對象都能被正確解析。

這個部署方案將開源的 Ollama 生態與亞馬遜雲科技託管服務有機結合。通過 Amazon CodeBuild 實現了 ARM 架構鏡像的自動化構建,通過 Amazon SageMaker 獲得了企業級的模型託管能力,通過 Graviton 實例實現了成本優化。

2.3亞馬遜雲科技中國區(北京/寧夏區域)部署選擇

在亞馬遜雲科技中國區新上線了 Graviton4 機型,與Amazon Graviton3處理器相比,Amazon Graviton4性能提升30%,獨立核心數增加50%,內存帶寬提升75%。可以在EC2 上選擇 Graviton 3 和 Graviton 4 實例部署上述容器進行模型推理。對於API 接入端,同樣可以採用亞馬遜雲科技推出的Static BGP(S-BGP)服務,是專為中國區域(北京和寧夏)設計的一種成本優化型數據傳輸服務。通過這項服務,我們致力於幫助客户在保證網絡性能的同時顯著降低數據傳輸成本。 S-BGP 可為符合條件的客户提供高達20%~70%的數據傳輸費用節省。

3. 應用分析

3.1適用場景:用輕量模型解決高頻簡單任務

在實際業務中,並非所有任務都需要部署參數量數百億的大型模型。很多企業面臨的問題是:70%-80% 的 AI 應用場景其實是相對簡單和標準化的任務,但如果使用大型模型來處理這些場景,成本會顯著增加。Qwen3 0.6B 正是為這類高頻但相對簡單的任務而設計的理想選擇,它能夠在保證任務完成質量的前提下,將推理成本降低到大型模型的幾分之一甚至十分之一。

典型的適用場景包括:工單的自動分類與路由、實時文本翻譯、關鍵信息提取、電商評論的情感分析等。這些任務的共同特點是問題域相對明確,不需要複雜的推理鏈,但對響應速度和成本敏感度高。例如,企業可以使用該模型對每天數萬條客服工單進行自動分類和優先級判定,將技術問題路由至技術團隊、賬務問題路由至財務團隊;或是對跨境電商平台的多語言商品評論進行實時翻譯和情感分析,幫助商家快速瞭解國際用户反饋;又或是從大量合同文檔中自動提取關鍵條款、日期、金額等結構化信息。

3.2性能與成本對比

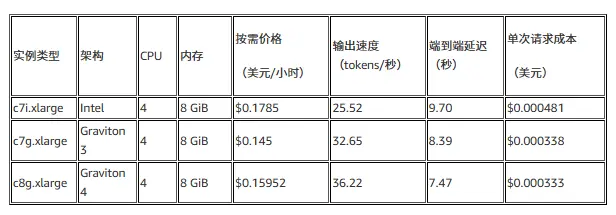

我們在多個 Amazon EC2 實例類型上對 Qwen3 0.6B 模型進行了全面的性能測試。測試條件為 input tokens 和 output tokens 均為 200 時的性能表現:

從測試數據可以清楚看到 Graviton 架構的成本優勢。在相同配置(4 vCPU,8 GiB 內存)下,Graviton 3 c7g.xlarge 相比 Intel c7i.xlarge 的輸出速度提升約 28%(32.65 vs 25.53 tokens/秒),端到端延遲降低約 14%,而單次請求成本下降約 30%。最新的 Graviton 4 c8g.xlarge 實例性能更加出色,輸出速度達到 36.22 tokens/秒,比 Intel 實例快約 42%,端到端延遲僅 7.47 秒,單次請求成本進一步降至 $0.000333。

4. 總結

Amazon Graviton 處理器與 Qwen3 0.6B 模型的結合為企業提供了一個極具性價比的 LLM 推理解決方案。通過SageMaker和Ollama可實現一鍵部署,支持多種應用場景。這一技術組合不僅滿足當前輕量級AI應用需求,還為企業構建成本可控、性能優異的智能化服務提供了理想的技術基礎,特別適合對成本敏感且需要快速響應的生產環境部署。基於實際測試驗證,Graviton 4 實例相比同配置 Intel 實例在推理吞吐量上提升 42%,單次請求成本降低 31%。在工單分類、情感分析、關鍵信息提取、輕量級翻譯等不需要複雜多輪推理的場景下,Graviton CPU 實例提供了除 GPU 之外的另一種推理方案選擇,為企業的技術選型提供了更多靈活性。

參考文檔

https://aws.amazon.com/cn/blogs/machine-learning/reduce-amazo...

https://docs.aws.amazon.com/sagemaker/latest/dg/realtime-endp...

https://docs.aws.amazon.com/sagemaker/latest/dg/realtime-endp...

https://huggingface.co/Qwen/Qwen3-0.6B#best-practices

*前述特定亞馬遜雲科技生成式人工智能相關的服務目前在亞馬遜雲科技海外區域可用。亞馬遜雲科技中國區域相關雲服務由西雲數據和光環新網運營,具體信息以中國區域官網為準。

本篇作者

本期最新實驗為《創新基石 —— 基於 Graviton 構建差異化生成式AI向量數據庫》

✨ 在本次實驗中,你可以在基於 Graviton 的 EC2 實例上輕鬆啓動 Milvus 向量數據庫,加速您的生成式 AI 應用。基於 Graviton 的 EC2 實例為您提供極佳性價比的向量數據庫部署選項。

📱 即刻在雲上探索實驗室,開啓構建開發者探索之旅吧!

⏩[點擊進入實驗] 構建無限, 探索啓程!