系列文章前言

在人工智能技術從理論突破走向工程落地的進程中,一篇篇里程碑式的論文如同燈塔,照亮了技術演進的關鍵路徑。為幫助大家吃透 AI 核心技術的底層邏輯、理清行業發展脈絡,博主推出「AI 十大核心論文解讀系列」,每篇聚焦一篇關鍵論文的問題背景、核心創新與行業影響。本篇博客解讀《Attention Is All You Need》論文。

@

- 系列文章前言

- 前言:為何它能入選AI工程領域“十大必看論文”

- 一、技術背景:Transformer出現前的“三大困境”

- 1. 序列處理效率低下:串行計算拖慢訓練節奏

- 2. 長距離依賴難題:信息衰減導致語義斷裂

- 3. 並行計算能力缺失:硬件資源無法充分利用

- 二、論文深度解讀:自注意力機制如何“顛覆”傳統框架?

- 1、自注意力機制——從“逐字讀”到“全局掃”的範式革命

- (1)自注意力的本質:不止是“找關聯”,更是“動態加權語義融合”

- (2) 縮放點積注意力:解決“相似度分數爆炸”的關鍵

- (3) 多頭注意力:讓模型“多角度看問題”

- 2、Transformer整體架構:編碼器+解碼器的“精密協作系統”

- (1) 編碼器(Encoder):文本“理解器”(6層堆疊)

- (2) 解碼器(Decoder):文本“生成器”(6層堆疊)

- (3) 位置編碼(Positional Encoding):給詞彙“貼位置標籤”

- 1、自注意力機制——從“逐字讀”到“全局掃”的範式革命

- 三、核心優勢:基於論文數據的“碾壓式突破”

- 1. 並行計算效率:從“串行排隊”到“並行開工”

- 2. 長距離依賴捕捉:從“隔山喊話”到“當面交流”

- 3. 規模擴展性價比:從“添磚加瓦”到“搭積木”

- 四、補充:訓練細節與泛化能力

- 1. 訓練關鍵策略

- 2. 泛化能力:不止於翻譯

- 五、總結:一篇論文,開啓AI的“大模型時代”

前言:為何它能入選AI工程領域“十大必看論文”

在人工智能工程的發展史上,有一批論文如同“燈塔”,照亮了技術突破的方向。“AI工程領域十大核心論文”覆蓋模型架構、微調技術、檢索增強、智能體等關鍵方向,而2017年穀歌團隊發表的《Attention Is All You Need》,無疑是其中最具“奠基性”的一篇——它徹底脱離前人的序列模型框架,以全新的“自注意力機制”重構了自然語言處理(NLP)乃至整個深度學習的技術路徑。

如果説GPT、BERT、LLaMA等大模型是AI時代的“高樓大廈”,那《Attention Is All You Need》就是搭建這些大廈的“鋼筋骨架”。如今幾乎所有現代大型語言模型(LLM)的設計,都離不開這篇論文提出的Transformer架構。無論是AI工程師面試必問的“並行計算原理”,還是日常開發依賴的“上下文理解能力”,其技術根源都能追溯到這篇僅11頁的論文。今天,我們就來深度拆解這篇改變AI格局的經典之作。

論文鏈接:https://arxiv.org/abs/1706.03762

一、技術背景:Transformer出現前的“三大困境”

2017年之前,NLP領域的主流技術方案是循環神經網絡(RNN) 和卷積神經網絡(CNN),但這兩種模型存在難以突破的瓶頸,直接限制了AI處理複雜文本的能力。

1. 序列處理效率低下:串行計算拖慢訓練節奏

RNN的核心邏輯是“逐句、逐詞處理文本”——分析一句話時,模型必須先處理第一個詞,再基於其結果處理第二個詞,以此類推。這種串行模式如同人逐字讀文章,無法同時處理多個詞彙,導致訓練速度極慢。對於長文本,RNN的訓練時間會呈指數級增長,根本無法支撐大規模數據訓練。

2. 長距離依賴難題:信息衰減導致語義斷裂

RNN存在“短期記憶”缺陷。比如處理“小明昨天去超市買了蘋果,他今天把____吃了”這句話時,RNN很難將“他”與前文的“小明”、“____”與前文的“蘋果”關聯起來。隨着文本長度增加,早期詞彙的信息會逐漸衰減,模型無法有效捕捉遠距離詞彙的語義聯繫。即便後續出現LSTM、GRU等改進模型,也只是緩解問題,並未從根本上解決。

3. 並行計算能力缺失:硬件資源無法充分利用

當時AI訓練已開始依賴多GPU集羣提升效率,但RNN和CNN幾乎無法支持高效並行。RNN的串行邏輯決定了“下一個詞的計算必須依賴上一個詞”,無法拆分任務到多個GPU同時執行;CNN雖能並行處理局部特徵,但對長文本的全局語義理解能力弱,且並行粒度有限。這種“並行困境”導致模型規模難以擴大——擴大參數規模只能依賴單GPU硬扛,成本和時間都難以承受。

正是在這樣的技術瓶頸下,《Attention Is All You Need》的出現如同一場“技術革命”,用全新思路解決了上述所有問題。

二、論文深度解讀:自注意力機制如何“顛覆”傳統框架?

這篇論文的核心貢獻只有一個:提出Transformer架構,用“自注意力機制”取代傳統的序列處理邏輯。整個架構圍繞“高效處理文本、支持並行計算、捕捉全局語義”三個目標設計,可從“核心機制”“架構細節”和“核心優勢”三方面拆解。

1、自注意力機制——從“逐字讀”到“全局掃”的範式革命

(1)自注意力的本質:不止是“找關聯”,更是“動態加權語義融合”

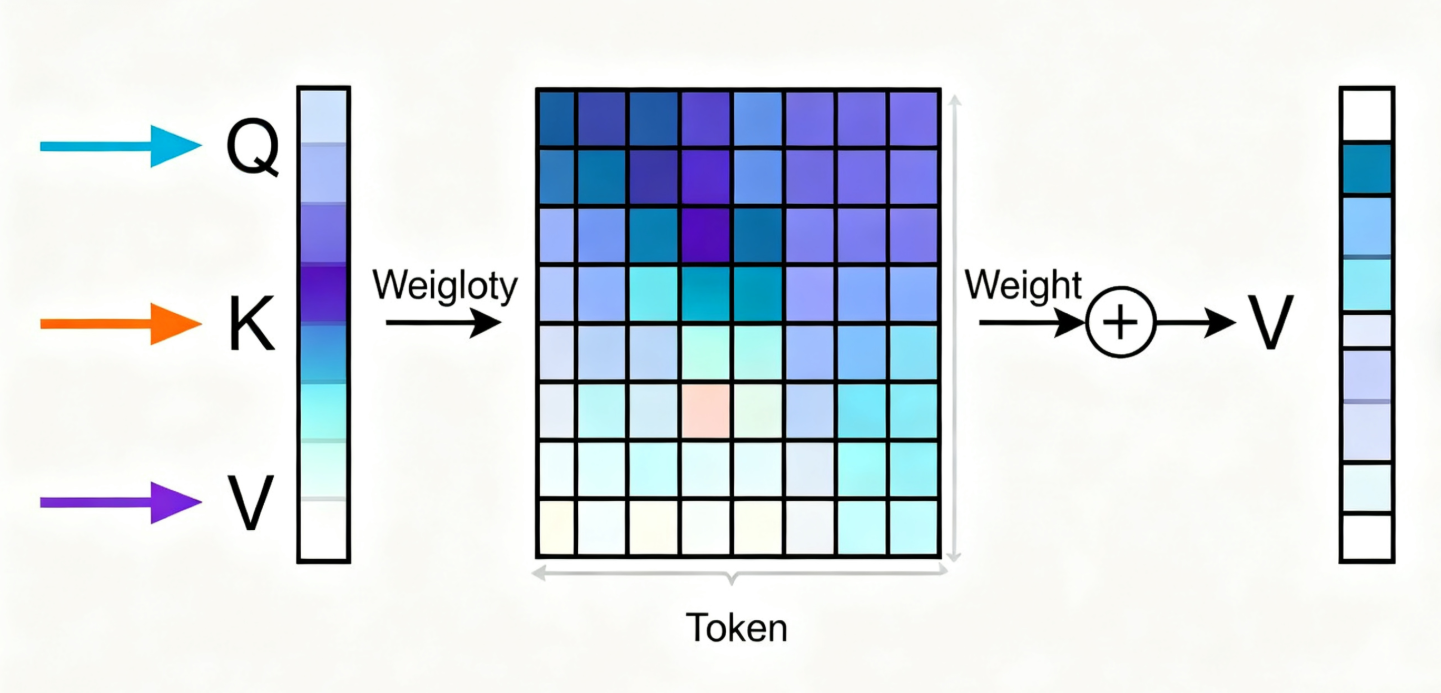

專業定義:自注意力是將查詢(Q)、鍵(K)、值(V)三組向量映射為輸出的函數,輸出是V的加權和,權重由Q與K的相似度計算得出。其核心是通過可學習的參數,為每個位置的token生成“全局依賴表徵”,即每個token的最終向量都融合了所有其他token的語義信息。

通俗類比:把處理句子比作“班級自我介紹”——以前的RNN是“按座位順序逐個發言,只能記住前一個人的名字”;自注意力是“所有人同時站起來,每個人手裏舉着自己的‘關鍵詞牌’(K)和‘詳細介紹’(V),你(當前token)拿着自己的‘需求牌’(Q),快速和所有人比對:和你需求越匹配的人,你越認真聽他的介紹,最後把所有人的介紹按‘認真程度’加權整合,形成自己的最終印象”。

論文關鍵細節補充:

- 向量維度約束:論文中Q、K的維度$d_k=64$,V的維度$d_v=64$,整個模型的表徵維度$d_{model}=512$(所有子層輸出維度統一,方便殘差連接)。

- 計算流程(對應論文公式1):

- 計算Q與K的轉置點積:$QK^T$(得到$n×n$的相似度矩陣,n是序列長度);

- 除以$\sqrt{d_k}$(縮放步驟);

- 經過softmax得到歸一化權重(權重和為1);

- 權重與V矩陣相乘,得到最終輸出。

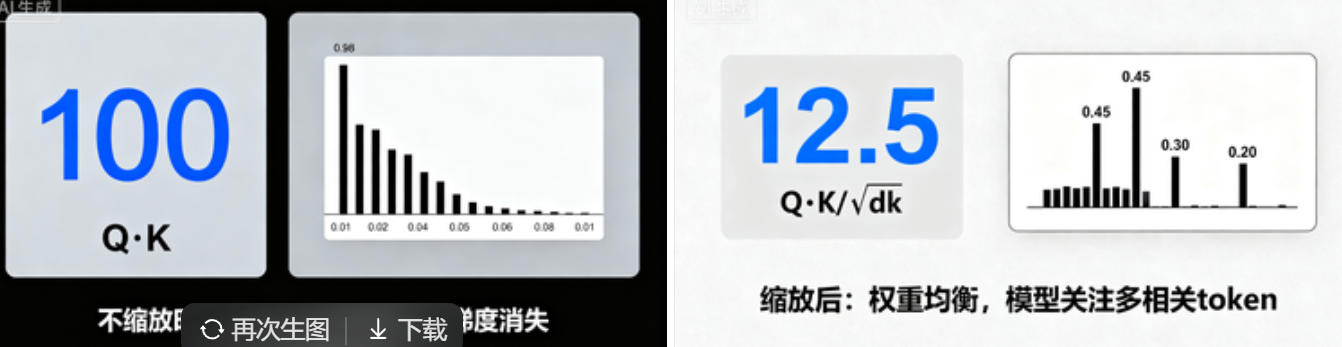

(2) 縮放點積注意力:解決“相似度分數爆炸”的關鍵

專業解釋:為什麼需要縮放?假設Q和K的每個元素都是均值為0、方差為1的獨立隨機變量,它們的點積$q·k=\sum_{i=1}^{d_k}q_ik_i$的均值為0、方差為$d_k$。當$d_k$較大(如$d_k=512$)時,點積結果的數值會非常大,導致softmax函數的輸入值落在“梯度接近0”的區域(softmax在輸入值極大時,輸出趨近於one-hot,導數幾乎為0),模型無法更新參數。 縮放的作用:除以$\sqrt{d_k}$後,點積的方差被歸一化為1,避免softmax陷入“梯度消失陷阱”。

通俗類比:比如$d_k=64$時,$\sqrt{d_k}=8$。如果不縮放,Q和K的點積可能達到幾十甚至上百,softmax會“偏愛”分數最高的那個token,其他token的權重幾乎為0(相當於“只看一個詞,忽略其他所有”);縮放後,分數被“壓縮”到合理範圍(比如原來100分變成12.5分),softmax能更均衡地分配權重,模型能關注到多個相關token。

(3) 多頭注意力:讓模型“多角度看問題”

專業解釋:核心操作是將Q、K、V通過8組獨立的線性投影($W_iQ∈\mathbb{R}×d_k}$,$W_iK∈\mathbb{R}×d_k}$,$W_iV∈\mathbb{R}×d_v}$)拆分為8個“子空間”(h=8,論文固定設置),每個子空間獨立執行縮放點積注意力,得到8個$d_v$維的輸出($d_v=64$),最後將8個輸出拼接,通過一個線性投影$WO∈\mathbb{R}{h d_v×d_{model}}$得到最終結果。參數約束:$h×d_k=d_{model}=512$,確保總計算量與“單頭注意力($d_k=512$)”相當($O(n^2 d_{model})$),不增加額外計算負擔。

通俗類比:多頭注意力就像“8個不同的專家同時分析一句話”——有的專家專門關注“語法依賴”(比如“它”指代哪個名詞),有的關注“語義關聯”(比如“making”和“difficult”的因果關係),有的關注“邏輯連接”(比如“but”前後的轉折)。最後把8個專家的分析結果整合,得到比單個專家更全面的理解。

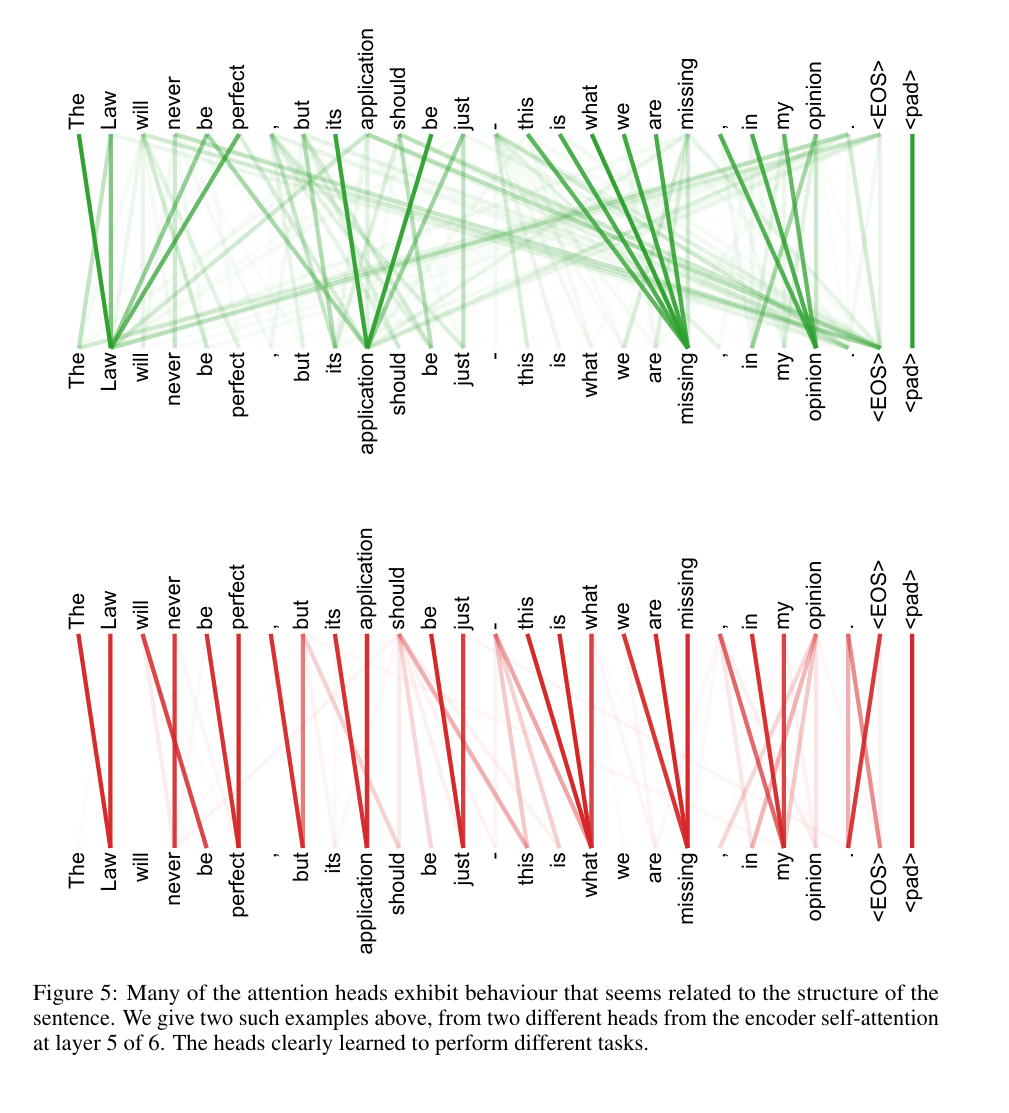

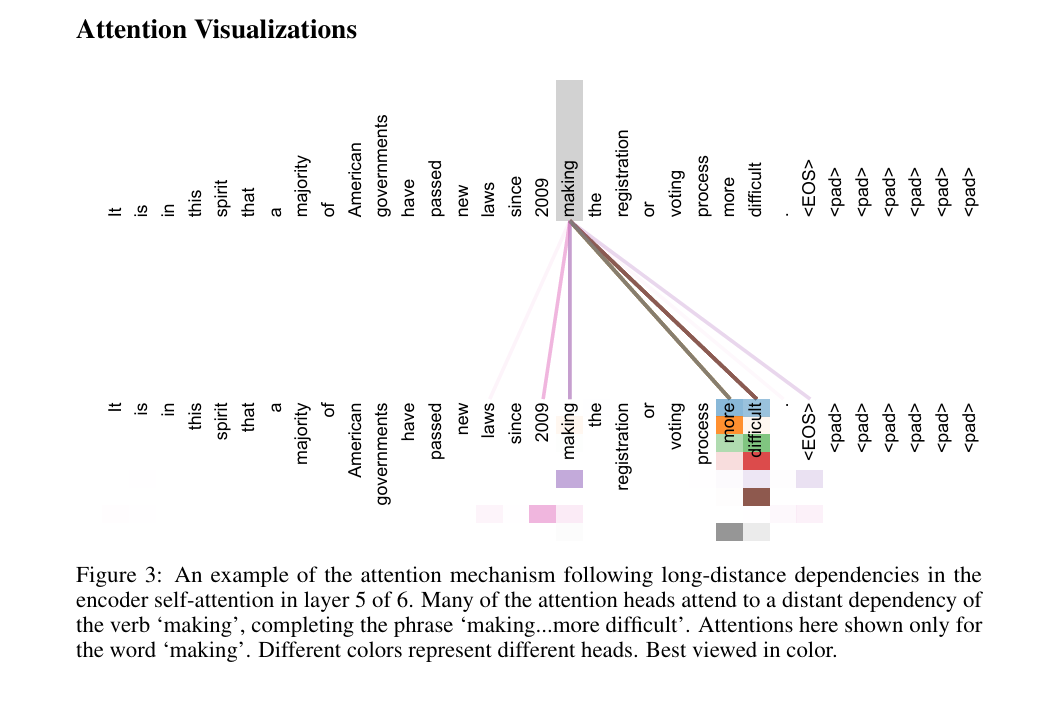

論文實證支持:論文附錄的注意力可視化(圖3-5)顯示,不同頭確實學習到了不同依賴:比如某個頭專門捕捉“making”與“more difficult”的長距離關聯(完成“making...more difficult”短語),另兩個頭負責指代消解(“its”指向“Law”),驗證了多頭設計的有效性。

“許多注意力頭表現出與句子結構相關的行為。我們在上面給出了兩個這樣的例子,它們來自 6 層編碼器自注意力機制中第 5 層的兩個不同注意力頭。這些注意力頭顯然學會了執行不同的任務。”

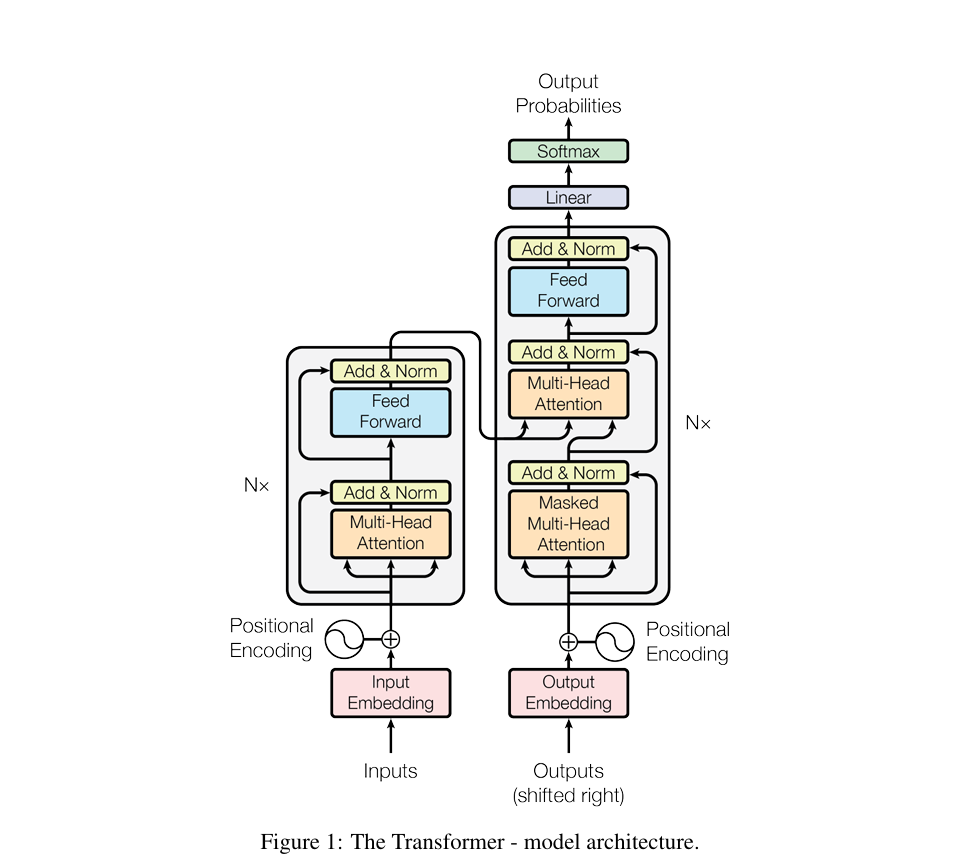

2、Transformer整體架構:編碼器+解碼器的“精密協作系統”

論文節詳細描述了架構細節,核心是“6層堆疊+殘差連接+層歸一化”,每個組件都有明確的設計目標,下面結合參數和原理雙向解讀:

(1) 編碼器(Encoder):文本“理解器”(6層堆疊)

專業結構拆解:

- 每層包含2個子層,且都包裹殘差連接(Residual Connection)和層歸一化(Layer Normalization):

- 子層1:多頭自注意力(Multi-Head Self-Attention)——所有Q、K、V都來自上一層輸出,捕捉輸入序列內部的全局依賴(比如“貓坐在墊子上”中“貓”與“墊子”的位置關係)。

- 子層2:位置wise前饋網絡(Position-wise Feed-Forward Network)——對每個token的表徵獨立進行非線性變換,公式為$FFN(x)=max(0, xW_1+b_1)W_2+b_2$(論文公式3),其中$d_{ff}=2048$(中間層維度),$d_{model}=512$(輸入輸出維度)。

- 關鍵約束:所有子層(包括嵌入層)的輸出維度必須為$d_{model}=512$,否則殘差連接無法進行($x$與Sublayer(x)維度需一致)。

- 殘差連接的作用:緩解深層網絡的梯度消失——通過直接將輸入$x$加到子層輸出,確保梯度能“直接回傳”到淺層,避免因多層變換導致梯度衰減。

通俗類比:編碼器就像“閲讀理解做題步驟”——

- 多頭自注意力:先通讀全文,劃出所有關鍵詞的關聯(比如“原因-結果”“主體-動作”);

- 前饋網絡:針對每個關鍵詞,單獨深化其語義(比如“貓”不僅是“動物”,還是“動作‘坐’的執行者”);

- 殘差連接:確保深化語義時不忘記原文信息(比如不會因為關注“貓”的動作,而忘記“貓”的位置)。

(2) 解碼器(Decoder):文本“生成器”(6層堆疊)

專業結構拆解:

- 每層包含3個子層(比編碼器多1個子層),同樣帶殘差連接和層歸一化:

- 子層1:掩碼多頭自注意力(Masked Multi-Head Self-Attention)——限制當前位置只能關注“之前的位置”(比如生成第3個詞時,只能看第1、2個詞),避免“偷看未來信息”。實現方式是在$QK^T$後,將未來位置的相似度分數設為$-∞$,softmax後權重為0。

- 子層2:編碼器-解碼器注意力(Encoder-Decoder Attention)——Q來自解碼器上一層輸出,K、V來自編碼器最終輸出,讓生成的每個詞都能關注輸入序列的相關位置(比如翻譯“它很舒服”時,“它”關注輸入的“貓”)。

- 子層3:與編碼器相同的位置wise前饋網絡。

- 輸出處理:解碼器最後一層輸出通過線性投影(維度從$d_{model}=512$映射到詞彙表大小,如37000)和softmax,得到下一個詞的概率分佈。

通俗類比:解碼器就像“寫作文”——

- 掩碼自注意力:寫每一句話時,只能參考前面已經寫的內容,不能提前看後面的草稿(保證邏輯連貫);

- 編碼器-解碼器注意力:寫的時候不斷回頭看“閲讀理解的筆記”(輸入文本的語義表徵),確保不偏離原文意思;

- 前饋網絡:把每個詞的表達打磨得更準確(比如把“它舒服”改成“它顯得很舒服”)。

(3) 位置編碼(Positional Encoding):給詞彙“貼位置標籤”

專業解釋:

- 設計原因:Transformer無遞歸/卷積,無法自動捕捉序列順序,必須手動注入位置信息。

- 編碼公式(論文核心公式):

$PE_{(pos, 2i)}=sin(pos/10000^{2i/d_{model}})$

$PE_{(pos, 2i+1)}=cos(pos/10000^{2i/d_{model}})$

其中pos是token在序列中的位置(從0開始),i是維度索引(0到$d_{model}/2-1$)。 - 核心優勢:

- 相對位置可表示:對於任意固定偏移k,$PE_{pos+k}$可通過$PE_{pos}$的正弦和餘弦函數線性組合得到(利用三角恆等式),模型能學習到“相對位置關係”(比如“第2個詞和第5個詞相差3個位置”)。

- 泛化性強:正弦餘弦函數是週期性的,可生成任意長度序列的位置編碼,即使測試時序列長度超過訓練時的最大值(比如訓練時最長512詞,測試時600詞),也能直接計算編碼,無需額外訓練。

- 對比實驗:論文表3(E行)顯示,正弦餘弦編碼與“學習型位置嵌入”(隨機初始化後訓練)性能幾乎一致(BLEU分別為25.7和25.8),但前者更節省參數且泛化性更好。

通俗類比:位置編碼就像“給排隊的人貼編號”——每個token都有一個唯一的“位置標籤”,標籤的設計很巧妙:不僅能看出“誰在第1位、誰在第10位”(絕對位置),還能通過標籤計算“兩人之間差幾個位置”(相對位置),而且不管隊伍多長(序列多長),都能快速生成新的編號。

三、核心優勢:基於論文數據的“碾壓式突破”

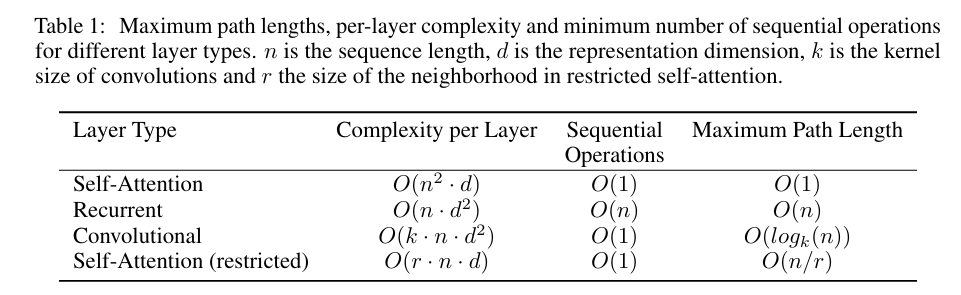

論文通過理論分析(表1)和實驗結果(表2-4),論證了Transformer的三大優勢,下面結合“專業數據+通俗解讀”展開:

1. 並行計算效率:從“串行排隊”到“並行開工”

“表 1:不同層類型的最大路徑長度、每層複雜度及最小順序操作數注:n 為序列長度,d 為表示維度,k 為卷積核大小,r 為受限自注意力中的鄰域大小”

專業分析(論文表1):

- 計算複雜度對比:

- 自注意力:$O(n^2 d)$(n=序列長度,d=表徵維度)——主要開銷是計算$QK^T$($n×n$矩陣)。

- RNN:$O(nd^2)$——每個token都要依賴前一個token的隱藏狀態,無法並行,且複雜度隨d增長更快。

- CNN:$O(kn d^2)$(k=卷積核大小)——雖支持並行,但捕捉長距離依賴需堆疊多層(比如k=3時,捕捉n=100詞的依賴需~30層)。

- 關鍵結論:當$n < d$時(這是NLP任務的常見情況,比如word-piece表徵中n=100,d=512),自注意力的複雜度低於RNN,且並行度極高(所有token的$QK^T$計算可同時進行)。

論文實驗數據:Transformer(big)在8個P100 GPU上訓練3.5天(300,000步),而之前的SOTA模型GNMT訓練需1.1×10²¹ FLOPs(是Transformer的~48倍),卻只達到41.16 BLEU,Transformer則達到41.8 BLEU。

通俗解讀:

- RNN處理句子像“工廠流水線”:只有前一個token處理完,才能處理下一個,100個token要按順序來,效率低。

- Transformer像“建築工地”:所有token同時“開工”,各自計算與其他所有token的關聯,8個GPU就是8個施工隊,同時推進,效率呈指數級提升。

- 舉個例子:處理100詞的句子,RNN需要100個“時間步”,Transformer只需1個“時間步”就能完成所有關聯計算,後續只需要處理前饋網絡和歸一化,並行優勢一目瞭然。

2. 長距離依賴捕捉:從“隔山喊話”到“當面交流”

專業分析(論文表1“最大路徑長度”):

- 最大路徑長度:指輸入序列中任意兩個token的依賴關係,在網絡中需要經過的“層數量”(路徑越短,依賴越容易學習)。

- 自注意力:$O(1)$——任意兩個token直接通過注意力權重關聯,無需經過中間層傳遞。

- RNN:$O(n)$——第1個token和第n個token的依賴,需要經過n-1個時間步的傳遞,梯度容易衰減。

- CNN:$O(log_k n)$——需通過 dilated convolution(空洞卷積)堆疊,路徑長度隨n增長而增加。

論文實證支持:注意力可視化圖3顯示,編碼器第5層的多個頭能直接捕捉“making”(第8個token)與“difficult”(第14個token)的長距離關聯,形成“making the registration process more difficult”的完整短語,而RNN需要逐次傳遞才能建立這種關聯,容易丟失信息。

通俗解讀:

- RNN處理長文本像“傳話遊戲”:第1個詞的信息要經過第2、3、...、n-1個詞才能傳到第n個詞,中間容易“傳錯話”(梯度消失),長距離依賴的信息會嚴重衰減。

- Transformer像“微信羣聊”:不管兩個詞相距多遠(比如第1個詞和第1000個詞),都能直接“@對方”,建立直接關聯,信息傳遞無損耗,長距離依賴的捕捉準確率幾乎不受距離影響。

- 比如處理“雖然他三年前離開了公司,但他的貢獻至今仍被同事們銘記”這句話,Transformer能直接將“他”與“他的貢獻”“同事們”關聯,而RNN可能在傳遞“他”的指代信息時出現偏差。

“圖 3:6 層編碼器自注意力中第 5 層的注意力機制捕捉長距離依賴的示例。許多注意力頭會關注動詞 “making” 的遠距離依賴,以補全短語 “making...more difficult”。此處僅展示針對單詞 “making” 的注意力情況。不同顏色代表不同的注意力頭。建議以彩色查看。”

3. 規模擴展性價比:從“添磚加瓦”到“搭積木”

專業分析:

- 傳統模型(RNN/CNN)擴展規模時,計算量呈“線性增長”甚至“超線性增長”:比如RNN的隱藏層維度從512提升到1024,複雜度從$nd2$變成$n(2d)2=4nd^2$,計算量翻4倍,但性能提升有限。

- Transformer的並行特性讓規模擴展的“邊際成本降低”:論文中“big model”將$d_{model}$從512提升到1024,$d_{ff}$從2048提升到4096,h從8提升到16,參數從6500萬增加到2.13億(3.3倍),但訓練時間僅從12小時(base model)增加到3.5天(big model),而BLEU從27.3提升到28.4(EN-DE任務【BLEU全稱 Bilingual Evaluation Understudy(雙語評估替補),核心是衡量模型生成文本與人工標註參考文本的相似度】),提升幅度顯著。

論文實驗數據:表3顯示,當$d_{model}=1024$、$d_{ff}=4096$時,模型的困惑度(PPL)從4.92降至4.33,BLEU從25.8提升到26.4,驗證了規模擴展的有效性。

通俗解讀:

- 傳統模型擴展像“蓋平房”:要想蓋更高(性能更好),必須把地基、牆體都重新加固(計算量大幅增加),付出的成本很高,但高度提升有限。

- Transformer擴展像“搭樂高”:並行結構就是“標準化積木”,要想搭更高(更大規模),只需增加積木數量(參數),無需重新設計結構,付出的成本遠低於傳統模型,但高度(性能)能持續提升。

- 這也是為什麼後續GPT-3(1750億參數)、PaLM(5400億參數)能基於Transformer架構實現,而無法基於RNN——RNN的串行結構根本支撐不了如此大規模的參數訓練。

四、補充:訓練細節與泛化能力

1. 訓練關鍵策略

- 優化器:Adam(論文5.3節),參數$\beta_1=0.9$,$\beta_2=0.98$,$\epsilon=1e-9$

$\beta_2$接近1,説明對歷史梯度平方的衰減較慢,適合稀疏梯度場景;“模型學習時既重視近期的梯度(當前數據的規律),也不忽視遠期的梯度(之前數據的規律),避免學了新的忘了舊的”。

- 學習率調度:$lrate=d_{model}{-0.5}·min(step_num, step_num·warmup_steps^{-1.5})$(論文公式3)

前4000步線性升温(warmup),避免初始學習率過大導致模型震盪;之後按步長的-0.5次方衰減,確保後期穩定收斂

- 正則化(論文5.4節):

- 殘差dropout:$P_{drop}=0.1$——對每個子層輸出和嵌入+位置編碼的總和進行dropout,防止過擬合;

- 標籤平滑:$\epsilon_{ls}=0.1$——將真實標籤的概率從1.0調整為0.9,其他標籤共享0.1的概率

降低模型對“正確標籤”的過度自信,提升泛化性。

2. 泛化能力:不止於翻譯

- 任務:英語 constituency parsing( constituency 句法分析,即分析句子的短語結構,如“主語短語-謂語短語”)。

- 實驗設置:4層Transformer,$d_{model}=1024$,訓練數據分兩種:僅WSJ(4萬句)、半監督(1700萬句)。

- 結果:僅WSJ訓練時F1=91.3,超過多數傳統模型;半監督訓練時F1=92.7,接近SOTA(RNN Grammar的93.3)。

句法分析要求模型捕捉嚴格的結構依賴(如“定語從句修飾哪個名詞”),且輸出長度遠大於輸入(短語結構樹的節點數是token數的2-3倍),Transformer能在該任務上取得好成績,證明其注意力機制的“結構建模能力”,而非僅適用於翻譯。Transformer不僅能“做好翻譯”,還能“學好語法分析”,説明它掌握的是“語言的通用規律”,而非“翻譯的專屬技巧”,為後續遷移到文本生成、摘要、問答等任務奠定了基礎。

五、總結:一篇論文,開啓AI的“大模型時代”

《Attention Is All You Need》之所以成為AI工程領域的“里程碑”,不僅在於它解決了當時的技術瓶頸,更在於它為後續十年的AI發展奠定了基礎:

- 技術層面:讓“大規模並行訓練”成為可能,直接推動模型參數從“百萬級”躍升到“萬億級”(如GPT-4的萬億參數規模);

- 應用層面:基於Transformer的模型攻克了機器翻譯、文本生成、問答系統等核心任務,讓AI從“實驗室”走進日常生活(如ChatGPT、智能客服、AI寫作工具);

- 工程師視角:理解Transformer的自注意力機制、並行邏輯和架構設計,是掌握大模型開發、優化、部署的“必修課”

如果説AI的發展是一條漫長的道路,那《Attention Is All You Need》就是這條路上的“關鍵路標”——它不僅回答了“如何高效處理文本”的問題,更開啓了“用注意力機制構建智能系統”的全新思路。直到今天,這篇論文的思想仍在影響AI前沿研究(如視覺Transformer(ViT)、多模態Transformer),足以證明其不朽的價值。

對於想要深入AI領域的朋友,建議直接閲讀論文原文(篇幅僅11頁,邏輯清晰、公式簡潔)——理解它,你就理解了現代大模型的“技術原點”。 論文鏈接如下 https://arxiv.org/abs/1706.03762