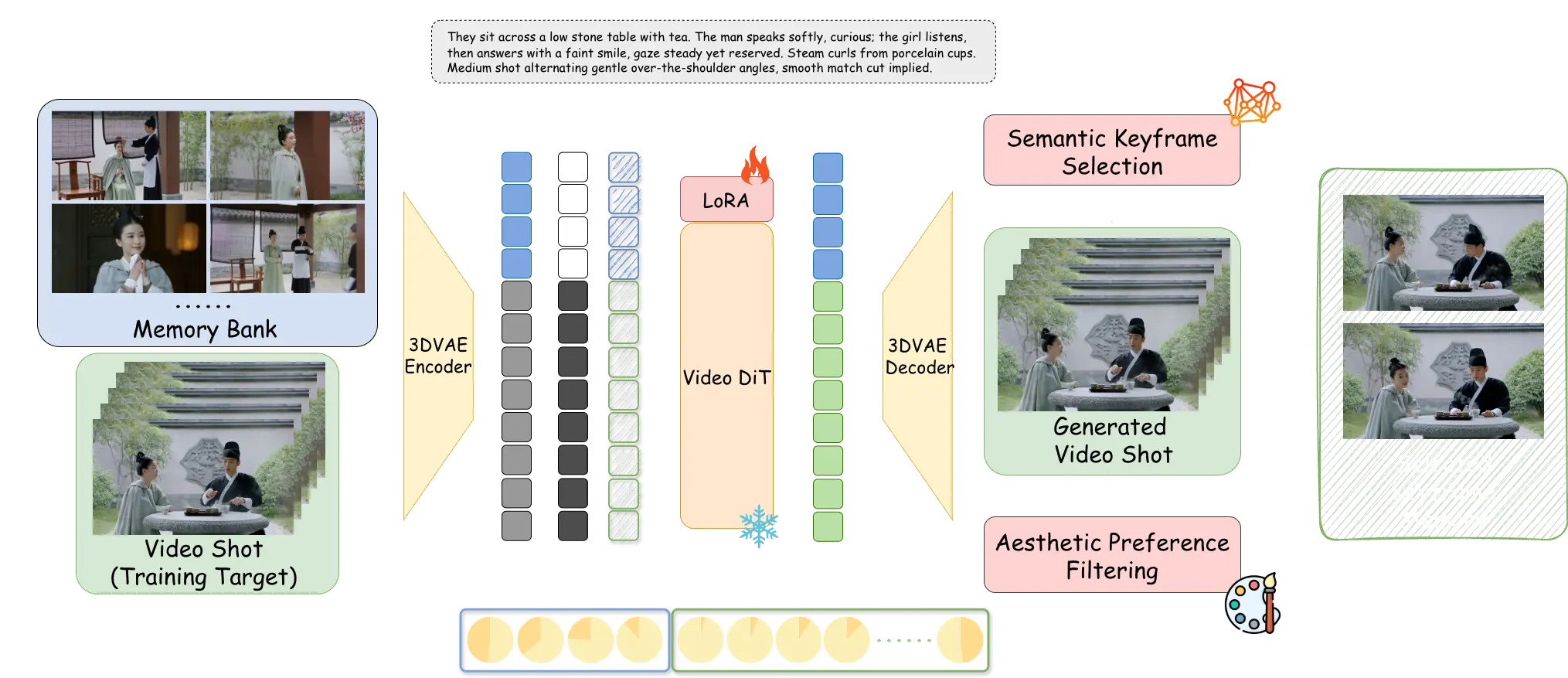

字節跳動與南洋理工大學聯合發佈開源AI視頻生成框架StoryMem,通過“Memory-to-Video(M2V)”機制,將單鏡頭擴散模型升級為支持多鏡頭、超1分鐘連貫敍事的長視頻生成系統。

該框架利用動態記憶庫存儲關鍵幀信息,結合輕量LoRA微調,在角色外貌、場景風格和敍事邏輯上實現跨鏡頭高度一致,一致性指標較現有方法提升29%。

開源地址:https://github.com/Kevin-thu/StoryMem

配套發佈的ST-Bench數據集含300個多鏡頭故事提示,支持標準化評估。社區已開始在ComfyUI中集成該技術。