據谷歌官方消息,NeurIPS 2025 收錄了該公司提出的一項重磅研究,其團隊提出 Nested Learning(嵌套學習)新方法,旨在解決機器學習中的 “災難性遺忘” 問題。

該方法打破模型架構與優化算法分離的傳統框架,將模型視為相互關聯的多層嵌套優化問題,通過多時間尺度更新和連續內存系統,實現新舊知識的協同保留。

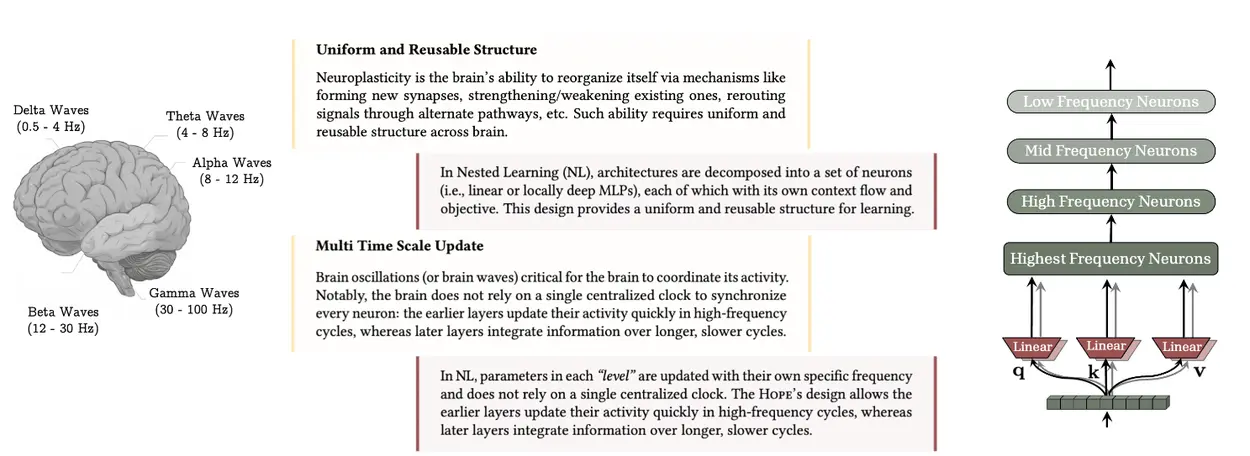

嵌套學習允許大腦的每個組成部分進行多時間尺度的更新,同時表明諸如 Transformer 等眾所周知的架構,實際上是具有不同更新頻率的線性層。嵌套學習模型中的統一結構與多頻率更新機制,與人腦的神經波動與神經可塑性結構十分相似。它使我們能夠在人工模型中定義「多時間尺度更新」:每個學習組件可在不同頻率下更新參數。通過定義「更新頻率」,即每個組件參數被調整的頻率,我們可以將這些優化問題組織成有序的層級結構。

作為概念驗證的 Hope 架構,基於該方法設計而成,具備自修改能力與無限循環學習層級。

實驗表明,Hope 在語言建模、常識推理及長上下文任務中,性能顯著優於 Transformer、Mamba2 等現有最優模型。該範式為新一代自改進 AI 提供了堅實基礎,有望縮小當前大模型與人類持續學習能力的差距。