Liquid AI 宣佈推出 LFM2.5-1.2B-Thinking 推理模型,僅佔用手機 900 MB 的內存,卻能提供同等體積下最快的推理速度和最佳的推理質量。

根據介紹,LFM2.5-1.2B-Thinking是LFM2.5 系列的最新成員。它是一個擁有 12 億參數的模型,專門針對推理任務進行訓練。它會在生成答案之前生成思考軌跡,系統地解決問題。該模型利用 LFM 獨特的推理速度優勢,生成更高質量的答案。

與 LFM2.5-1.2B-Instruct 相比,LFM2.5-1.2B-Thinkin 有三項能力大幅提升:數學推理(MATH-500 上的 63→88)、指令遵循(Multi-IF 上的 61→69)和工具使用(BFCLv3 上的 49→57)。

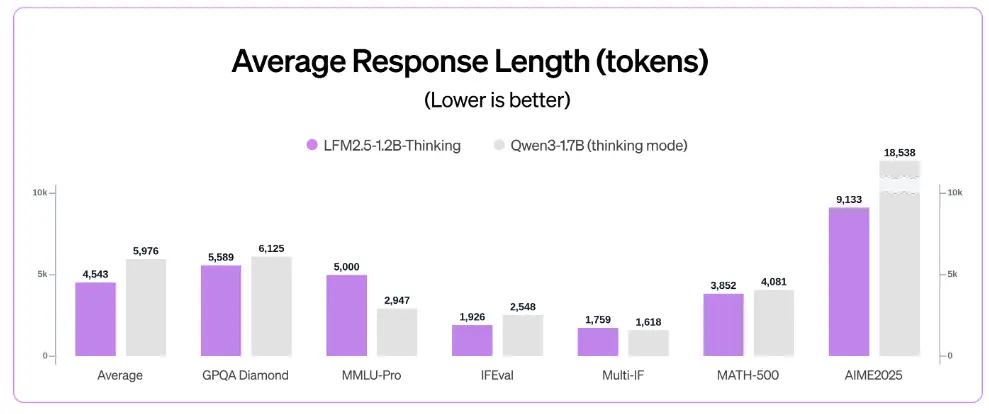

公告稱,儘管參數量減少了 40%,但 LFM2.5-1.2B-Thinking 在大多數推理基準測試中表現與 Qwen3-1.7B 相當甚至更優。此外,它兼具高質量和高效的測試時計算能力。與 Qwen3-1.7B(思考模式)相比,它在提供更高整體性能的同時,所需的輸出 token 更少。

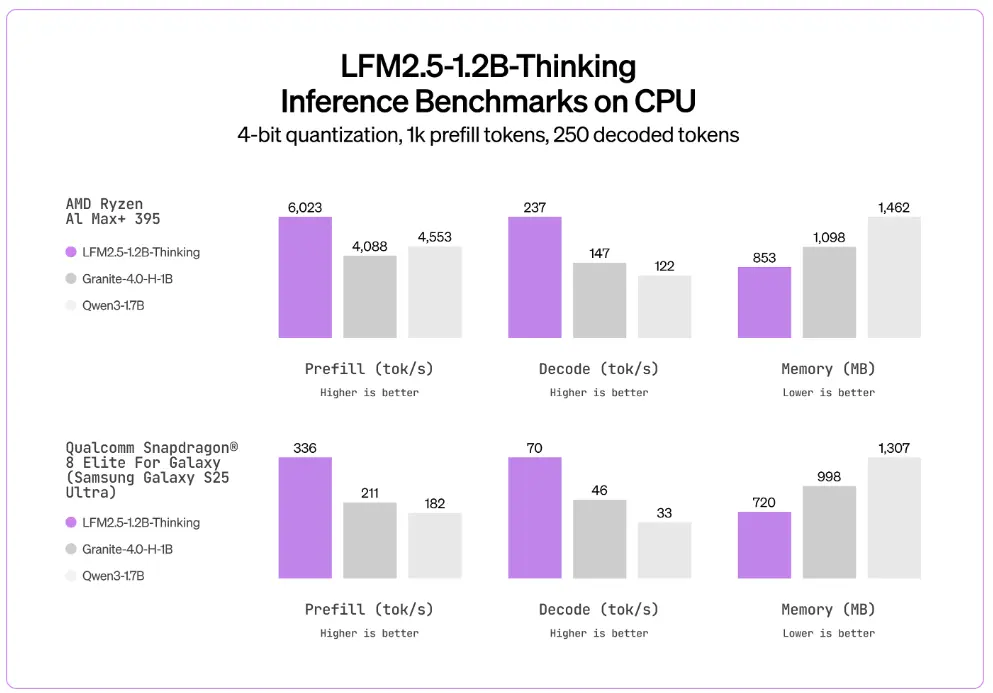

在推理階段,LFM2.5-1.2B-Thinking 不僅在速度和內存效率方面超過了 Qwen3-1.7B,甚至超過了 Granite-4.0-H-1B 等混合架構。

且 LFM2.5-1.2B-Thinking 在需要大量自主性和推理的任務(例如工具使用、數學運算、編程)、以及長上下文推理方面的表現也十分出色。