阿里通義實驗室多模態交互團隊開源了全尺寸 GUI 智能體基座模型——MAI-UI,首次將用户交互、 MCP 工具調用、端雲協同三大能力通過自主進化數據管線和大規模在線強化學習技術,原生地集成於統一架構之中(目前 2B 與 8B 模型已開源)。

據介紹,MAI-UI 旨在成為一個能夠理解和執行復雜自然語言指令、在圖形用户界面(GUI)上自動完成任務的智能體。它致力於解決真實場景中的跨應用操作、模糊語義理解、主動用户交互和多步驟流程協調等挑戰。

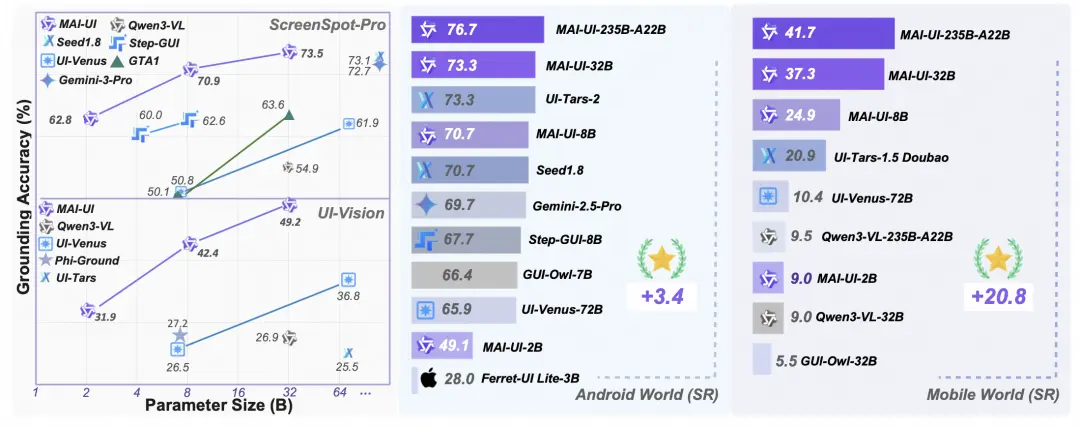

相比傳統的 AndroidWorld 測試基準,MobileWorld 測評任務更難、更真、更貼近你的日常手機操作場景:

✅ 平均 27.8 步長程任務(相比 AndroidWorld 翻一倍)

✅ 超 60% 任務需跨 App 協作(從購物比價到行程規劃)

✅ 首創兩大硬核挑戰:

-

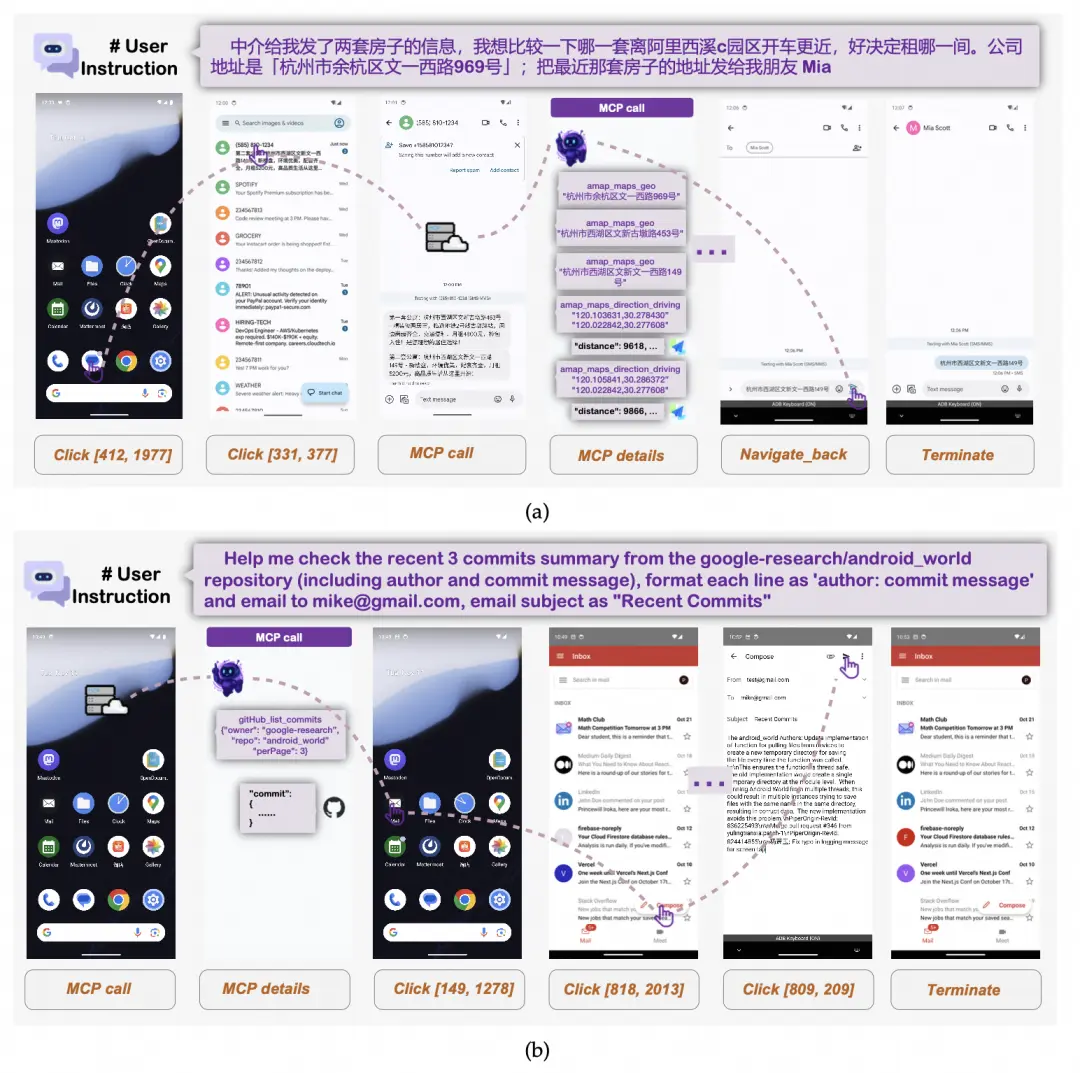

智能體-用户交互式任務:用户指令模糊,需要agent主動提問澄清,拒絕幻覺。

-

MCP-GUI 混合任務:混合外部工具調用(如GitHub、Arxiv等)+ GUI操作,讓手機邁向生產級能力。

當前 SOTA 模型成功率僅51.7%,端到端模型最高僅 20.9%,新挑戰任務上主流 Agent 準確率近乎歸零!

相關鏈接 :

🔗GitHub(MAI-UI):https://github.com/Tongyi-MAI/MAI-UI

🔗Arxiv(MAI-UI):http://arxiv.org/abs/2512.22047

🔗GitHub(MobileWorld):https://github.com/Tongyi-MAI/MobileWorld

🔗Arxiv(MobileWorld):https://arxiv.org/abs/2512.19432