人工智能在理解人類行為方面取得了突破性進展。得克薩斯農工大學(Texas A&M University)的研究人員近日開發出一種名為“OmniPredict”的新型人工智能系統,該系統展現出了前所未有的“讀心”能力——它不僅能看見人類的動作,更能通過解讀視覺和環境線索,實時預判人類的下一步意圖。

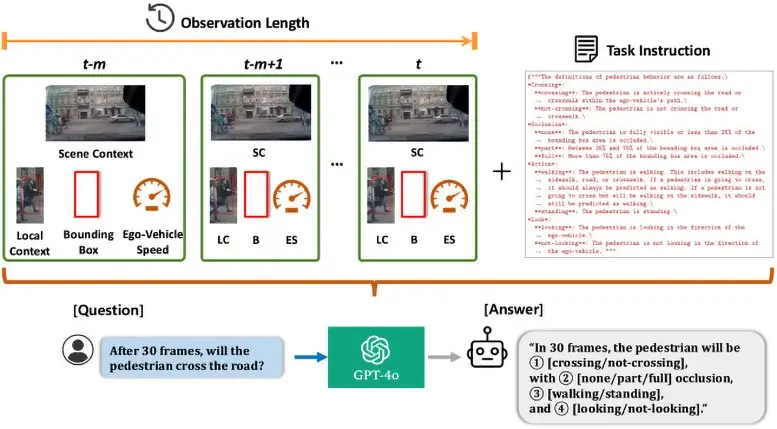

這一研究成果標誌着自動駕駛技術從“被動反應”向“主動直覺”的重大跨越。傳統的自動駕駛系統通常只能識別行人的當前位置和移動軌跡,而 OmniPredict 則引入了多模態大語言模型(MLLM)技術,使其具備了類似人類的推理能力。該系統能夠敏鋭地捕捉行人的姿態變化、猶豫瞬間、身體朝向甚至眼神壓力等細微信號,從而推斷行人究竟是準備過馬路、只是在路邊等待,還是會有其他突發行為。

研究團隊指出,OmniPredict 的核心優勢在於它不再僅僅是“看”各種像素點,而是試圖理解行為背後的“為什麼”。通過分析複雜的混合輸入信息,該模型將人類行為精準地歸類為穿越馬路、視線遮擋、具體動作和注視方向等關鍵類別。在測試中,OmniPredict 展現了高達67%的預測準確率,比目前市面上最先進的模型高出了整整10個百分點。更令人印象深刻的是,即便在行人被部分遮擋或僅通過眼神與車輛互動的複雜場景下,該系統依然保持了極高的判斷穩定性。

項目負責人斯里坎特·薩里帕利(Srikanth Saripalli)博士表示,OmniPredict 賦予了機器一種全新的“街頭智慧”(Street Smarts)。如果自動駕駛汽車能夠像人類駕駛員一樣,讀懂路人“欲言又止”的肢體語言並預判其下一步動作,道路交通的安全性將得到質的飛躍。除了自動駕駛領域,這項能夠解讀肢體語言和心理狀態的技術,未來還有望在軍事行動及緊急救援等高風險場景中發揮關鍵作用,通過賦予機器“直覺”,徹底改變人機協作的模式。

編譯自/ScitechDaily