螞蟻集團旗下具身智能公司靈波科技正式開源高精度空間感知模型 LingBot-Depth。

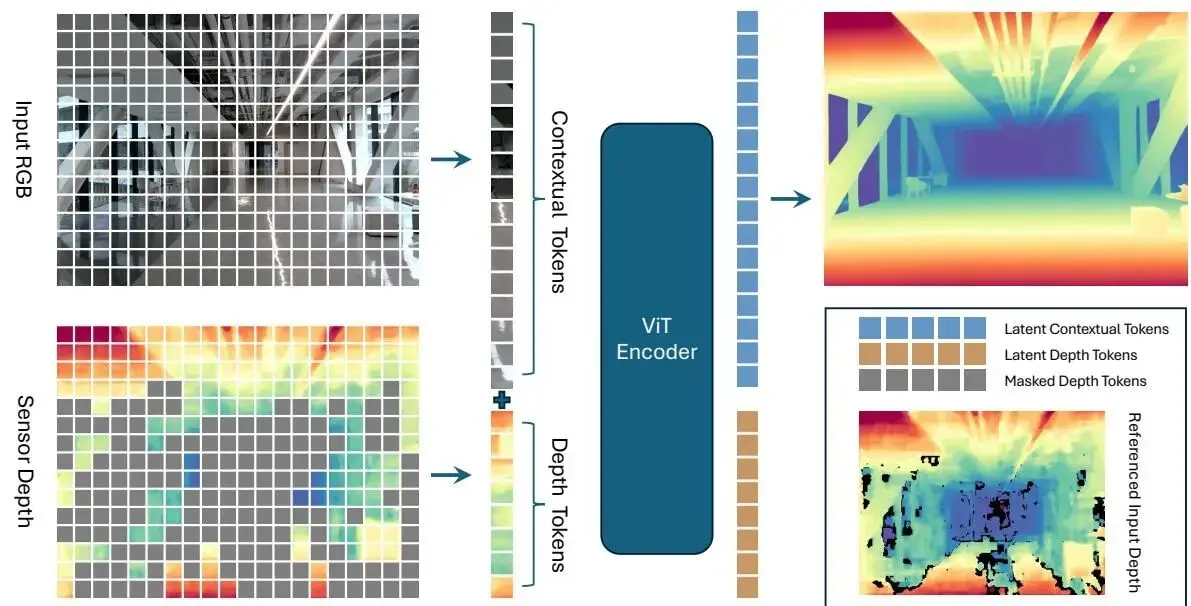

據介紹,LingBot-Depth 是一種面向真實場景的深度補全模型,依託奧比中光 Gemini 330 系列雙目 3D 相機進行 RGB-Depth 數據採集與效果驗證,並基於深度引擎芯片直出的深度數據進行訓練與優化,旨在將不完整且受噪聲干擾的深度傳感器數據轉化為高質量、具備真實尺度的三維測量結果,提升環境深度感知與三維空間理解能力,為機器人、自動駕駛汽車等智能終端賦予更精準、更可靠的三維視覺。

LingBot-Depth 核心亮點

- 精準且穩定的相機深度感知

- 卓越的 3D 和 4D 環境感知能力

- 靈巧抓取操作適用於透明與反光物體

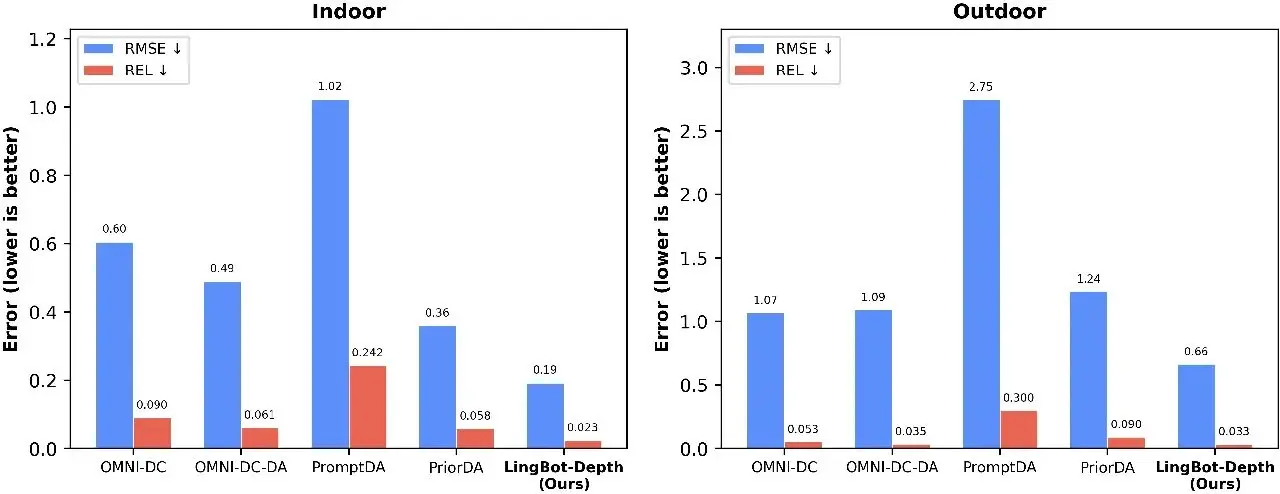

實驗結果表明,該模型在深度精度與像素覆蓋率兩項核心指標上均超越業界頂級工業級深度相機。在 NYUv2、ETH3D 等多個基準測試中,LingBot-Depth 在深度補全、單目深度估計及雙目匹配任務上均達到當前最優水平,並在無需顯式時序建模的情況下保持視頻級時間一致性。

LingBot-Depth 模型也已通過奧比中光深度視覺實驗室的專業認證,在精度、穩定性及複雜場景適應性方面均達到行業領先水平。

在最具挑戰的稀疏深度補全任務中,LingBot-Depth 性能整體優於現有多種主流模型。(圖中數值越低代表性能越好。)下游任務驗證進一步表明,模型能夠在 RGB 與深度兩種模態之間學習到對齊的潛在空間表徵,從而實現對透明及反光物體的穩定機器人抓取。

LingBot-Depth 研發團隊介紹稱,他們研發了“掩碼深度建模”(Masked Depth Modeling,MDM)技術。雖然訓練過程中使用海量 RGB–深度圖像對,但刻意遮擋其中一部分深度區域,讓模型僅根據 RGB 圖像去預測缺失的深度值。隨着訓練進行,模型逐漸學會建立“外觀—幾何”之間的對應關係,也就是從“物體看起來像什麼”推斷“它大概有多遠”。

LingBot-Depth 模型、代碼、技術報告已全部開源:

Website:https://technology.robbyant.com/lingbot-depth

Model:https://huggingface.co/robbyant/lingbot-depth

Code:https://github.com/Robbyant/lingbot-depthTech

Report:https://github.com/Robbyant/lingbot-depth/blob/main/tech-report.pdf