一、序 言

在分佈式系統中,網絡請求的可靠性直接決定了服務質量。想象一下,當你的支付系統因第三方API超時導致訂單狀態不一致,或因瞬時網絡抖動造成用户操作失敗,這些問題往往源於HTTP客户端缺乏完善的超時控制和重試策略。Golang標準庫雖然提供了基礎的HTTP客户端實現,但在高併發、高可用場景下,我們需要更精細化的策略來應對複雜的網絡環境。

二、超時控制的風險與必要性

2024年Cloudflare的網絡報告顯示,78%的服務中斷事件與不合理的超時配置直接相關。當一個HTTP請求因目標服務無響應而長時間阻塞時,不僅會佔用寶貴的系統資源,更可能引發級聯故障——大量堆積的阻塞請求會耗盡連接池資源,導致新請求無法建立,最終演變為服務雪崩。超時控制本質上是一種資源保護機制,通過設定合理的時間邊界,確保單個請求的異常不會擴散到整個系統。

超時配置不當的兩大典型風險:

- DoS攻擊放大效應:缺乏連接超時限制的客户端,在遭遇惡意慢響應攻擊時,會維持大量半開連接,迅速耗盡服務器文件描述符。

- 資源利用率倒掛:當ReadTimeout設置過長(如默認的0表示無限制),慢請求會長期佔用連接池資源。Netflix的性能數據顯示,將超時時間從30秒優化到5秒後,連接池利用率提升了400%,服務吞吐量增長2.3倍。

三、超時參數示例

永遠不要依賴默認的http.DefaultClient,其Timeout為0(無超時)。生產環境必須顯式配置所有超時參數,形成防禦性編程習慣。

以下代碼展示如何通過net.Dialer配置連接超時和keep-alive策略:

transport := &http.Transport{

DialContext: (&net.Dialer{

Timeout: 3 * time.Second, // TCP連接建立超時

KeepAlive: 30 * time.Second, // 連接保活時間

DualStack: true, // 支持IPv4/IPv6雙棧

}).DialContext,

ResponseHeaderTimeout: 5 * time.Second, // 等待響應頭超時

MaxIdleConnsPerHost: 100, // 每個主機的最大空閒連接

}

client := &http.Client{

Transport: transport,

Timeout: 10 * time.Second, // 整個請求的超時時間

}

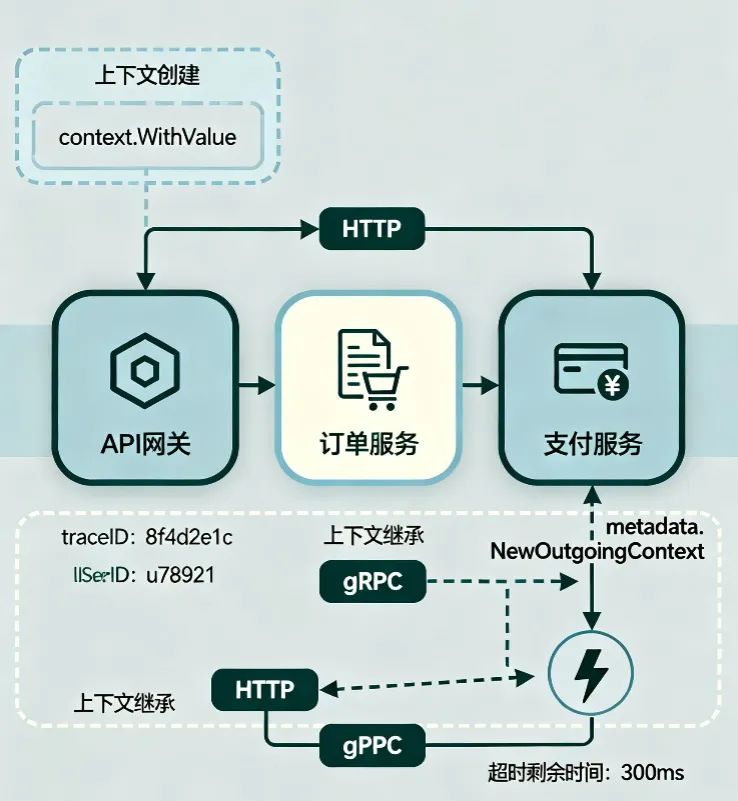

四、基於context的超時實現

context.Context為請求超時提供了更靈活的控制機制,特別是在分佈式追蹤和請求取消場景中。與http.Client的超時參數不同,context超時可以實現請求級別的超時傳遞,例如在微服務調用鏈中傳遞超時剩餘時間。

4.1 上下文超時傳遞

如圖所示,context通過WithTimeout或WithDeadline創建超時上下文,在請求過程中逐級傳遞。當父context被取消時,子context會立即終止請求,避免資源泄漏。

4.2 帶追蹤的超時控制

func requestWithTracing(ctx context.Context) (*http.Response, error) {

// 從父上下文派生5秒超時的子上下文

ctx, cancel := context.WithTimeout(ctx, 5*time.Second)

defer cancel() // 確保無論成功失敗都取消上下文

req, err := http.NewRequestWithContext(ctx, "GET", "https://api.example.com/data", nil)

if err != nil {

return nil, fmt.Errorf("創建請求失敗: %v", err)

}

// 添加分佈式追蹤信息

req.Header.Set("X-Request-ID", ctx.Value("request-id").(string))

client := &http.Client{

Transport: &http.Transport{

DialContext: (&net.Dialer{

Timeout: 2 * time.Second,

}).DialContext,

},

// 注意: 此處不設置Timeout,完全由context控制

}

resp, err := client.Do(req)

if err != nil {

// 區分上下文取消和其他錯誤

if ctx.Err() == context.DeadlineExceeded {

return nil, fmt.Errorf("請求超時: %w", ctx.Err())

}

return nil, fmt.Errorf("請求失敗: %v", err)

}

return resp, nil

}關鍵區別:context.WithTimeout與http.Client.Timeout是疊加關係而非替代關係。當同時設置時,取兩者中較小的值。

五、重試策略

網絡請求失敗不可避免,但盲目重試可能加劇服務負載,甚至引發驚羣效應。一個健壯的重試機制需要結合錯誤類型判斷、退避算法和冪等性保證,在可靠性和服務保護間取得平衡。

5.1 指數退避與抖動

指數退避通過逐漸增加重試間隔,避免對故障服務造成二次衝擊。Golang實現中需加入隨機抖動,防止多個客户端同時重試導致的波峯效應。

以下是簡單的重試實現示例:

type RetryPolicy struct {

MaxRetries int

InitialBackoff time.Duration

MaxBackoff time.Duration

JitterFactor float64 // 抖動係數,建議0.1-0.5

}

// 帶抖動的指數退避

func (rp *RetryPolicy) Backoff(attempt int) time.Duration {

if attempt <= 0 {

return rp.InitialBackoff

}

// 指數增長: InitialBackoff * 2^(attempt-1)

backoff := rp.InitialBackoff * (1 << (attempt - 1))

if backoff > rp.MaxBackoff {

backoff = rp.MaxBackoff

}

// 添加抖動: [backoff*(1-jitter), backoff*(1+jitter)]

jitter := time.Duration(rand.Float64() * float64(backoff) * rp.JitterFactor)

return backoff - jitter + 2*jitter // 均勻分佈在抖動範圍內

}

// 通用重試執行器

func Retry(ctx context.Context, policy RetryPolicy, fn func() error) error {

var err error

for attempt := 0; attempt <= policy.MaxRetries; attempt++ {

if attempt > 0 {

// 檢查上下文是否已取消

select {

case <-ctx.Done():

return fmt.Errorf("重試被取消: %w", ctx.Err())

default:

}

backoff := policy.Backoff(attempt)

timer := time.NewTimer(backoff)

select {

case <-timer.C:

case <-ctx.Done():

timer.Stop()

return fmt.Errorf("重試被取消: %w", ctx.Err())

}

}

err = fn()

if err == nil {

return nil

}

// 判斷是否應該重試

if !shouldRetry(err) {

return err

}

}

return fmt.Errorf("達到最大重試次數 %d: %w", policy.MaxRetries, err)

}

5.2 錯誤類型判斷

盲目重試所有錯誤不僅無效,還可能導致數據不一致。shouldRetry函數需要精確區分可重試錯誤類型:

func shouldRetry(err error) bool {

// 網絡層面錯誤

var netErr net.Error

if errors.As(err, &netErr) {

// 超時錯誤和臨時網絡錯誤可重試

return netErr.Timeout() || netErr.Temporary()

}

// HTTP狀態碼判斷

var respErr *url.Error

if errors.As(err, &respErr) {

if resp, ok := respErr.Response.(*http.Response); ok {

switch resp.StatusCode {

case 429, 500, 502, 503, 504:

return true // 限流和服務器錯誤可重試

case 408:

return true // 請求超時可重試

}

}

}

// 應用層自定義錯誤

if errors.Is(err, ErrRateLimited) || errors.Is(err, ErrServiceUnavailable) {

return true

}

return false

}

行業最佳實踐:Netflix的重試策略建議:對5xx錯誤最多重試3次,對429錯誤使用Retry-After頭指定的間隔,對網絡錯誤使用指數退避(初始100ms,最大5秒)。

六、冪等性保證

重試機制的前提是請求必須是冪等的,否則重試可能導致數據不一致(如重複扣款)。實現冪等性的核心是確保多次相同請求產生相同的副作用,常見方案包括請求ID機制和樂觀鎖。

6.1 請求ID+Redis實現

基於UUID請求ID和Redis的冪等性檢查機制,可確保重複請求僅被處理一次:

type IdempotentClient struct {

redisClient *redis.Client

prefix string // Redis鍵前綴

ttl time.Duration // 冪等鍵過期時間

}

// 生成唯一請求ID

func (ic *IdempotentClient) NewRequestID() string {

return uuid.New().String()

}

// 執行冪等請求

func (ic *IdempotentClient) Do(req *http.Request, requestID string) (*http.Response, error) {

// 檢查請求是否已處理

key := fmt.Sprintf("%s:%s", ic.prefix, requestID)

exists, err := ic.redisClient.Exists(req.Context(), key).Result()

if err != nil {

return nil, fmt.Errorf("冪等檢查失敗: %v", err)

}

if exists == 1 {

// 返回緩存的響應或標記為重複請求

return nil, fmt.Errorf("請求已處理: %s", requestID)

}

// 使用SET NX確保只有一個請求能通過檢查

set, err := ic.redisClient.SetNX(

req.Context(),

key,

"processing",

ic.ttl,

).Result()

if err != nil {

return nil, fmt.Errorf("冪等鎖失敗: %v", err)

}

if !set {

return nil, fmt.Errorf("併發請求衝突: %s", requestID)

}

// 執行請求

client := &http.Client{/* 配置 */}

resp, err := client.Do(req)

if err != nil {

// 請求失敗時刪除冪等標記

ic.redisClient.Del(req.Context(), key)

return nil, err

}

// 請求成功,更新冪等標記狀態

ic.redisClient.Set(req.Context(), key, "completed", ic.ttl)

return resp, nil

}

關鍵設計:冪等鍵的TTL應大於最大重試周期+業務處理時間。例如,若最大重試間隔為30秒,處理耗時5秒,建議TTL設置為60秒,避免重試過程中鍵過期導致的重複處理。

6.2 業務層冪等策略

對於寫操作,還需在業務層實現冪等邏輯:

- 更新操作:使用樂觀鎖(如UPDATE ... WHERE version = ?)

- 創建操作:使用唯一索引(如訂單號、外部交易號)

- 刪除操作:採用"標記刪除"而非物理刪除

七、性能優化

高併發場景下,HTTP客户端的性能瓶頸通常不在於網絡延遲,而在於連接管理和內存分配。通過合理配置連接池和複用資源,可顯著提升吞吐量。

7.1 連接池配置

http.Transport的連接池參數優化對性能影響巨大,以下是經過生產驗證的配置:

func NewOptimizedTransport() *http.Transport {

return &http.Transport{

// 連接池配置

MaxIdleConns: 1000, // 全局最大空閒連接

MaxIdleConnsPerHost: 100, // 每個主機的最大空閒連接

IdleConnTimeout: 90 * time.Second, // 空閒連接超時時間

// TCP配置

DialContext: (&net.Dialer{

Timeout: 2 * time.Second,

KeepAlive: 30 * time.Second,

}).DialContext,

// TLS配置

TLSHandshakeTimeout: 5 * time.Second,

TLSClientConfig: &tls.Config{

InsecureSkipVerify: false,

MinVersion: tls.VersionTLS12,

},

// 其他優化

ExpectContinueTimeout: 1 * time.Second,

DisableCompression: false, // 啓用壓縮

}

}Uber的性能測試顯示,將MaxIdleConnsPerHost從默認的2提升到100後,針對同一API的併發請求延遲從85ms降至12ms,吞吐量提升6倍。

7.2 sync.Pool內存複用

頻繁創建http.Request和http.Response會導致大量內存分配和GC壓力。使用sync.Pool複用這些對象可減少90%的內存分配:

var requestPool = sync.Pool{

New: func() interface{} {

return &http.Request{

Header: make(http.Header),

}

},

}

// 從池獲取請求對象

func AcquireRequest() *http.Request {

req := requestPool.Get().(*http.Request)

// 重置必要字段

req.Method = ""

req.URL = nil

req.Body = nil

req.ContentLength = 0

req.Header.Reset()

return req

}

// 釋放請求對象到池

func ReleaseRequest(req *http.Request) {

requestPool.Put(req)

}

八、總結

HTTP請求看似簡單,但它連接着整個系統的"血管"。忽視超時和重試,就像在血管上留了個缺口——平時沒事,壓力一來就大出血。構建高可靠的網絡請求需要在超時控制、重試策略、冪等性保證和性能優化之間取得平衡。

記住,在分佈式系統中,超時和重試不是可選功能,而是生存必需。

擴展資源:

- Golang官方HTTP客户端文檔(https://pkg.go.dev/net/http)

- Netflix Hystrix超時設計模式(https://github.com/Netflix/Hystrix/wiki/Configuration)

往期回顧

1. RN與hawk碰撞的火花之C++異常捕獲|得物技術

2. 得物TiDB升級實踐

3. 得物管理類目配置線上化:從業務痛點到技術實現

4. 大模型如何革新搜索相關性?智能升級讓搜索更“懂你”|得物技術

5. RAG—Chunking策略實戰|得物技術

文 /梧

關注得物技術,每週更新技術乾貨

要是覺得文章對你有幫助的話,歡迎評論轉發點贊~

未經得物技術許可嚴禁轉載,否則依法追究法律責任。