今日上午,在小米2025小米人車家全生態合作伙伴大會上,Xiaomi MiMO大模型負責人羅福莉完成入職後的小米首秀,並正式發佈和開源最新MoE大模型MiMo-V2-Flash。

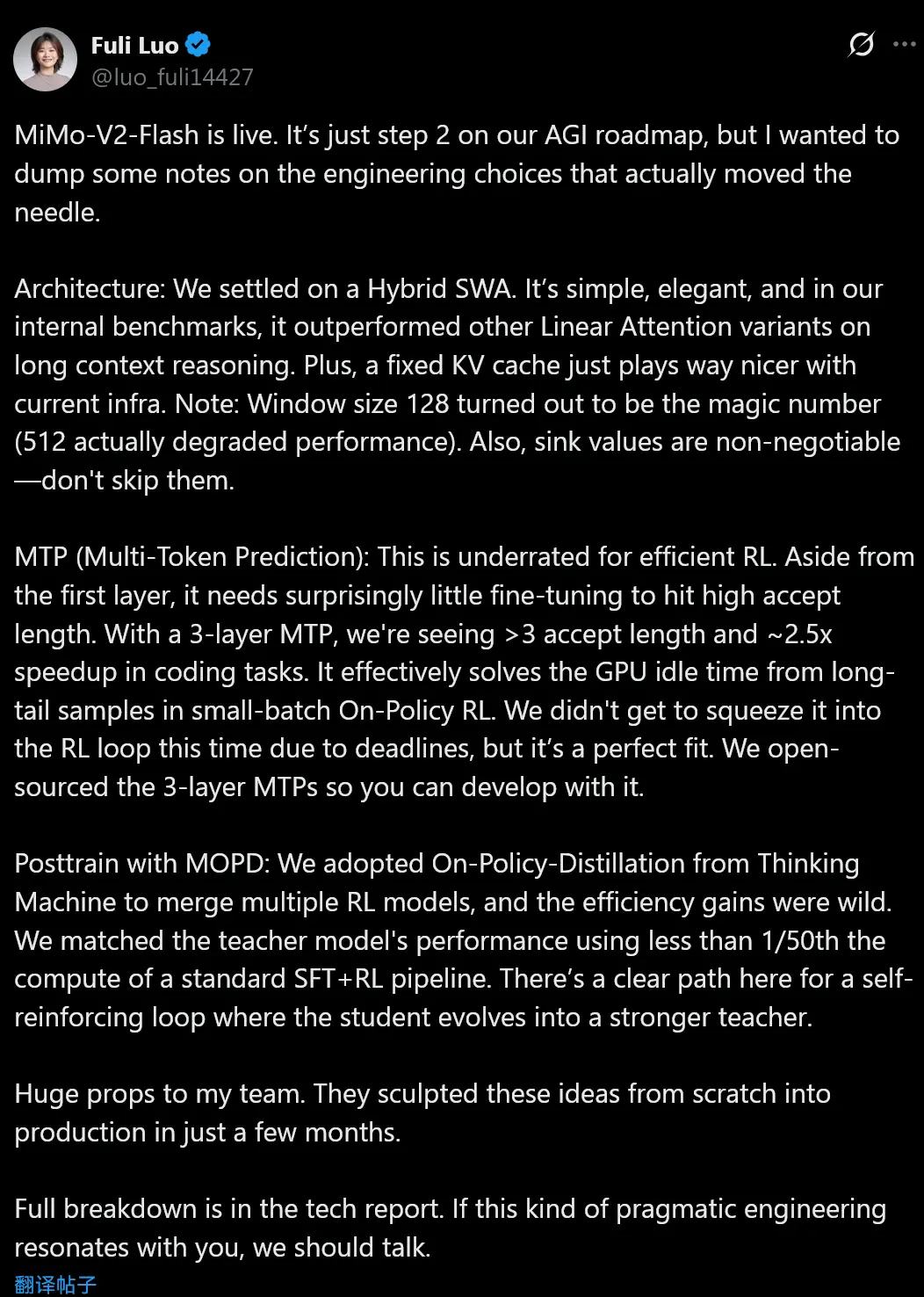

羅福莉同步在社交媒體發佈了對MiMo-V2-Flash的介紹:

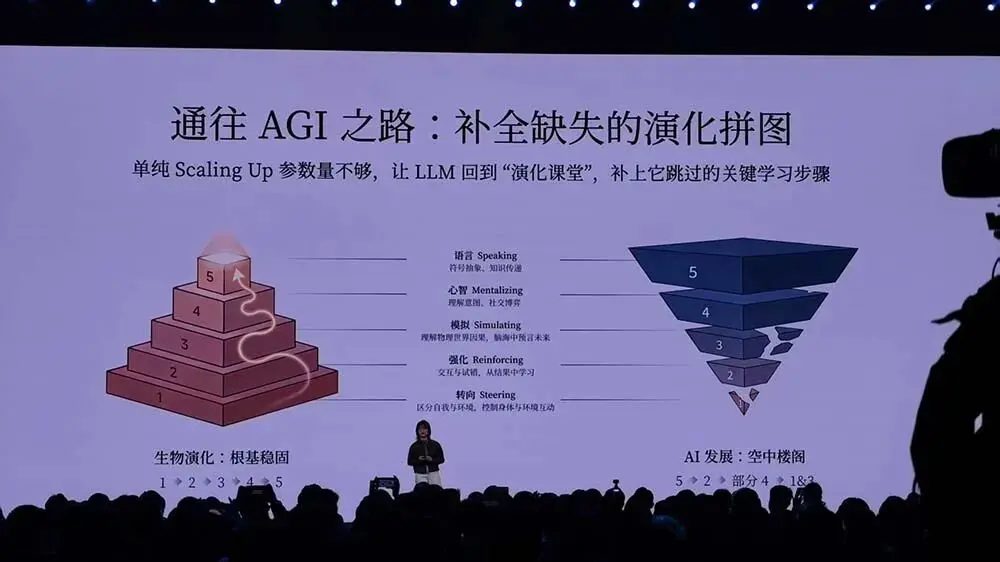

MiMo-V2-Flash 已正式上線。這只是我們 AGI 路線圖中的第二步,但我想把一些真正產生決定性效果的工程選擇隨手記下來。

架構:

我們最終採用了 Hybrid SWA。它足夠簡單、足夠優雅,而且在內部基準測試中,在長上下文推理上明顯優於其他線性注意力(Linear Attention)變體。另外,固定 KV cache 與現有基礎設施的兼容性要友好得多。

備註:窗口大小 128 是那個“甜點值”(512 反而會拉低性能);sink values 是不可妥協的,千萬別省略。

MTP(Multi-Token Prediction):

這一點在高效 RL 中被嚴重低估了。除了第一層以外,MTP 實際上只需要極少的微調,就能達到很高的 accept length。使用 3 層 MTP 時,我們在編程任務中看到了 accept length 大於 3,以及約 2.5 倍的速度提升。

它基本上解決了小 batch 的 On-Policy RL 中,由長尾樣本造成的 GPU 空轉問題。這次由於時間節點原因,我們沒能把它塞進 RL loop 裏,但它在這裏幾乎是天作之合。我們已經開源了 3-layer MTP,方便大家直接基於它進行開發。

使用 MOPD 的後訓練:

我們採用了 Thinking Machine 提出的 On-Policy Distillation,用來融合多個 RL 模型,效率提升非常誇張。在不到傳統 SFT + RL pipeline 的 1/50 計算量下,我們就達到了 teacher 模型的性能。

這裏已經能清晰看到一條路徑:學生模型不斷進化,最終反過來成為更強的教師模型,形成自我強化的閉環。

致謝:

向我的團隊致以最高敬意。他們在短短几個月內,把這些想法從零打磨到可上線的生產系統。

來源:https://weibo.com/2194035935/QiO8H8AOE