上海人工智能實驗室 OpenDataLab 團隊發佈 ScienceMetaBench 科學文獻元數據提取評測集,該基準旨在建立客觀、統一的評估標準,助力社區衡量與比較各類前沿方法的實際性能。

數據集地址:https://huggingface.co/datasets/opendatalab/ScienceMetaBench

評測工具代碼 (Dingo):https://github.com/MigoXLab/dingo

據介紹,ScienceMetaBench 是一個專注於評估科學文獻 PDF 元數據提取能力的評測集,涵蓋了學術論文 (Paper)、教科書 (Textbook) 與 電子書 (Ebook) 三類典型語料 。在構建過程中,研究團隊針對中英文雙語環境進行了深度適配,確保元信息的提取邏輯與正文語種保持一致。

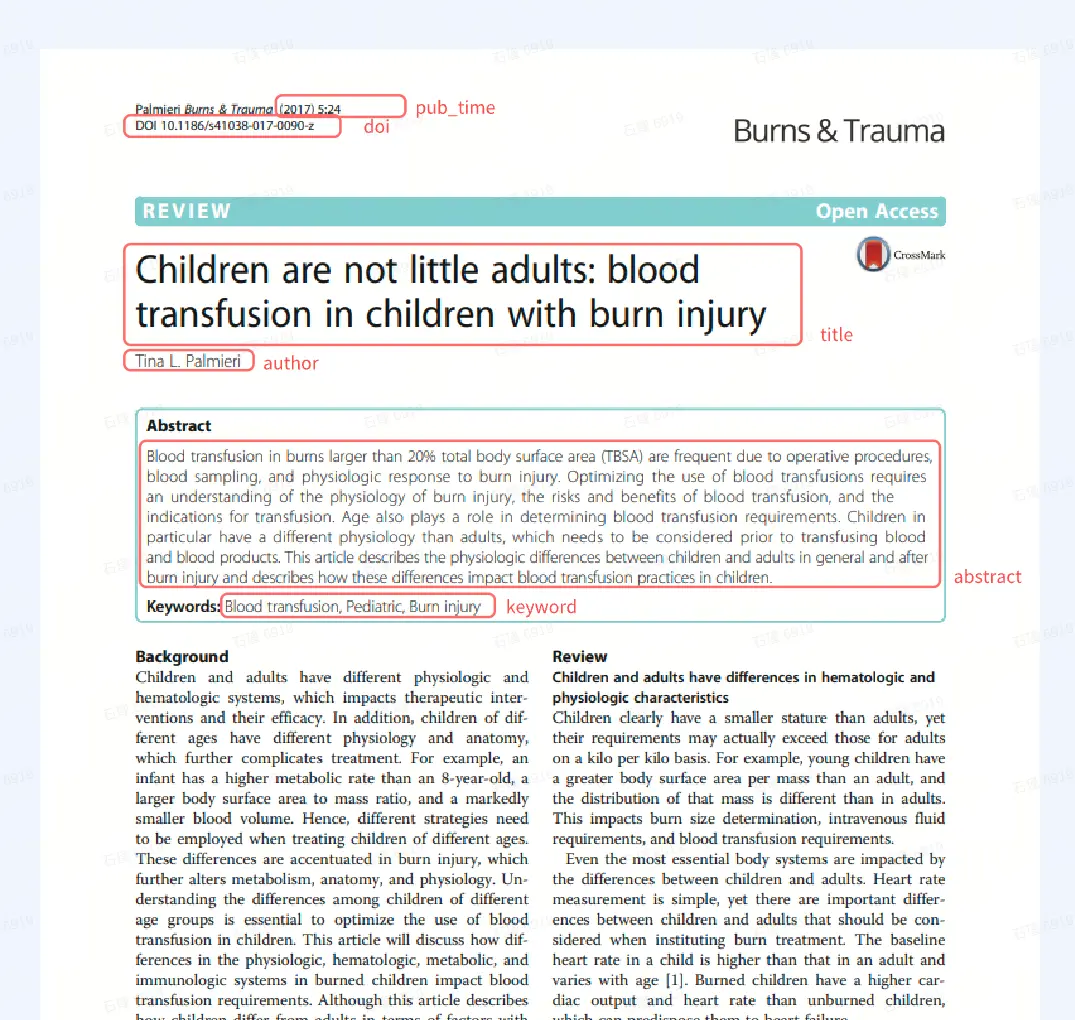

下圖展示了從學術論文 PDF 文件中提取的元數據字段示例:

需要從論文首頁提取以下關鍵信息:{

"sha256": "8d3e...f3a", // 文件唯一哈希,確保數據可追溯"doi": "10.1186/s41038-017-0090-z", // 唯一標識符"title": "Children are not little adults...", // 文獻標題"author": "Tina L. Palmieri, ...", // 作者姓名,統一用英文逗號分隔"keyword": "Blood transfusion, Pediatric", // 關鍵詞,統一用英文逗號分隔"abstract": "Blood transfusion in burns larger than...", // 摘要正文"pub_time": "2017" // 標準化後的出版年份}

為了提升樣本的代表性,團隊結合了多數據源採樣與 K-Means 圖像聚類技術,力求覆蓋更多元、複雜的排版樣式。在標註環節,團隊採用了“AI 預標註 + 人工修正”的高效模式,並參考了用於MinerU評測的OmniDocBench 權威評測基準,以確保數據質量與評測維度的專業性。