螞蟻集團旗下具身智能公司靈波科技正式開源具身大模型 LingBot-VLA。

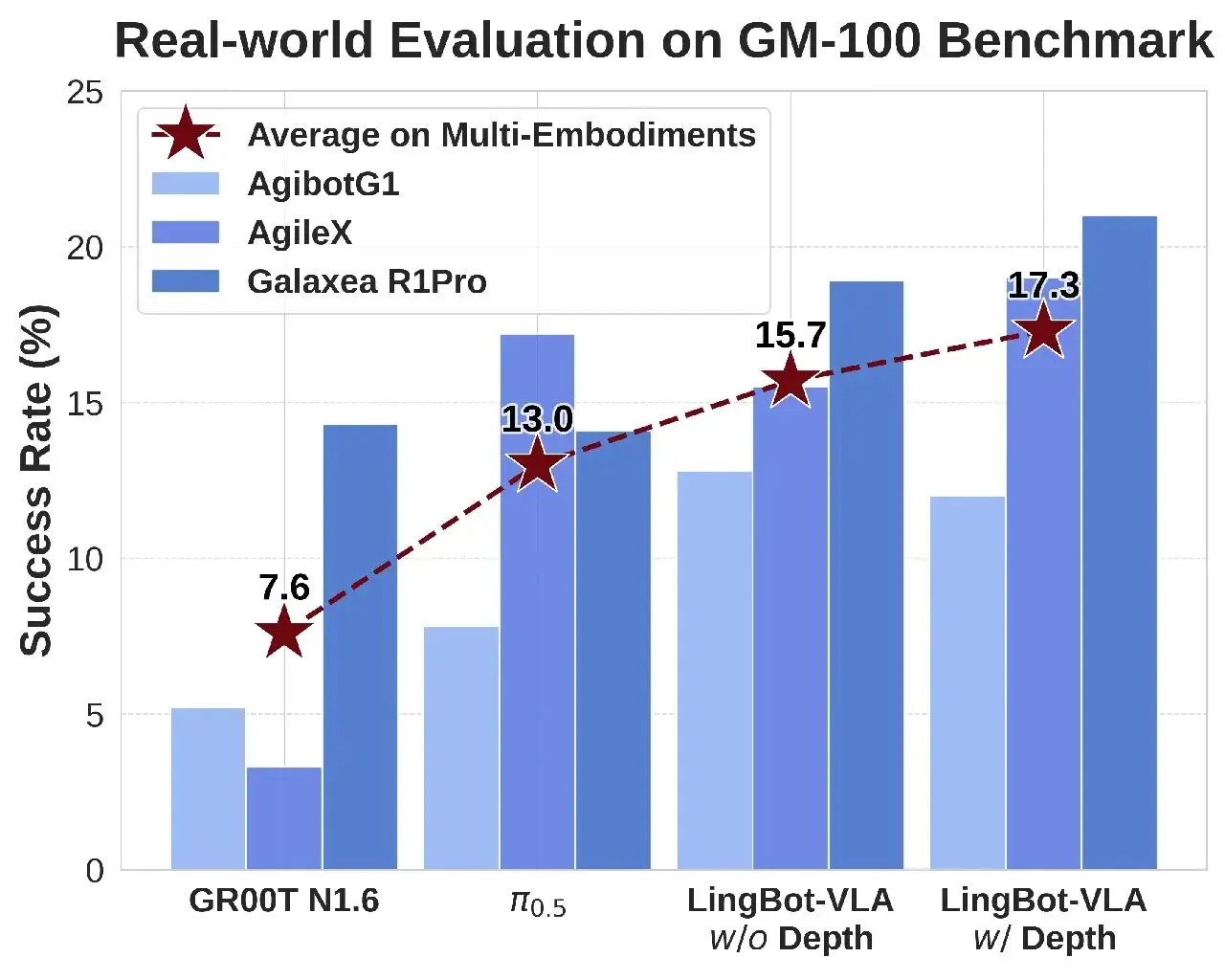

據介紹,在上海交通大學開源的具身評測基準 GM-100(包含 100 項真實操作任務)測試中,LingBot-VLA 在 3 個不同的真實機器人平台上,跨本體泛化平均成功率相較於 Pi0.5 的 13.0% 提升至 15.7%(w/o Depth)。引入深度信息(w/ Depth)後,空間感知能力增強,平均成功率進一步攀升至 17.3%,展現了 LingBot-VLA 強大的準確性和泛化性。

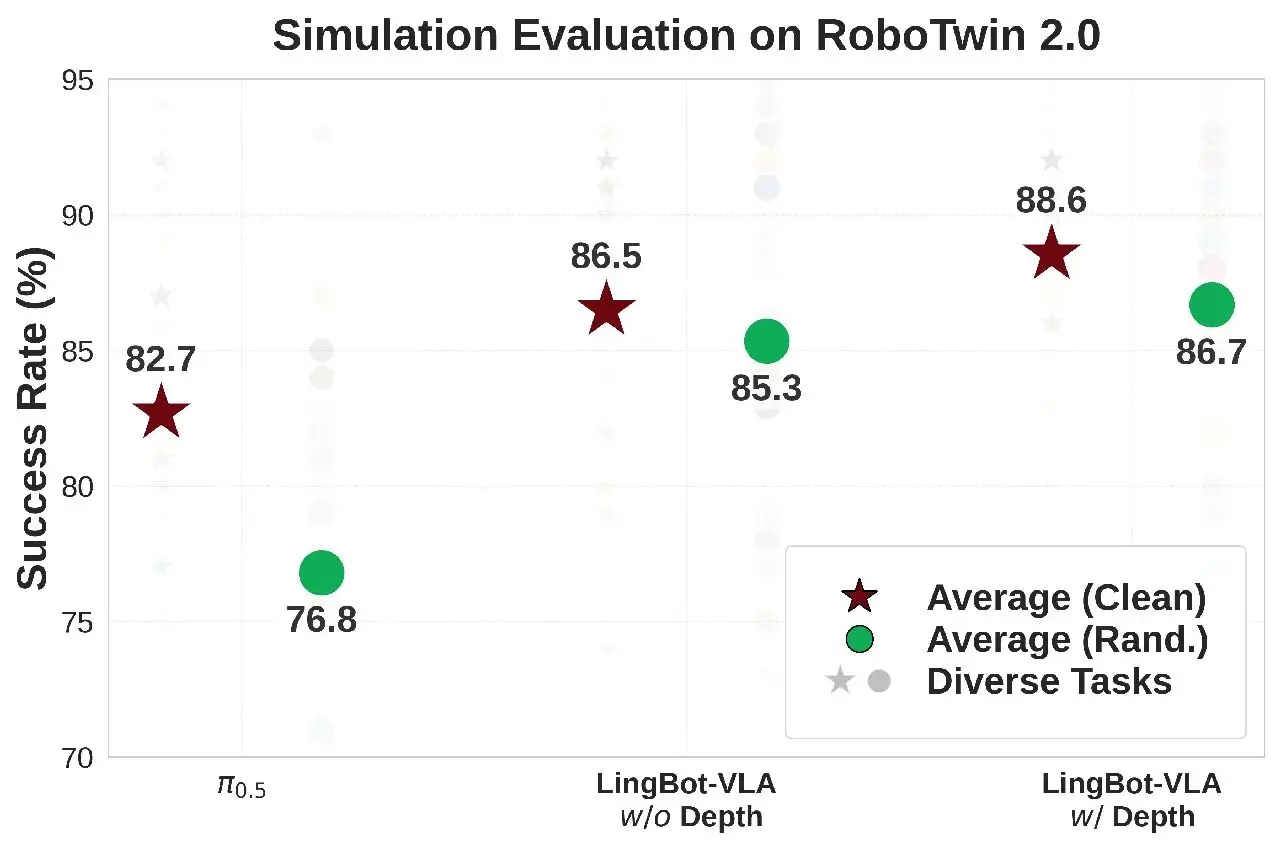

在 RoboTwin 2.0 仿真基準(包含50項任務)評測中,面對高強度的環境隨機化干擾(如光照、雜物、高度擾動),LingBot-VLA 憑藉獨特的可學習查詢對齊機制,高度融合深度信息,操作成功率比 Pi0.5 提升了 9.92%,實現了從虛擬仿真到真實落地的全方位性能領跑。

後訓練成本低、效率高、代碼全開源 真正實用的 VLA 模型

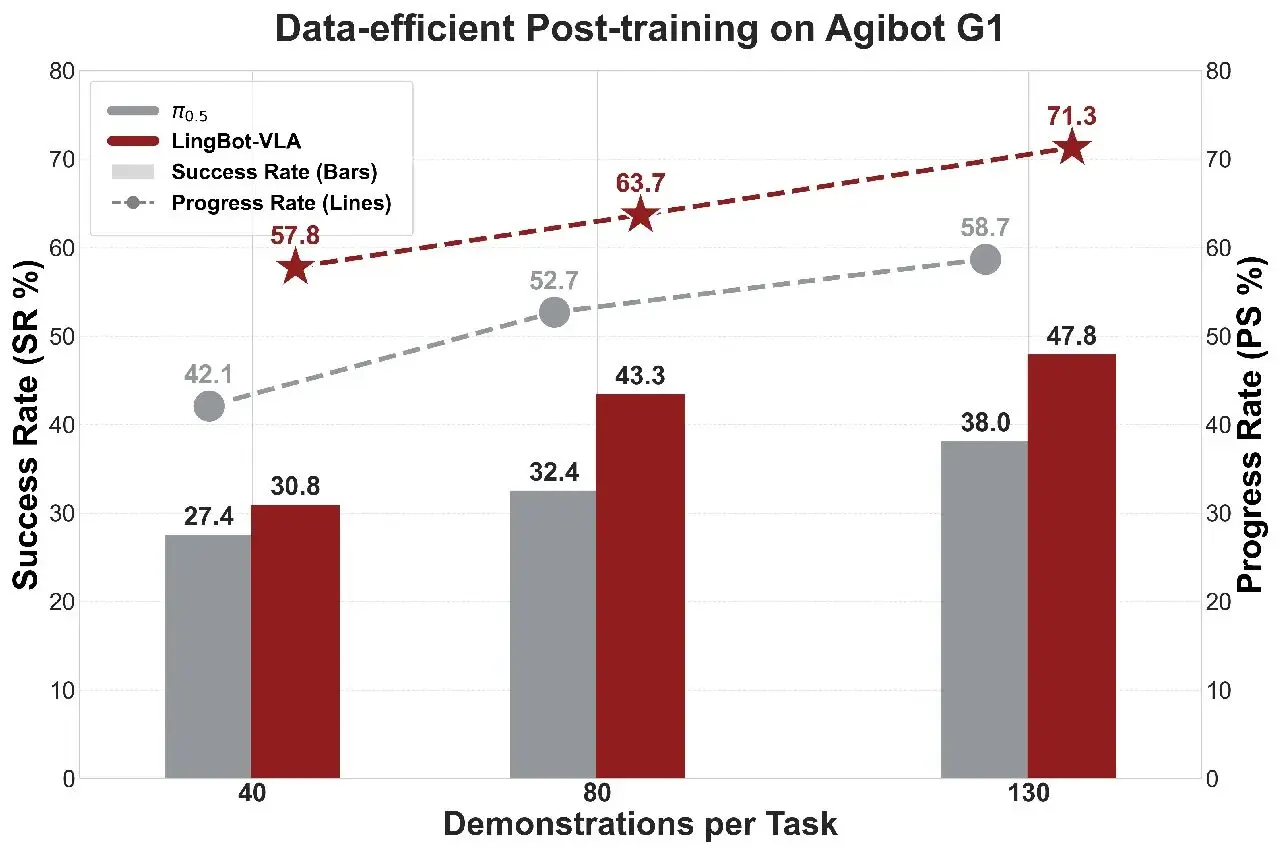

得益於涵蓋主流構型和詳盡任務的大規模預訓練,LingBot-VLA 具備強大的通用操控能力,並且能夠將其高效遷移到多樣的下游機器人任務中。

實驗表明,LingBot-VLA 在下游任務中能夠使用更少的數據,達到超越 π0.5 的性能;並且性能優勢會隨着數據量的增加而持續擴大。

LingBot-VLA 團隊還構建了一套高效的後訓練工具鏈,在 8 卡 GPU 配置下實現了單卡每秒 261 個樣本的吞吐量,其訓練效率達到 StarVLA、OpenPI 等主流框架的 1.5~2.8 倍,實現了數據與算力成本的雙重降低。

LingBot-VLA 此次開源提供了模型權重,並同步開放了包含數據處理、高效微調及自動化評估在內的全套代碼庫。

-

Website: https://technology.robbyant.com/lingbot-vla

-

Model:

https://huggingface.co/collections/robbyant/lingbot-vlahttps://www.modelscope.cn/collections/Robbyant/LingBot-VLA

-

Datasets: https://huggingface.co/datasets/robbyant/lingbot-GM-100

-

Code: https://github.com/Robbyant/lingbot-vla

-

Tech Report: https://arxiv.org/abs/2601.18692