美團 LongCat 團隊正式發佈並開源 LongCat-Image 模型,通過高性能模型架構設計、系統性的訓練策略和數據工程,以6B參數規模,成功在文生圖和圖像編輯的核心能力維度上逼近更大尺寸模型效果。

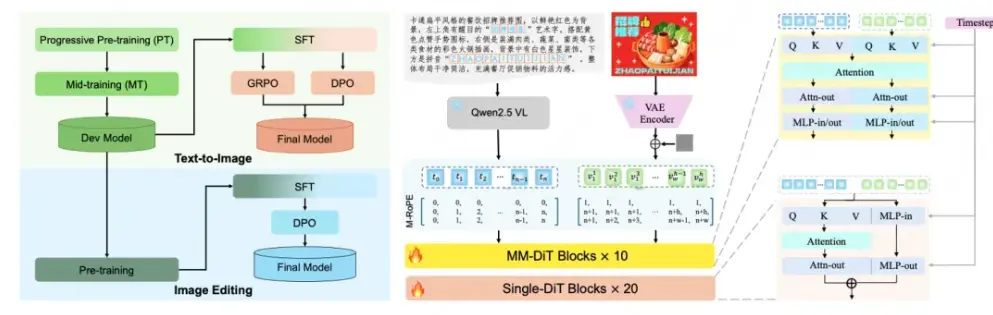

根據介紹,LongCat-Image 採用文生圖與圖像編輯同源的架構設計,並結合漸進式學習策略,在僅 6B 的緊湊參數規模下,實現了指令遵循精準度、生圖質量與文字渲染能力的高效協同提升。尤其在單圖編輯的可控性和文字生成的漢字覆蓋度方面獨具優勢。

LongCat-Image 在圖像編輯領域的多個重要基準測試中(如GEdit-Bench、ImgEdit-Bench)均達到開源SOTA水平,實現性能突破的背後在於一套緊密協同的訓練範式和數據策略。為有效繼承文生圖模型的知識和美感,同時避免文生圖後訓練階段收窄的狀態空間對編輯指令多樣性的限制,基於文生圖Mid-training階段模型進行初始化,並採用指令編輯與文生圖多任務聯合學習機制,深化對複雜多樣化指令的理解。此外通過預訓練階段的多源數據及指令改寫策略,以及SFT階段引入人工精標數據,最終實現了指令遵循精準度、泛化性和編輯前後視覺一致性的共同提升。

針對中文文本渲染這一行業痛點,LongCat-Image 通過課程學習策略來提升字符覆蓋度和渲染精準度:預訓練階段基於千萬量級合成數據學習字形,覆蓋通用規範漢字表的8105個漢字;SFT 階段引入真實世界文本圖像數據,提升在字體、排版佈局上的泛化能力;RL 階段融入 OCR 與美學雙獎勵模型,進一步提升文本準確性與背景融合自然度。此外通過對 prompt 中指定渲染的文本採用字符級編碼,大幅降低模型記憶負擔,實現文字生成學習效率的跨越式提升。通過該項能力加持,有效支持海報設計、商業廣告作圖場景中複雜筆畫結構漢字的渲染,以及古詩詞插圖、對聯、門店招牌、文字Logo等設計場景的生僻字渲染。

此外,LongCat-Image通過系統性的數據篩選與對抗訓練框架,實現了出圖紋理細節和真實感的提升。預訓練和中期訓練階段嚴格過濾AIGC數據,避免陷入“塑料感”紋理的局部最優;在SFT階段,所有數據均經過人工精篩來對齊大眾審美;在RL階段,創新性地引入AIGC內容檢測器作為獎勵模型,利用其對抗信號逆向引導模型學習真實世界的物理紋理、光影和質感。

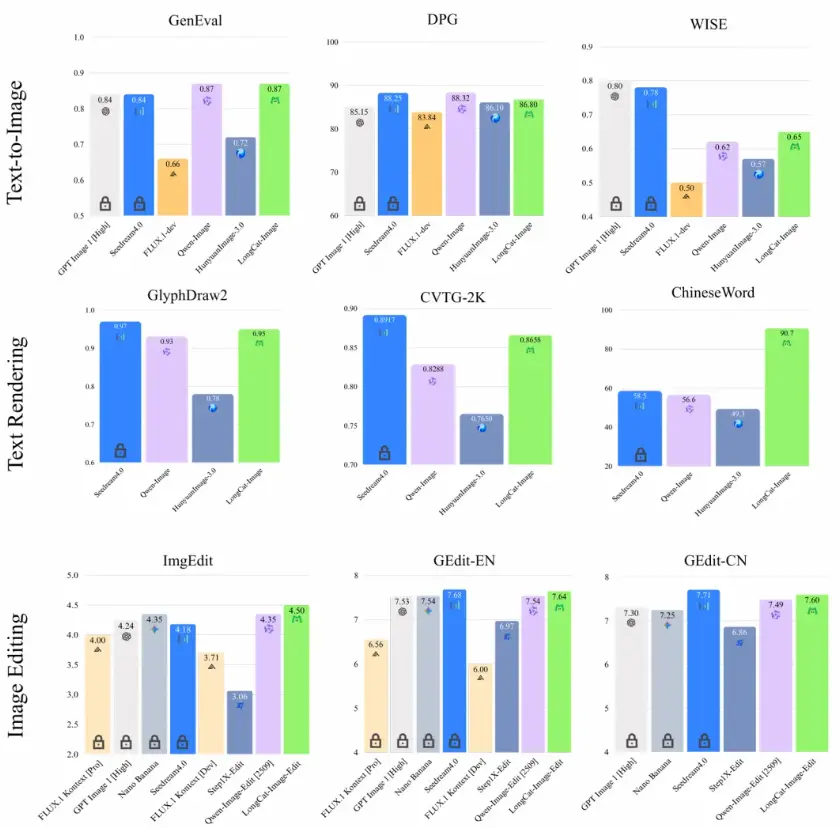

基準測評結果表明,在圖像編輯任務中,ImgEdit-Bench(4.50分)、 GEdit-Bench 中英文得分(7.60/7.64分)均達到開源SOTA水平,且逼近頭部閉源模型水平;在文字渲染方面,ChineseWord 評測以 90.7 分的成績大幅領先所有參評模型,實現常用字、生僻字的全量精準覆蓋;文生圖任務上,GenEval 0.87 分、DPG-Bench 86.8 分的表現,使其在生圖基礎能力上相比頭部開源與閉源模型依然具備強競爭力。

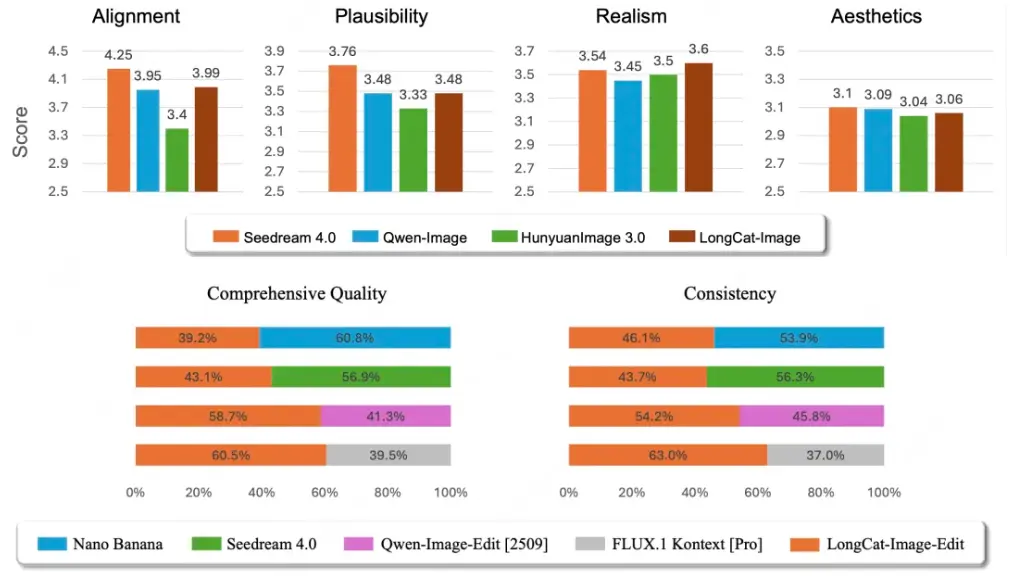

在文生圖方面採用大規模的人工主觀評分(MOS)方法,核心覆蓋 文本-圖像對齊、視覺合理度、視覺真實度、美學質量4個維度,LongCat-Image 的真實度相比主流開閉源模型表現出色,同時在文本-圖像對齊與合理度上達到開源SOTA水平。

在圖像編輯方面採用嚴格的並列對比評估(Side-by-Side, SBS)方法,聚焦於綜合編輯質量、視覺一致性這兩個用户體驗的維度,評測結果表明,LongCat-Image 雖然與 Nano Banana、Seedream 4.0 等商業模型存在一定差距,但顯著超越了其他開源方案。