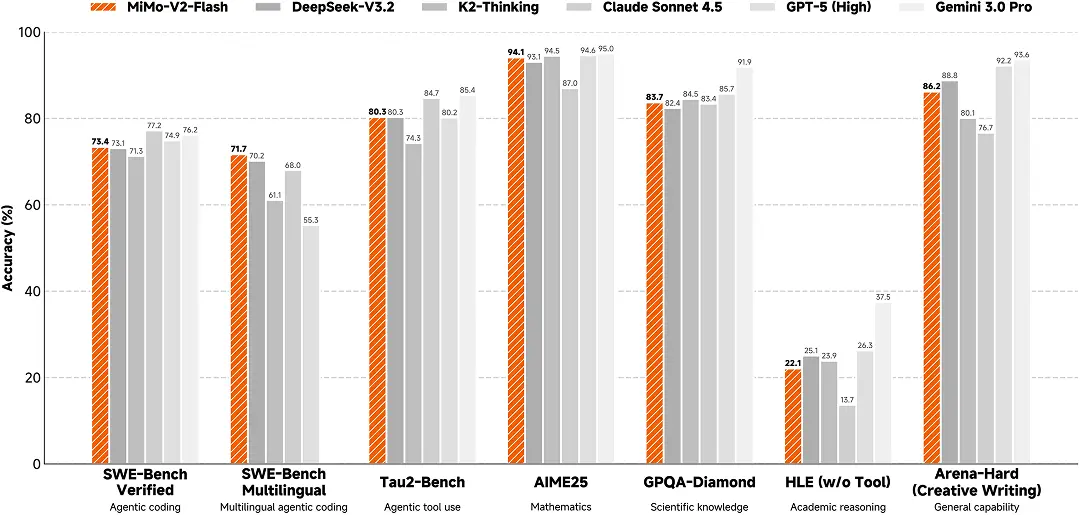

小米正式宣佈開源 Xiaomi MiMo-V2-Flash,這是小米專為極致推理效率自研的總參數 309B(激活15B)的 MoE 模型,通過引入 Hybrid 注意力架構創新及多層 MTP 推理加速,在多個 Agent 測評基準上進入全球開源模型 Top 2;代碼能力超過所有開源模型,比肩標杆閉源模型 Claude 4.5 Sonnet,但推理價格僅為其 2.5% 且生成速度提升至 2 倍,成功將大模型效果和推理效率推向極致。

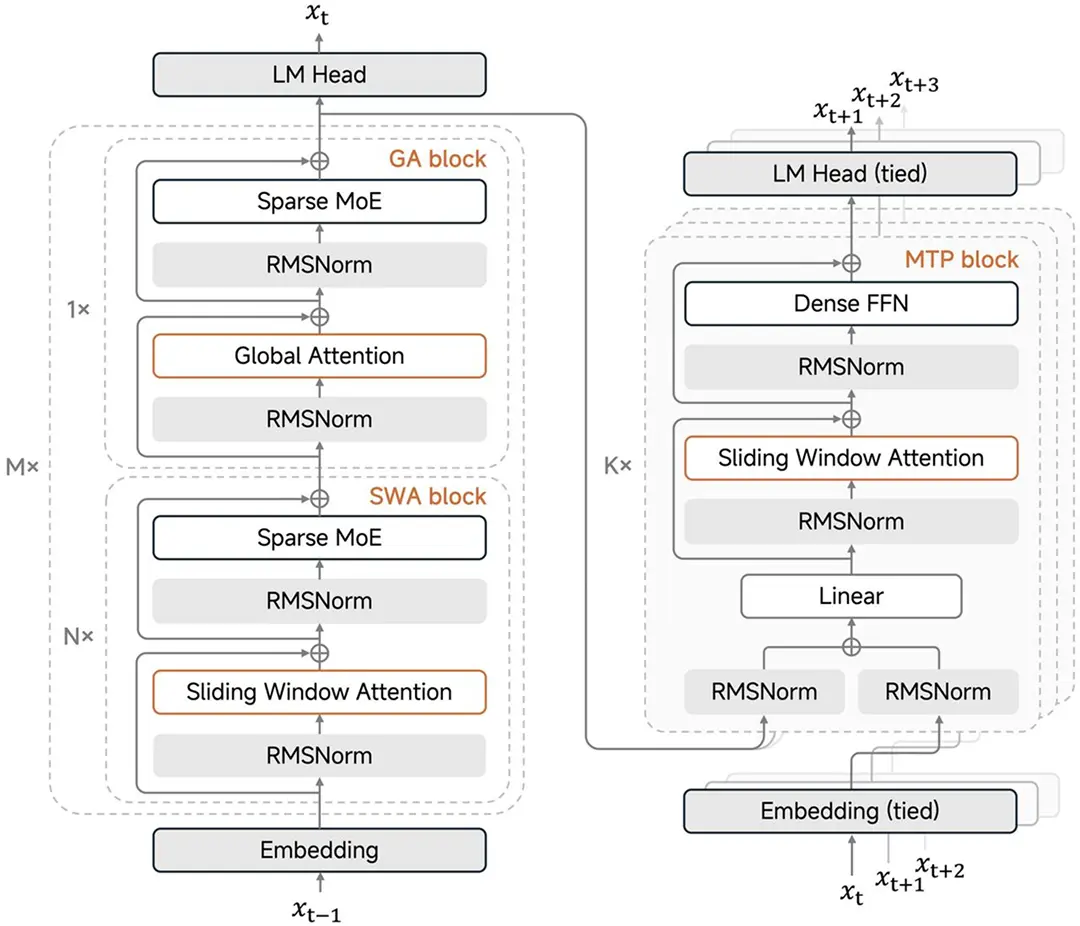

MiMo-V2-Flash 模型架構如下:

MiMo-V2-Flash 模型結構要點:

- 混合注意力

採用 5:1 的 Sliding Window Attention (SWA) 與 Global Attention(GA)混合結構,128 窗口大小,原生 32K 外擴 256K 訓練。經前期大量實驗發現,SWA 簡單、高效、易用,展現了比主流 Linear Attention 綜合更佳的通用、長文和推理能力,並提供了固定大小的 KV Cache 從而極易適配現有訓練和推理 Infra 框架。

- MTP推理加速

引入 MTP (Multi-Token Prediction) 訓練提升基座能力的同時,在推理階段通過並行驗證 MTP Token,打破了傳統 Decoding 在大 Batch 下的顯存帶寬瓶頸,實測在 3 層 MTP 情況下可實現 2.8~3.6 的接收長度和 2.0~2.6 的實際加速比。

整體而言,得益於模型結構與訓推 Infra 的深度融合與創新,MiMo-V2-Flash 可以在不同的硬件上通過調優 Batch Size 和 MTP 層數來最大化釋放 GPU 算力,從而展現出更高的吞吐,並維持優秀的低時延以及極致推理性能。

Xiaomi MiMo-V2-Flash 模型權重和推理代碼均全面開源。API 限時免費,體驗 Web Demo 已上線。

訪問 platform.xiaomimimo.com,可以一鍵兼容 Claude Code、Cursor、Cline、Kilo Code 等框架。

即刻登錄 MiMo Studio Web:aistudio.xiaomimimo.com,免費體驗模型。