螞蟻技術研究院宣佈推出 LLaDA2.0 系列離散擴散大語言模型(dLLM),並同步公開了背後的技術報告,宣稱是“業內首個 100B 擴散語言模型”。

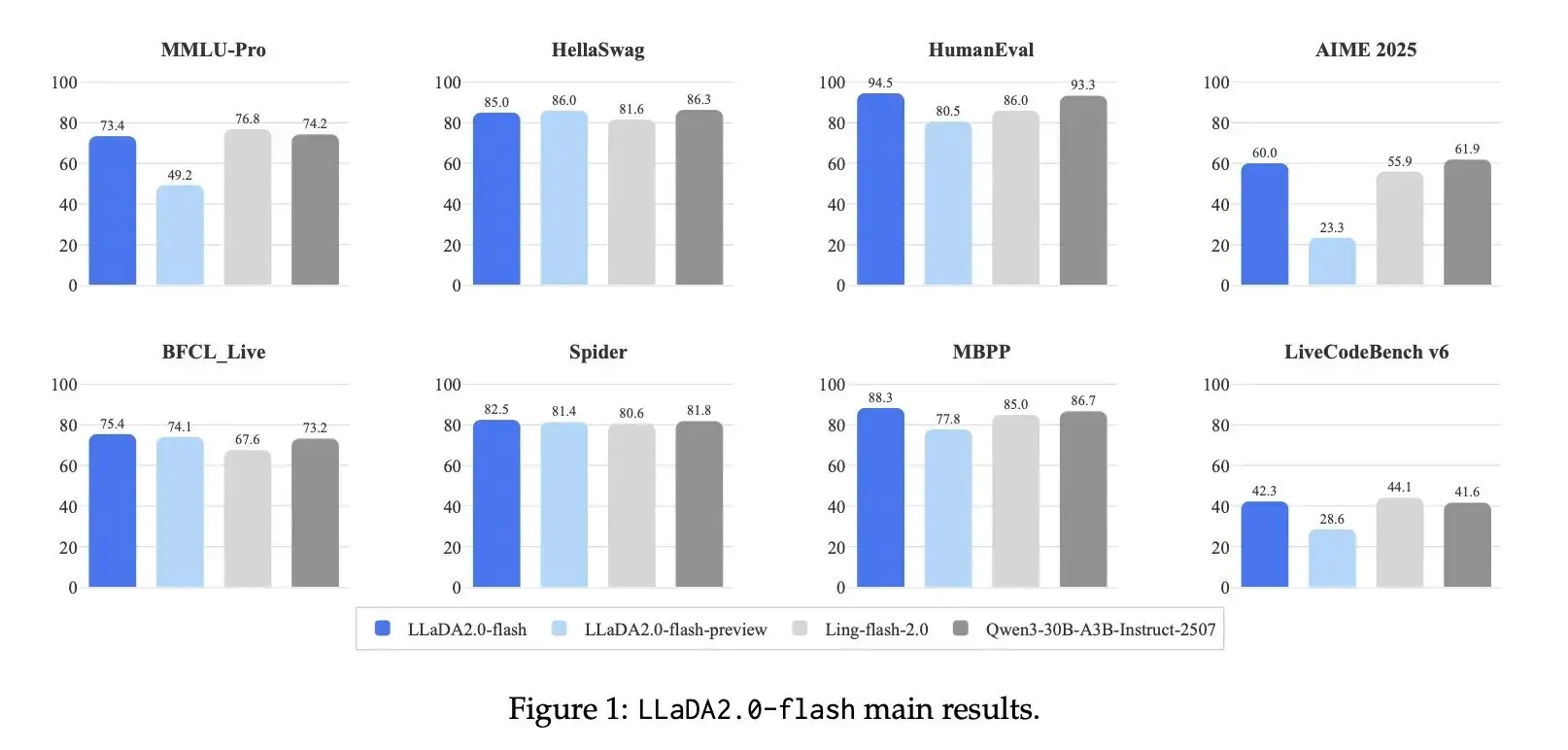

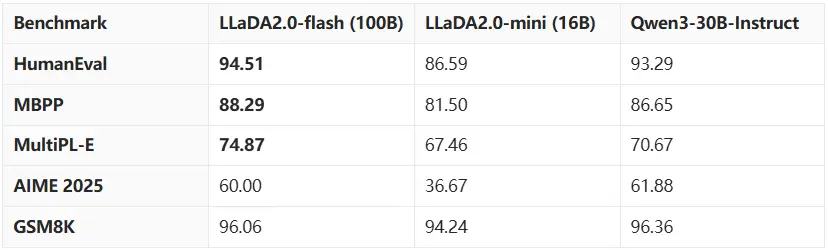

LLaDA2.0 包含 MoE 架構的 16B (mini) 和 100B (flash) 兩個版本,將 Diffusion 模型的參數規模首次擴展到了 100B 量級。據介紹,此次發佈的模型不僅打破了擴散模型難以擴展的固有印象,更在代碼、數學和智能體任務上展現出了超越同級自迴歸(AR)模型的性能。

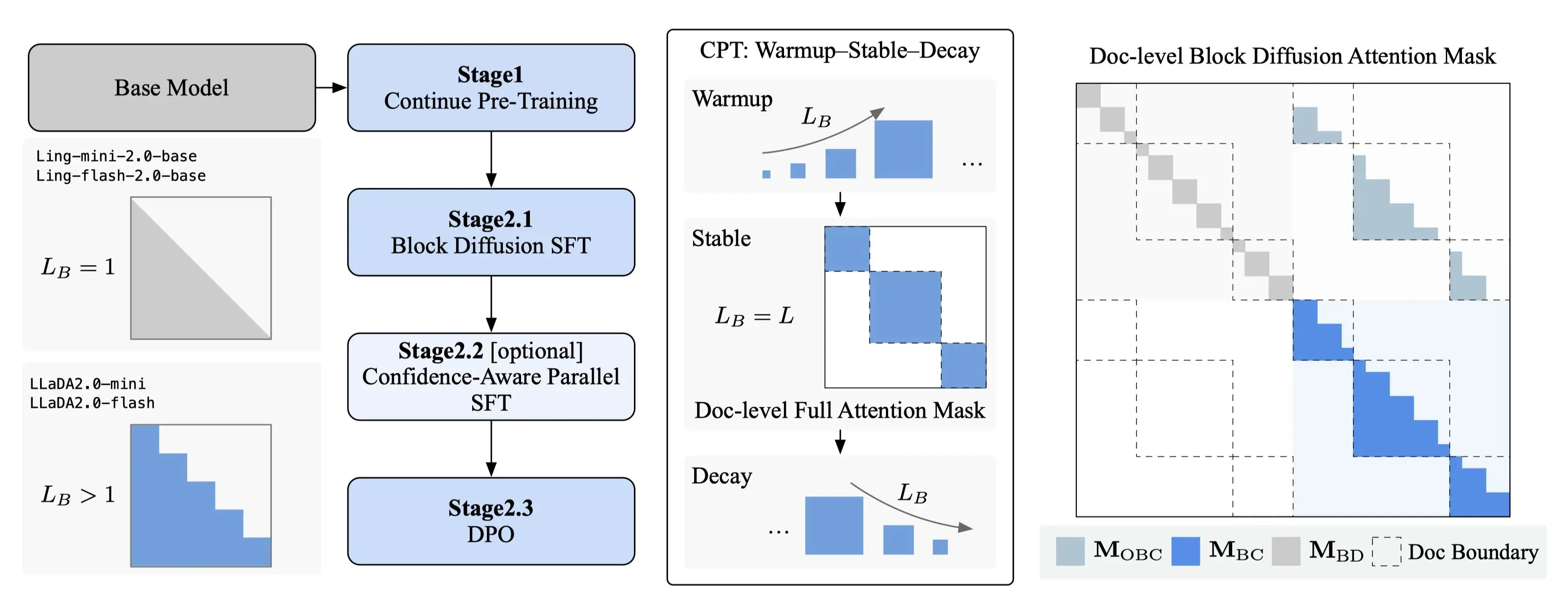

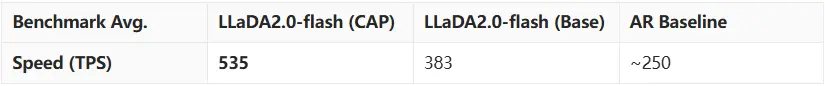

通過創新的 Warmup-Stable-Decay(WSD)持續預訓練策略,LLaDA2.0 能夠無縫繼承現有 AR 模型的知識,避免了從頭訓練的高昂成本。結合不僅限於常規 SFT 的 置信度感知並行訓練(CAP)和 擴散模型版 DPO,LLaDA2.0 在保證生成質量的同時,利用擴散模型的並行解碼優勢,實現了相比 AR 模型 2.1 倍的推理加速,證明了在超大規模參數下,擴散模型不僅可行,而且更強、更快。

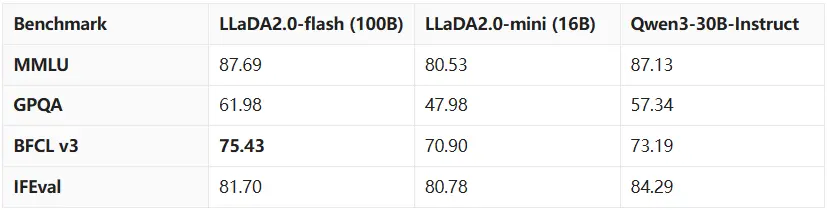

螞蟻技術研究院在知識理解、數學、代碼、推理 & 智能體等多個維度對模型進行了評估。結果顯示,LLaDA2.0 在結構化生成任務(如代碼)上具有顯著優勢,並在其他領域與開源 AR 模型持平。

LLaDA2.0 的模型權重(16B/100B)及相關訓練代碼均已開源:

https://huggingface.co/collections/inclusionAI/llada-20

https://github.com/inclusionAI/LLaDA2.0