英偉達研究團隊近日正式發佈了名為 PersonaPlex-7B-v1 的全雙工語音對語音對話模型。打破傳統 AI 語音助手“聽一句、回一句”的呆板模式,旨在實現更接近真人的自然對話體驗。

與過去需要通過 ASR(語音轉文本)、LLM(大語言模型)、TTS(文本轉語音)多個環節串聯的架構不同,PersonaPlex採用了一個單一的 Transformer 架構,直接完成語音理解與生成的全過程。

這種“端到端”的設計極大降低了響應延遲,並賦予了 AI 處理自然中斷、語音重疊以及即時反饋的能力。簡單來説,就像真人聊天一樣,AI 在説話的同時也在持續傾聽,即便用户突然打斷,它也能迅速做出反應。

此外,通過“語音+文本”的雙重引導,用户不僅能定義 AI 的角色背景,還能精確控制其音色和語調。

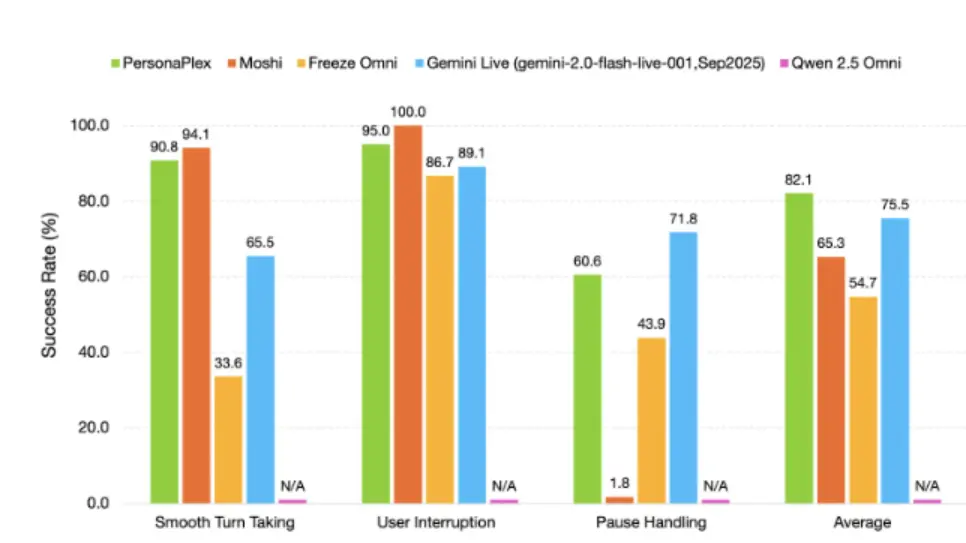

英偉達在訓練中結合了海量真實通話數據與合成場景,使模型既具備自然的語言習慣,又能嚴格遵守特定行業的業務規則。目前的評估結果顯示,PersonaPlex-7B-v1在對話流暢度和任務達成率上均優於多數開源及閉源系統。