阿里巴巴通義Qwen團隊發佈了最新的開源 QwenLong-L1.5 模型 ,主打超長上下文推理和記憶管理能力,構建於 Qwen3-30B-A3B-Thinking 模型之上,並增強記憶機制以處理超出其物理上下文窗口(256K)的任務。

QwenLong-L1.5三項核心創新:

1. 數據合成管線:開發了新的合成流程,專注於創建需要多跳溯源和全局分佈式證據推理的挑戰性任務,而非簡單的“大海撈針”任務。

2. 強化學習策略:引入了任務平衡採樣(Task-balanced sampling)和自適應熵控策略優化(AEPO)等 RL 策略,以穩定長上下文訓練。

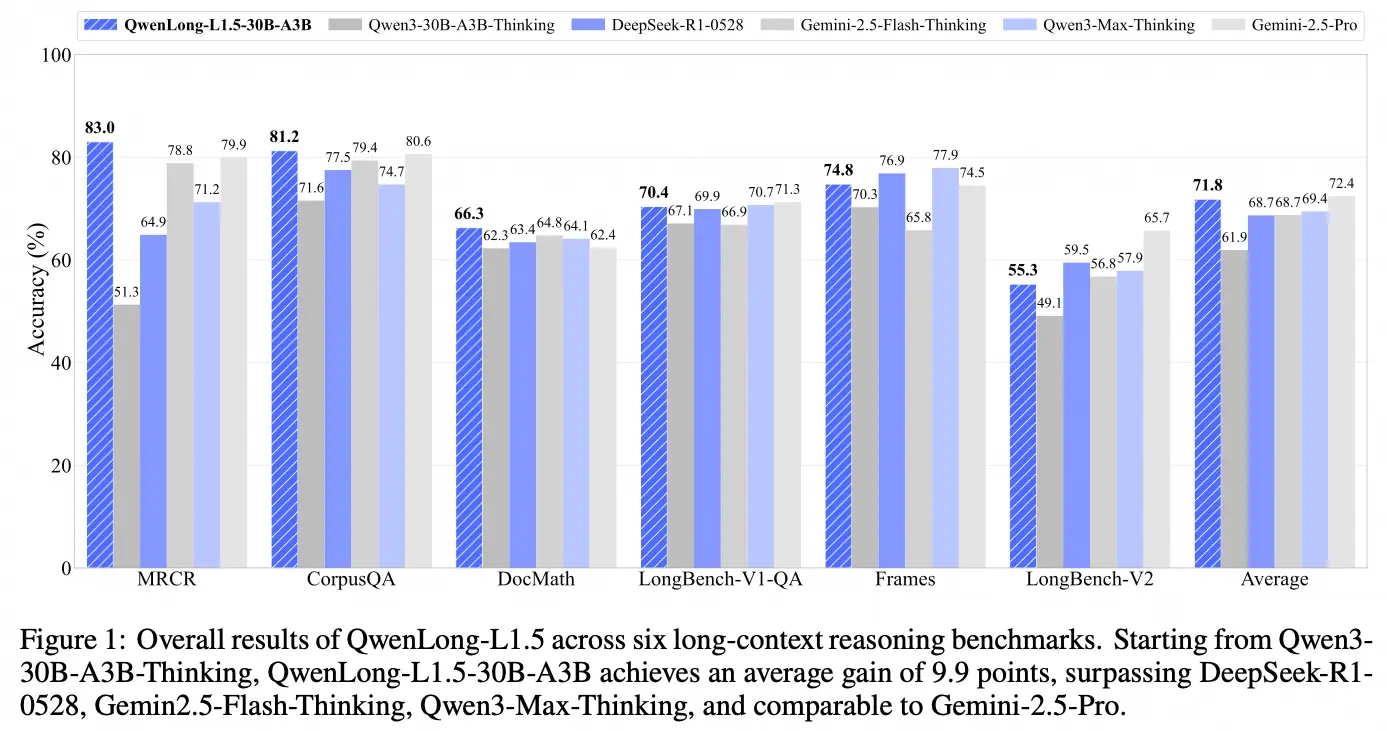

3. 記憶管理框架:透過多階段融合強化學習,在單次推理256 K 上下文窗口外,結合記憶更新機制處理更長任務在領先的長上下文基準測試中,QwenLong-L1.5 比其基線模型 Qwen3-30B-A3B-Thinking 平均高出 9.9 分,性能可與 GPT-5 和 Gemini-2.5-Pro 等頂級模型媲美。

開源地址:https://github.com/Tongyi-Zhiwen/Qwen-Doc/tree/main/QwenLong-L1.5