英偉達發佈了一份面向初學者的 LLM 微調指南,詳細介紹瞭如何在從 GeForce RTX 筆記本到 DGX Spark 在內的多種硬件上使用開源框架 Unsloth。該指南涵蓋了參數高效微調、全微調與強化學習等方法,並闡述了各自的適用場景、所需數據量及 VRAM 要求。

Unsloth 是一個針對 LLM 微調優化的開源框架,專為 NVIDIA GPU 架構打造,可顯著提升原本基於 Hugging Face Transformers 的訓練速度和資源效率。據官方介紹,在 RTX GPU 平台上,Unsloth 可使訓練性能提升約 2.5×,同時顯存佔用更低,讓普通開發者也能在本地機器上完成模型定製。

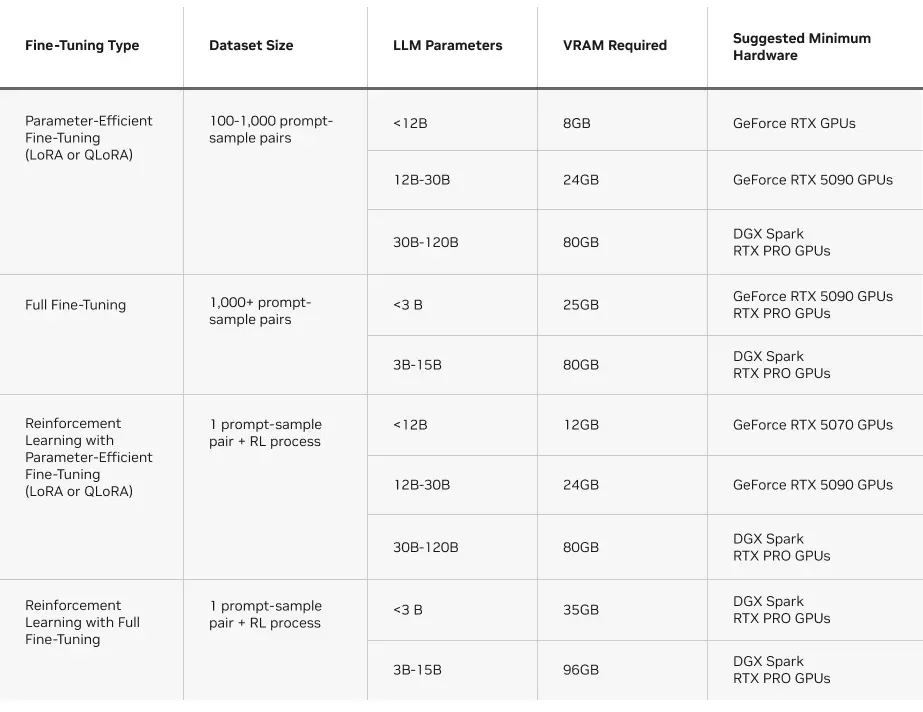

Unsloth 支持三種主流微調方式:

-

參數高效微調(如 LoRA / QLoRA):僅調整模型少量參數,訓練成本低,適合添加領域知識或改善特定能力。

-

完整微調:更新所有參數,適合高精度 AI 機器人或需嚴格行為規則的模型。

-

強化學習微調:藉助反饋機制優化行為策略,用於自主智能體等複雜場景。

這一多樣化支持,使開發者可以根據數據規模與任務需求靈活選擇微調方法。

詳情查看:https://blogs.nvidia.com/blog/rtx-ai-garage-fine-tuning-unsloth-dgx-spark/