OpenAI 發佈技術文章系統拆解了其編程 Agent 產品 Codex CLI 背後的 “Agent loop” 核心機制,展示了 LLM Agent 如何在軟件開發任務中高效協作與自我迭代。

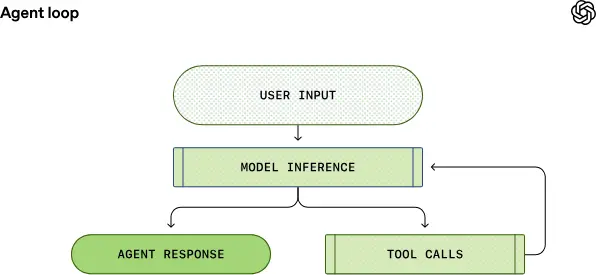

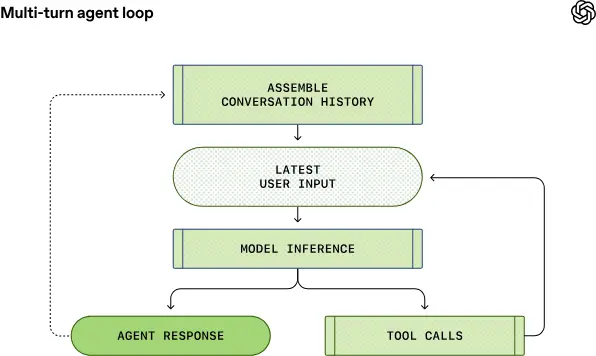

“Agent loop”是 Codex 在處理用户指令時的核心執行流程:從接收用户輸入開始,Codex 不僅讓大模型進行推理,還引導模型反覆調用工具、執行動作、觀察輸出,並最終生成準確回覆(或代碼更改)。這一循環持續進行,直到模型返回最終結果。

關鍵步驟包括:

- 構建 Prompt(提示詞):將用户輸入和上下文信息打包成用於模型推理的指令集。

- 模型推理(Inference):將 Prompt 轉換為 token 並送入模型生成輸出。

- 工具調用:模型可能發出工具請求,如執行 shell 命令或訪問文件系統,Agent 執行後將結果反饋給模型。

- 重複循環:根據新信息重組 Prompt,再次請求模型,直到輸出終結信息交付用户。

相比傳統單向對話系統,這種循環整合了推理+動作執行+反饋整合,使得 Codex 能夠自主完成更復雜的編程任務,而不僅僅是生成文本回復。

面向 Responses API 的構建方式

Codex CLI 藉助 Responses API 與 LLM 通信,其支持多種部署環境:

- 使用 ChatGPT 登錄:通過 ChatGPT 後端 API 接入。

- API key 認證:調用標準 OpenAI Responses API。

- 本地 open-source 模型:支持如 ollama、LM Studio 的本地服務。

這種可配置性讓開發者可以在本地部署、雲端託管或混合架構中運行 Codex,實現更靈活的開發集成。

Prompt 構建細節與角色分層

OpenAI 詳細解釋了 Prompt 的組成與權重機制:

- system / developer / user / assistant 角色區分不同來源與優先級的信息。

- 系統自動注入權限、安全沙箱規範、開發者指令等多層內容。

- 環境信息(如當前工作目錄、shell 類型)也被編碼進 Prompt。

這些細節有助於精細控制 Agent 行為、規範權限邊界,並提升模型調用的可靠性。

性能與上下文管理

隨着對話或任務執行的循環次數增長,Prompt 會不斷膨脹。OpenAI 指出:

- Prompt 緩存能顯著提升性能,但僅在完全前綴匹配時生效。

- 為避免上下文窗口耗盡,Codex 會自動調用新的 Responses API 壓縮上下文(compaction),用摘要表示早期對話內容以節省 token。

這些策略對於長期工程任務(如複雜代碼編輯、多輪推理)至關重要。

完整內容查看原文:https://openai.com/index/unrolling-the-codex-agent-loop/