騰訊雲聯合小紅書Hilab Infra團隊,在SGLang 中實現了DeepSeek量化模型的高效推理優化,並在HuggingFace中發佈了DeepSeek-V3.1-Terminus的量化模型。

量化方案介紹

當前主流的大語言模型普遍採用MoE架構,這種架構可以在減少訓推成本的同時提升模型性能,與此同時,模型體積也變得越來越大。比如,DeepSeek系列為671B,Kimi K2達到了 1TB,而當前主流的GPU單卡顯存只有 80GB/96GB,通常需要雙機分佈式部署。

模型量化是提升推理效率、降低推理成本的主流方式,它是指在保持模型精度儘量不變的前提下,將模型使用的**高精度數值(如 FP32/BF16 浮點數)轉換為低精度數值(如 FP8、INT8、INT4 甚至更低比特)**的過程,從而減少了大模型內存佔用、提升了推理性能。

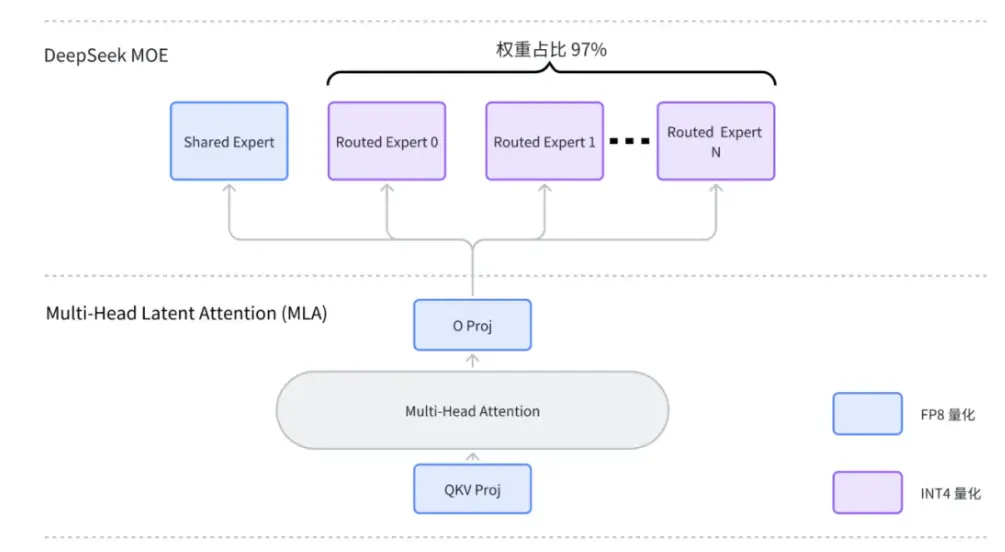

當前針對MoE模型,社區普遍使用W4AFP8 混合量化方案,這種量化方案的特點在於:

-

對權重(Weight)採用 INT4 量化,對激活(Activation)採用 FP8 動態量化;

-

只對普通專家權重使用INT4量化,而對其他線性層保留DeepSeek原生的FP8量化方式;

這樣做的好處在於,普通路由專家權重佔整個模型體積的 97% ,只對普通路由專家權重做 4-bit量化,可以在降低一半模型體積的同時,儘可能減小模型運行時精度損失,並且提升了權重讀寫帶寬,進而加快了推理速度。

W4AFP8混合量化方案

通過上述W4AFP8混合量化方案,可以將DeepSeek系列模型大小從689GB減小到 367GB,從而可以實現單機八卡部署,推理成本降低 50%。為了實現這種量化模型的高效推理,項目團隊在SGLang中實現了一種優化的推理方案,並貢獻給了開源社區。

推理框架優化

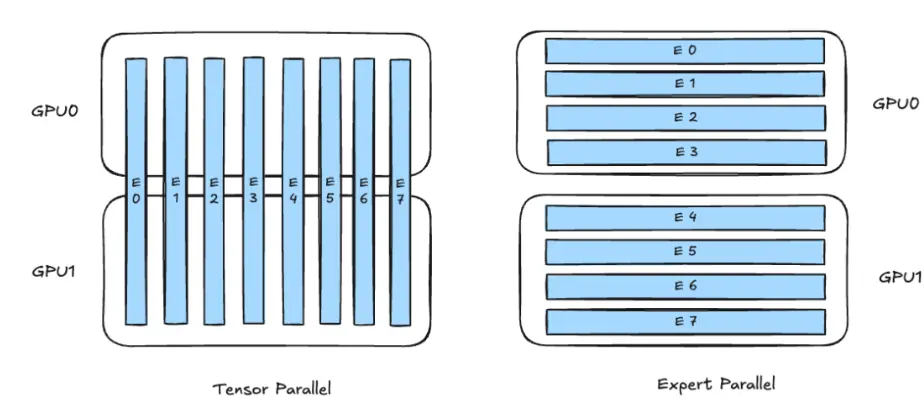

大模型中的MoE模塊推理時一般有兩種並行策略:TP並行(Tensor Parallel)和 EP並行(Expert Parallel),如下圖所示。 EP並行時,每個 GPU 負責一部分專家(Experts),不同 GPU 上的專家各不相同,而TP並行是將單個專家(例如 MLP 的權重矩陣)在多 GPU 之間做切分,共同計算。

TP並行和EP並行的權重劃分對比示意圖

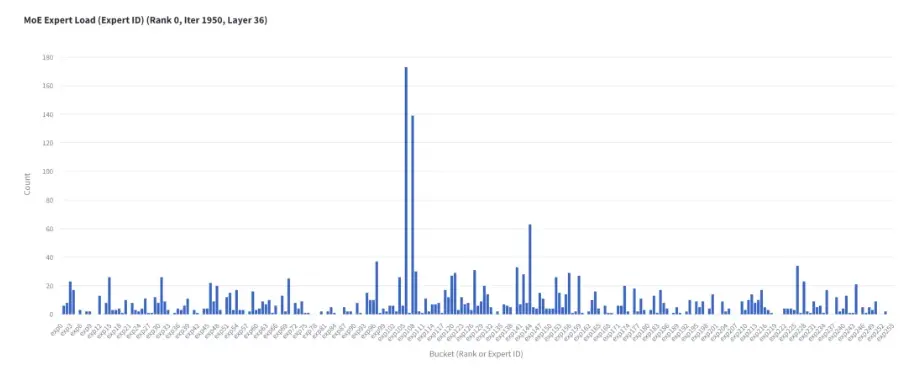

SGLang中最初針對W4AFP8模型的推理方案是EP並行。EP並行的好處是在並行度比較大的時候,整體通信效率更高,但是在單機八卡時通信效率跟TP沒有差異;另外,EP並行在併發比較小時還有負載不均衡的問題,熱點 Expert所在的GPU卡會拖慢整體計算速度,如下圖。

不同專家被激活的token數量(圖片源於NVIDIA公眾號)

TP並行時,所有GPU卡計算量一致,整體計算時間穩定,性能相比 EP有明顯提升。

然而,將這一理論上的優勢轉化為實際可用的功能,需要克服以下兩個挑戰:

1. 權重切分與加載的適配:實現TP並行需要設計一套新的權重加載邏輯,能夠正確識別需要切分的權重(如專家MLP層的權重矩陣),並按照TP的策略(如行切分或列切分)將其均勻地切分到多個GPU上。同時,新的TP實現需要能夠無縫集成到推理框架現有的分佈式調度邏輯中。

2. 推理計算內核的兼容:模型推理時前向傳播計算需要適配TP模式,這是實現TP部署的核心工作。例如,對於一個線性層,TP部署時輸入的權重和對應的量化參數維度已經變化,如果直接使用原來的算子可能會有計算錯誤,或者性能無法達到最優;這要求對推理框架中負責MoE層計算的核心內核有深入的瞭解並進行修改。

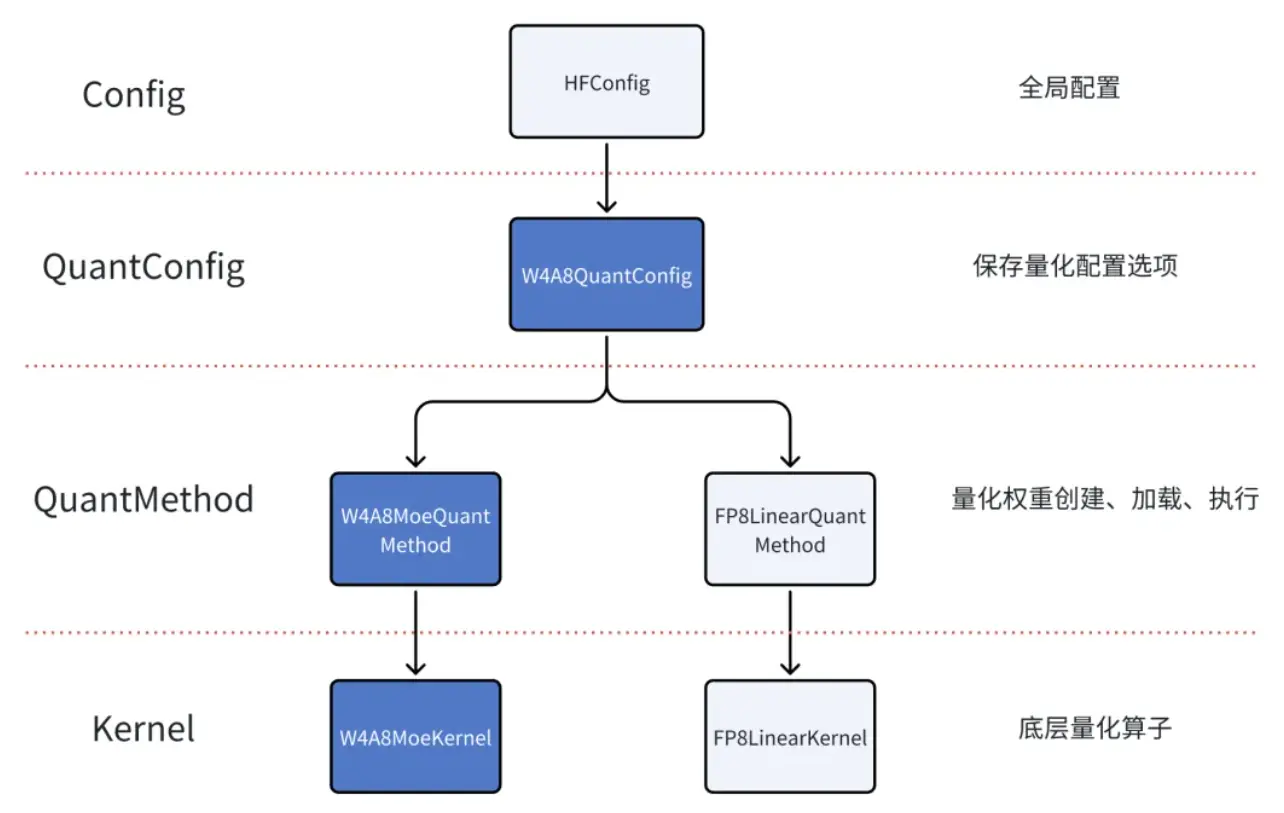

SGLang中W4AFP8量化模塊架構圖,深色為TP並行需要修改的部分

為此,騰訊雲聯合小紅書Hilab Infra團隊,為SGLang提供了完整的 W4AFP8模型TP並行推理實現。在開發過程中,團隊深入分析了模型結構,修改了SGLang中與模型權重加載相關的代碼,確保W4AFP8格式的量化權重能被正確切分並加載到TP組內的各個GPU中;另外,重構了CUDA內核調度模塊,修改了CUDA內核實現,確保了MoE模塊TP計算時精度無損;同時,遍歷了各種內核調優配置(TileShape,ClusterShape和 Scedule策略),並從中選取最優組合,保證了MoE算子的高性能。

通過上述優化攻堅,當前TP方案推理性能相比最初方案有了顯著提升:TTFT最高降低了 20%,QPM最高提升了 14%。目前相關PR已正式合入 SGLang V0.5.2版本。詳見 https://github.com/sgl-project/sglang/pull/8118

在SGLang V0.5.2之後的版本用TP並行部署 W4AFP8模型很簡單,只需要如下命令:

python3 -m sglang.launch_server --model-path /path/to/model --tp 8 --trust-remote-code --host 0.0.0.0 --port 8000

DeepSeek-V3.1-Terminus 量化高效推理方案

DeepSeek-V3.1-Terminus 是 DeepSeek 最新一代開源模型,在保持超強推理能力的同時,進一步提升了通用任務性能與代碼生成能力。與前代模型相比,Terminus 在多語言理解、數學推理、長上下文等任務上均有顯著提升。詳見 https://api-docs.deepseek.com/news/news250922

項目團隨完成了DeepSeek-V3.1-Terminus的 W4AFP8量化,在這個過程中使用了更多場景下的校準數據集, 使得MMLU-Pro任務精度損失僅為 0.38%。目前該模型已經上傳到 HuggingFace。詳見:https://huggingface.co/tencent/DeepSeek-V3.1-Terminus-W4AFP8

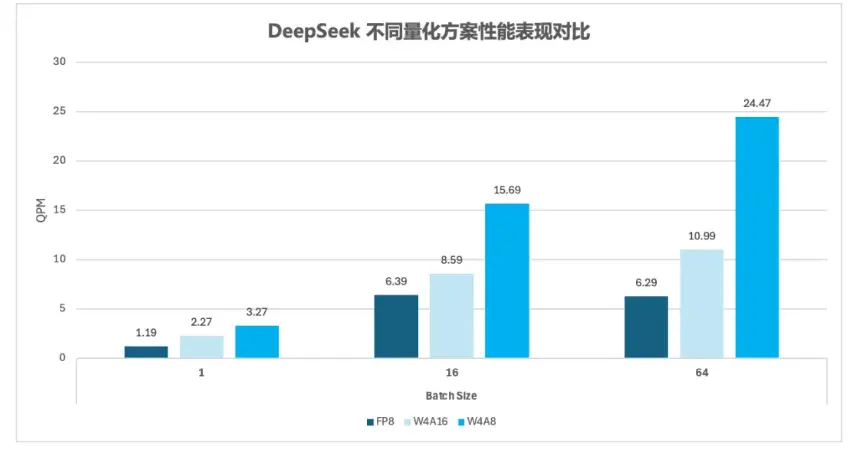

該模型可以由上述推理優化方案直接支持,單台GPU部署時推理性能相比量化FP8模型,可以提升 2.7×~3.9×。